RWKV-7:极先进的大模型架构,长文本能力极强

RWKV-7 采用了动态状态演化(Dynamic State Evolution),超越了 attention /linear attention 范式 TC0 表达能力的根本限制。RWKV-7 拥有 NC1 的表达能力,使其可以解决许多 attention 无法解决的问题。因此,RWKV-7 是一个真正的持续学习模型。RWKV-7 as a meta-in-context learner,从第一

RWKV-7 是极先进的最新大模型架构,超越 attention /linear attention 范式,拥有强大的 in-context-learning(上下文学习)能力,可真正持续学习,在保持 100% RNN 的同时,拥有极强的长文本能力。

RWKV-7 架构性能表现

RWKV-7 的大海捞针测试

RWKV-7-World 0.1B(L12-D768)在 ctx 4k 预训练 1T tokens(world-v2.8),无需任何微调,即可完美通过 ctx 16k 的大海捞针。且 world 系列模型支持全球 100+ 种语言和代码。

RWKV-7-Pile 0.4B(L24-D1024)在 ctx 4k 预训练 0.3T tokens(pile),无需任何微调,即可完美通过 ctx 16k 的大海捞针。

RWKV-7 的长文本外推测试

RWKV-7-Pile 系列模型,在 ctx 4k 预训练 0.3T tokens(pile),无需任何微调,即可自动外推到 ctx 32k+ 长度,且 ppl 随 ctx 增加持续稳步下降,说明还远未达到它的外推极限。

下面是 RWKV-7 与 Mamba 的对比,所有模型(除 - slimpj)都是在 Pile 训练:

Pile 模型横向评测

我们对多款 Pile 模型进行了综合测评。这里的所有模型,基于相同的 EleutherAI/pile 数据集训练,并使用相同的分词器(tokenizer)进行推理,所以是真正公平公正的模型性能对比。

我们对比了以下模型,涵盖 0.1B、0.4B、1.5B 三种参数:

- RWKV-7 "Goose"(例如 L12-D768, lr 8e-4 to 3e-5 cosine decay, wd 0.1, bsz 8x30x4096,随机初始化。我们没有使用任何 “技巧” 提升性能,训练过程非常稳定,无任何毛刺,完全可复现,欢迎联系我们复现)

- RWKV-4 "Dove"

- Mamba(我们发现 Mamba 在实际训练中很不稳定,这里使用的是他们提供的模型,我们无法验证他们是否使用了 “技巧” 提升性能)

- Pythia

从评测结果,可见 RWKV-7-Pile 在各项英文和多语言测试中,都拥有显著优势:

注意 RWKV-7 拥有显著更强的 ReCoRD 评分,这是长文本材料问答任务,表明 RWKV-7 能够更好地理解和使用长文本的信息。

此外,我们训练了两个 “深窄”(更多的层数和更小的维度)的 RWKV-7-Pile 0.1B 模型 ,分别是 L25-D576 和 L33-D512,它们的综合性能更强:

这表明 RWKV 架构可通过使用 “深窄” 尺寸,进一步提升性能。

0.1B 模型横向评测

RWKV-7-World-0.1B 是全球最强的 0.1B 多语言模型,在 world-2.8(1T tokens)数据训练后,拥有一流的英文能力,且多语言能力显著超越所有 0.1B 模型,支持全球 100+ 种语言和代码。

注意 RWKV-7-World-0.1B 在模型设计上保持 L12-D768 尺寸,而非 SmolLM2 的 L30-D576 尺寸。更少的神经网络层数(L12)使得 RWKV-7 的速度更快,更适合边缘设备等资源受限的推理场景,而且微调训练所需的数据和计算资源也更低。

这里的所有 RWKV 模型均已开源发布:HuggingFace 下载链接。

RWKV-7-World-0.1B 生成案例

作为仅 0.1B 参数的 L12-D768 小模型,RWKV-7-World-0.1B 拥有超越其尺寸的综合能力。以下是 RWKV-7-World-0.1B 的生成案例(使用 RWKV-Runner 运行):

其中的部分生成内容不准确,但考虑到,这是一个 0.1B L12-D768 的基底模型,尚未做任何 post-training,其性能可谓令人惊讶。

在 Huggingface Gradio Demo 测试 RWKV-7-World 0.1B

我们正在训练更大参数的 RWKV-7 模型,具体的发布计划请见后文。

RWKV-7 架构介绍

RWKV-7 采用了动态状态演化(Dynamic State Evolution),超越了 attention /linear attention 范式 TC0 表达能力的根本限制。RWKV-7 拥有 NC1 的表达能力,使其可以解决许多 attention 无法解决的问题。

因此,RWKV-7 是一个真正的持续学习模型。

有关 RWKV-7 的更详细设计思路(公式、伪代码等),请查看文章:RWKV-7 as a meta-in-context learner,从第一性原理真正理解

这种动态 State 演化机制,使得 RWKV-7 更擅长处理长上下文内容,拥有显著更强的长文本能力,且生成的内容更少出现自我重复,比各种 Transformer 和 RWKV-6 版本看上去更有连贯的思路。

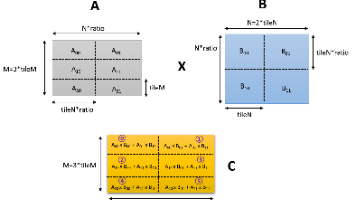

RWKV-7 的架构图:

RWKV-7 的训练和推理

RWKV-7 架构的训练和推理代码均已定稿,架构论文正在由彭博和社区成员联合撰写,欢迎大家参与,可在 EleutherAI 的 Discord 搜索 RWKV-papers 频道。

RWKV-7 训练代码可在 RWKV-LM 仓库中查看,RWKV-PEFT 项目已支持微调 RWKV-7 模型。

推理方面,RWKV pip 0.8.28 版本、web-rwkv、Ai00、RWKV Runner 等 RWKV 推理工具均已支持 RWKV-7 模型。

RWKV-7 模型发布计划

我们正在训练更大的 RWKV-7-World 模型,路线图如下:

| 模型 | 数据集 | 计划发布日期 |

|---|---|---|

| RWKV-7-0.4B | World-v2.9(2T) | 2025 年 1 月上旬 |

| RWKV-7-1.5B | World-v3(3.1T) | 2025 年 1 月下旬 |

| RWKV-7-2.9B | World-v3(3.1T) | 2025 年 2 月中旬 |

请关注我们的公众号 “元始智能”,第一时间接收 RWKV-7 的最新动态!

加入 RWKV 社区

RWKV 是一种创新的深度学习网络架构,它结合了 Transformer 与 RNN 的优点,同时实现高度并行化训练与高效推理。

- RWKV 中文官网(包括大量 RWKV 多模态论文):https://rwkv.cn/

- RWKV 英文官网:https://rwkv.com/

- RWKV-5/6(Eagle & Finch)论文: https://arxiv.org/abs/2404.05892

- RWKV-4 论文: https://arxiv.org/abs/2305.13048

欢迎大家加入 RWKV 社区!您可从 RWKV 官网了解 RWKV 模型,一起探讨 RWKV 模型。

相关链接

RWKV 是结合了 RNN 和 Transformer 的语言模型,适合长文本,运行速度较快,拟合性能较好,占用显存较少,训练用时较少

-

PENG Bo 2024-06-11 08:28

-

PENG Bo 2024-05-31 18:35

-

64b7fe4c better state training

test201610 2024-05-16 17:12

main 分支: 2024-06-11

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)