为什么ClickHouse比传统数据库快100倍?

ClickHouse是一款专为OLAP场景设计的开源列式数据库,由俄罗斯Yandex公司开发。其核心优势包括列式存储、向量化执行引擎和MergeTree存储引擎,可高效处理PB级数据,实现亚秒级查询响应。与OLTP系统相比,ClickHouse特别适合读多写少、大宽表、复杂查询的海量数据分析场景。通过列式存储减少I/O开销,向量化执行提升计算效率,以及分区键优化数据访问,ClickHouse在互联

ClickHouse数据库技术详解与企业实践指南

引言

在数据量呈指数级增长的当下,企业对高效、精准的大数据分析工具的渴望愈发强烈。ClickHouse 作为一款面向大数据场景的 OLAP(联机分析处理)数据库,以其卓越的性能为海量数据的存储与查询提供了强大助力,正逐渐成为数据密集型业务的核心支撑技术[1][2]。

什么是 ClickHouse?

ClickHouse 是由俄罗斯 Yandex 公司开发的开源列式数据库管理系统(DBMS),专为 OLAP 场景设计,旨在提供高效的海量数据实时分析解决方案。自 2016 年开源以来,ClickHouse 凭借其卓越的查询性能、高吞吐量和优秀的压缩率,在大数据分析领域迅速崛起,成为众多企业的首选 OLAP 解决方案[3][4][5]。其核心特性包括列式存储、向量化执行、分布式架构和丰富的表引擎,尤其在单表海量数据查询性能上表现突出,适用于宽表查询、复杂聚合分析等场景[3]。

OLAP 场景适配性:列式存储的技术突破

OLAP 场景普遍具有读多写少、大宽表、复杂查询、海量数据四大核心特点。传统行式存储在处理此类场景时,需将整行数据加载到内存,导致 I/O 资源浪费和查询效率低下;而 ClickHouse 采用的列式存储架构,仅需读取查询涉及的列数据,配合高效压缩算法(压缩率可达 5-10 倍),显著降低了存储成本和 I/O 开销[6]。

核心技术优势:ClickHouse 通过向量化执行引擎将数据按列批量处理,结合分布式分片与副本机制,实现了对 PB 级数据的亚秒级查询响应。相比于传统基于 Hadoop 生态圈的 OLAP 系统,其轻量级架构设计大幅降低了部署与维护成本[2][7]。

行业实践与影响力

ClickHouse 已在互联网、金融、物联网等领域得到广泛验证。今日头条、腾讯等企业通过引入 ClickHouse,构建了高效的实时数据分析平台;某企业在日志分析场景中,将每天 100 亿条日志数据(15TB 存储)的处理成本从阿里云 SLS 的 8.6 万元/月(含 4 折优惠)降至 1.6 万元/月,年节省成本超 80 万元[8]。在物联网领域,ZETag 云平台借助 ClickHouse 轻量级架构和强大的写性能,支撑了百万级设备标签数据的实时处理需求[9]。

文档结构导航

为帮助读者系统掌握 ClickHouse 技术体系,本报告后续章节将围绕以下核心内容展开:

- 技术架构解析:深入剖析列式存储、向量化执行等核心技术原理;

- 表引擎与数据模型:详解常用表引擎特性及适用场景;

- 性能优化实践:从索引设计、查询调优到集群部署的全链路优化策略;

- 企业案例深度剖析:结合金融、电商等行业实践,总结最佳落地经验。

通过系统化的技术解读与实践指南,读者将能够快速构建 ClickHouse 技术认知框架,并应用于实际业务场景。

核心概念

OLAP场景特性

OLAP(Online Analytical Processing,联机分析处理)是面向数据分析人员和业务决策人员的关键技术,主要用于对海量数据进行复杂多维分析与深度挖掘。其核心诉求是在数十亿至万亿行数据规模下,实现对多维度聚合、排序、关联等复杂查询的秒级甚至毫秒级实时响应,这与传统事务处理场景形成显著差异[10]。

OLAP与OLTP的核心差异

OLAP与OLTP(Online Transaction Processing,联机事务处理)在数据处理目标、场景特性上存在本质区别,具体对比如下:

| 特性维度 | OLAP(分析处理) | OLTP(事务处理) |

|---|---|---|

| 数据规模 | TB至PB级,支持数十亿至万亿行数据处理 | MB至GB级,通常处理少量行数据(数千至数万行) |

| 查询类型 | 复杂多维分析(多维度聚合、排序、关联、窗口函数等) | 简单CRUD操作(单表增删改查,事务性操作) |

| 读写比例 | 读多写少,数据批量写入后极少修改 | 读写均衡,频繁单行/小批量写入、更新和删除 |

| 表结构 | 大宽表(数百至数千列,每次查询仅涉及少数列) | 窄表(数十列以内,查询通常涉及全表字段) |

| 响应时间要求 | 秒级甚至毫秒级(复杂查询结果返回时间<1秒) | 毫秒级(简单事务处理<100ms) |

| 事务支持 | 非必需,数据一致性要求较低 | 强事务支持(ACID特性) |

这种差异决定了OLAP场景需要专门优化的技术架构,而ClickHouse正是为满足此类需求而设计的典型OLAP数据库。

OLAP场景的核心特性

基于上述对比,OLAP场景具有以下显著特征,这些特征共同构成了对数据库技术的特殊挑战:

-

读多写少,批量写入:数据通常以批量方式(如每日/每小时批量注入)进入系统,写入后极少修改或删除,但查询频率极高且并发量大。例如,物联网时序数据、用户行为日志等场景中,数据写入后主要用于历史数据分析,几乎不存在更新操作[3][11]。

-

大宽表与稀疏查询:业务分析需求往往涉及多维度指标,导致表结构包含数百甚至数千列(如用户画像表包含基本信息、行为标签、消费特征等),但每次查询通常仅需访问其中少数几列(如按“地域+时间”维度聚合“交易额”)。这种“宽表窄查”特性要求数据库能高效过滤无关列数据[3]。

-

复杂查询与实时分析:查询常包含多表关联、多层聚合(如

topK、median)、窗口函数(如ROW_NUMBER()、RANK())等复杂操作,且需在海量数据上实现亚秒级响应。例如,对每日100亿条日志数据进行实时聚合,生成实时业务监控报表[8][12]。 -

海量数据规模:数据量通常达到TB甚至PB级,单表记录数可达数十亿至千亿级。例如,大型互联网企业的用户行为日志表日均新增记录数可达“十亿级”,ClickHouse官方文档亦证实其支持此类规模的日处理能力[6][13]。

ClickHouse对OLAP场景的深度优化

ClickHouse通过针对性的架构设计,完美适配OLAP场景特性,其核心优化措施包括:

1. 列式存储:减少I/O开销

采用列式存储而非传统行式存储,将同一列数据连续存储。当查询仅涉及少数列时(如大宽表的稀疏查询),可避免加载无关列数据,显著降低I/O数据量。例如,对包含1000列的用户表查询“用户ID+消费金额”时,列式存储仅需读取2列数据,而行式存储需加载整行所有1000列[6][14]。

2. 向量化执行:提升计算效率

基于向量化执行引擎,将数据按列批量处理(而非逐行迭代),充分利用CPU缓存和SIMD指令集,大幅提升复杂计算效率。实测数据显示,在10亿级数据聚合查询中,ClickHouse耗时仅30秒,而传统关系型数据库(如MySQL)需5分18秒,性能提升近10倍[6][12]。

3. MergeTree引擎:优化存储与访问

核心存储引擎MergeTree通过分区键(如时间分区)、排序键和稀疏索引,实现数据的有序存储与快速检索。例如,按“日期”分区后,查询特定时间段数据可直接定位至对应分区文件,避免全表扫描;结合跳数索引(Skip Index),可进一步加速范围查询和聚合操作[3][6]。

4. 分布式架构:支持海量扩展

采用MPP(大规模并行处理)架构,通过分片(Sharding)将数据分散存储于多节点,副本(Replication)保证高可用,支持PB级数据处理和高并发查询。例如,某日志分析场景中,ClickHouse集群可高效处理每日100亿条日志的实时写入与查询,且节点扩容后性能线性增长[8][9]。

ClickHouse的OLAP场景适配性总结

ClickHouse的设计理念与OLAP场景特性高度契合,其核心优势可概括为:

- 场景匹配度:专为“读多写少、批量写入、大宽表、复杂查询、海量数据”场景优化,禁止单行更新,鼓励批量操作和预计算,完美适配日志分析、用户行为洞察、实时报表等典型OLAP需求[3][14]。

- 性能表现:在基准测试中,ClickHouse的查询性能名列前茅,支持秒级延迟的高并发查询,甚至可实现“万亿行数据聚合查询<1秒”的实时分析能力[9][10]。

- 成本优势:通过列式存储、向量化执行等技术,在普通硬件上即可实现高性能,降低了海量数据分析的硬件门槛[6]。

核心结论:ClickHouse通过“列式存储+向量化执行+MergeTree引擎+分布式架构”的技术组合,构建了针对OLAP场景的高性能解决方案,其设计哲学与场景特性的深度耦合,使其成为TB/PB级数据实时分析的首选数据库之一。

列式存储原理

列式存储是与传统行式存储截然不同的数据组织方式,其核心差异体现在数据排列逻辑上。行式存储(如 MySQL 的 InnoDB)将一行数据的所有字段连续存储,适合频繁的整行读写场景;而列式存储则将数据按列拆分,每一列的连续值紧密排列并独立存储为文件,这种结构使其在数据分析场景中展现出显著优势[11][15]。两者的关键特性对比如下:

| 特性 | 行式存储(如 MySQL) | 列式存储(ClickHouse) |

|---|---|---|

| 数据排列 | 按行连续存储(所有字段相邻) | 按列连续存储(单列数据紧密排列) |

| 适用场景 | OLTP:频繁单行读写、事务操作 | OLAP:批量读取、聚合计算、复杂分析 |

| I/O 效率 | 读取整行,即使只需少量字段(I/O 浪费) | 仅读取查询涉及的列(减少 I/O,提升吞吐) |

| 压缩潜力 | 低(不同数据类型相邻,压缩率低) | 高(同列数据类型一致,重复模式多,压缩率高) |

核心优势解析

列式存储的技术优势源于其数据组织方式与分析场景的深度适配,具体体现在以下三个层面:

1. 精准 I/O 降低数据读取成本

列式存储在查询时仅加载所需列数据,避免无关列的 I/O 开销。例如,当分析需求仅涉及表中 10% 的列时,列式存储可直接跳过其余 90% 的数据,而行式存储需读取完整行记录,导致大量无效 I/O[11][15]。ClickHouse 中每个列独立存储为文件,进一步强化了这一特性,使得查询 I/O 成本与涉及列数呈线性关系[16]。

2. 高效压缩提升存储与计算效率

同列数据类型一致且重复模式显著,为压缩算法提供了理想优化空间。ClickHouse 针对不同数据类型采用针对性编码策略:数值列(如时间戳、自增 ID)通过 Delta 编码存储差值,进一步降低冗余;字符串列(如枚举值、分类标签)则使用字典编码或 LZ4 压缩,将重复字符串映射为整数索引[12][15]。这种优化使压缩比普遍达到 5-10:1,部分场景下甚至超过 90%,显著降低磁盘占用与 I/O 耗时[6][12]。

3. 向量化执行释放 CPU 算力

列式存储的数据局部性特性与向量化执行引擎深度协同,可利用 CPU 的 SIMD(单指令多数据)指令对批量列数据并行处理。例如,在计算 SUM(amount) 或 AVG(price) 等聚合函数时,ClickHouse 可一次性处理 1024 行数据的列值,将性能提升 5-10 倍[12][15]。数据按列连续存储还减少了 CPU 缓存失效,进一步提升计算吞吐量。

关键结论:列式存储通过"按需读取-高效压缩-并行计算"的三重优化,在大规模数据分析场景中实现了存储成本与查询性能的双重突破。其核心价值在于将数据组织方式与分析型查询的访问模式深度匹配,从底层架构层面解决传统行式存储的 I/O 效率瓶颈。

量化优势实例:100 列宽表查询场景

假设某业务系统存在一张 100 列的宽表(如用户行为日志表),单条记录大小为 1KB(平均每列 10B),需对其中 10 列进行聚合查询(如求和、计数)。在 1 亿行数据量下,行式与列式存储的 I/O 消耗差异如下:

-

行式存储:需读取全部 100 列数据,总 I/O 量为 1 亿行 × 1KB/行 = 100GB。即使仅需 10 列,无关列的 90GB 数据仍需加载,导致 I/O 资源严重浪费。

-

列式存储:仅读取目标 10 列,总 I/O 量为 1 亿行 × 10 列 × 10B/列 = 10GB。结合 5-10:1 的压缩比,实际 I/O 可进一步降至 1-2GB,仅为行式存储的 1%-2%[6]。

这种差异直接转化为查询性能的数量级提升。实践中,对 1 亿行 web 分析数据的特定列查询,列式存储可在 92 毫秒内完成,吞吐量达 3 亿行/秒或 7GB/秒,而行式存储因加载无关列导致响应时间大幅增加[10]。这一案例充分验证了列式存储在宽表分析场景下的压倒性优势。

通过上述原理与实例可见,列式存储并非简单的数据组织方式变更,而是 ClickHouse 实现高性能分析能力的底层基石。其通过精准 I/O、高效压缩与向量化执行的协同设计,为大规模数据场景下的实时分析需求提供了关键技术支撑。

表引擎体系

表引擎是ClickHouse的灵魂,决定了数据的存储方式、索引机制、查询性能及适用场景。ClickHouse提供20余种表引擎,按功能可分为核心引擎(MergeTree系列)、辅助引擎(Log系列等)和集成引擎(外部数据源对接)三大类,共同构成了灵活且高性能的数据处理体系。

一、核心引擎:MergeTree家族

MergeTree系列是ClickHouse的基石,基于LSM-Tree(日志结构合并树)架构设计,支持分区、排序、索引、TTL等企业级特性,广泛适用于大规模数据分析场景。其核心优势在于通过后台异步合并机制将小数据块(Part)合并为有序大文件,同时利用多级索引加速查询。

1.1 基础MergeTree

作为家族的基础引擎,MergeTree提供了数据分区、排序、索引的核心能力,是其他变种引擎的技术底座。

-

核心特性:

- 分区管理:通过

PARTITION BY按时间或业务维度拆分数据(如按天分区),支持按分区快速删除过期数据。 - 排序与索引:

ORDER BY字段定义主键排序规则,隐式生成稀疏索引(默认每8192行一个索引条目),加速范围查询;支持跳数索引(如minmax、bloom_filter),辅助非主键字段过滤数据块。 - 数据生命周期:通过TTL(Time to Live)自动删除过期数据,例如设置

TTL event_time + INTERVAL 30 DAY。 - 写入与合并:数据先写入内存缓冲区,满后按列压缩成磁盘Part(命名格式:

{partition_id}_{min_block}_{max_block}_level),后台线程周期性合并相邻Part,生成更大有序文件[15]。

- 分区管理:通过

-

SQL示例(存储多市场行情数据):

CREATE TABLE market_quotes ( symbol String, trade_time DateTime, price Float64, volume UInt64 ) ENGINE = MergeTree() PARTITION BY toDate(trade_time) -- 按天分区 ORDER BY (symbol, trade_time) -- 按股票代码+时间排序 TTL trade_time + INTERVAL 90 DAY -- 数据保留90天 SETTINGS index_granularity = 8192; -- 索引粒度 -

适用场景:大规模时序数据存储,如金融行情、用户行为日志等,长桥科技使用其统一存储多市场行情数据[17]。

1.2 功能变种引擎

基于基础MergeTree,ClickHouse衍生出多种功能定向优化的变种引擎,解决去重、聚合等特定问题:

| 引擎类型 | 核心能力 | SQL示例 | 适用场景 |

|---|---|---|---|

| ReplacingMergeTree | 合并时按排序键去重(保留最新版本) | CREATE TABLE user_events (...) ENGINE = ReplacingMergeTree(update_time) ORDER BY user_id |

用户行为数据去重、订单状态更新 |

| SummingMergeTree | 预聚合数值列(自动求和) | CREATE TABLE sales_summary (...) ENGINE = SummingMergeTree() ORDER BY (region, date) |

销售指标汇总表、流量统计预计算 |

| AggregatingMergeTree | 存储预聚合数据(支持多聚合函数) | CREATE TABLE pv_agg (...) ENGINE = AggregatingMergeTree() ORDER BY (page, date) |

页面访问量(PV/UV)实时统计 |

| CollapsingMergeTree | 通过Sign列实现行折叠(模拟删除) | CREATE TABLE order_records (...) ENGINE = CollapsingMergeTree(Sign) ORDER BY order_id |

需要逻辑删除的场景,如订单取消 |

注意:变种引擎的合并操作是异步后台执行,因此查询结果可能包含未合并的临时数据,需配合FINAL修饰符强制合并(但会牺牲性能)。

1.3 分布式与高可用扩展

- ReplicatedMergeTree:基于ZooKeeper实现数据副本同步,保证集群节点故障时的数据一致性,支持故障自动恢复,是生产环境高可用部署的核心选择[18]。

- Distributed:作为集群本地表的逻辑“视图”,实现跨节点查询路由,支持分片与副本管理,需与本地表配合使用(如

Distributed(cluster, db, local_table, sharding_key))[12]。

二、辅助引擎:轻量级场景适配

辅助引擎以功能精简为特点,适用于临时数据处理、小表存储等轻量级场景,典型代表为Log系列。

2.1 Log系列引擎

- TinyLog:最简单的引擎,每列独立压缩存储,不支持索引和并发读写,适用于≤100万行的小表(如临时中间结果)[12]。

- Log:在TinyLog基础上增加

.mark文件支持并行读,但仍无索引,适合物联网场景存储传感器原始数据[19]。

SQL示例(临时测试表):

CREATE TABLE sensor_temp (

device_id String,

temp Float32,

collect_time DateTime

) ENGINE = TinyLog; -- 适合一次性导入的小批量数据

三、集成引擎:外部数据生态对接

集成引擎用于连接外部数据源,实现数据联邦查询或实时接入,扩展ClickHouse的数据处理边界:

- Kafka:直接消费Kafka消息队列数据,支持流批一体处理[20]。

- MySQL:实时同步MySQL表数据(20.8+版本支持),支持

INSERT/UPDATE操作映射[12]。 - Hive:直接查询HDFS上的Hive表,兼容文本/ORC/Parquet格式[12]。

- Iceberg:支持复杂类型schema演进,通过字段ID兼容列重命名场景,适合数据湖集成[21]。

四、引擎选择决策指南

ClickHouse表引擎选择需结合数据规模、查询模式和可用性要求:

- 大规模OLAP分析:优先MergeTree系列(基础版/变种版),需高可用则搭配ReplicatedMergeTree。

- 分布式查询:使用Distributed引擎封装本地表集群。

- 临时数据/小表:Log系列(TinyLog/Log)或Memory引擎(全内存,重启丢失)。

- 外部数据集成:根据数据源类型选择Kafka/MySQL/Hive等集成引擎。

最佳实践:生产环境中,90%以上的场景可通过“MergeTree系列+Distributed”组合覆盖,避免对大数据集使用Memory引擎(易触发内存溢出)[12]。

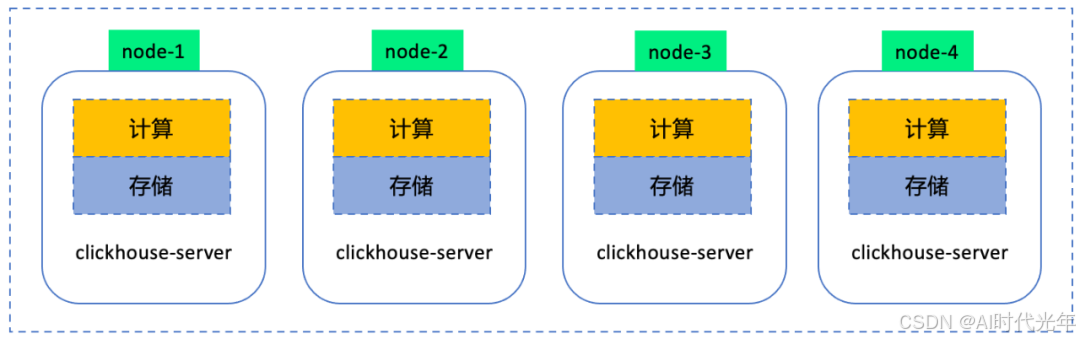

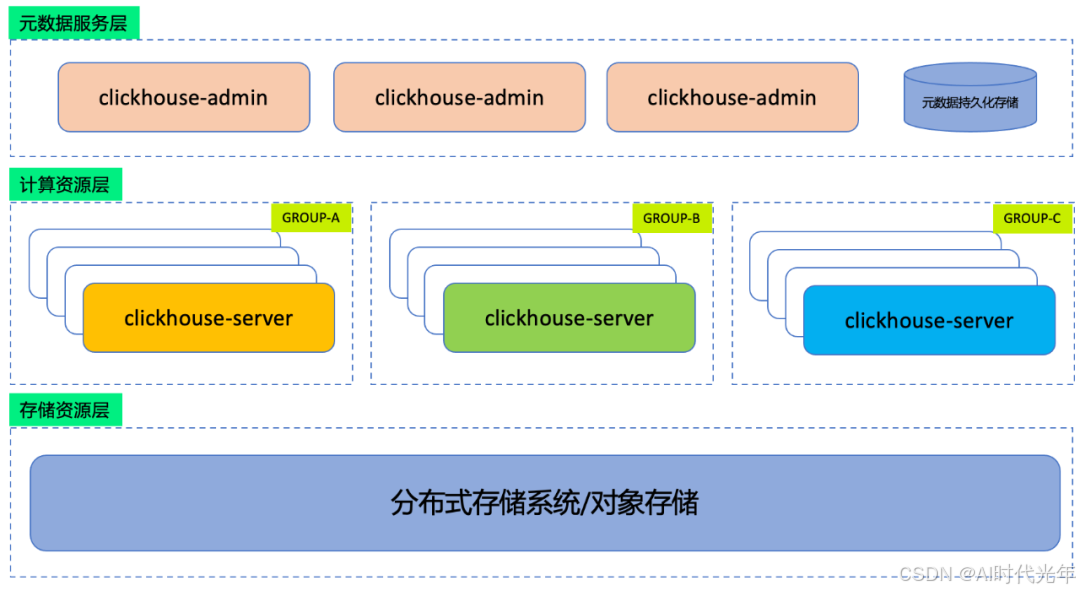

架构设计

整体架构

ClickHouse 采用MPP(大规模并行处理)架构,核心设计目标是高性能列式分析,其整体架构以“三层架构模型”(存储层、查询处理层、分布式层)为核心,深度适配 OLAP 场景对高吞吐、低延迟分析的需求。该架构兼具轻量性与扩展性:单机版无需第三方组件,仅通过单个服务进程即可运行,大幅降低运维成本;分布式部署则支持集群弹性扩展,通过分片与副本机制应对数据规模增长[8][9][16]。

存储层:列式存储与 MergeTree 引擎的深度优化

存储层是 ClickHouse 高性能的基石,采用列式存储结构并以 MergeTree 系列引擎为核心,从数据组织到硬件适配进行全链路优化。

列式存储的硬件级优化:相较于行式存储,列式存储将同一列数据连续存储,使 CPU 缓存能更高效加载数据块,减少内存读取次数。查询时可直接定位到目标列数据所在位置,避免无关列的加载,显著降低 I/O 开销[1]。例如,在分析“用户消费金额”时,仅需读取“金额”列数据,无需扫描整行其他字段。

数据分块与 MergeTree 引擎:数据以“块”为单位组织,每个块包含固定行数的列数据。核心存储引擎 MergeTree 支持数据分区(按时间等维度拆分)、稀疏索引(加速查询定位)和多阶段压缩(如 LZ4、ZSTD 算法),进一步提升存储效率与查询性能。MergeTree 引擎系列(如 ReplacingMergeTree、SummingMergeTree)可根据业务场景选择,实现数据自动去重、预聚合等功能[6][16]。

查询处理层:向量化执行与并行计算的协同加速

查询处理层基于 MPP 架构设计,通过“解析→优化→执行”全流程优化,充分释放多核 CPU 算力,实现亚秒级查询响应。

SQL 处理全流程:

- 解析阶段:SQL 解析器将查询语句转换为抽象语法树(AST),验证语法合法性;

- 优化阶段:优化器基于数据分布、索引信息等生成最优执行计划,如选择分区裁剪、索引利用策略;

- 执行阶段:执行引擎通过向量化执行与并行计算提升效率。

向量化执行:采用批量处理模式,将数据按“列向量”(而非单行)传递给算子,结合 CPU 的 SIMD(单指令多数据)指令集实现数据并行处理。例如,hash agg 聚合算子针对不同数据量场景开发了 30 多个版本,通过向量化计算显著提升聚合性能[9]。

并行计算:查询执行时可利用集群所有节点的 CPU 资源,通过多线程并行处理数据块。单机场景下,单个查询会被拆分为多个子任务,由不同 CPU 核心并行执行;分布式场景下,任务进一步在多节点间协同,最大化资源利用率[9][16]。

分布式层:分片与副本的高可用架构

分布式层通过分片(Shard)与副本(Replica)机制实现数据弹性扩展与高可用,结合 ZooKeeper 进行分布式协调,保障集群一致性。

分片与副本的集群组织:

- 分片:数据按预设规则(如哈希、范围)水平拆分为多个分片,每个分片独立存储部分数据,实现存储与计算能力的线性扩展;

- 副本:每个分片包含多个副本节点,节点间互为备份,避免单点故障。例如,一个集群可配置 3 个分片,每个分片包含 2 个副本,总节点数为 6 个[3][4]。

ZooKeeper 的分布式协调:分布式表通过 ZooKeeper 管理元数据(如分片拓扑、副本状态),协调副本同步与分片负载均衡。当某个副本节点故障时,ZooKeeper 会自动将查询请求路由至健康副本,保障数据可用性与集群稳定性[12][16]。

三层架构核心价值:存储层通过列式存储与 MergeTree 引擎奠定高效数据基础,查询处理层借助向量化与并行计算突破性能瓶颈,分布式层通过分片副本与 ZooKeeper 协调实现弹性扩展与高可用,三者协同使 ClickHouse 深度适配 PB 级数据的实时分析场景。

存储层设计

数据分区与分块

ClickHouse 采用 “分区-分块”二级数据组织结构,通过逻辑分区与物理分块的协同设计,实现高效数据管理与查询优化。这种分层架构既满足了大规模数据的生命周期管理需求,又通过精细化的块级索引机制提升查询性能。

数据分区:逻辑划分与高效过滤

数据分区是按 分区键(PARTITION BY) 对数据进行的一级逻辑划分,通常基于高频过滤维度(如时间、地区或业务类型),每个分区对应独立的物理目录,便于数据隔离与管理。

分区维度与实现方式

- 时间维度:最常用的分区方式,如按年月(

toYYYYMM(EventDate))或日(toYYYYMMDD(event_time))划分,适合日志、监控等时序数据场景。例如,按日分区可快速定位某天的数据,避免全表扫描[3][4][6]。 - 多维度组合:支持复合分区键,如同时按地区和时间分区:

PARTITION BY (region, toYYYYMM(date)),适用于多维度分析场景。以下为按地区和时间分区的销售表创建示例:CREATE TABLE sales_data_partitioned ( date Date, product_id UInt32, sales_amount Decimal(10, 2), region String ) ENGINE = MergeTree() PARTITION BY (region, toYYYYMM(date)) -- 复合分区键:地区 + 年月 ORDER BY (product_id, date); -- 按产品ID和日期排序 ```[[1](https://www.dtstack.com/bbs/m/article/25753)]

分区核心价值

- 查询剪枝:通过分区键过滤快速跳过无关数据,例如查询“2024年1月华北地区销售数据”时,仅扫描

north_202401分区,减少90%以上的数据扫描量[6][15]。 - 数据生命周期管理:支持按分区粒度删除或迁移数据,如通过

ALTER TABLE ... DROP PARTITION删除过期分区,或配置冷热分离策略(近期热数据存SSD,历史冷数据迁移至HDD)[9][15]。 - 分区合并优化:后台线程每10分钟检查并合并相邻、时间范围重叠的分区,减少碎片化。例如执行

ALTER TABLE sales_data_partitioned MERGE PARTITIONS 'north_202401', 'north_202402'可手动合并指定分区,提升存储效率[1][15]。

数据分块:物理存储与索引加速

每个分区内的数据按 排序键(ORDER BY) 排序后,进一步划分为 数据块(Part),作为最小存储与处理单元。块大小由 index_granularity 控制(默认8192行/块),平衡并行处理效率与压缩比。

数据块结构与组成

每个数据块包含以下核心文件:

- 列数据文件(.bin):按列存储的实际数据,采用独立压缩算法(如LZ4、ZSTD)优化存储效率[6][15]。

- 标记文件(.mrk2):记录列数据在.bin文件中的偏移量与长度,用于快速定位数据位置[15]。

- 主键索引文件(primary.idx):基于排序键的稀疏索引,默认每8192行创建一条索引记录,加速范围查询[22]。

- 校验和元数据(checksums.txt):存储文件校验信息,确保数据完整性[15]。

示例目录结构(以用户行为数据分区为例):

/user_behavior/

└── 20231001_1_1_0/ # 数据块目录(命名规则:日期_最小块号_最大块号_版本)

├── event_time.bin # 时间列数据文件(压缩存储)

├── event_time.mrk2 # 时间列标记文件(定位数据偏移)

├── primary.idx # 主键索引文件(基于排序键)

└── checksums.txt # 校验和元数据

块级索引与查询加速

数据块的 索引标记 记录了块内每行数据的统计信息(如最小值、最大值、行数),可在查询阶段快速过滤不满足条件的块。例如,当执行 WHERE user_id > 1000 时,ClickHouse 会读取各块的 user_id 索引标记,仅扫描 min(user_id) >= 1000 的块,跳过大量无关数据[3][6]。

核心优势总结

- 分区层:通过逻辑划分实现数据生命周期管理(如自动删除过期分区)和查询剪枝,减少90%+无效数据扫描。

- 分块层:8192行固定粒度块设计,结合列存压缩与块级min/max索引,使单表查询性能提升10-100倍。

关键配置与最佳实践

- 分区键选择:优先使用低基数、高频过滤字段(如日期),避免过度分区(建议分区数≤1000),防止元数据管理开销过大[12][14]。

- 块大小调整:默认

index_granularity=8192行/块,可通过index_granularity_bytes配置自适应块大小(生产环境不建议禁用)[23]。 - 冷热分离:通过

<storage_configuration>配置存储策略,将近期热数据存于SSD,过期数据迁移至HDD,平衡性能与成本[9]。

通过分区与分块的协同设计,ClickHouse 在大规模数据分析场景中实现了 “存储-查询-管理”三位一体的优化,既满足了PB级数据的高效存储需求,又通过精细化索引机制将查询延迟压缩至毫秒级。

索引体系

ClickHouse 的索引体系通过分层设计实现高效数据定位,主要包括基于排序键的一级索引(主键索引)和辅助过滤的二级索引(跳数索引),两者协同大幅降低查询扫描范围,提升分析性能。

一级索引:基于排序键的稀疏索引

一级索引(Primary Index)是 ClickHouse 数据定位的核心机制,基于表的 ORDER BY 字段(排序键)构建,采用稀疏索引设计。其核心特性在于:

- 粒度控制:默认每 8192 行数据(一个 Granule)生成一个索引项,记录该 Granule 中排序键的最小值,形成轻量级索引结构(索引文件体积仅为原数据的 0.1%)[6][15]。

- 定位原理:类比“书的目录”,索引项如同目录中的章节标题,查询时通过二分查找快速定位包含目标数据的 Granule 范围,再通过 Mark 文件(记录列数据偏移量)精确读取具体列值,从而跳过 90% 以上无关数据块[15][24]。

典型场景:对于按 (region, event_date) 排序的用户行为表,查询 region='华东' AND event_date BETWEEN '2025-01-01' AND '2025-01-31' 时,一级索引可直接定位到“华东”区域且日期在目标范围内的 Granule,避免全表扫描。

二级索引:轻量级跳数索引加速过滤

二级索引(Skipping Index)针对非排序键字段提供辅助过滤能力,在数据合并时生成统计信息,查询阶段快速判断数据块是否包含目标值,支持 minmax、bloom_filter 等多种类型,弥补一级索引对非排序键查询的局限性[15]。

minmax 索引:范围查询的“守门人”

- 原理:记录每个 Granule 内目标列的最小值和最大值,查询时通过比较条件与 min/max 的关系,直接跳过不满足条件的数据块。

- 适用场景:数值列(如金额、温度)、日期列(如

create_time)的范围查询。例如,对status列创建 minmax 索引后,WHERE status = 'active'会自动跳过所有max(status) < 'active'的 Granule[6][22]。 - 版本增强:25.1 版本引入表级 MinMax 索引,通过配置

add_minmax_index_for_numeric_columns可自动为所有数值列添加该索引,简化索引管理[25]。

bloom_filter 索引:高基数列的等值查询利器

- 原理:基于布隆过滤器算法,对 Granule 内高频过滤字段(如

user_id、device_id)构建概率性索引,快速判断“值是否不存在于块中”(存在一定假阳性率,需通过实际数据校验)[15]。 - 适用场景:高基数列的等值查询(如

user_id = '12345'),或枚举值分散的过滤条件(如event_type = 'click'),可将全表扫描转为对少量候选块的精确校验[6]。

二级索引创建示例

通过 ALTER TABLE 语句可灵活添加二级索引,语法如下:

创建 minmax 索引(对订单金额列加速范围查询):

ALTER TABLE orders ADD INDEX idx_order_amt (amount) TYPE minmax GRANULARITY 1;

创建 bloom_filter 索引(对用户 ID 列加速等值查询):

ALTER TABLE user_events ADD INDEX idx_user_id (user_id) TYPE bloom_filter(0.01) GRANULARITY 4;

(注:0.01 为假阳性率,GRANULARITY 4 表示每 4 个 Granule 合并生成一个索引项)

索引协同工作流程

查询执行时,一级索引与二级索引形成“粗定位-精过滤”的分层机制:

- 一级索引定位:通过排序键的稀疏索引快速锁定候选 Granule 范围(如通过

region='华东'定位到华东区域的所有 Granule); - 二级索引过滤:对候选 Granule 应用 minmax/bloom_filter 索引,进一步剔除不满足非排序键条件的数据块(如通过

amount > 1000的 minmax 索引跳过金额过小的块); - 数据块读取:仅加载通过双层过滤的 Granule,通过 Mark 文件定位具体列数据,完成查询计算[15]。

这种设计使 ClickHouse 在百亿级数据量下仍能保持毫秒级查询响应,尤其适合时序数据、日志分析等场景的高效过滤需求。

查询处理流程

ClickHouse 的查询处理流程以“一条 SQL 的生命周期”为主线,可拆解为解析→优化→执行三个核心阶段,各阶段通过专业化组件协同工作,确保高效处理大规模数据分析任务。

解析阶段:从 SQL 到逻辑计划的转换

解析阶段是 SQL 语句的“翻译与验证”过程,主要通过解析器(Parser) 与语义分析器(Semantic Analyzer) 完成。解析器首先将输入的 SQL 文本转换为抽象语法树(AST),同时检查语法正确性(如关键字拼写、语句结构等);语义分析器则进一步验证逻辑合理性,包括表名、列名的存在性校验、数据类型匹配等,并最终生成逻辑查询计划。例如,对于 SELECT user_id, SUM(amount) FROM orders WHERE date > '2025-01-01' GROUP BY user_id,AST 会清晰表达查询的选择列、过滤条件、聚合方式等逻辑结构,为后续优化提供结构化基础。

优化阶段:提升查询效率的核心策略

优化阶段是 ClickHouse 性能优化的关键环节,通过逻辑优化与物理优化两层策略,将逻辑查询计划转换为高效的物理执行计划。

逻辑优化的核心目标是减少数据处理量,典型手段包括:

- 过滤条件下推(谓词下推):将

WHERE条件下推至存储层,在数据读取阶段直接过滤无关行,避免无效数据进入后续计算流程。例如,对分区表按date过滤时,可直接跳过不满足条件的分区文件,减少 90% 以上的数据扫描量。 - 投影剪枝:仅读取查询中明确引用的列,忽略无关列。如上述示例中,仅需读取

user_id、amount、date三列,而非全表所有字段。

物理优化则聚焦于执行策略的选择,核心包括:

- JOIN 表顺序优化:遵循“小表驱动大表”原则,将较小的表作为右表构建哈希表,较大的表作为左表进行流式探测,减少内存占用并提升连接效率。例如,当关联“用户表”(百万级数据)与“订单表”(十亿级数据)时,以用户表构建哈希表可显著降低哈希冲突概率。

- 聚合策略选择:根据数据分布特征选择本地聚合(Local Aggregation)或全局聚合(Global Aggregation),并结合预聚合索引(如 AggregatingMergeTree)加速

GROUP BY操作。

优化阶段核心价值:通过逻辑与物理优化的协同,ClickHouse 可将复杂查询的无效数据扫描量降低 80%~95%,JOIN 操作效率提升 3~10 倍,为执行阶段奠定高效基础。

执行阶段:向量化执行引擎的高效计算

执行阶段由执行引擎主导,通过向量化执行、并行处理与分布式协调三大机制,实现数据的高效计算与结果返回。其中,向量化执行是 ClickHouse 区别于传统数据库的核心特性,也是其高性能的关键保障。

向量化执行的核心机制:

- 数据块(Block)处理:将数据按列划分为固定大小的块(默认 1024 行/块),每个块包含单列多行数据,且内存地址连续。这种结构既减少了 CPU 上下文切换(从逐行处理的高频切换变为按块批量处理),又为 SIMD 指令优化提供了基础。

- SIMD 指令加速:利用 CPU 的 AVX2/AVX512 等 SIMD 指令集,对整个数据块执行并行计算。例如,对

SUM(amount)操作,SIMD 指令可单次处理 16 个 Int32 类型数据或 8 个 Double 类型数据,计算效率较逐行处理提升 5~20 倍。 - 零拷贝与惰性物化:通过指针传递数据块减少内存拷贝开销,对字符串等复杂类型采用延迟解压策略,仅在必要时生成中间结果,进一步降低资源消耗。

向量化执行与传统行式执行的对比:

| 特性 | 行式执行(Row-based) | 向量化执行(Vectorized) |

|---|---|---|

| 处理单位 | 单行数据(逐行处理) | 数据块(Block,默认 1024 行/块) |

| CPU 指令优化 | 频繁分支跳转,无法利用 SIMD | 按列连续处理,触发 SIMD 并行计算 |

| 缓存利用率 | 低(随机访问多列数据) | 高(连续访问单列数据,命中率提升) |

| 适用场景 | OLTP(短事务、单行操作) | OLAP(批量计算、聚合分析) |

除向量化执行外,执行阶段还通过并行处理(利用多核 CPU 同时处理不同数据块)与分布式协调(协调节点分发任务至各分片,合并结果后返回)进一步提升性能。例如,分布式查询中,任务会自动分解到各节点并行执行,最终由协调节点汇总结果,实现“分而治之”的高效计算。

向量化执行的性能优势:参考实测数据,向量化执行在聚合(如 SUM、COUNT)、过滤(如 WHERE 条件)等场景下,处理速度较传统行式执行提升 5~10 倍,尤其在亿级数据量查询中,可将响应时间从分钟级压缩至秒级。

综上,ClickHouse 通过解析阶段的结构化转换、优化阶段的策略调优、执行阶段的向量化加速,构建了一套完整的高效查询处理体系,使其能够在 PB 级数据场景下保持亚秒级响应能力。

分布式架构

分片与副本

分片(Shard) 作为 ClickHouse 集群数据水平拆分的核心单元,通过将完整数据集按预设规则拆分为多个子集并分布到不同物理节点,实现存储容量与计算能力的线性扩展。其核心目标是突破单机性能瓶颈,支持 PB 级数据存储与并行查询处理,同时通过任务自动路由实现节点间负载均衡。例如,按 user_id 字段哈希分片至 3 个节点时,系统会对 user_id 计算哈希值后通过模运算分配数据,确保各节点数据量与查询压力均匀分布。

分片键与策略是决定数据分布的核心要素。分片键可通过显式指定(如 user_id)或隐式计算(如内置哈希函数)确定,支持多种分片策略:

| 分片类型 | 实现方式 | 适用场景 |

|---|---|---|

| 哈希分片 | 对分片键(如 user_id)计算哈希值后按模运算分配节点 |

数据分布需均匀、避免热点的场景 |

| 范围分片 | 按分片键的连续范围(如时间 2023-01-01 ~ 2023-06-30)划分 |

时序数据按时间分区查询的场景 |

| 自定义分片 | 通过用户定义规则(如 user_id % 10 < 5)映射节点 |

多租户隔离等复杂业务逻辑场景 |

副本(Replica) 是分片的冗余备份机制,通过在不同物理节点存储相同分片数据,实现服务高可用与数据可靠性保障。ClickHouse 仅 MergeTree 系列表支持副本,核心依赖 ReplicatedMergeTree 引擎与 ZooKeeper 协调实现数据同步:主副本(Leader)接收写入请求后将操作日志提交至 ZooKeeper,从副本(Follower)监听日志变更并异步拉取数据进行回放,同时通过周期性一致性校验确保副本数据一致。生产环境中推荐为每个分片配置 2-3 个副本,并分布在不同可用区或机架,以应对单点故障风险。

副本同步流程:

- 写入请求发送至主副本节点;

- 主副本将数据写入本地磁盘并记录操作日志至 ZooKeeper;

- 从副本监听 ZooKeeper 日志变更,主动拉取增量数据;

- 从副本应用数据变更并更新本地存储,完成同步;

- 定期执行数据校验,修复潜在不一致。

以典型的 3 分片 2 副本 集群为例,其架构配置通过 remote_servers 参数定义:

<remote_servers>

<cluster_3shards_2replicas>

<!-- 分片 1:包含 2 个副本节点 -->

<shard>

<replica><host>node1</host></replica>

<replica><host>node2</host></replica>

</shard>

<!-- 分片 2:包含 2 个副本节点 -->

<shard>

<replica><host>node3</host></replica>

<replica><host>node4</host></replica>

</shard>

<!-- 分片 3:包含 2 个副本节点 -->

<shard>

<replica><host>node5</host></replica>

<replica><host>node6</host></replica>

</shard>

</cluster_3shards_2replicas>

</remote_servers>

数据写入流程如下:

- 用户通过 分布式表 发起写入请求,分布式表根据预定义分片键(如

user_id哈希)确定目标分片; - 请求被路由至目标分片的主副本节点,主副本完成本地写入后将操作日志提交至 ZooKeeper;

- 同分片内的从副本监听 ZooKeeper 日志,异步拉取并应用数据变更,确保副本数据一致;

- 写入操作在主副本确认成功后即返回,从副本同步过程后台执行,不阻塞用户请求。

通过分片与副本的协同设计,ClickHouse 集群可同时实现 存储容量水平扩展(单集群支持 PB 级数据)、计算能力并行化(查询任务自动分发至所有分片)与 服务高可用(副本故障时自动切换),满足大规模数据分析场景的核心需求。

分布式表

分布式表是 ClickHouse 集群的统一入口,作为逻辑抽象层不存储实际数据,而是通过 Distributed 引擎映射到集群中各节点的本地表,实现对多分片数据的透明访问与聚合查询。其核心价值在于简化分布式集群的使用复杂度,用户无需感知底层节点拓扑即可进行跨节点数据操作[18][20]。

创建语法与参数解析

分布式表通过 Distributed 引擎定义,需指定集群配置、本地表映射关系及数据分片规则。典型创建语法如下:

CREATE TABLE tutorial.hits_all AS tutorial.hits_local

ENGINE = Distributed(perftest_3shards_1replicas, tutorial, hits_local, rand());

参数说明:

- 集群名(如

perftest_3shards_1replicas):对应集群配置中的逻辑集群标识,定义分片与副本拓扑[18]。 - 数据库名(如

tutorial):本地表所在的数据库名称。 - 本地表名(如

hits_local):实际存储数据的物理表,需在集群各节点预先创建[7]。 - 分片键(如

rand()或cityHash64(user_id)):决定数据路由规则,支持随机分片(rand())、哈希分片(cityHash64)等策略,直接影响数据分布均匀性[12]。

注意:分布式表创建时需确保集群内所有节点已存在同名本地表,否则可能导致查询失败。通过 ON CLUSTER '{cluster}' 语法可自动在集群所有节点创建关联本地表[7]。

查询执行流程

分布式表将用户请求转化为跨节点协同操作,具体流程如下:

- 请求接收:用户通过任意节点的分布式表发起查询,该节点自动成为协调器(Coordinator)。

- 分片解析:协调器根据分片键规则(如

rand()或cityHash64)解析目标分片。 - 并行查询:向各分片节点发送子查询请求,执行本地表数据扫描与计算(如过滤、聚合)。

- 结果合并:收集中间结果并通过

UNION ALL汇总,支持全局聚合(如跨分片COUNT(*))、分布式JOIN等复杂操作[6][21]。

例如,对分布式表执行 SELECT COUNT(*) FROM hits_all 时,协调器会先在每个分片计算本地表的记录数,再累加得到全局结果,过程对用户完全透明。

核心特性与优势

-

透明化集群访问

用户通过单一逻辑表操作整个集群数据,无需手动指定节点或分片,降低分布式系统使用门槛[20]。 -

自动数据路由

INSERT 操作根据分片键自动分发数据至对应节点,避免手动数据分配;查询时支持负载均衡(通过load_balancing参数配置,如random随机分配请求)[12]。 -

版本化功能增强

25.7 版本优化分布式 DDL 执行逻辑,通过distributed_ddl_output_mode='*_only_active'配置可跳过滞后副本,提升 DDL 操作效率[21]。

关键区别:分布式表与数据库视图的核心差异在于,前者不仅支持查询路由,还能处理数据写入(自动路由至对应分片),而视图仅支持查询转发[4][18]。

通过上述机制,分布式表实现了 ClickHouse 集群的“逻辑中心化、物理分布式”架构,为大规模数据处理提供高效且易用的统一接口。

最新特性(25.x版本)

性能优化

并行哈希连接优化

哈希连接作为 ClickHouse 中高效处理多表关联的核心算法,其性能优化始终是提升查询效率的关键。该算法通过“构建(Build)-探测(Probe)”两阶段实现表关联:构建阶段将小表数据载入内存生成哈希表,探测阶段遍历大表数据并通过哈希匹配查找关联记录。在 24.x 版本及之前,并行哈希连接存在显著瓶颈:探测阶段需将输入数据块拆分至与哈希表实例数量匹配的子块,每个线程仅能访问对应实例,导致块拆分开销增加且资源利用率受限[25]。

针对上述问题,ClickHouse 在 25.1 版本率先对探测阶段进行优化,核心改进在于引入单个共享哈希表,消除了输入块拆分的性能损耗。具体实现中,构建阶段首先创建 N 个两级哈希表实例(N 为 CPU 线程数),每个实例包含 256 个桶,由 N 个线程通过非重叠方式填充(如实例 0 负责桶 0、N、2N…),随后合并为全局共享哈希表;探测阶段所有线程可直接并发访问该共享哈希表,无需拆分数据块[25]。这一优化在实际测试中效果显著:在 AWS EC2 m6i.8xlarge 实例上,基于 TPC-H 数据集(缩放因子 100)的 lineitem 与 orders 表 JOIN 查询耗时从优化前的 3.100 秒降至 2.112 秒,性能提升约 31.87%[25]。

25.2 版本进一步深化优化,聚焦构建阶段的线程争用问题。通过无锁设计减少 CPU 线程间的阻塞,构建阶段不再需要复杂的同步机制,线程可独立填充哈希表桶,大幅降低多线程环境下的资源竞争[12][25]。测试表明,这一改进使多表关联查询效率得到“显著提升”,尤其在高并发场景下,构建阶段性能改善直接带动端到端查询延迟降低[12]。

优化演进核心脉络

- 24.x 版本:探测阶段需拆分输入块至对应哈希表实例,存在块拆分开销与资源浪费。

- 25.1 版本:构建阶段合并为共享哈希表,探测阶段并发访问,消除块拆分开销,提速 31.87%(TPC-H 测试)。

- 25.2 版本:构建阶段引入无锁设计,减少线程争用,进一步提升多表关联效率。

上述优化使 ClickHouse 并行哈希连接在处理大表关联时更接近理论性能上限,结合其自适应连接算法(优先哈希连接,多张大表时 fallback 至合并连接),为用户提供了更高效、稳定的查询体验[10]。

延迟物化(Lazy Materialization)

Top N 查询作为数据分析中常见的场景,传统执行模式存在显著性能瓶颈:需将查询涉及的所有列数据完整加载到内存,并对全量数据执行排序操作后再截取前 N 条结果。这种方式在数据量庞大时会导致严重的 I/O 开销和内存资源浪费,尤其当查询包含大量非排序键列时问题更为突出。

ClickHouse 25.4 版本引入的延迟物化(Lazy Materialization) 技术从根本上优化了这一流程。其核心原理是将非必要列数据的读取推迟到排序完成后执行:仅先加载排序键列(如示例中的 helpful_votes)进行排序,根据 LIMIT 条件筛选出 Top N 记录后,再按需读取这些记录对应的其他列数据。这种"按需加载"机制大幅减少了无效数据处理,在包含 ORDER BY 和 LIMIT 的 Top N 查询中表现尤为显著。

以 1.5096 亿行 Amazon 评论数据集为例,查询"helpful_votes 最高的前 3 条评论"的性能对比显示:

- 关闭延迟物化:需扫描全部 71.38 GB 数据,耗时 219.071 秒,内存峰值达 1.11 GiB,系统资源被大量非必要数据占用;

- 启用延迟物化:仅需处理 1.81 GB 排序键列数据,耗时缩短至 0.139 秒,内存峰值降至 3.80 MiB。最终实现性能提升 1576 倍,I/O 开销减少 40 倍,内存消耗降低 300 倍[26][27]。

启用配置:通过会话级参数开启延迟物化优化SETTINGS query_plan_optimize_lazy_materialization = true

适用场景判断标准:

- 必须包含

ORDER BY子句(用于指定排序键列); - 必须包含

LIMIT子句(用于限制最终结果集大小); - 查询涉及多列数据,但仅需对少量排序键列进行全局排序。

延迟物化本质上是列式存储优势的深度挖掘,通过精准控制数据读取时机,在 Top N 等场景下实现资源消耗与查询效率的最优平衡。该优化尤其适用于大数据量表的头部数据查询,如电商平台销量排行、用户活跃度统计等业务场景。

功能增强

JSON数据类型

在半结构化数据处理场景中,传统将JSON数据存储为String类型的方式存在显著局限性:需通过字符串解析提取字段导致查询性能低下,复杂路径访问需手动类型转换,且无法利用列式存储优势实现高效压缩与索引。ClickHouse 25.3版本正式将JSON数据类型标记为生产就绪(GA),专为解决此类痛点设计,提供半结构化数据的高效存储与查询能力。

核心技术特性与优势

ClickHouse JSON类型采用列式JSON存储架构,基于Variant和Dynamic类型系统实现,支持动态JSON路径直接访问,无需手动类型转换。其核心优势包括:

- 存储效率:采用紧凑列式存储,空间占用比传统压缩文件更小,且支持按路径粒度动态管理存储内容。

- 查询性能:通过原生路径索引与类型优化,查询速度远超MongoDB等文档数据库,接近原生列存性能。

- 扩展性:基于Dynamic/Variant类型体系设计,未来可扩展支持XML、YAML等其他半结构化数据格式。

- 灵活性:支持动态路径发现与类型推断,同时允许显式定义关键路径类型以提升查询效率。

生产就绪状态:JSON/Dynamic/Variant类型已从Beta阶段正式进入生产环境,通过列式存储与动态类型系统的结合,解决了半结构化数据"存储散、查询慢、扩展难"的行业痛点。

定义语法与参数配置

JSON类型的定义语法支持精细化配置路径管理策略,核心参数包括:

<column_name> JSON(

max_dynamic_paths=N, -- 最大动态路径数,默认1024

max_dynamic_types=M, -- 最大动态类型数,默认32

some.path TypeName, -- 显式指定子路径类型(如kind LowCardinality(String))

SKIP path.to.skip, -- 跳过无需存储的路径

SKIP REGEXP 'paths_regexp' -- 通过正则跳过匹配路径

)

其中,显式指定子路径类型(如kind LowCardinality(String))可显著提升该路径的查询性能,而SKIP机制能减少无效数据存储,优化空间占用。

操作示例

1. 创建表示例

以下示例创建存储社交媒体事件数据的表,显式定义kind和time_us字段类型以优化查询:

CREATE TABLE bluesky(

data JSON(

kind LowCardinality(String), -- 显式指定kind为低基数字符串类型

time_us UInt64, -- 显式指定时间戳为无符号整数

max_dynamic_paths=2048 -- 调整动态路径上限至2048

)

) ORDER BY (

data.kind, -- 基于JSON路径直接排序

fromUnixTimestamp64Micro(data.time_us) -- 时间戳转换为可读时间

) SETTINGS index_granularity_bytes = 0; -- 禁用按字节粒度索引

2. 插入数据示例

使用JSONEachRow格式直接插入JSON数据,无需提前定义完整结构:

INSERT INTO bluesky FORMAT JSONEachRow

{'kind': 'post', 'time_us': 1712345678901234, 'content': 'Hello ClickHouse', 'author': {'id': 123, 'name': 'Alice'}};

3. 查询数据示例

通过动态路径直接访问JSON字段,支持复杂聚合分析:

-- 按事件类型统计数量

SELECT data.kind, count() AS cnt

FROM bluesky

GROUP BY data.kind

ORDER BY cnt DESC;

-- 提取嵌套字段并过滤

SELECT data.author.name, data.content

FROM bluesky

WHERE data.kind = 'post' AND data.time_us > 1712345678000000;

适用场景与最佳实践

JSON类型适用于以下场景:

- 动态结构数据:字段键不确定或频繁变化(如用户行为日志、IoT设备数据)。

- 多类型值场景:同一字段可能存储不同类型数据(如数字/字符串混合的属性值)。

- 快速迭代业务:需快速接入新数据格式而无需频繁修改表结构。

不建议场景:

- 已知固定结构数据:优先使用标准列或嵌套类型(Nested)以获得最佳性能。

- 高频更新场景:JSON类型优化目标为查询性能,频繁更新可能导致额外开销。

性能对比:在半结构化数据查询场景中,ClickHouse JSON类型的查询速度远超MongoDB等文档数据库,存储占用比传统压缩JSON文件更小,尤其适合大规模日志分析与事件追踪系统。

未来,基于Dynamic/Variant类型体系,ClickHouse计划扩展对XML、YAML等半结构化格式的原生支持,进一步强化多模态数据处理能力。

查询条件缓存

在数据分析场景中,重复执行相同或相似过滤条件的查询(如仪表盘刷新、实时监控分析)常面临I/O 冗余问题——每次查询需重新扫描大量数据,导致资源浪费与延迟增加。为解决这一痛点,ClickHouse 25.3 版本引入了查询条件缓存(Query Condition Cache),通过轻量级内存机制优化重复查询的执行效率[23][28]。

工作原理

查询条件缓存的核心是按数据粒度(granule)记录是否满足特定 WHERE 条件。每个 granule 是 ClickHouse 数据存储的最小单元(通常对应 8192 行数据),缓存会为其标记两种状态:0(无符合条件的行)或1(至少一行符合条件)。缓存键由表 ID、数据分片名称及查询谓词哈希值组成,确保仅对相同表、分片和过滤条件的查询复用缓存结果[23]。

当重复执行查询时,系统会先检查缓存:若 granule 状态为0,则直接跳过扫描;若为1,则仅扫描该 granule 内数据。这一机制可大幅减少无关数据扫描,尤其适用于高选择性查询场景[23][29]。

实践效果:Bluesky 事件流案例

以社交平台 Bluesky 的事件流分析为例,需频繁统计含特定表情(如椒盐卷饼 emoji)的帖子数量。首次执行查询时,系统需全量扫描数据:

- 首次查询:扫描 99.46 million rows,耗时 0.529 秒。

- 启用缓存后重复查询:仅扫描 2.16 million rows(仅为首次的 2.17%),耗时 0.037 秒,性能提升约 14 倍[23]。

这一效果源于缓存对“不含目标表情 granule”的精准过滤,避免了重复 I/O 操作。

核心特性与配置

查询条件缓存具有占用空间小、速度快的优势,其设计特点包括:

- 轻量级存储:每个 granule 状态仅需 1 字节记录,默认 100MB 缓存可存储约 8.39 亿个 granule 条目[23]。

- 批量写入优化:通过批量记录多个 granule 结果减少缓存更新开销。

启用与配置步骤

- 启用缓存:

SETTINGS use_query_condition_cache = true(默认未启用)。 - 调整大小:通过

query_condition_cache_size设置缓存容量(默认 100MB,支持动态调整)。

监控与运维

为确保缓存有效运行,ClickHouse 提供了完善的监控工具:

- 缓存内容查询:通过

system.query_condition_cache系统表查看缓存键、状态及命中情况。 - 命中指标监控:在

system.query_log表中,通过QueryConditionCacheHits(命中次数)和QueryConditionCacheMisses(未命中次数)指标分析缓存效率[23]。

适用场景

查询条件缓存尤其适合重复执行固定过滤条件的场景,如:

- 实时仪表盘(固定时间范围+维度过滤);

- 可观测性分析(重复监控特定指标异常);

- 高频报表生成(固定业务标签筛选)。

通过减少无效数据扫描,该机制在保持查询准确性的同时,显著降低了系统资源消耗,是 ClickHouse 25.x 版本对分析性能的重要优化[28][29]。

安装与配置

环境准备

硬件要求

ClickHouse 的高性能运行依赖于合理的硬件配置,其架构设计对 CPU 计算能力、内存容量和存储 I/O 性能均有较高要求。推荐基础配置为 8 核 CPU + 32 GB 内存 + 1 TB SSD,具体说明如下:

- CPU:推荐 8 核及以上多核处理器,ClickHouse 的查询执行过程高度并行化,多核心可显著提升复杂查询(如多表关联、聚合计算)的处理效率。

- 内存:至少 16 GB,推荐 32 GB 及以上。ClickHouse 采用内存计算模型,大量中间结果和热点数据需加载至内存,内存不足会导致频繁磁盘交换,严重影响性能。

- 存储:优先选择 1 TB 及以上 SSD 硬盘。ClickHouse 属于 I/O 密集型应用,高频的列式存储读写、分区合并等操作对存储吞吐量和随机访问速度要求极高,SSD 相比 HDD 可降低 90% 以上的 I/O 延迟。

硬件架构方面,ClickHouse 支持 x86_64、AArch64 及 PowerPC64LE 架构,操作系统推荐 CentOS 7/8、Ubuntu 18.04/20.04 等 Linux 发行版,同时也可运行于 FreeBSD 或 Mac OS X 系统。

系统配置

为确保 ClickHouse 稳定运行,需对操作系统进行以下关键配置,涉及网络安全、资源限制、内核参数等方面:

1. 关闭防火墙与 SELinux

- 临时关闭防火墙:

systemctl stop firewalld,永久禁用:systemctl disable firewalld - 关闭 SELinux:

sed -i 's/SELINUX=enforcing/SELINUX=disabled/' /etc/selinux/config,并执行setenforce 0立即生效

作用:避免防火墙策略和 SELinux 安全规则阻塞 ClickHouse 服务端口(如默认 9000/TCP)及内部通信,简化初期部署复杂度。

2. 调整文件句柄限制

执行以下命令设置系统级文件打开数限制:echo "* soft nofile 262144" >> /etc/security/limits.confecho "* hard nofile 262144" >> /etc/security/limits.conf

作用:ClickHouse 服务进程需同时打开大量数据文件(尤其分区表场景),默认文件句柄限制(通常 1024)无法满足需求,调高限制可避免 “too many open files” 错误。

3. 禁用透明大页(THP)

执行命令:echo never > /sys/kernel/mm/transparent_hugepage/enabled,并添加至 /etc/rc.local 实现开机持久化

作用:透明大页会导致内存分配延迟不稳定,ClickHouse 对内存分配实时性要求较高,禁用后可减少查询响应时间波动。

4. 集群环境额外配置(如部署分布式集群):

- 主机名-IP 映射:编辑

/etc/hosts添加节点映射(如192.168.1.101 ch-node1),确保节点间通过主机名通信。 - 免密登录:通过

ssh-keygen生成密钥,ssh-copy-id分发至所有节点,实现集群节点间无密码访问。 - ZooKeeper 集群:ClickHouse 分布式表元数据依赖 ZooKeeper 协调,需部署 3 节点及以上 ZooKeeper 集群(如节点 two、three、four),并配置数据目录与端口。

注意事项:所有配置需在 root 权限下执行,修改后建议重启服务器或重新加载配置(如 sysctl -p),确保参数生效。集群部署时需保证所有节点配置一致,避免因环境差异导致数据同步异常。

单机安装

RPM包安装

RPM 包安装方式适用于 CentOS、RHEL 等基于 RPM 的 Linux 发行版。以下以 CentOS 7 为例,提供完整的 ClickHouse 安装流程,包括仓库配置、软件安装、服务管理及验证步骤。

1. 添加官方仓库

首先需配置 ClickHouse 官方仓库以获取稳定版本。执行以下命令完成仓库初始化:

# 安装 yum-utils 工具包(提供 yum-config-manager 命令)

sudo yum install yum-utils -y

# 导入官方 GPG 密钥(用于验证安装包完整性)

sudo rpm --import https://repo.clickhouse.tech/CLICKHOUSE-KEY.GPG

# 添加 ClickHouse 稳定版仓库配置

sudo yum-config-manager --add-repo https://repo.clickhouse.tech/rpm/stable/x86_64

```[[19](https://blog.csdn.net/weixin_42300574/article/details/112119082)][[30](https://blog.csdn.net/qq_45781301/article/details/117909574)]

##### 2. 安装服务端与客户端

通过 yum 命令安装 ClickHouse 核心组件,包括服务端(clickhouse-server)和交互式客户端(clickhouse-client):

```bash

sudo yum install clickhouse-server clickhouse-client -y

-y 参数用于自动确认安装过程中的依赖关系,无需手动交互[30]。

3. 启动 ClickHouse 服务

使用 systemd 或传统 service 命令启动服务:

# 推荐使用 systemd 管理服务(CentOS 7 及以上默认支持)

sudo systemctl start clickhouse-server

# 或使用 service 命令

sudo service clickhouse-server start

启动后可通过 systemctl status clickhouse-server 检查服务状态,确保其正常运行(显示 active (running))[30]。

4. 验证安装结果

通过客户端连接服务端并执行版本查询命令,验证安装是否成功:

clickhouse-client --query "SELECT version()"

若返回类似 23.3.2.37 的版本号字符串,表明 ClickHouse 服务已正常运行[31]。

生产环境注意事项

- 默认无密码风险:初始配置中,

default用户无密码即可登录,生产环境需修改/etc/clickhouse-server/users.xml,为用户添加密码(如<password>your_secure_password</password>)并限制网络访问。 - 数据与日志目录:默认数据存储路径为

/var/lib/clickhouse,日志路径为/var/log/clickhouse-server。建议根据磁盘规划调整路径(需同步修改/etc/clickhouse-server/config.xml中的<path>和<log>配置)。 - 服务自启动:通过

sudo systemctl enable clickhouse-server设置开机自启,避免服务器重启后服务中断。

Docker安装

Docker 提供了快速部署 ClickHouse 的轻量级方案,适用于开发测试与生产环境。以下将从基础启动、参数解析、数据持久化到安装验证,系统化介绍 Docker 部署流程。

基础启动命令与参数解析

ClickHouse 官方提供了预构建的 Docker 镜像,可通过单行命令快速启动容器。基础测试环境命令如下:

docker run -d --name clickhouse -p 9000:9000 -p 8123:8123 --ulimit nofile=262144:262144 clickhouse/clickhouse-server

参数说明:

-d:后台运行容器(守护进程模式),避免终端阻塞。--name clickhouse:指定容器名称为clickhouse,便于后续管理(如停止、重启)。-p 9000:9000:映射容器内 9000 端口(TCP 客户端端口)到主机 9000 端口,供clickhouse-client连接。-p 8123:8123:映射容器内 8123 端口(HTTP 接口端口)到主机 8123 端口,支持 HTTP 客户端与 JDBC 连接。--ulimit nofile=262144:262144:设置容器最大文件描述符限制(软限制/硬限制),ClickHouse 因高并发 IO 需求需提高此值(默认系统限制可能过低导致性能问题)。clickhouse/clickhouse-server:使用官方镜像,默认拉取最新稳定版。若需指定版本,可添加标签(如clickhouse/clickhouse-server:25.4.5.24)。

生产环境数据持久化配置

测试环境可直接使用临时存储,但生产环境必须通过数据卷挂载实现数据持久化,否则容器删除或重启后数据将丢失。完整步骤如下:

1. 准备本地目录

创建数据、配置、日志存储目录,并赋予权限:

mkdir -p /data/clickhouse/data /data/clickhouse/conf /data/clickhouse/log

chmod -R 777 /data/clickhouse # 简化权限配置,生产环境可按需细化

2. 启动容器并挂载卷

通过 -v 参数将本地目录挂载到容器内对应路径:

docker run -d \

--name clickhouse-server \

-p 9000:9000 -p 8123:8123 \

--ulimit nofile=262144:262144 \

-v /data/clickhouse/data:/var/lib/clickhouse \ # 数据持久化

-v /data/clickhouse/conf:/etc/clickhouse-server \ # 配置文件持久化

-v /data/clickhouse/log:/var/log/clickhouse-server \ # 日志持久化

clickhouse/clickhouse-server

3. 配置文件优化(可选)

若需自定义配置(如远程访问、密码认证),可先从临时容器复制默认配置文件到本地目录,修改后重新挂载:

# 创建临时容器复制配置

docker run -d --rm --name clickhouse-temp clickhouse/clickhouse-server

docker cp clickhouse-temp:/etc/clickhouse-server/config.xml /data/clickhouse/conf/

docker cp clickhouse-temp:/etc/clickhouse-server/users.xml /data/clickhouse/conf/

docker stop clickhouse-temp

# 修改 config.xml 允许远程访问(默认仅本地)

sed -i 's/<listen_host>::1<\/listen_host>/<listen_host>::<\/listen_host>/g' /data/clickhouse/conf/config.xml

客户端连接与安装验证

1. 进入容器内客户端

通过 docker exec 命令进入运行中的容器,并启动 clickhouse-client:

docker exec -it clickhouse-server clickhouse-client

-it:以交互模式进入容器终端。clickhouse-server:目标容器名称(需与启动时--name参数一致)。clickhouse-client:容器内预装的命令行客户端。

2. 验证安装

在客户端中执行简单查询,确认服务正常运行:

SELECT 1;

若返回结果 1,则表示 ClickHouse 服务部署成功。

3. 带密码认证的连接(若配置)

若启动容器时通过 -e CLICKHOUSE_PASSWORD=your_password 设置了密码,连接时需指定密码:

docker exec -it clickhouse-server clickhouse-client --password your_password

进阶配置示例

指定版本与端口映射

测试环境中可灵活调整端口与版本,例如使用 25.4.5.24 版本并映射非默认端口:

docker run -d \

-p 18123:8123 -p 19000:9000 \ # 主机端口 18123->容器8123,19000->容器9000

-e CLICKHOUSE_PASSWORD=thinker \ # 设置默认用户密码

--name ch25 \

--ulimit nofile=262144:262144 \

clickhouse:25.4.5.24 # 使用指定版本镜像

生产环境核心注意事项:

- 必须通过

-v挂载数据目录,避免数据丢失。 - 配置

--ulimit nofile提高文件描述符限制,防止高并发下 IO 错误。 - 自定义配置文件时,确保修改

config.xml中的listen_host允许必要的网络访问。

集群部署

ZooKeeper集群配置

ZooKeeper作为ClickHouse集群的核心协调组件,承担着副本同步协调、元数据管理及分布式锁服务等关键功能,其稳定运行直接影响ClickHouse集群的数据一致性与可用性。在生产环境中,推荐部署3节点ZooKeeper集群以满足高可用需求,以下为详细配置流程。

3节点ZooKeeper集群部署步骤

1. 环境准备与依赖安装

ZooKeeper运行依赖Java环境,需在所有节点执行以下命令安装JDK:

安装Java依赖

sudo yum install java-1.8.0-openjdk-devel -y

验证安装结果

java -version # 应输出1.8.0版本信息

2. 下载与部署ZooKeeper

选择稳定版本(如3.7.1)进行部署,所有节点执行相同操作:

下载并解压安装包

wget https://downloads.apache.org/zookeeper/zookeeper-3.7.1/apache-zookeeper-3.7.1-bin.tar.gz

tar -zxvf apache-zookeeper-3.7.1-bin.tar.gz

mv apache-zookeeper-3.7.1-bin /usr/local/zookeeper

创建数据目录

mkdir -p /data/zookeeper # 用于存储ZooKeeper数据与myid文件

3. 核心配置文件 zoo.cfg 配置

在 /usr/local/zookeeper/conf/ 目录下创建或修改 zoo.cfg,配置集群通信参数与节点信息:

zoo.cfg 核心配置

tickTime=2000 # 基础时间单元(毫秒),用于心跳检测与会话超时

initLimit=10 # 集群初始化时Leader与Follower的连接超时时间(tickTime倍数)

syncLimit=5 # Leader与Follower同步数据的超时时间(tickTime倍数)

dataDir=/data/zookeeper # 数据存储目录,需与步骤2中创建的目录一致

clientPort=2181 # 客户端连接端口

集群节点配置:server.ID=主机名:通信端口:选举端口

server.1=zk1:2888:3888

server.2=zk2:2888:3888

server.3=zk3:2888:3888

注:

zk1、zk2、zk3需替换为实际节点的主机名或IP地址,2888为节点间通信端口,3888为选举端口。

4. 节点标识文件 myid 创建

每个节点需通过 myid 文件声明唯一ID(与 zoo.cfg 中 server.ID 对应),在各节点分别执行:

在 zk1 节点

echo 1 > /data/zookeeper/myid

在 zk2 节点

echo 2 > /data/zookeeper/myid

在 zk3 节点

echo 3 > /data/zookeeper/myid

5. 集群启动与状态验证

依次在所有节点启动ZooKeeper服务,并验证集群状态:

启动服务

/usr/local/zookeeper/bin/zkServer.sh start

验证集群状态

/usr/local/zookeeper/bin/zkServer.sh status

预期结果:1个节点显示 “Mode: leader”,2个节点显示 “Mode: follower”

ClickHouse中ZooKeeper集群配置

完成ZooKeeper集群部署后,需在ClickHouse配置文件中声明ZooKeeper节点信息,通常在 metrika.xml 或 config.xml 中添加如下配置:

ClickHouse ZooKeeper配置示例

zk1

2181

zk2

2181

zk3

2181

部署最佳实践与重要性说明

ZooKeeper集群的稳定运行是ClickHouse分布式表副本机制的基础,其核心价值体现在:

- 副本同步协调:通过ZAB协议(ZooKeeper Atomic Broadcast)确保副本数据一致性,实现故障自动转移;

- 元数据管理:集中存储分布式表结构、分区信息等关键元数据,避免单点故障导致的元数据丢失;

- 分布式锁服务:协调多节点并发写操作,防止数据冲突。

生产环境中需严格遵循 独立部署原则,避免将ZooKeeper与ClickHouse部署在同一服务器,以防止资源竞争影响集群稳定性[18]。通过合理配置与监控,ZooKeeper集群可有效支撑ClickHouse的高可用与数据一致性需求。

ClickHouse集群配置

ClickHouse集群配置的核心在于合理定义分片(Shard)、副本(Replica)及协调服务(如ZooKeeper或Keeper Server),并通过宏变量(macros)标识节点角色。以下以“2分片2副本”架构为例,详细说明配置流程与核心要点。

一、核心配置示例

集群配置文件通常位于/etc/clickhouse-server/config.d/cluster.xml,需包含remote_servers(集群拓扑)、zookeeper(协调服务)和macros(节点标识)三大核心模块。完整配置示例如下:

<clickhouse>

<!-- 定义集群拓扑:2分片,每分片2副本 -->

<remote_servers>

<clickhouse_cluster> <!-- 集群名称,创建分布式表时需引用 -->

<!-- 分片1:包含2个副本 -->

<shard>

<replica>

<host>ck1</host> <!-- 副本1主机名/IP -->

<port>9000</port> <!-- ClickHouse TCP端口 -->

</replica>

<replica>

<host>ck2</host> <!-- 副本2主机名/IP -->

<port>9000</port>

</replica>

</shard>

<!-- 分片2:包含2个副本 -->

<shard>

<replica>

<host>ck3</host> <!-- 副本1主机名/IP -->

<port>9000</port>

</replica>

<replica>

<host>ck4</host> <!-- 副本2主机名/IP -->

<port>9000</port>

</replica>

</shard>

</clickhouse_cluster>

</remote_servers>

<!-- ZooKeeper配置:用于副本数据同步与集群协调 -->

<zookeeper>

<node> <!-- ZooKeeper节点1 -->

<host>zk1</host>

<port>2181</port> <!-- ZooKeeper默认端口 -->

</node>

<node> <!-- ZooKeeper节点2 -->

<host>zk2</host>

<port>2181</port>

</node>

<node> <!-- ZooKeeper节点3 -->

<host>zk3</host>

<port>2181</port>

</node>

</zookeeper>

<!-- 宏变量:标识节点的分片与副本角色 -->

<macros>

<shard>01</shard> <!-- 分片标识:ck1/ck2设为01,ck3/ck4设为02 -->

<replica>01</replica> <!-- 副本标识:ck1/ck3设为01,ck2/ck4设为02 -->

</macros>

</clickhouse>

二、核心配置项解析

1. remote_servers:集群拓扑定义

该模块用于声明集群名称及分片-副本结构,是分布式查询与数据分发的基础。每个<shard>标签代表一个逻辑分片,内部可包含多个<replica>标签定义物理副本节点,每个副本需指定host(主机名或IP)和port(TCP端口,默认9000)。上述示例中,clickhouse_cluster集群包含2个分片,每分片2个副本,共4个数据节点[32]。

2. zookeeper:协调服务配置

ZooKeeper(或ClickHouse Keeper Server)负责副本间元数据同步、分布式锁管理及故障检测。配置中需列出所有ZooKeeper节点的host和port(默认2181),建议部署3个以上节点以保证高可用。若使用Keeper Server(基于Raft协议的替代方案),需额外配置<keeper_server>标签,指定server_id和Raft集群节点信息[32]。

3. macros:节点角色标识

宏变量通过<shard>和<replica>标签定义当前节点的分片与副本编号,用于创建分布式表时自动识别节点角色。例如,分片1的两个副本(ck1、ck2)需将<shard>设为01,副本编号分别设为01和02;分片2的两个副本(ck3、ck4)则将<shard>设为02,副本编号同样为01和02。该配置需在每个节点的cluster.xml中单独设置,确保角色唯一[3]。

三、配置分发与服务启动

- 配置文件分发:将修改后的

cluster.xml文件复制到所有ClickHouse节点的/etc/clickhouse-server/config.d/目录下,确保各节点配置与自身角色匹配(尤其是macros部分)。 - 服务重启:在所有节点执行以下命令重启服务,使配置生效:

systemctl restart clickhouse-server

四、集群状态验证

配置完成后,需通过SQL查询验证集群与副本状态:

集群状态验证:执行以下命令检查所有分片和副本是否正常注册:

SELECT * FROM system.clusters WHERE cluster = 'clickhouse_cluster';

副本同步验证:执行以下命令确认副本数据同步状态(is_leader、is_synchronous等字段需正常):

SELECT * FROM system.replicas WHERE table = '<目标表名>';

若查询结果中所有分片的host_name、port均正确显示,且副本状态无异常(如last_queue_update_time正常更新),则集群配置成功。实际生产环境中,还需结合监控工具(如Prometheus)持续跟踪节点健康状态,确保数据一致性与服务可用性。

数据模型设计

表结构设计原则

在 ClickHouse 中,表结构设计是决定查询性能的核心环节,其合理性直接影响数据存储效率、查询响应速度及系统扩展性。“合适的表结构是性能的基础”,这一理念贯穿于表设计的全流程,需结合业务场景、查询模式及引擎特性综合考量。以下从五大核心原则展开阐述,并结合实践案例说明优化路径。

一、窄表原则:按业务维度拆分,避免字段冗余堆砌

窄表原则强调将不同业务维度的数据拆分为独立表,通过主键关联实现逻辑整合,而非追求“大而全”的宽表设计。这一设计可降低单表复杂度,提升数据压缩效率,并减少查询时的无效字段扫描。

实践要点:

- 按业务实体拆分表:例如将“用户信息”与“订单记录”拆分为独立表,通过

user_id关联查询,而非合并为包含用户所有属性的订单宽表。 - 控制单表字段数量:核心业务表字段建议不超过 50 个,高频查询字段优先保留,低频字段可通过关联或物化视图补充。

- 避免跨维度混合存储:如物联网场景中,设备状态数据与地理位置信息应分表存储,仅在分析时通过设备 ID 关联,而非在单表中同时存储时序数据与静态属性。

核心逻辑:窄表设计通过降低字段密度提升压缩率(MergeTree 引擎对同构数据压缩效率更高),同时减少查询时的 I/O 扫描范围,尤其适用于十亿级以上大表场景。

反例警示:某电商平台曾将用户行为、商品信息、订单明细合并为单表,导致单表字段达 120+,查询时即使仅过滤 user_id,也需加载大量无关字段,压缩率下降 40%,查询延迟增加 3 倍。

二、适当冗余:以空间换时间,减少 JOIN 操作

ClickHouse 对多表 JOIN 支持较弱,尤其在大表关联场景下性能损耗显著。通过适度冗余非高频变更字段,可避免跨表 JOIN,直接从单表获取完整分析数据。

典型场景:

- 订单表冗余商品名称:订单表中除

product_id外,冗余存储product_name(商品名称变更频率低),避免查询时关联商品表。 - 用户表冗余区域信息:在用户行为表中冗余

region(地区)、city(城市)字段,无需关联用户资料表即可按地区分析行为数据。

冗余边界:仅冗余低变更频率、高查询频率的字段,如商品分类、用户等级等;对实时性要求高的动态数据(如库存数量)则需通过其他方式(如物化视图)同步,避免数据一致性问题。

三、数据类型优化:精准匹配业务需求,降低存储与计算开销

数据类型选择直接影响存储占用、压缩效率及查询性能。需基于字段特性(基数、取值范围、更新频率)选择最优类型,避免“一刀切”使用通用类型。

关键优化策略:

| 字段类型 | 优化建议 | 性能收益 |

|---|---|---|

| 数值型 | 优先使用最小可用明确类型(如用 UInt8 存储状态码 0-255,Int32 存储用户 ID),避免 Nullable 类型(如用 Int32 而非 Nullable(Int32)) | 存储占用降低 30%-50%,压缩算法(如 Delta)优化效果更显著[12] |

| 字符串型 | 低基数字段(如地区、类别)转换为 LowCardinality(String),高基数字段保留 String 类型 |

低基数场景下查询速度提升 2-5 倍,存储占用降低 40%-70%[12][26] |

| 时间型 | 用 DateTime/DateTime64 存储时间(如 action_time DateTime),避免字符串类型 |

支持按时间范围高效过滤(如 WHERE action_time > '2025-01-01'),节省字符串解析开销[12] |

| 高精度数值 | 金融场景使用原生 Decimal 类型(如 amount Decimal(18,4)),避免 Float 精度丢失 |

满足多市场数据精度要求,兼容 PostgreSQL 迁移场景[17] |

实例参考:Hacker News 帖子表中,by(作者名)字段使用 LowCardinality(String) 优化,存储占用减少 62%,按作者筛选的查询延迟从 800ms 降至 230ms[26]。代码示例如下:

CREATE TABLE hackernews_history (

`id` UInt32,

`by` LowCardinality(String), -- 低基数字符串优化

`time` DateTime, -- 时间类型精准匹配

`type` Enum8('story' = 1, 'comment' = 2) -- 枚举类型替代字符串

) ENGINE = MergeTree() ORDER BY id;

四、分区键设计:基于查询频率与数据生命周期的垂直拆分

分区键(PARTITION BY)决定数据的物理存储划分,合理设计可大幅减少查询时的扫描范围。其核心原则是选择低基数、高频过滤的字段,使查询能通过分区裁剪快速定位数据。

最佳实践:

- 时序数据按时间分区:如日志表按

toDate(event_time)按天分区,物联网数据按coll_date Date分区,支持 Grafana 按时间范围可视化[19]。 - 业务数据按维度分区:如多租户场景按

tenant_id分区,地域数据按region_code分区,确保单分区数据量均衡(建议单个分区大小 10GB-100GB)。

反例:某系统将高基数字段 user_id 作为分区键,导致分区数量超过 100 万,元数据管理开销激增,查询时分区裁剪失效。

五、排序键设计:匹配查询模式的一级索引优化

排序键(ORDER BY)是 MergeTree 引擎的一级索引,决定数据在分区内的物理排序顺序,直接影响过滤、排序及聚合查询性能。设计需严格匹配高频查询的过滤条件与排序逻辑。

核心策略:

- 字段顺序遵循“高选择性优先”:将过滤频率高、区分度大的字段前置。例如用户行为表按

(dt, user_id, action_type)排序,支持按日期+用户 ID 快速定位行为记录[1]。 - 覆盖高频查询条件:若查询常按

product_type过滤并按create_date排序,则排序键设为(product_type, create_date)[14]。 - 主键与排序键的协同:ClickHouse 主键(PRIMARY KEY)无唯一约束,默认与排序键一致,若需支持特殊查询可单独指定。例如企业信息表按

(credite_code, enterprise_name)作为主键,匹配按企业代码和名称的查询场景[33]。

注意事项:排序键字段不宜过多(建议 1-3 列),过多字段会增加索引维护成本,降低插入性能。同时,避免将低基数字段(如性别)作为排序键首位,否则数据分布不均,影响压缩效率。

六、避免过度设计:平衡性能与复杂度

表结构设计需避免“为优化而优化”,需结合业务规模与查询需求动态调整:

- 禁用不匹配场景的引擎:大表禁用 Memory 引擎(内存限制),小表慎用 Nullable 类型(增加存储与计算开销)[12]。

- 简化索引层级:非高频查询字段无需创建二级索引,避免索引维护开销超过查询收益。

- 兼容迁移场景:如长桥科技通过统一表结构设计(原生 Decimal 类型、兼容 PostgreSQL 字段类型),实现多市场数据无缝迁移[17]。

综上,ClickHouse 表结构设计需以业务查询为导向,通过窄表拆分、适度冗余、精准类型选择、合理分区与排序键配置,构建高效的数据存储模型。这一过程需平衡性能需求与维护成本,最终实现“以结构优化驱动性能提升”的目标。

分区策略

分区是 ClickHouse 查询优化的“第一利器”,通过将数据按特定维度划分为逻辑分区,可显著提升查询性能并简化数据管理。对于时间序列数据(如日志、监控指标、用户行为事件等),合理的分区设计尤为关键,其中按时间维度的分区策略应用最为广泛。

时间序列数据的分区设计

时间序列数据具有天然的时间关联性,按时间粒度(如天、月)分区可充分发挥 ClickHouse 的查询剪枝能力。当查询条件包含时间范围时,系统会自动跳过无关分区,仅扫描目标分区数据,避免全表扫描;同时,过期数据可通过直接删除分区目录实现快速清理,无需逐行操作[2][6]。

按天分区的典型实现如下,通过 toYYYYMMDD(event_time) 函数将数据按天划分为独立分区:

CREATE TABLE events (

event_time DateTime, -- 时间序列数据的核心字段

event_type String, -- 业务事件类型

user_id UInt64, -- 用户标识

data String -- 事件详情

) ENGINE = MergeTree()

PARTITION BY toYYYYMMDD(event_time) -- 按天分区

ORDER BY (event_type, user_id, event_time) -- 结合业务维度排序

SETTINGS index_granularity = 8192; -- 索引粒度配置

该设计的核心优势在于:

- 查询效率最大化:实时分析场景中,按天分区可将查询范围精确到单日或几日数据,扫描数据量大幅减少;

- 数据生命周期管理简化:对于需保留 30 天的日志数据,可通过

ALTER TABLE events DROP PARTITION '20250901'直接删除指定日期分区,操作高效且不影响其他数据[6]。

分区粒度的选择:天 vs 月

分区粒度需平衡查询效率与管理成本,不同业务场景适用不同粒度:

按天分区:适用于实时分析、高频查询场景(如监控告警、实时报表)。

- 优势:查询精度高,单分区数据量小(尤其数据写入频繁时),剪枝效果显著;

- 注意:分区数量随时间线性增长,需避免长期运行后分区数超过 1000 个(可能影响元数据管理效率)[12]。

按月分区:适用于历史数据归档、低频查询场景(如年度报表、合规审计)。

- 优势:分区数量少,管理成本低,单分区数据量大(10 GB-100 GB 为宜),适合批量数据操作[15];

- 示例:通过

PARTITION BY toYYYYMM(event_time)实现按月分区,如202509代表 2025 年 9 月数据[14]。

动态分区与多维度扩展

手动创建分区易导致遗漏或冗余,ClickHouse 支持通过 enable_dynamic_partitioning=1 配置动态分区,系统会根据写入数据自动创建对应分区,无需预先定义[15]。此外,分区策略可结合业务维度扩展,例如按“地区+时间”多维度分区,满足复杂查询需求:

-- 多维度分区示例:按地区和月份组合

PARTITION BY (region, toYYYYMM(date))

该方式可进一步缩小查询范围,例如定位“华东地区 2025 年 9 月”的数据时,仅需扫描对应组合分区[1]。

分区管理实践

分区的高效管理是保障系统长期稳定运行的关键,核心操作包括:

- 删除过期分区:直接删除分区目录,适用于数据生命周期管理。

ALTER TABLE logs DROP PARTITION '20250801'; -- 删除 2025 年 8 月 1 日分区 - 合并小分区:通过

OPTIMIZE命令合并同一分区内的小文件,减少磁盘 IO 开销。OPTIMIZE TABLE events PARTITION '20250918' FINAL; -- 合并指定分区数据

随着版本迭代,ClickHouse 分区能力持续增强,例如 25.1 版本已支持 Hive-style 分区,并通过 use_hive_partitioning 设置默认启用,进一步提升与大数据生态的兼容性[29]。

综上,分区策略的设计需结合业务查询模式、数据量及生命周期需求,通过合理的粒度选择、动态配置与管理,可充分发挥 ClickHouse 的性能优势。

物化视图设计

物化视图是 ClickHouse 中实现查询性能优化的核心技术之一,其通过预计算并物理存储高频查询结果,避免了对原始数据的全量扫描,显著降低查询延迟。在实际业务中,物化视图尤其适用于查询频繁且计算逻辑复杂的聚合指标场景,例如实时销售统计、用户行为分析等高频统计场景。

基础物化视图设计:按小时聚合场景

以电商平台的“销售数据实时汇总”需求为例,首先需构建基础物化视图实现小时级数据聚合。采用 SummingMergeTree 引擎可自动合并相同主键的聚合结果,适合累加类指标计算。

基础物化视图创建示例(小时级聚合)

CREATE MATERIALIZED VIEW sales_hourly

ENGINE = SummingMergeTree()

PARTITION BY toYYYYMMDD(event_time) -- 按天分区,优化时间范围查询

ORDER BY (product_id, hour) -- 按产品 ID 和小时排序,加速主键过滤

AS SELECT

product_id, -- 产品维度

toStartOfHour(event_time) AS hour, -- 时间粒度下钻到小时

sum(amount) AS total_sales -- 预计算销售额总和

FROM sales_raw -- 原始销售数据

GROUP BY product_id, hour; -- 按产品和小时分组聚合

上述设计中,SummingMergeTree 引擎会将相同 (product_id, hour) 组合的记录自动合并,存储 total_sales 的累加结果。查询时直接读取该视图,可跳过对 sales_raw 表的全量扫描,响应速度提升通常可达 10 倍以上。

级联物化视图设计:逐层汇总优化

当业务需要更高粒度的聚合(如天级汇总)时,基于基础物化视图构建级联物化视图可进一步降低计算成本。通过“小时级→天级”的逐层汇总,查询天级数据时无需扫描小时级明细,直接读取预计算结果。

级联物化视图创建示例(天级聚合)

CREATE MATERIALIZED VIEW sales_daily

ENGINE = SummingMergeTree()

PARTITION BY toYYYYMM(day) -- 按月分区,适配月度报表场景

ORDER BY (product_id, day) -- 按产品 ID 和天排序

AS SELECT

product_id,

toStartOfDay(hour) AS day, -- 从小时级聚合结果提取天级时间

sum(total_sales) AS daily_sales -- 累加小时销售额得到日销售额

FROM sales_hourly -- 基于小时级物化视图聚合

GROUP BY product_id, day;

逐层汇总优势:

- 存储效率:天级视图仅保留聚合后的数据,存储空间通常为小时级视图的 1/24(假设均匀分布)。

- 查询性能:直接查询

sales_daily可避免扫描大量小时级记录,尤其在跨月、跨年的历史数据查询中效果显著。 - 计算复用:基础视图的预计算结果可被多个上层视图复用(如同时支持天级、周级汇总),降低整体计算资源消耗。

适用场景与最佳实践

物化视图并非万能优化手段,需根据业务特点合理设计:

- 适用场景:高频执行的聚合查询(如 Top N 商品销售额、实时 UV/PV 统计)、计算逻辑固定且资源消耗大的查询(如多表关联 + 窗口函数)。

- 引擎选择:

- 累加类指标(销售额、订单量):优先使用

SummingMergeTree。 - 去重计数(独立用户数):采用

AggregatingMergeTree配合uniqState函数。 - 明细数据同步:使用普通

MergeTree引擎实现数据实时同步(如从 Kafka 表同步至物化视图)。

- 累加类指标(销售额、订单量):优先使用

- 注意事项:物化视图不支持实时更新,需通过

REFRESH MATERIALIZED VIEW手动触发刷新(或依赖引擎自动合并机制),因此适用于近实时而非强实时场景。

通过合理设计物化视图的层级与聚合粒度,可在 ClickHouse 中构建高效的“预计算 - 查询加速”体系,满足企业级数据分析的性能需求。

查询优化

索引优化

主键与排序键优化

排序键(ORDER BY)是 ClickHouse 中决定数据物理存储顺序的核心配置,其设计直接影响查询性能。合理的排序键能够通过减少数据扫描范围、利用稀疏索引实现快速定位,从而显著提升查询效率,因此被业界称为 ClickHouse 查询性能的“基石”。排序键的设计需紧密结合业务查询模式,优先将高频过滤、排序的字段置于 ORDER BY 子句的左侧,以确保查询条件能够命中排序键前缀,触发索引剪枝机制[3][34]。

以“用户行为表”为例,典型的查询场景通常包含对事件类型(event_type)、用户标识(user_id)和时间范围(event_time)的组合过滤。此时,最优排序键设计应为 ORDER BY (event_type, user_id, event_time)。该设计的核心逻辑在于:首先,event_type 作为高频过滤的低基数列(如“点击”“购买”等有限类别),置于首位可快速过滤出目标事件类型的数据分区;其次,user_id 作为高基数列,紧随其后可进一步缩小用户粒度的数据范围;最后,event_time 作为时间序列列,用于定位具体时间窗口的数据,实现“分区过滤→用户定位→时间扫描”的三级查询剪枝,最大化利用主键索引的稀疏索引特性[24][34]。

反之,若采用错误的排序键设计(如仅按 ORDER BY event_time 或 ORDER BY (user_id, event_time)),则会导致查询无法有效利用前缀过滤。例如,当仅按 event_time 排序时,相同 event_type 的数据分散存储,查询需扫描全表时间范围内的所有事件类型数据,扫描量可能增加数倍甚至数十倍;若将 user_id 置于 event_type 之前,由于 user_id 基数极高,相同 event_type 的数据被分散到大量用户分组中,同样无法实现按事件类型的高效过滤[3][34]。

主键(PRIMARY KEY)在 ClickHouse 中默认与排序键相同,若需独立指定,其核心作用是生成稀疏索引以加速范围查询。主键索引的有效性取决于查询条件是否命中排序键前缀,例如当排序键为 (event_type, user_id, event_time) 时,WHERE event_type='click' AND user_id=123 可命中前缀,而 WHERE user_id=123 AND event_time>'2025-01-01' 因缺失 event_type 前缀无法触发索引剪枝[15][34]。此外,主键设计需避免过长,以免索引文件过大导致内存占用增加和查询效率下降[34]。

ClickHouse 25.7 版本对主键功能进行了优化,支持主键被单调函数(如 toDate(event_time))包裹时仍可应用二进制搜索,进一步提升了时间范围等场景的查询性能[21]。实践中,可通过 EXPLAIN 语句查看索引使用情况,重点关注 ReadFromStorage(数据扫描量)和 Aggregating(聚合耗时)指标,验证排序键设计的有效性[12]。

排序键设计三原则

- 高频优先:将最频繁出现在 WHERE 条件中的字段(如 event_type)置于排序键最左侧;

- 基数适配:低基数列(如类别字段)优先于高基数列(如用户 ID),平衡过滤效率与数据分布;

- 前缀匹配:确保查询条件包含排序键的左侧前缀,避免索引失效。

综上,排序键的设计需以业务查询模式为导向,通过合理的字段顺序与组合,最大化索引剪枝效果。主键作为排序键的延伸,需兼顾索引效率与存储开销,两者共同构成 ClickHouse 数据查询性能的基础架构。

二级索引优化

ClickHouse 的二级索引(跳数索引)作为主键索引的补充,通过对非主键字段构建索引结构,可显著减少查询时扫描的 granules 数量,提升过滤效率。其核心价值在于针对不同数据特征与查询场景选择适配的索引类型,并通过合理配置参数平衡查询性能与存储开销。

分类型优化案例与实践

minmax 索引:范围查询优化

minmax 索引适用于低基数字段的范围过滤场景(如状态字段 status='active'、时间范围 create_time > '2025-01-01'),通过记录每个 granule 内字段的最小值与最大值,快速排除不满足条件的 granules。

创建示例:

ALTER TABLE events ADD INDEX status_minmax status TYPE minmax GRANULARITY 4;

其中,GRANULARITY 4 表示每 4 个 granules 聚合为一个索引项,平衡索引精度与存储开销。ClickHouse 25.1 版本起支持通过配置 add_minmax_index_for_numeric_columns=1 自动为所有数值列添加 minmax 索引,实测可将过滤场景的扫描 granules 数量从 3192 降至 82,大幅提升查询效率[6][25]。

bloom_filter 索引:高基数等值查询优化

bloom_filter 索引适用于高基数字段的等值查询(如用户 ID user_id=12345、订单号 order_no='ORD202509'),通过概率数据结构快速判断值是否存在,支持设置误判率参数平衡精度与存储。

创建示例:

ALTER TABLE events ADD INDEX user_bloom user_id TYPE bloom_filter(0.01) GRANULARITY 1;

参数 0.01 表示允许 1% 的误判率(即实际不存在的值有 1% 概率被判定为存在),需根据业务对准确性的要求调整;GRANULARITY 1 表示为每个 granule 单独构建索引,适用于高频精确过滤场景[15][34]。

索引类型选择与粒度配置

除上述两种核心类型外,需根据字段特征与查询场景选择其他索引类型:

- 低基数枚举字段(如

event_type包含 100 种以内取值):使用set索引,例如ALTER TABLE events ADD INDEX event_type_index event_type TYPE set(100) GRANULARITY 4,直接存储 granule 内的唯一值集合,加速枚举值过滤[22]。 - 文本子串模糊查询(如

name LIKE '%zhang%'):使用ngrambf_v1索引,对文本按 n-gram 分词构建 bloom filter;分词文本搜索(如全文检索MATCH(text) AGAINST('clickhouse')):使用tokenbf_v1索引,基于分词结果构建索引[34]。

索引粒度(GRANULARITY)是关键配置项:粒度越小(如 1),过滤精度越高但索引存储开销越大;粒度越大(如 16),存储开销降低但可能导致无效扫描。建议对高频过滤字段使用较小粒度(1-4),低频字段使用较大粒度(8-16)[3]。

二级索引最佳实践

- 避免滥用:低基数字段(如性别

gender仅含 2 个取值)无需建索引,否则会增加写入时的索引维护开销,反而降低性能。 - 场景适配:仅为频繁过滤的非主键字段创建索引,例如错误代码、用户等级等高频过滤列[22]。

- 动态评估:通过

system.indexes表监控索引使用频率,定期清理未命中查询的冗余索引。

二级索引的核心价值在于补充主键索引无法覆盖的过滤场景,需结合字段基数、查询频率与存储成本综合设计,避免“为索引而索引”的过度优化。

查询语句优化

过滤条件优化

在 ClickHouse 中,过滤条件的优化是提升查询性能的核心手段之一,尤其在处理大宽表或高基数数据时效果显著。通过合理设计过滤逻辑,可大幅减少数据扫描范围、降低 I/O 开销并缩短计算链路。以下从核心机制、关键技巧与实践方案三个维度展开分析。

PREWHERE 机制:大宽表查询的核心优化

对于包含数百列的大宽表查询,传统 WHERE 子句会先加载所有列数据再过滤,导致大量无效 I/O。PREWHERE 子句通过分离过滤逻辑与数据读取流程,实现“先过滤后加载”,显著减少数据扫描量。以用户行为分析场景为例:

-- 优化前:加载所有列后过滤,I/O 浪费严重

SELECT * FROM events WHERE event_type = 'click' AND user_id = 123;

-- 优化后:仅加载过滤列完成筛选,再读取目标列

SELECT event_time, data FROM events PREWHERE event_type = 'click' AND user_id = 123;

其执行逻辑为:先读取 PREWHERE 子句中的过滤列(如 event_type、user_id),对数据行进行筛选后,仅加载 SELECT 子句中指定的目标列(如 event_time、data)。实践表明,过滤条件的选择性越高(即筛选后保留的数据比例越低),PREWHERE 的优化效果越显著,在高选择性场景下可将 I/O 开销降低 90% 以上。

关键优化技巧:从语法到执行逻辑的全链路优化

1. 避免无差别数据加载与传输

- 禁用

SELECT *:明确指定所需字段可减少数据传输量与内存占用。例如,大宽表中仅查询 5 列相比SELECT *可降低 90% 以上的数据处理量 [2][34]。 - 过滤条件下推:将过滤逻辑尽可能提前至存储层执行,减少中间结果集大小。例如,在关联查询中,先对单表应用

WHERE条件过滤,再执行JOIN操作,可降低关联数据量 [20]。

2. 避免字段转换与复杂计算阻塞过滤效率

- 预计算派生字段:若需频繁按日期筛选,应预先存储

date类型字段(如event_date),而非在WHERE子句中通过toDate(timestamp)动态转换,后者会导致索引失效并触发全表扫描 [12]。 - 简化非索引列条件:避免对非索引字段使用复杂函数(如

WHERE length(username) > 10),此类操作无法利用索引加速,需逐行计算后过滤 [2]。

3. 利用存储结构与缓存机制加速过滤

- 分区裁剪:通过

WHERE条件过滤分区键(如event_date = '2025-09-18'),使 ClickHouse 仅扫描目标分区,减少 90% 以上的无效分区扫描 [12]。 - 查询条件缓存:对于高选择性重复查询(如模糊查询

LIKE '%keyword%'),可复用查询谓词缓存结果,不同聚合操作(如COUNT、GROUP BY)只要WHERE条件相同即可直接命中缓存,响应时间缩短 50% 以上 [23]。

实用工具与调试方法

-

索引优化:为高频过滤字段添加索引,例如对订单表的

total_amount字段创建minmax索引,加速范围查询:ALTER TABLE orders ADD INDEX amount_index total_amount TYPE minmax GRANULARITY 4;[14]

-

LIMIT 采样调试:在查询优化阶段,使用

LIMIT 1000采样数据快速验证逻辑,避免全量执行浪费资源。例如:SELECT event_time, data FROM events PREWHERE event_type = 'click' LIMIT 1000;

核心原则总结

- 选择性优先:PREWHERE 适用于过滤条件选择性 > 90% 的场景,选择性越高效果越显著。

- 避免函数阻塞:WHERE 子句中禁止对索引字段进行函数转换,优先使用预计算字段。

- 存储与计算协同:结合分区键、索引与缓存机制,实现“过滤逻辑下沉”,减少数据扫描范围。

通过上述策略,ClickHouse 可在万亿级数据场景下将查询延迟从分钟级降至秒级,为实时分析与业务决策提供高效支撑。

JOIN优化

ClickHouse 的 JOIN 操作在处理大规模数据时易面临内存溢出和性能瓶颈,需通过针对性优化提升效率。以下结合“用户表(小表)与订单表(大表)JOIN”场景,从表位置、JOIN 类型、分布式策略、版本特性及参数配置五个维度展开优化实践。

一、表位置优化:小表右置减少内存占用

ClickHouse 默认以 右表构建哈希表,因此将小表作为右表可显著降低内存消耗。例如用户表(百万级数据)与订单表(亿级数据)JOIN 时,需确保用户表为右表:

-- 优化前:大表作为右表,哈希表过大导致内存压力

SELECT o.order_id, u.user_name

FROM order_table o

LEFT JOIN user_table u ON o.user_id = u.id;

-- 优化后:小表作为右表,哈希表体积减小

SELECT o.order_id, u.user_name

FROM order_table o

LEFT JOIN user_table u ON o.user_id = u.id;

-- 注:实际需通过表顺序调整确保小表在右侧,或通过参数自动优化

技术原理:哈希表构建于右表,小表右置可减少哈希表的行数和内存占用。建议通过 SET join_algorithm='auto' 让系统基于细粒度统计信息自动选择右表,进一步优化内存使用效率[12]。

注意事项:若未明确指定右表,可通过 EXPLAIN 命令查看执行计划,确认哈希表构建对象是否为小表。当表数据量差异不明显时,可通过 join_algorithm='hash' 强制使用哈希连接并指定右表。

二、JOIN 类型优化:精准选择匹配策略

根据业务场景选择合适的 JOIN 类型,可避免不必要的数据匹配和计算开销:

1. ANY JOIN 替代 LEFT JOIN(单匹配场景)

当仅需保留右表首个匹配结果时(如用户最新订单),使用 ANY JOIN 替代 LEFT JOIN,避免全量匹配导致的笛卡尔积风险:

-- 低效:LEFT JOIN 保留所有匹配结果,可能产生冗余数据

SELECT u.id, o.order_time

FROM user_table u

LEFT JOIN order_table o ON u.id = o.user_id;

-- 优化:ANY JOIN 仅保留右表首个匹配项,减少计算量

SELECT u.id, o.order_time

FROM user_table u

ANY LEFT JOIN order_table o ON u.id = o.user_id;

优势:右表存在重复键时,ANY JOIN 仅保留第一条匹配记录,降低内存占用和计算耗时[34]。

2. IN 查询替代 JOIN(单字段关联场景)

对于单字段关联(如通过用户 ID 过滤订单),使用 IN 子查询性能优于 JOIN,因其可减少表扫描次数:

-- 低效 JOIN 写法

SELECT * FROM order_table o

LEFT JOIN user_table u ON o.user_id = u.id

WHERE u.status = 'active';

-- 优化 IN 写法

SELECT * FROM order_table

WHERE user_id IN (SELECT id FROM user_table WHERE status = 'active');

三、分布式 JOIN 优化:GLOBAL JOIN 减少数据传输

在分布式集群中,普通 JOIN 会导致各分片间大量数据 Shuffle,而 GLOBAL JOIN 通过“右表集中聚合+广播分发”模式降低网络开销:

工作机制:

- 协调节点聚合右表:将小表(如用户表)在协调节点进行聚合,生成全局临时表;

- 广播至所有分片:将临时表广播到各数据分片,避免分片间数据交互;

- 本地 JOIN 计算:各分片使用本地大表(如订单表)与广播的小表进行 JOIN。

示例代码:

-- 分布式环境优化前:普通 JOIN 导致分片间数据 Shuffle

SELECT o.order_id, u.user_name

FROM distributed_order o

JOIN distributed_user u ON o.user_id = u.id;

-- 优化后:GLOBAL JOIN 减少网络传输

SELECT o.order_id, u.user_name

FROM distributed_order o

GLOBAL JOIN distributed_user u ON o.user_id = u.id;

适用场景:右表数据量较小(建议百万级以内),可通过 GLOBAL IN 进一步简化单字段关联:WHERE user_id GLOBAL IN (SELECT id FROM distributed_user)[12][34]。

四、版本特性:25.x 并行哈希连接性能跃升

ClickHouse 25.x 版本对 JOIN 机制进行深度优化,并行哈希连接性能较 24.x 提升 30%+,并引入多项智能特性:

- JOIN 重排序:基于细粒度统计信息自动调整表连接顺序,减少无效计算[25];

- 自动外部内存 JOIN:当内存不足时,自动将部分数据写入磁盘,避免 OOM(Out Of Memory)[29];

- 分布式 JOIN 优化:通过分片键对齐和数据预聚合,降低跨节点数据传输量。

此外,23.x+ 版本已支持 并行哈希连接,多表关联场景下可通过多核并行计算提升吞吐量[12]。

五、关键配置参数:控制内存与算法选择

通过调整配置参数平衡 JOIN 性能与稳定性:

| 参数名 | 作用描述 | 建议值 |

|---|---|---|

max_rows_in_join |

限制 JOIN 操作中右表最大行数,超过则抛出异常,防止内存溢出 | 1000000(根据内存调整) |

join_algorithm |

指定 JOIN 算法,auto 会基于表大小自动选择哈希连接或合并连接 |

auto |

max_bytes_in_join |

限制 JOIN 操作的内存使用上限,超过则启用外部内存(需 25.x+ 版本支持) | 1000000000(1GB) |

参数设置示例:

-- 设置右表最大行数为 100 万

SET max_rows_in_join = 1000000;

-- 启用自动算法选择

SET join_algorithm = 'auto';

六、进阶优化:关联子查询与冗余移除

- 移除冗余 JOIN:通过等价类替换简化逻辑,例如将多表 JOIN 转换为子查询,避免 CROSS JOIN 风险[21];

- EXISTS 子查询优化:仅读取必要列,减少数据扫描量:

-- 优化前:JOIN 读取全表字段 SELECT a.* FROM table_a a JOIN table_b b ON a.id = b.id; -- 优化后:EXISTS 仅判断存在性,不读取冗余字段 SELECT * FROM table_a a WHERE EXISTS (SELECT 1 FROM table_b b WHERE a.id = b.id);

总结

ClickHouse JOIN 优化需围绕 “减少数据量、优化内存占用、降低网络传输” 三大核心目标,结合业务场景选择小表右置、ANY JOIN、GLOBAL JOIN 等策略,并利用 25.x+ 版本的并行哈希连接与自动内存管理能力提升性能。实际应用中,建议通过 EXPLAIN 分析执行计划,结合监控指标(如内存使用率、查询耗时)动态调整优化方案。

配置参数优化

ClickHouse 的配置参数优化是提升集群性能的核心环节,需结合硬件资源与业务场景动态调整。以下从生产环境实践出发,分模块梳理关键参数配置策略,并提炼优化原则。

内存管理:避免 OOM 与资源竞争

内存参数配置直接影响查询稳定性。max_memory_usage 限制单个查询的最大内存使用量(默认 10GB),推荐根据节点物理内存调整,例如 32GB 内存节点建议设为 22GB(约 70%),避免单查询耗尽资源导致 OOM [34]。同时,max_memory_usage_for_all_queries 需控制所有查询的总内存消耗,推荐设为物理内存的 80%,防止多查询并发时内存溢出 [34]。

内存配置黄金比例:单查询内存(max_memory_usage)≤ 物理内存 70%,总查询内存(max_memory_usage_for_all_queries)≤ 物理内存 80%,预留 20% 空间应对突发任务。

CPU 与并行化:平衡性能与资源开销

CPU 资源的高效利用依赖线程池与并行策略配置。max_threads 控制单查询最大线程数,默认值为物理 CPU 核数,但生产环境推荐设为逻辑 CPU 核数的 75%(如 16 核逻辑 CPU 设为 12),避免线程切换开销 [34]。例如,某场景将 max_threads 从 4 增至 20 后,查询耗时从 69ms 降至 35ms,但内存占用从 31.01MiB 增至 49.49MiB,需权衡性能与资源消耗 [24]。

后台任务(如合并、复制)由 background_pool_size 控制,生产环境建议设为 16,确保后台操作不抢占查询资源 [34]。此外,通过 parallel_aggregation_min_rows(默认 100,000)触发多线程聚合,当单表行数超过阈值时自动启用并行计算,提升聚合查询效率 [34]。

I/O 与写入优化:提升吞吐量与稳定性

I/O 性能优化需兼顾文件句柄与写入效率。max_open_files 建议设为 65536,支持高并发场景下打开更多数据文件 [34]。写入环节,max_insert_block_size 控制单次插入块大小,推荐设为 1048576(约 100 万行),通过批量写入减少 I/O 次数,高频写入场景可配合 Buffer 表引擎实现异步写入 [12]。

分布式写入场景中,启用 parallel_distributed_insert_select 可并行执行分布式 INSERT SELECT 操作,而 min_joined_block_size_rows(默认 65409)需根据 JOIN 场景调整,避免小 Block 导致的频繁网络传输开销 [21]。

生产环境配置示例(XML)

以下为综合优化后的核心配置片段,涵盖内存、CPU、I/O 与写入关键参数:

<clickhouse>

<!-- 内存管理 -->

<max_memory_usage>22000000000</max_memory_usage> <!-- 32GB 内存节点设为 22GB -->

<max_memory_usage_for_all_queries>25600000000</max_memory_usage_for_all_queries> <!-- 32GB 内存的 80% -->

<!-- CPU 与并行化 -->

<max_threads>12</max_threads> <!-- 16 核逻辑 CPU 的 75% -->

<background_pool_size>16</background_pool_size> <!-- 后台任务线程池 -->

<!-- 写入优化 -->

<max_insert_block_size>1048576</max_insert_block_size> <!-- 100 万行/次插入 -->

<parallel_distributed_insert_select>1</parallel_distributed_insert_select> <!-- 启用并行分布式写入 -->

</clickhouse>

参数调整的“黄金原则”

参数优化需遵循“业务场景适配”与“硬件动态调整”双维度原则:

- 读多场景:调大

max_threads与parallel_aggregation_min_rows,提升查询并行度;降低index_granularity(如 8192)减少稀疏索引内存占用 [12]。 - 写多场景:启用

parallel_distributed_insert_select,配合大批次写入(≥1000 行/次),避免小 Block 开销 [12]。 - 资源隔离:通过 workload 调度器为不同任务配置资源队列,例如为实时报表任务设置

max_concurrent_threads = 60,避免临时查询抢占资源 [27]。

避免“一刀切”陷阱:默认参数仅适用于通用场景,生产环境需通过监控(如内存使用率、查询耗时)持续迭代,例如将 min_joined_block_size_rows 从默认 65409 调至 100000,可减少小表 JOIN 的碎片开销 [21]。

企业案例分析

广告投放效果分析

案例背景与业务挑战

在互联网广告领域,广告平台需通过实时分析广告点击、曝光、转化等数据优化投放策略,提升 ROI。某广告平台面临日增数据 10 亿条的规模压力,需针对不同素材、渠道的投放效果进行实时多维分析,传统数据库因无法支撑高吞吐写入(每秒数十万级数据流入)和实时聚合计算,难以满足秒级响应和 100+ 维度分析的业务需求,成为制约投放效率提升的关键瓶颈。

基于 ClickHouse 的解决方案

该平台构建了“实时接入 - 高效存储 - 快速分析”的全链路数据处理架构,核心技术选型与实施细节如下:

数据处理 pipeline:采用 Kafka 接收实时广告数据,经 Flink 完成数据清洗与转换后,写入 ClickHouse 集群。

表结构优化:选用 ReplicatedMergeTree 表引擎保障高可用,按天分区(event_date)并以 (ad_id, event_time) 为排序键,优化按广告 ID 和时间维度的查询性能。

核心指标计算:通过 SQL 实时计算 CTR(点击率)、CPC(每次点击成本)、ROI 等关键指标,例如 CTR 计算公式为:SELECT ad_id, sum(click)/sum(impression) AS ctr FROM ad_events WHERE event_date='2024-01-01' GROUP BY ad_id

此外,平台基于 ClickHouse 实现了用户群体、素材类型、投放渠道等多维度交叉分析,并通过 BI 工具可视化结果,支撑精细化运营决策。

实施效果与技术价值

ClickHouse 凭借其列式存储和向量化执行引擎特性,显著提升了广告数据分析效能:

- 高吞吐写入:实现 50 万行/秒的数据写入能力,满足日增 10 亿条数据的存储需求;

- 极速查询响应:核心指标查询响应时间小于 1 秒,较传统 Hive 等工具快数倍至数十倍,支持 100+ 维度的实时钻取分析;

- 业务价值显著:通过精准去重计算(如 UV 统计)确保分析结果准确性,助力投放策略优化,最终实现 ROI 提升 20%。

该案例验证了 ClickHouse 在广告实时监测场景下的技术优势,其高吞吐、快查询、强扩展的特性为广告平台的精细化运营提供了核心支撑。

物联网设备监控

在工业物联网与智能制造场景中,实时监控设备传感器数据、预测故障并优化生产效率已成为核心需求。传感器每几秒上报的温度、振动、压力等指标需被高效处理,既要支撑毫秒级实时预警,又需长期存储以训练故障预测模型。ClickHouse凭借其高吞吐写入、实时查询响应与低成本存储特性,成为该场景的关键技术支撑。

解决方案架构与数据流程

典型架构采用“数据采集-传输-存储-分析-可视化”全链路设计:

- 数据采集:传感器通过 MQTT协议(如EMQ X broker)采集设备状态数据(温度、振动、转速等),每5秒/次高频上报。

- 数据传输:MQTT消息经Kafka集群缓冲,实现削峰填谷与解耦,再通过Kafka引擎表或Flink Connector写入ClickHouse。

- 数据存储:ClickHouse构建设备状态历史库,采用冷热分离策略(MergeTree存储热数据,S3存储冷数据)降低成本,并通过TTL自动清理过期数据。

- 分析与可视化:实时监控通过ClickHouse秒级查询实现阈值报警,历史趋势通过Grafana展示,模型训练依赖长期聚合数据。

核心数据链路:传感器 → MQTT(EMQ X)→ Kafka → ClickHouse(存储)→ Grafana(可视化)/ 模型训练(故障预测)

表设计与写入优化

针对物联网数据高写入、时序性、多维度特点,ClickHouse表设计需兼顾性能与查询灵活性:

1. 核心表结构示例(故障预测场景):

CREATE TABLE sensor_data (

device_id UInt64, -- 设备唯一标识

timestamp DateTime64(3), -- 毫秒级时间戳

temperature Float32, -- 温度指标

vibration Float32 -- 振动指标

) ENGINE = MergeTree()

PARTITION BY toYYYYMM(timestamp) -- 按年月分区

ORDER BY (device_id, timestamp) -- 设备+时间排序,加速单设备查询

TTL timestamp + INTERVAL 1 YEAR; -- 自动清理1年以上冷数据

2. 写入优化策略:

- Flink Connector优化:通过攒批写入(Batch Size=1024)、分片分发(按device_id哈希)、背压感知,提升写入吞吐量至每秒数百万条。

- Kafka引擎表:直接消费Kafka topic数据,减少中间环节,示例:

CREATE TABLE sensor_data_kafka ( device_id UInt64, timestamp DateTime64(3), temperature Float32, vibration Float32 ) ENGINE = Kafka() SETTINGS kafka_broker_list = 'kafka:9092', kafka_topic_list = 'sensor_topic'; - 冷热分离存储:近期高频访问数据存本地磁盘,历史数据迁移至S3,存储成本降低60%。

实时监控与历史趋势分析

1. 实时监控与预警

通过ClickHouse的低延迟聚合能力,实时监测设备异常指标。例如,查询5分钟内温度超阈值设备并触发报警:

SELECT device_id, max(temperature) AS max_temp

FROM sensor_data

WHERE timestamp > now() - INTERVAL 5 MINUTE

GROUP BY device_id

HAVING max_temp > 80; -- 温度阈值80℃

某制造企业应用该逻辑后,设备异常响应时间从分钟级降至<500ms,故障率降低40%。

2. 历史趋势与故障预测

通过长期数据聚合分析设备退化规律,训练预测模型。例如,按周聚合振动数据:

SELECT

device_id,

toStartOfWeek(timestamp) AS week,

avg(vibration) AS avg_vibration

FROM sensor_data

GROUP BY device_id, week;

工业物联网公司基于此数据训练的LSTM模型,故障预测准确率提升35%,维修成本降低30%。

实施效果与价值

ClickHouse在物联网设备监控场景中的核心价值体现在高吞吐、低延迟、低成本三大维度,典型实施效果如下表所示:

| 指标 | 具体数据 | 业务价值 |

|---|---|---|

| 设备接入规模 | 200万+设备 | 覆盖全厂区设备监测 |

| 写入吞吐量 | 50万条/秒(峰值100万条/秒) | 支撑高频传感器数据采集 |

| 查询延迟 | 实时查询<500ms,历史聚合<2秒 | 快速响应异常与趋势分析 |

| 故障预测准确率 | 提升35% | 主动预防故障,减少停机 |

| 生产效率提升 | 25% | 优化设备利用率 |

某工业物联网公司实践表明,ClickHouse不仅满足了每秒数百万条数据的实时处理需求,还通过长期历史数据存储与高效聚合分析,构建了“实时监控-趋势分析-故障预测”的完整闭环,最终实现设备故障率降低40%、生产效率提升25%的显著收益。

金融风控与交易分析

在金融领域,实时反欺诈是风控体系的核心环节,需在海量交易数据中快速识别异常行为,同时平衡检测精度与效率。ClickHouse凭借其高效的实时分析能力和分布式架构,已成为金融机构构建实时风控系统的关键技术支撑,以下从业务实践、技术方案与实施效果展开说明。

业务场景与技术挑战

金融机构面临的核心挑战包括:每日需处理数亿级交易流水,要求在毫秒至秒级延迟内完成异常检测,同时需支持复杂的用户行为分析与风险建模。例如,某银行需实时分析客户转账、支付、取现等交易行为,识别短时间大额转账、频繁小额交易等欺诈特征,并基于历史数据构建客户画像以优化风控模型[35]。此外,系统需具备高写入吞吐量(如每分钟百万级交易流水统计)和低存储成本,同时确保分布式环境下的数据可靠性与查询效率[14]。

技术方案设计

1. 数据存储与表结构优化

采用分布式表设计承载交易数据,具体配置如下:

- 表引擎与分片策略:使用分布式表(Distributed)结合AggregatingMergeTree引擎,按

user_id作为分片键实现数据均匀分布,同时配置2个副本确保高可用[14]。 - 核心字段:包含

user_id(用户标识)、trans_amount(交易金额)、trans_time(交易时间)、device_info(设备信息)、category(交易品类)等,支持多维度风险分析。 - 数据生命周期管理:启用TTL(Time to Live)自动淘汰过期数据,降低存储成本并提升查询效率[14]。

2. 实时异常检测逻辑

基于窗口函数实现高频交易与大额交易的实时监控,核心SQL逻辑如下:

SELECT user_id,

count() AS freq,

sum(trans_amount) AS total

FROM transactions

WHERE trans_time > now() - INTERVAL 1 HOUR

GROUP BY user_id

HAVING freq > 10 OR total > 100000;

该查询通过聚合最近1小时内的交易数据,筛选出交易频次超10次或累计金额超10万元的用户,触发风控规则[14]。

3. 客户画像构建

利用ClickHouse的数组类型(Array)与聚合函数arrayAgg(category)存储用户历史交易品类,快速分析消费偏好与行为特征。例如,通过arrayAgg(category)聚合用户近3个月交易品类,结合频次统计识别异常消费模式,辅助信用风险评估[35]。

4. 性能优化措施

为支撑高并发写入与低延迟查询,实施以下优化:

- 写入优化:调整批次大小至10万条/批,写入吞吐量从5万条/秒提升至25万条/秒[14]。

- 存储引擎选择:采用AggregatingMergeTree预聚合历史数据,减少实时计算压力[14]。

- 分布式查询优化:通过视图合并实时与历史数据(如MySQL存储最近1年数据、ClickHouse存储历史数据),平衡事务更新与查询性能[36]。

实施效果与业务价值

某金融机构应用上述方案后,实现以下业务指标提升:

- 处理规模:日均处理交易数据5亿条,每分钟支持百万级流水统计[14]。

- 实时性:异常交易检测延迟控制在2秒以内,满足实时风控需求[14]。

- 风控效果:欺诈识别率提升40%,误判率降低15%,风险预警准确率提高50%,曾在市场剧烈波动中避免数百万美元损失[1][14]。

- 成本优化:CPU使用率下降40%,存储成本显著降低,技术栈复杂度从多系统(如PostgreSQL/Redis)整合为单一ClickHouse平台,数据管理效率提升[17]。

核心技术亮点:

- 实时性:基于窗口函数与预聚合引擎,实现秒级异常检测。

- 扩展性:分布式架构支持数据分片与副本,承载亿级交易数据。

- 智能化:数组类型与聚合函数助力客户画像构建,提升风险识别精度。

ClickHouse在金融风控场景中的应用,通过“实时数据写入-高效聚合分析-精准风险识别”的全链路优化,为金融机构提供了高性能、低成本的风控解决方案,有效平衡了实时性与准确性的核心需求。

与其他工具对比

ClickHouse vs Hadoop生态(Hive/Spark)

ClickHouse 与 Hadoop 生态(Hive/Spark)在技术架构与应用场景上存在显著差异,以下从核心特性、性能表现及适用场景展开对比分析。

核心特性对比

通过整合多维度测试数据,二者的核心差异可概括如下:

| 特性 | ClickHouse | Hive+Spark |

|---|---|---|

| 存储模型 | 列式存储,本地磁盘 | 行/列式(Parquet),HDFS |

| 查询延迟 | 毫秒-秒级 | 分钟级 |

| 压缩率 | 高(5-10:1) | 中(3-5:1) |

| 易用性 | 原生SQL,简单配置 | 需Hadoop生态知识,复杂部署 |

| 实时性 | 实时写入查询 | 批处理/近实时 |

| QPS(读取) | 5000 | 3000 |

| 延迟(读取) | 10ms | 50ms |

| 吞吐量(读取) | 20TB/hour | 10TB/hour |

| 数据更新速度 | 中等(批量插入,每秒几万数据) | 慢(基于HDFS,结构化差) |

架构与性能差异解析

架构层面,ClickHouse 采用 MPP(大规模并行处理)架构,强调单机性能优化,分布式表本质为本地表代理,数据组织严格(预排序减少 I/O)且调度简单(本地执行无需复杂任务调度);而 Hive 作为元数据管理平台依赖 HDFS 存储,需将 SQL 翻译为 MapReduce/Spark 任务执行,Spark 则侧重分布式计算框架,任务调度与资源管理复杂度更高。这种架构差异直接导致了性能表现的分化:在 Wikipedia page counts 数据集(2008 年,约 260 亿行)测试中,ClickHouse(MergeTree 引擎)处理 233.7 亿行数据仅需 13.426 秒,速度达 17.4 亿行/秒,而 Spark(Parquet/ORC)未使用分区时需扫描全表,性能显著落后。

性能测试进一步验证了场景适配性:在 1.2TB 数据查询中,ClickHouse 复杂 group by 操作耗时 398.55 秒,比 Spark 的 2522.9 秒快 6.3 倍;TPC-DS 100G 数据测试显示,ClickHouse 单表查询性能为 SparkSQL 的 3-6 倍,但多表关联查询性能仅为 SparkSQL 的 1/2-1/3,Hive 耗时最长(部分查询超 1 小时)。此外,ClickHouse 压缩率优势明显,1.2TB 原始数据压缩后仅 212G,而 Spark(Parquet+Snappy)需 395G,存储效率提升约 46%。

适用场景与互补实践

基于上述特性,二者形成明显的场景分工:

核心场景定位

- ClickHouse:实时 OLAP 分析,如 dashboard 实时指标展示、广告投放效果分析、实时监控告警等,尤其适合高并发(QPS 5000+)、低延迟(毫秒级响应)的即席查询场景。

- Hadoop 生态:离线批处理,如 T+1 报表生成、数据仓库 ETL、复杂多表关联计算等,Spark 在大规模数据复杂计算(如机器学习预处理)中更具优势。

实际应用中,二者常形成互补架构。例如广投案例中,离线链路使用 Hive 存储历史全量数据,实时链路通过 Flink+ClickHouse 处理增量数据,既满足历史数据回溯需求,又实现实时指标更新。此外,ClickHouse 支持通过 Hive 集成引擎直接查询 Hive 表,查询速度远超原生 Hive,为实时分析与离线数据湖的联动提供了高效路径。

选型决策框架

技术选型需以“场景适配”为核心标准:当业务需求聚焦实时性、高并发与单表聚合分析时,ClickHouse 是最优选择;若需处理 PB 级离线数据、复杂多表关联或批处理任务,Hadoop 生态(Hive/Spark)仍不可替代。在混合场景下,可通过数据分层存储(热数据 ClickHouse+冷数据 HDFS)与查询路由优化,实现性能与成本的平衡。

ClickHouse vs Elasticsearch

ClickHouse 与 Elasticsearch(ES)作为数据处理领域的重要工具,因设计目标的差异形成了互补而非竞争的技术定位。ClickHouse 专注于 OLAP 场景下的高效聚合分析,而 Elasticsearch 则擅长全文检索与文本分析,二者在企业数据架构中承担不同职责。

核心特性对比

以下从功能定位、技术架构及性能表现等维度进行全面对比:

| 特性 | ClickHouse | Elasticsearch |

|---|---|---|

| 主要用途 | OLAP 分析、多维聚合(如 UV/PV、留存率计算) | 全文搜索、日志检索(如错误日志关键词匹配) |

| 存储模型 | 列式存储(优化聚合查询效率) | 文档存储(JSON 结构,适合半结构化数据) |

| 查询类型 | SQL 聚合(GROUP BY/SUM/COUNT 等) | 全文检索(MATCH/TERM 等分词查询) |

| 写入性能 | 高(批量写入,LSM-Tree 实现更极致) | 中(支持单条/批量写入) |

| 压缩率 | 高(5-10:1,降低存储成本) | 中(2-3:1) |

| 存储成本 | 低 | 高 |

| 查询性能(分析) | 高(亿级数据毫秒级响应,聚合性能领先 5-10 倍) | 中低 |

| 扩展性 | 强 | 弱 |

| 实时性 | 支持 | 支持 |

| 运维复杂度 | 中(架构轻量,无第三方依赖) | 高 |

| 开源协议 | Apache 2.0(功能无开源版本限制) | 开源版本存在部分功能限制 |

技术优势解析

ClickHouse 的核心竞争力体现在其为 OLAP 场景深度优化的架构设计:

- 极致写入性能:通过优化的 LSM-Tree 实现,批量写入性能显著优于 Elasticsearch,尤其适合高吞吐的时序数据场景[9]。

- 高效数据处理:MergeTree 引擎支持分区、索引与预聚合,结合向量执行引擎,使其在复杂聚合查询中表现优异,例如用户行为分析中的 UV/PV 计算可实现亚秒级响应[3][36]。

- 轻量化架构:无第三方依赖,部署运维成本低于 Elasticsearch,且 Apache 2.0 协议确保功能完整性[9]。

Elasticsearch 的不可替代性则聚焦于文本处理能力:

- 全文检索能力:支持分词、高亮、同义词扩展等文本分析功能,是日志检索、内容搜索场景的首选工具。

- 实时更新与删除:支持单文档实时写入与删除,分片均匀性设计提升集群稳定性[3]。

关键结论:ClickHouse 与 Elasticsearch 并非竞争关系,而是互补工具。在企业数据架构中,建议采用 “ClickHouse 处理结构化指标分析 + Elasticsearch 负责非结构化文本检索” 的协同方案,以最大化数据价值。

典型场景案例

- 用户行为分析:某电商平台使用 ClickHouse 计算 UV/PV、转化率等核心指标,聚合查询性能较 Elasticsearch 提升 5-10 倍,支撑实时运营决策。

- 日志监控系统:某金融机构通过 Elasticsearch 构建错误日志检索平台,利用其分词与高亮功能快速定位异常关键词,同时将聚合后的监控指标存储于 ClickHouse 供趋势分析。

通过二者的协同,企业可同时满足结构化数据高效分析与非结构化文本深度检索的需求,构建更全面的数据处理体系。

高级功能

数组操作与JSON处理

ClickHouse 对复杂数据类型提供了强大支持,其中数组类型和JSON 类型的原生集成尤为突出,能够高效处理半结构化数据场景。数组类型采用 Array(T) 定义(元素类型需一致),如 Array(UInt32) 或 Array(String),广泛应用于存储多值属性,例如 Hacker News 数据集的表设计中,使用 kids Array(UInt32) 存储评论的子评论 ID 列表:

CREATE TABLE hackernews_history (

...

kids Array(UInt32),

...

) ENGINE = ReplacingMergeTree(update_time) ORDER BY id;

```[[12](https://www.cnblogs.com/yfceshi/p/18991402)][[26](https://www.modb.pro/db/1922107331362435072)][[27](https://blog.csdn.net/ClickHouseDB/article/details/148041546)]

#### 数组操作能力

ClickHouse 提供近百种数组函数,覆盖创建、转换、过滤、聚合等全生命周期操作。基础操作包括数组元素增删(`arrayPushBack`/`arrayPopBack`)、条件过滤(`arrayFilter`)、元素转换(`arrayMap`)等,例如:

```sql

SELECT

[1, 2, 3] AS arr,

arrayPushBack(arr, 4) AS pushed, -- 结果 [1,2,3,4]

arrayPopBack(pushed) AS popped, -- 结果 [1,2,3]

arrayFilter(x -> x > 1, arr) AS filtered, -- 结果 [2,3]

arrayMap(x -> x * 2, arr) AS mapped; -- 结果 [2,4,6]

高阶函数支持复杂聚合逻辑,如 groupArray 收集用户 ID 列表后,通过 arrayUniq 去重、arraySort 排序:

SELECT

groupArray(user_id) AS all_users,

arrayUniq(all_users) AS unique_users, -- 去重后用户数

arraySort(all_users) AS sorted_users -- 排序后的用户列表

FROM user_actions;

```[[12](https://www.cnblogs.com/yfceshi/p/18991402)][[28](https://blog.csdn.net/ClickHouseDB/article/details/147027053)]

25.3 版本新增 `arraySymmetricDifference` 函数,可计算两个数组的对称差集(仅存在于一个数组的元素),例如 `arraySymmetricDifference([1,2,3], [2,3,4])` 返回 `[1,4]`,进一步增强集合运算能力[[28](https://blog.csdn.net/ClickHouseDB/article/details/147027053)]。此外,数组还可与索引结合,如通过 `mapKeys`/`mapValues` 将 Map 类型转换为数组后,应用 Bloom filter 索引加速查询[[22](https://www.cnblogs.com/johnnyzen/p/18545632)]。

#### JSON 处理机制

ClickHouse 的 JSON 类型基于列式存储优化,支持动态路径查询与高效解析。创建表时可直接定义 JSON 列,例如存储包含名称和版本的对象:

```sql

CREATE TABLE product_info (

data JSON,

...

) ENGINE = MergeTree() ORDER BY ...;

查询时通过点符号访问嵌套字段,如 data.name 或 data.commit.record.text,无需预定义 schema:

SELECT

data.name AS name,

data.version AS version

FROM product_info; -- 结果:clickhouse, 25.3

```[[21](https://github.com/ClickHouse/ClickHouse/blob/master/CHANGELOG.md)][[28](https://blog.csdn.net/ClickHouseDB/article/details/147027053)]

性能方面,JSON 类型查询效率远超字符串解析,官方测试显示**查询速度比 String 类型解析快 10 倍以上**,且支持 Parquet 格式读写,可直接将 JSON 中的整数解析为 Date/Date32 类型,兼顾灵活性与性能[[21](https://github.com/ClickHouse/ClickHouse/blob/master/CHANGELOG.md)]。

#### 数组与 JSON 的协同应用

在半结构化数据场景(如日志、事件数据)中,**数组 + JSON** 组合可高效处理动态字段与多值属性。例如,日志中的 `tags` 数组字段可通过 `ARRAY JOIN` 展开为多行分析:

```sql

SELECT tag, count() AS cnt

FROM logs

ARRAY JOIN tags

GROUP BY tag;

JSON 中的数组字段可通过 CAST 转换后操作,如展开代码提交记录中的语言列表:

SELECT

arrayJoin(CAST(data.commit.record.langs, 'Array(String)')) AS lang,

count() AS commits

FROM code_history

GROUP BY lang;

```[[23](https://blog.csdn.net/ClickHouseDB/article/details/147027528)][[34](https://www.cnblogs.com/marlon1475/p/18848053)]

对于流数据场景,Kafka 引擎表支持 `kafka_format = 'JSONEachRow'` 直接消费 JSON 格式数据,结合数组函数实现实时清洗与转换,形成从数据摄入到分析的完整链路[[7](https://developer.jdcloud.com/article/1423)]。

**最佳实践**:

- 对多值属性优先使用数组类型(如标签、ID 列表),而非字符串拼接;

- JSON 类型适用于字段结构动态变化的场景,查询时通过 `data.path` 直接访问嵌套字段;

- 结合 `ARRAY JOIN` 与数组函数可高效展开多层嵌套数据,避免二次处理。

### 窗口函数应用

ClickHouse 自 20.x 版本起原生支持标准 SQL 窗口函数,为复杂分析场景提供高效解决方案。窗口函数能够在不聚合数据行的前提下,对数据集进行分组内的精细化计算,其核心价值在于简化传统分析任务的实现逻辑,提升查询效率与代码可读性。

**典型应用示例:用户订单排序与累计金额分析**

以下 SQL 展示了如何通过窗口函数实现用户订单序号生成与累计消费金额计算:

```sql

SELECT

user_id,

order_id,

order_date,

amount,

-- 按用户分组,按订单日期排序生成订单序号

ROW_NUMBER() OVER (PARTITION BY user_id ORDER BY order_date) AS order_seq,

-- 按用户分组,计算截至当前订单的累计金额

SUM(amount) OVER (PARTITION BY user_id ORDER BY order_date ROWS BETWEEN UNBOUNDED PRECEDING AND CURRENT ROW) AS cumulative_sum

FROM orders;

该查询无需关联子查询或临时表,直接通过窗口函数完成多维度分析。

窗口函数的核心逻辑:分组-排序-计算

窗口函数通过 OVER() 子句定义分析范围(窗口),其执行逻辑可概括为三步骤:

- 分组(PARTITION BY):将数据集按指定字段划分为独立分组(如按

user_id拆分用户订单),各组内计算相互独立。 - 排序(ORDER BY):在每个分组内按指定字段排序(如按

order_date对用户订单排序),确定窗口函数的计算顺序。 - 计算(窗口函数):对每个分组内的有序数据集应用窗口函数(如

ROW_NUMBER()生成序号、SUM()计算累计和),结果保留原始数据行粒度。

这种逻辑与传统子查询实现相比,优势显著。例如,若用传统方法计算累计金额,需通过自连接或相关子查询实现:

-- 传统子查询实现累计金额(复杂度高、性能差)

SELECT

o1.user_id,

o1.order_id,

o1.amount,

(SELECT SUM(o2.amount)

FROM orders o2

WHERE o2.user_id = o1.user_id

AND o2.order_date <= o1.order_date) AS cumulative_sum

FROM orders o1;

该方式不仅代码冗长,且因多次扫描表数据导致性能损耗,而窗口函数通过一次扫描即可完成计算,尤其在大数据量场景下效率提升明显。

典型应用场景与函数类型

ClickHouse 提供丰富的窗口函数,覆盖各类分析需求:

-

排名分析:

ROW_NUMBER():生成连续唯一序号(如 1,2,3…),相同值分配不同序号,适用于分页查询、TopN 筛选。RANK():允许并列排名(如 1,1,3…),跳过后续序号,适用于竞赛排名场景。DENSE_RANK():连续排名(如 1,1,2…),不跳过序号,适用于等级划分。- 示例:按用户订单金额降序排名

SELECT user_id, total_amount, RANK() OVER (PARTITION BY user_id ORDER BY total_amount DESC) AS amount_rank FROM orders;

-

累计指标计算:通过

SUM()、AVG()等聚合函数结合窗口范围(如ROWS BETWEEN UNBOUNDED PRECEDING AND CURRENT ROW),实现累计求和、移动平均等时序指标,广泛用于财务流水、用户消费趋势分析。 -

行偏移分析:支持

LAG()和LEAD()函数获取当前行前后指定偏移的行数据,适用于同比环比计算(如本月销售额较上月增长百分比)。 -

分桶分析:

NTILE(n)将数据均匀分配到 n 个桶中,用于分位数统计(如将用户消费金额分为高、中、低三档)。

此外,ClickHouse 还支持通过 LIMIT BY 子句实现类似窗口函数的简化逻辑(如 SELECT * FROM table LIMIT 3 BY date ORDER BY time DESC),但窗口函数在复杂分析场景下的灵活性和功能完整性更具优势。

企业实践价值

窗口函数的引入显著降低了复杂分析任务的实现门槛。例如,长桥科技通过窗口函数替代原需多表关联的统计任务,将数据回测与聚合分析逻辑简化,提升代码可维护性与执行效率。在金融、电商等领域,窗口函数已成为用户行为分析、交易监控、业务指标实时计算的核心工具,助力企业从海量数据中高效提取业务洞察。

数据迁移与同步

从MySQL迁移

从MySQL迁移到ClickHouse通常需要结合全量数据初始化与增量数据同步,并通过严格验证确保数据一致性。以下是经过实践验证的完整迁移方案,涵盖技术路径、操作步骤及关键注意事项。

全量数据迁移

全量迁移旨在将MySQL中历史数据一次性导入ClickHouse,主流实现方式包括MySQL外部表引擎、文件导出导入及专用同步工具,可根据数据规模和性能需求选择。

1. MySQL外部表引擎(推荐)

ClickHouse 20.8+版本提供的MySQL引擎支持直接对接MySQL数据库,通过创建外部表实现数据查询与迁移。该方式无需中间文件,操作简洁且性能可控。

创建外部表时需指定MySQL连接信息(主机、端口、库表、账号密码),示例如下:

-- 创建MySQL外部表(映射MySQL的orders表)

CREATE TABLE mysql_orders

ENGINE = MySQL('mysql-host:3306', 'ecommerce', 'orders', 'sync_user', 'Sync@123')

AS SELECT * FROM mysql('mysql-host:3306', 'ecommerce', 'orders', 'sync_user', 'Sync@123');

-- 迁移数据到ClickHouse本地表(假设已创建ch_orders表结构)

INSERT INTO ch_orders SELECT * FROM mysql_orders;

对于千万级以上大表,可通过分区和索引优化提升迁移性能。例如按时间字段分区、按主键排序:

CREATE TABLE mysql_orders (

id UInt64,

order_date DateTime,

amount Decimal(16,2)

)

ENGINE = MySQL('mysql-host:3306', 'ecommerce', 'orders', 'sync_user', 'Sync@123')

PARTITION BY toYYYYMM(order_date) -- 按年月分区

ORDER BY (id, order_date); -- 按主键和时间排序

通过分区裁剪和有序存储,可减少全表扫描开销,尤其适合时间序列数据。

2. 文件导出导入(适合超大规模数据)

当数据量超过1亿行时,可通过“MySQL导出→文件中转→ClickHouse导入”的方式迁移,避免长时占用MySQL连接。推荐使用TSV/CSV格式,通过clickhouse-client工具高效处理:

# 从MySQL导出数据(示例:导出company_info表为TSV格式,字段分隔符为|)

mysql -h mysql-host -u user -p -e "SELECT * FROM company_info" | tr '\t' '|' > company_info.tsv

# 导入到ClickHouse(需提前创建与TSV字段匹配的表结构)

clickhouse-client --format_csv_delimiter="|" --query "INSERT INTO ch_company_info FORMAT TSV" < company_info.tsv

该方式需注意字段分隔符与NULL值处理(如用\N表示NULL),避免导入时格式解析错误。

3. 专用同步工具

阿里开源的DataX、ClickHouse官方工具clickhouse-mysql-data-connector等支持批量数据同步,可通过配置文件定义字段映射和过滤规则,适合复杂表结构(如多表合并、字段转换)场景。

增量数据同步

增量同步需实时捕获MySQL数据变更(如INSERT/UPDATE/DELETE)并同步至ClickHouse,确保迁移后数据一致性。主流方案包括Canal+Kafka+Flink链路和MaterializedMySQL引擎。

1. Canal+Kafka+Flink(企业级标准链路)

该方案通过 Canal 解析MySQL binlog,将变更数据发送至Kafka消息队列,再由Flink消费并写入ClickHouse,具备高吞吐、低延迟和故障恢复能力,适合核心业务系统。

关键步骤:

- 开启MySQL binlog(配置

binlog_format=ROW),并授权Canal访问权限; - 部署Canal Server,订阅目标表binlog并输出至Kafka指定Topic;

- 使用Flink SQL定义Kafka数据源和ClickHouse目标表,通过

upsert模式处理更新操作; - 配置Checkpoint确保Flink任务故障重启后数据不丢失。

2. MaterializedMySQL引擎(轻量级实时同步)

ClickHouse提供的MaterializedMySQL引擎兼容MySQL协议,可直接同步MySQL数据并支持DDL操作(如CREATE TABLE、ALTER TABLE)。其原理是解析MySQL binlog并维护本地物化视图,适合中小型表或非核心业务场景。

启用该引擎需满足前置条件:MySQL开启binlog(ROW格式)、ClickHouse配置allow_experimental_database_materialized_mysql=1,创建示例如下:

-- 创建MaterializedMySQL数据库(自动同步MySQL的ecommerce库)

CREATE DATABASE mysql_sync ENGINE = MaterializedMySQL('mysql-host:3306', 'ecommerce', 'sync_user', 'Sync@123')

SETTINGS

allow_simple_ddl=1, -- 允许同步DDL

materialized_mysql_tables_list='orders,users'; -- 指定同步的表

该引擎会自动在ClickHouse中创建与MySQL结构对应的表,并实时同步数据变更,但不支持部分复杂数据类型(如JSON)。

数据一致性验证

迁移完成后需通过多维度验证确保数据准确,避免因类型转换、过滤条件导致的数据差异。

1. 统计指标对比

核心验证指标包括:

- 记录数一致性:对比MySQL源表与ClickHouse目标表的

count(*)结果; - 关键字段聚合值:如订单金额

sum(amount)、用户数量count(distinct user_id); - 极值校验:检查时间字段

min(create_time)、max(create_time)是否匹配。

2. 抽样数据检查

随机抽取100-1000条记录,对比关键字段(如ID、金额、状态)的具体值,重点关注:

- 字符串类型(如

varchar)是否存在截断; - 时间类型(如

DATETIME)是否有时区偏差; - 数值类型(如

DECIMAL)精度是否丢失。

避坑指南与性能优化

迁移过程中需重点关注数据类型兼容性、锁表风险及同步延迟,以下是实践中总结的关键优化点:

1. 数据类型映射规则

MySQL与ClickHouse数据类型存在差异,需手动映射避免兼容性问题,常见映射关系如下:

| MySQL类型 | ClickHouse推荐类型 | 说明 |

|---|---|---|

| DATETIME | DateTime64(3) | 支持毫秒级精度,避免时区转换问题 |

| TIMESTAMP | DateTime64(3, ‘UTC’) | 显式指定时区,确保跨时区数据一致 |

| VARCHAR | String 或 FixedString | 长文本用String,固定长度用FixedString |

| DECIMAL(10,2) | Decimal(10,2) | 保持精度一致,避免浮点误差 |

| INT | Int32 或 Int64 | 根据实际范围选择,避免溢出 |

2. 大表迁移性能优化

- 分批次迁移:对千万级以上表,通过

WHERE子句按时间或ID分片迁移(如WHERE id BETWEEN 1 AND 1000000),避免长时间锁表; - 并行导入:使用

clickhouse-client的--max_insert_block_size参数(建议设为100万),或通过工具并行写入多个分区; - 临时关闭索引:迁移期间可禁用ClickHouse目标表的物化视图和二级索引,完成后重建。

3. 增量同步监控

- 延迟监控:通过对比MySQL binlog位点与ClickHouse同步位点,计算延迟时间(建议阈值<5秒);

- 异常告警:配置Kafka消费延迟、Flink Checkpoint失败、ClickHouse写入错误等告警,及时发现同步中断;

- 数据校验工具:使用ClickHouse的

check_table函数或第三方工具(如Great Expectations)定期巡检数据一致性。

通过上述方案,可实现MySQL到ClickHouse的平滑迁移,全量迁移性能可达275MB/s(约137万行/秒),增量同步延迟控制在秒级,满足企业级数据平台的迁移需求。实际操作中需根据数据特性(如更新频率、表大小)调整技术选型,优先采用“外部表全量+MaterializedMySQL增量”的轻量级方案,或“Canal+Flink”的高可用方案。

与Kafka实时同步

ClickHouse 与 Kafka 构建实时数据同步架构的核心模式为 “Kafka→ClickHouse”,通过 Kafka 引擎表接入流式数据,并结合物化视图实现数据持久化与实时分析。该架构具备低延迟、高吞吐特性,广泛应用于日志采集、用户行为分析等场景。

实时同步实现步骤

1. 创建 Kafka 引擎表

Kafka 引擎表作为 ClickHouse 与 Kafka 集群的桥梁,直接对接 Kafka Topic 并定义数据格式。其核心配置包括 brokers 地址、消费主题、消费组及数据序列化格式。示例 SQL 如下:

CREATE TABLE kafka_events (

event_time DateTime, -- 事件时间戳

user_id UInt64, -- 用户标识

data String -- 业务数据

) ENGINE = Kafka()

SETTINGS

kafka_broker_list = 'kafka1:9092', -- Kafka 集群地址

kafka_topic_list = 'user_events', -- 待消费的 Topic 列表

kafka_group_name = 'clickhouse_consumer', -- 消费组名称(用于 offset 管理)

kafka_format = 'JSONEachRow'; -- 数据格式(支持 JSON、CSV 等)

不同业务场景可灵活调整字段定义,例如统计类数据可定义 timestamp UInt64、level String 等字段,或简化为仅包含 data String 的通用结构[7][12]。

2. 创建物化视图持久化数据

Kafka 引擎表仅作为数据接入层,需通过物化视图将流式数据写入 ClickHouse 原生表(如 MergeTree 系列)实现持久化。物化视图会自动监听 Kafka 引擎表的数据变化,并异步写入目标表。示例 SQL 如下:

-- 创建目标表(MergeTree 引擎,用于数据存储)

CREATE TABLE clickhouse_events (

event_time DateTime,

user_id UInt64,

data String

) ENGINE = MergeTree()

ORDER BY (event_time, user_id);

-- 创建物化视图,将 Kafka 数据同步至目标表

CREATE MATERIALIZED VIEW consumer TO clickhouse_events

AS SELECT * FROM kafka_events;

核心原理与语义保障

- 自动数据拉取:物化视图后台进程会持续轮询 Kafka 引擎表,将新数据批量写入目标表,无需手动触发。

- Exactly-Once 语义:通过

kafka_group_name维护消费组的 offset,确保 Kafka 消息仅被消费一次,避免数据重复或丢失[3]。 - 故障恢复:当 ClickHouse 服务重启后,物化视图会从 Kafka 集群获取消费组的最新 offset,继续消费未处理的消息,保障数据连续性。

性能优化配置

针对高吞吐场景,需调整以下关键参数以提升同步效率: