π∗0.6——RL微调流式VLA π0.6:先基于演示数据做离线RL预训练,再在线RL后训练(与环境自主交互,从经验数据中学习,且必要时人工干预)

前言

今天上午,一朋友在我组建的「七月具身:π0和π0.5复现微调群」群内说:pi0.6发布了,我当时还表示PI公司牛啊

另一朋友说:“感觉现在都转向强化学习了呀”,其实

- 一方面,远的,早在ChatGPT于22年年底火爆全球后,便通过RLHF这一范式向所有人证明了,RL是一条相当于有前途、潜力的方向,是康庄大道

——

更不用说,今年年初deepseek R1-zero,直接摒弃掉ChatGPT三阶段训练范式(SFT-RM-PPO)中最开始的SFT,直接RL训练(规则奖励建模 然后没有critic的GRPO迭代)

此举,首次公开研究验证LLM的推理能力,可以纯粹通过RL激励,而无需SFT - 二方面,如此文《πRL——首个在线RL微调流式VLA π0/π0.5的框架:通过Flow-Noise和Flow-SDE实现精确对数似然估计,全面提升性能》开头所说的

今年8月底,我便预言道:vla + RL的结合,基本是趋势了,再加之「hil-serl」这类框架的成功

加速了vla + RL的结合

——

我顺带吐槽下,某些新闻稿说,“过去一年,所有人都在唱衰VLA”,我一看就很无语,某小部分业余人的观点怎么能代表所有人呢

再顺带

- 如果你对RL还不熟,则可看看此文《强化学习极简入门:通俗理解MDP、DP MC TD和Q学习、策略梯度、PPO》,在万千资料中 该文会让你眼前一亮的

- 此外,我在解读过程中补充了大量的解释说明、技术细节,如果你只是想大概了解一下背后相关的技术,那不一定非得抠细节

如果你想抠细节,则可能需要你耐着性子 慢慢看,避免图快

第一部分 π∗0.6:能够从经验中学习的 VLA

1.1 引言、相关工作、预备知识

1.1.1 引言

如π∗0.6原论文所说,尽管人类在习得新技能方面极具适应性,但要达到精通,往往需要通过反复尝试中不断学习。对于VLA而言,可以通过提示灵活地为通用机器人指定任务。但正如人类一样,这些模型需要通过练习技能来实现精通,这不仅需

- 依靠演示数据,演示数据类似离线数据下的示范

- 还需要模型自主收集的经验数据

自主经验数据 类似真机与真实环境交互所产生的数据

从而让策略能够纠正在实际部署中犯下的错误,并在速度与鲁棒性上超越人类远程操作水平,同时能够适应新的部署环境

自主练习学习的基础,如通过RL[1-Reinforcementlearning: An introduction]形式化,已被人们认知数十年,但要在通用且可扩展的机器人学习系统中实现这些原则仍面临重大挑战:

- 如何为大规模模型设计可扩展且稳定的强化学习方法

- 如何处理来自不同策略的异构数据

- 以及如何在真实环境中搭建基于奖励反馈的强化学习训练体系

而在现实中,奖励信号可能是模糊或随机的

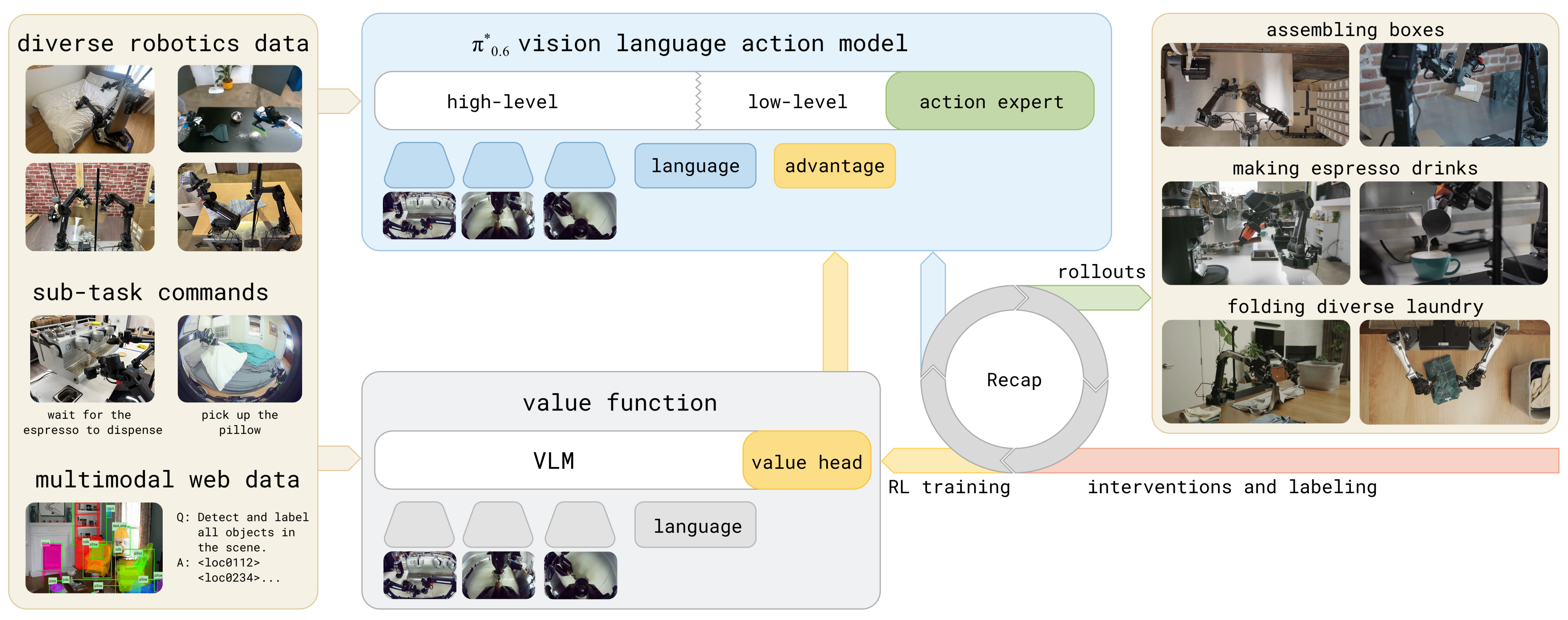

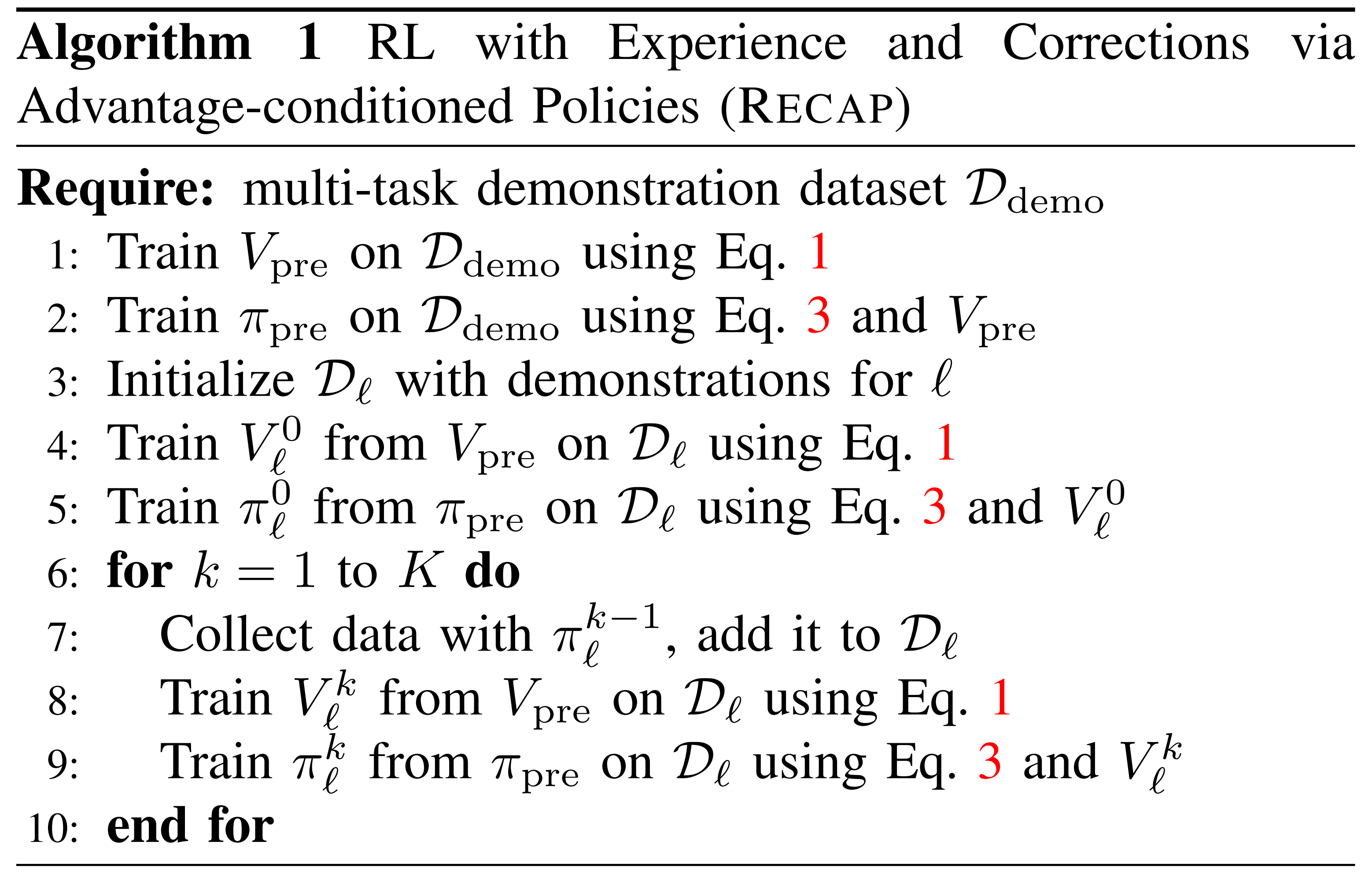

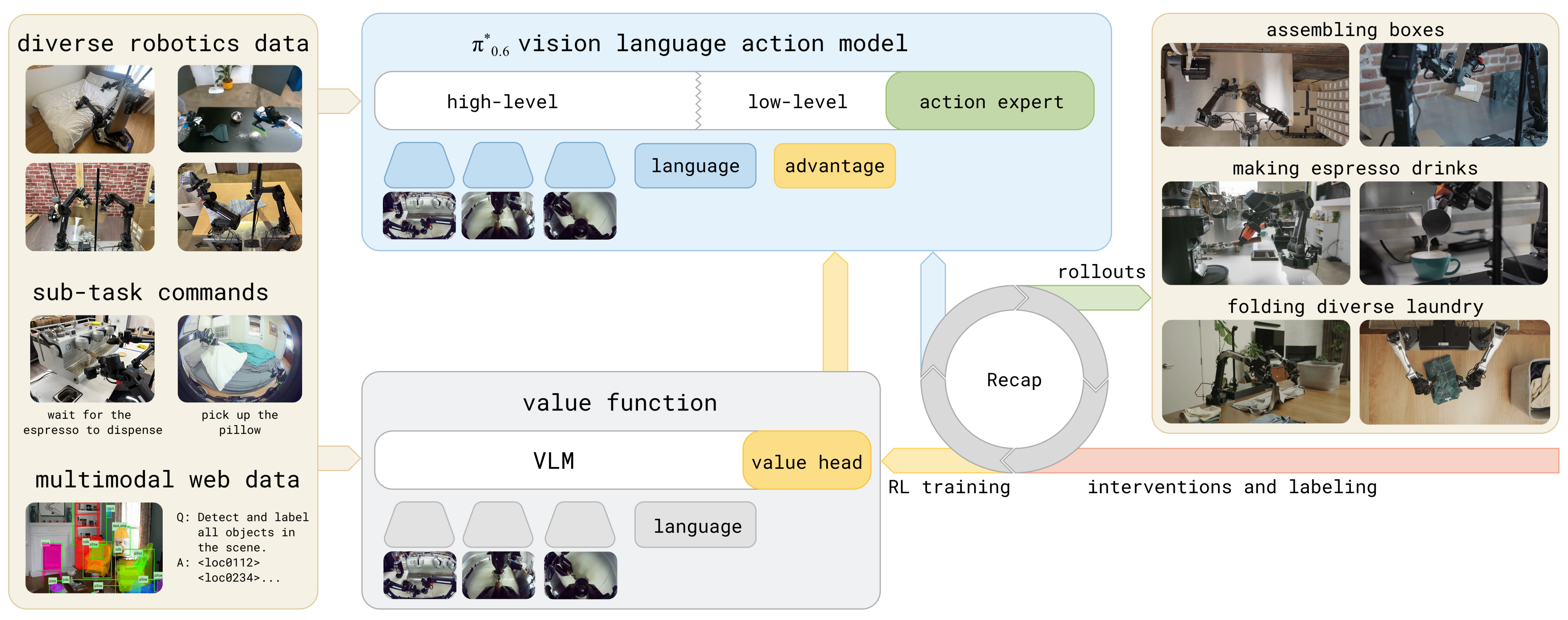

对此,PI公司提出了 RECAP(RL with Experience and Corrections via Advantage-conditioned Policies),这是一种能够使VLA 模型在整个训练流程的各个阶段——从预训练一直到基于自主执行数据的(后)训练——都能够融入奖励反馈的方法

RECAP 旨在通过一种通用的方案来解决该问题,该方案结合了示范、自主经验和专家干预

- 其从通用的训练方案出发,为了实现通用的VLA并在来自多种机器人平台的多样化数据上进行训练,即RECAP首先利用离线强化学习对VLA进行预训练

- 随后在部署过程中采集的数据上进行补充训练(即后训练),在这些部署期间,机器人会根据每次试验的结果获得(稀疏的)奖励反馈,并且可能获得额外的专家干预以纠正错误

具体而言

- RECAP的训练过程遵循离线强化学习[2,3-Offline reinforcement learning: Tutorial, review,and perspectives on open problems]的范式:

第一步,作者训练一个价值函数,用于评估任务成功完成的进展

第二步,利用该价值函数估算数据集中每个动作的优势,即通过根据该优势[4-Diffusion guidance is a controllable policyimprovement operator]作为改进指标对策略进行条件化,且可以获得经过提升的策略

- RECAP预训练好了之后,便可以使用RECAP 来训练用于复杂任务的策略,例如折叠各种洗衣物、组装盒子或制作浓缩咖啡饮品

————

这些新数据会不断加入任务数据池,随后 Recap 会对全部数据重新训练价值函数,价值函数越训练越强,对“成功距离”的判断也越准确

更新后的价值函数再计算所有动作的 advantage(优势),并作为额外输入反哺给策略模型,使 π*0.6 能够从好动作中学习、从坏动作中避开,策略自然越来越强

下图图1展示了RECAP的高层次流程概览

RECAP使得利用奖励反馈和人工干预训练VLA成为可能。该系统以一个已经集成优势条件的预训练VLA作为起点(相当于离线RL),使模型能够有效地从真实世界经验中学习。针对每项任务,部署模型,并收集自主执行轨迹和在线人工纠正

随后,在这些在线数据上微调价值函数,从而提升其对动作如何影响性能的评估准确性。对VLA进行微调并基于更新后的优势估计进行条件化,进一步优化策略行为

说白了,RECAP的训练「含预训练和后训练」是可以循环迭代的

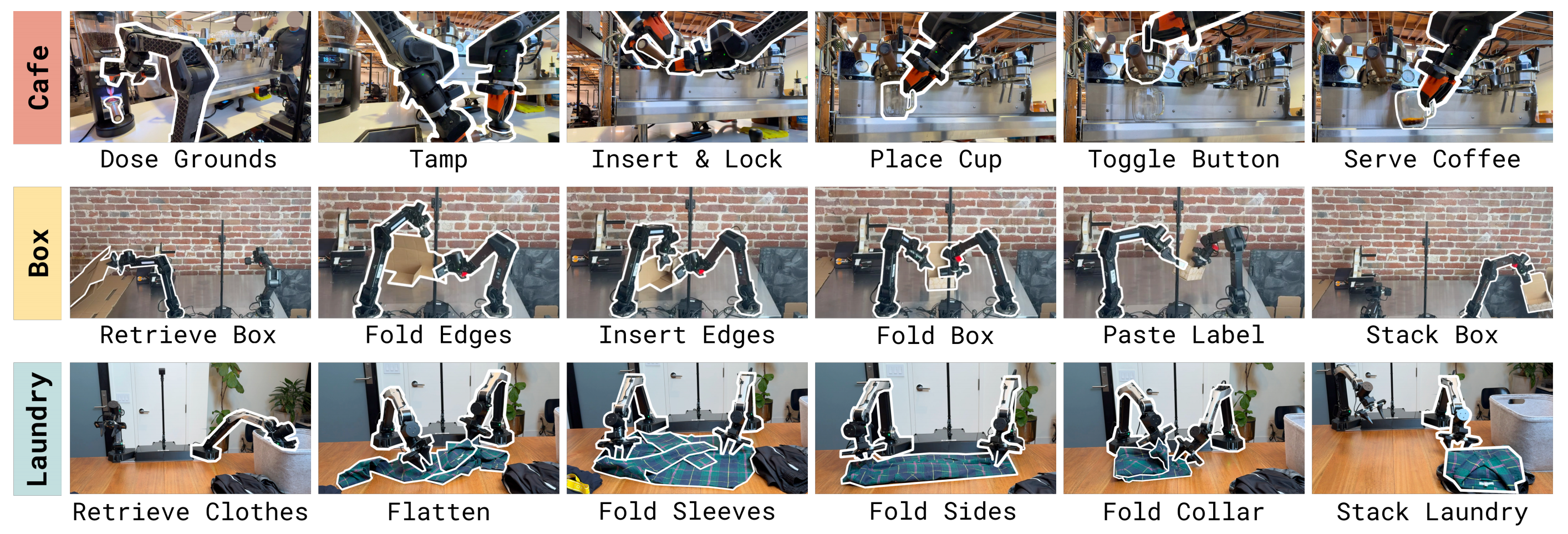

比如作者在图2 中展示了其中一些任务「π∗0.6 trained with RECAP can make espresso drinks, assemble cardboard boxes, and fold diverse and realisticlaundry with a high success rate」

- 第一阶段,首先通过离线RL,在多任务和多机器人多样化数据集上对π∗0.6 模型进行预训练

——

π∗0.6 是π0.6 模型针对RL 的一个适应版本,而π0.6是在π0.5 [5] 基础上的改进,增加了更大的主干网络和更丰富的条件多样性[6]

π∗0.6 增加了对二值化优势值进行条件输入的能力(即集成优势函数),这使得可以引入价值函数来提升策略表现 - 第二阶段,在预训练之后,π∗0.6 通过“演示数据”对π∗0.6 模型进行下游任务微调,然后进行一次或多次机器人上的数据采集,通过RL 进一步提升模型性能

After pre-training π∗0.6 finetunes the π∗0.6 model to a down stream task with demonstrations, and then performs one or more iterationsof on-robot data collection to improve the model with RL. - 第三阶段,再之后,将π∗0.6 和RECAP 一起在自主经验上训练(并结合专家纠错,循环迭代),可以使某些最难任务的处理吞吐量提升一倍以上,并使失败率降低2× 或更多

最终,可使得π∗0.6 能够达到实际有用的鲁棒性水平:比如能够让其连续制作咖啡饮品达13 小时,在新家庭环境下连续折叠新型衣物超过两小时而不中断,并组装用于工厂实际包装的盒子

1.1.2 相关工作

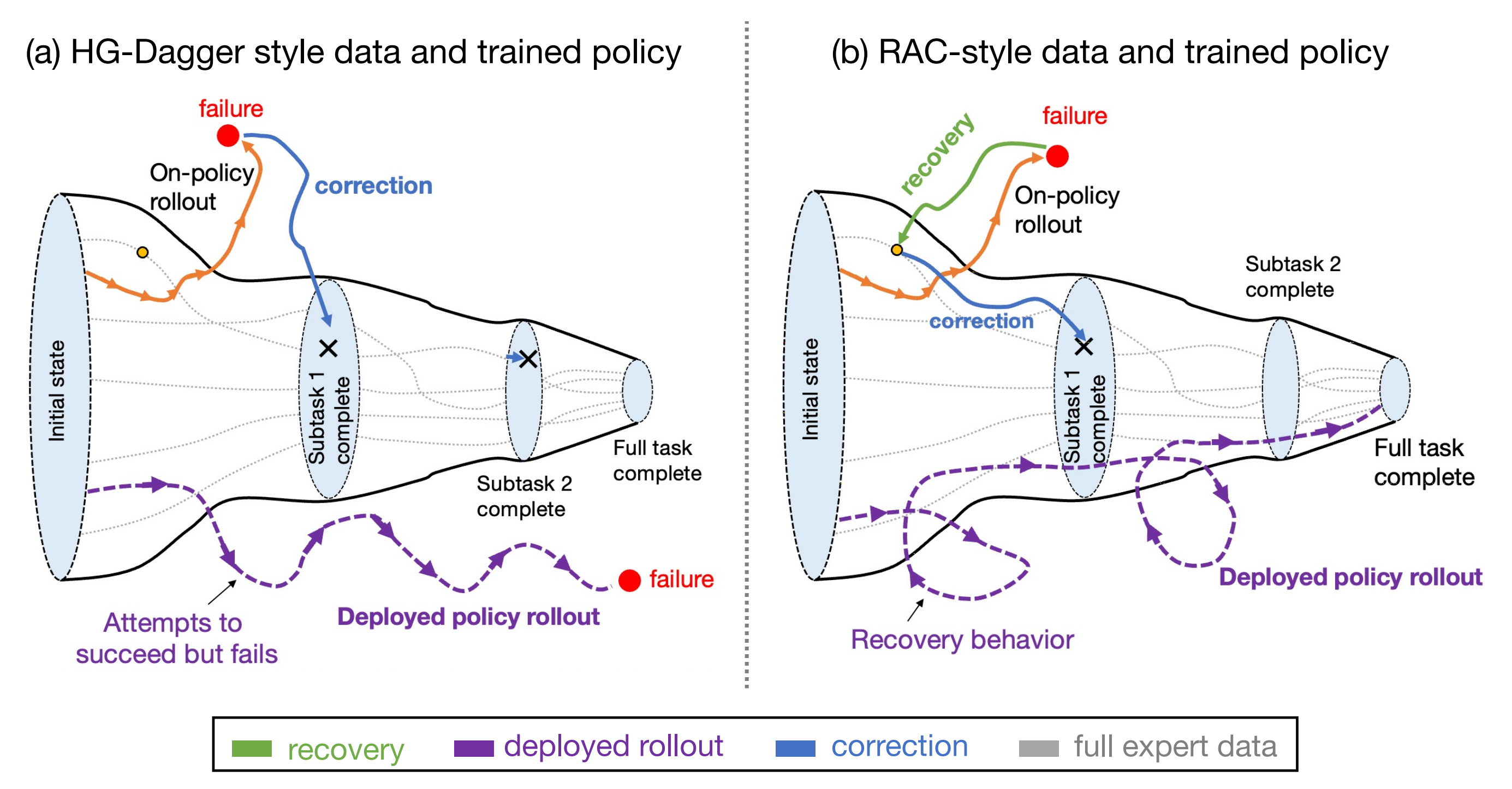

首先,基于模仿学习训练的策略已知容易产生累积性错误[7],并且其性能最多只能与演示数据持平

说白了,VLA控制机器人时,它会像任何模型一样犯一些小错误——例如,抓取器位置错误、抓取失败或碰倒物体。由于机器人是在与真实的物理环境交互,这些错误会导致与训练数据中的情况略有不同,机器人更有可能犯下更大的错误,从而导致误差累积。小错误可以修复,但累积误差会导致失败

亦如此文《一文通透ACT——斯坦福ALOHA团队推出的动作分块算法:基于CVAE一次生成K个动作且做时间集成》所说的

1.1.2 行为克隆(Behavioral cloning, BC)中为何要引入ACT

- 模仿学习使机器人能够直接从专家处学习。行为克隆(Behavioral cloning, BC)是最简单的模仿学习算法之一,将模仿学习视为从观测到动作的监督学习问题

行为克隆(BC)的一个主要缺陷是累积误差,即前一个时间步的错误会逐步积累,导致机器人偏离其训练分布,从而进入难以恢复的状态 [47,64]- 这一问题在精细操作场景中尤为突出 [29]。缓解累积误差的一种方法是允许额外的基于策略的交互和专家纠正,例如DAgger [47] 及其变体 [30,40,24]

..

本文的目标是通过超越离线演示的模仿学习,提升视觉-语言-动作策略的可靠性与速度

- 已有的相关研究通过在线干预提升了机器人操作策略的性能[8–11]

对于文献11,参见此文《RaC——挂衬衫且打包外卖盒:如果机器人将失败,则人类让其先回退后纠正,以减缓IL中的误差累积(让数据的增长对任务促进的效率更高)》

——

而作者采用了一种被称为“人类门控DAgger”的干预方法[10,12]

与这些方法不同,π∗0.6结合了专家干预和完全自主的经验,构建了一个融合多种数据来源的基于强化学习的框架 - 已有大量研究针对利用强化学习自主改进机器人操作策略[13–21]

对于文献19,详见此文《SERL——针对真机高效采样的RL系统:基于图像观测和RLPD算法等,开启少量演示下的RL精密插拔之路(含插入基准FMB的详解)》

包括基于扩散的策略方法[22–24,其中文献23是Diffusion Policy Policy Optimization]、多任务场景下的方法[25,26],以及使用预训练多任务策略的方法[27–29]

与上述工作不同,作者关注如何将真实世界中的强化学习扩展到大规模视觉-语言-动作策略,用于处理长期且细粒度的操作任务

其次,近期有许多研究致力于通过强化学习(RL)提升基础视觉语言动作(VLA)模型的性能

- 其中,一些工作直接将近端策略优化(PPO)算法及其变体应用于VLA微调『30–34,其中文献31是vla-rl,文献33是πRL,详见此文《πRL——首个在线RL微调流式VLA π0/π0.5的框架:通过Flow-Noise和Flow-SDE实现精确对数似然估计,全面提升性能》』

但这些方法难以高效且可扩展地应用到真实世界的强化学习场景 - 另一类研究则着眼于在预训练VLA模型基础上进行强化学习微调,这包括

通过强化学习训练残差策略

35-Improvingvision-language-action model with online reinforcement learning

36-Self-improving vision-language-action models with data gen-eration via residual rl

微调动作头网络

[37-Conrft: A reinforcedfine-tuning method for vla models via consistency policy]

选择或优化VLA提出的动作[38–40],或优化作用于基于扩散的VLA噪声空间中的策略[41]

————

此外,一些研究还探索了如何将学习到的行为蒸馏回VLA模型,实现端到端的迭代改进[35,36,38,42]

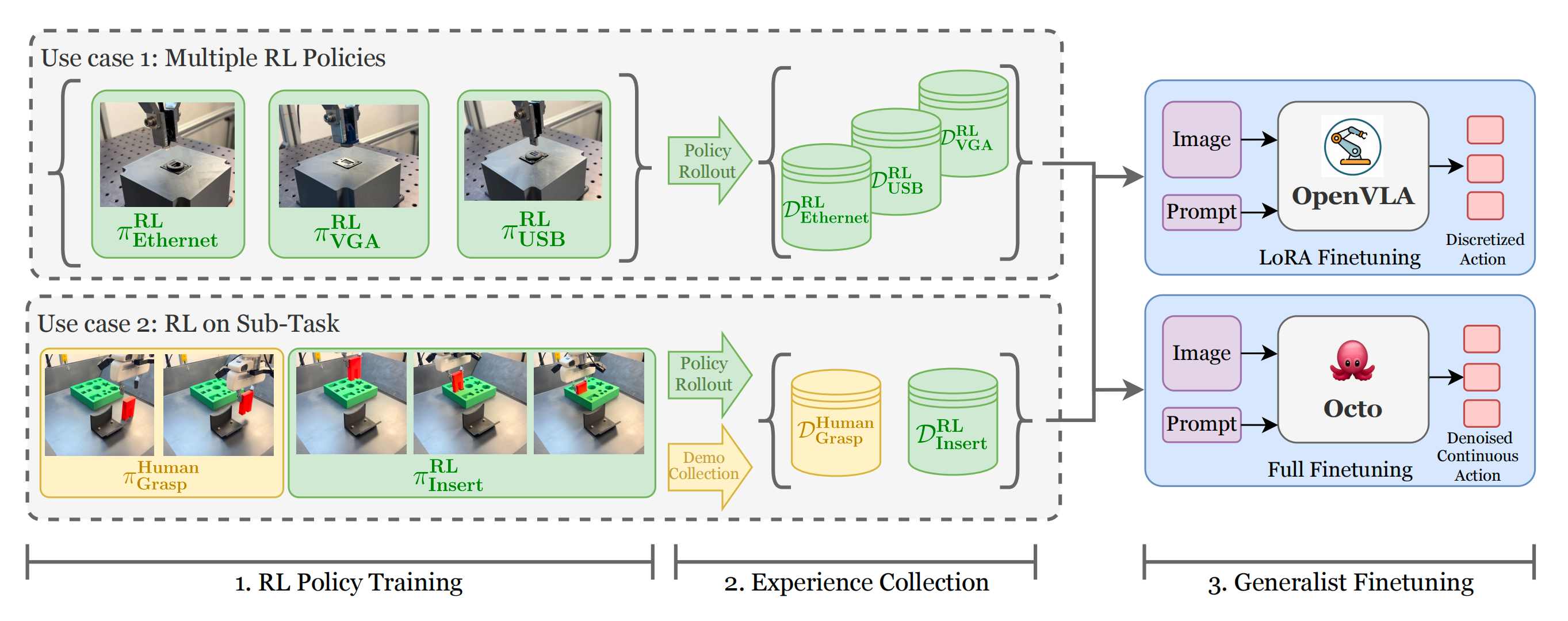

关于文献42-Rldg: Robotic generalist policy distillation via reinforce-ment learning,参见此文《知识蒸馏RLDG:先基于精密任务训练RL策略(HIL-SERL),得到的RL数据去微调OpenVLA,最终效果超越人类演示数据》

以往的相关工作通常采用离散动作或简单的高斯连续动作分布。一个关键区别在于,作者通过(迭代)离线强化学习,用表达能力极强的流匹配VLA模型对整个VLA进行端到端训练

这得益于一种简单且可扩展的优势条件策略提取方法,该方法大幅简化了在大规模VLA模型中使用策略梯度类目标的复杂性。在作者的对比实验中,该方法显著优于传统的基于策略梯度的提取方案

在方法论上,与RECAP更为接近的是,一些先前的研究已经在真实机器人上集成了价值函数与端到端的VLA强化学习训练 [43–46]

- 例如,Huang等人[43]将校准的Q-学习应用于离线抓取任务示范数据集,但没有进行在线优化阶段

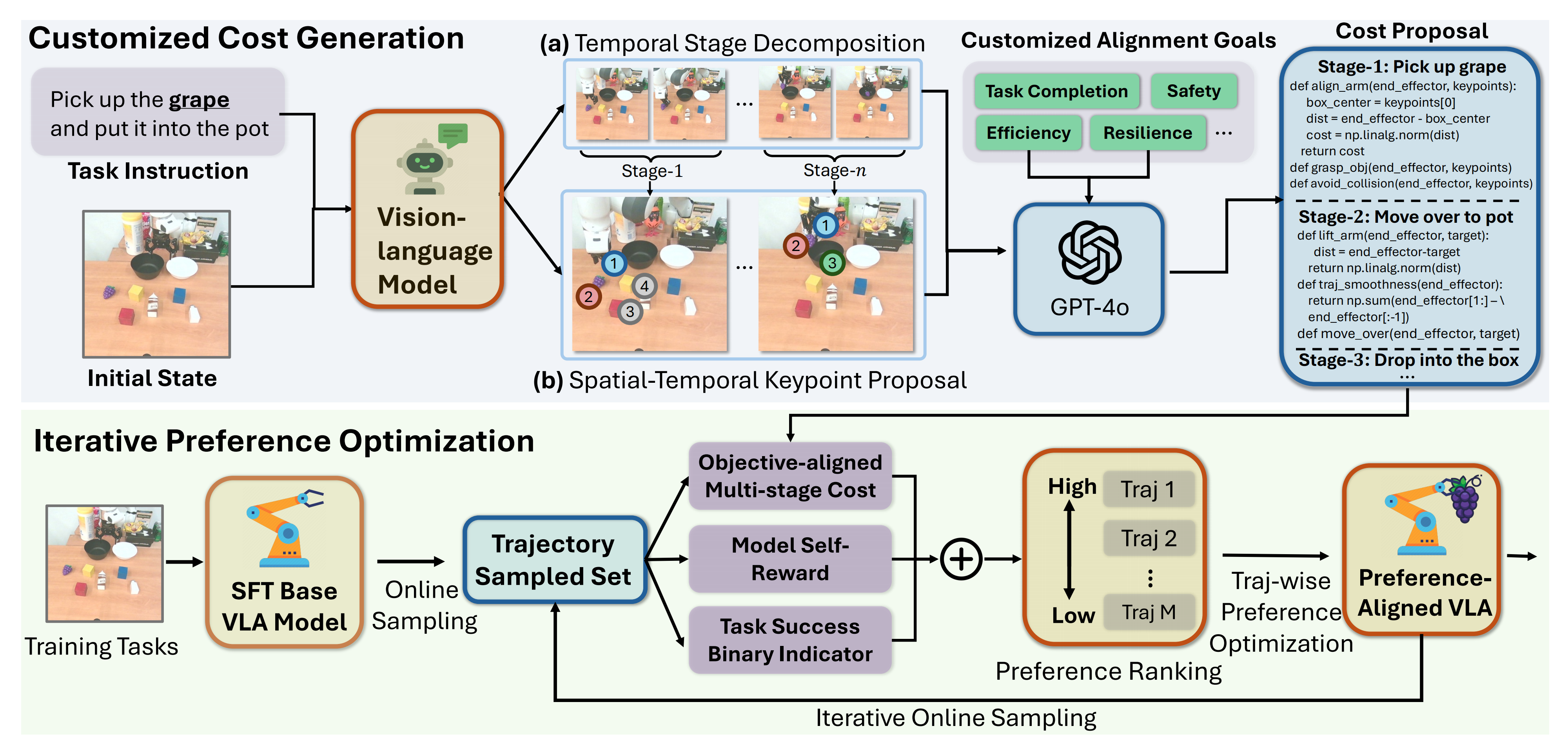

- Zhang等人[44-GRAPE]采用直接偏好优化(DPO)方法,根据人类偏好,从VLA在线轨迹中优化抓取与放置技能

- 最后,Zhai等人[45]和Ghasemipour等人[46]分别利用PPO和REINFORCE算法,通过任务完成时间价值函数训练VLA,应用于如移动碗、展开垫子和推动桌面物体等任务

与这些前人工作相比,作者提出了一种迭代式的VLA离线强化学习框架,具有多项优势

- 首先,π∗0.6支持高容量的扩散模型和流式VLA,与先前工作主要关注的离散动作模型不同

- 其次,π∗0.6通过引入优势条件策略提取方法,避免了对策略依赖型PPO或REINFORCE的需求,从而能够利用所有历史(无论是离策略还是离线)数据

- 最后,π∗0.6的评估场景涵盖了复杂的、灵巧的、时间跨度较长的任务,在处理可变形物体、液体以及多阶段任务时,吞吐量提高了约2倍

总之,以往的研究已经探索了基于奖励、价值和优势对策略进行条件化的思想 [47–56,其中55是Advantage-conditioned diffusion: Offline rl via general-ization],其中包括采用无分类器引导方法的研究 [4]。作者将这一方法扩展应用于大规模通用 VLA 策略的预训练和微调 [5],并结合多种数据源(包括演示、干预以及自主策略演化)来学习真实的机器人操作任务

近期还有研究关注于如何高效训练多任务与语言条件化的奖励函数 [57–63] 和价值函数 [45,64,65]。在这些工作的基础上,作者还训练了一个基于语言条件的分布式价值函数,从而能够为他们的优势条件化VLA 训练框架估算状态-动作优势

1.1.3 预备知识

首先,对于强化学习

考虑标准的RL 设置,其中智能体由策略给出,根据观测

选择动作

。作者将轨迹定义为

轨迹分布由策略

和随机动力学

产生「可以假设观测

构成一个有效的马尔可夫状态」:

- 奖励函数被定义为

,作者将其简写为

以简化符号,其中

为终止奖励,可以将累积回报(或收益)定义为

PS,这里作者没有使用折扣因子,当然也可以容易地添加 - 强化学习的目标是最大化累积回报(或收益),通过学习一个最大化

的策略

策略π 的价值函数被定义为 - 随后可以计算某一动作

的优势值,即

这对应于一个n 步估计

其次,对于正则化强化学习

与最大化不同,在强化学习中通常会使用正则化,优化一项既最大化奖励又保持与某个参考策略

接近的策略[66-70]

具体而言,当希望在同一批数据上进行多步梯度训练时,此时 通常对应于收集训练数据时的行为策略(比如在下文涉及到RL在线后训练时,便会通过

与环境交互,先收集一批经验数据)

PS,这个其实本质就是PPO,策略迭代时,尽可能不要脱离参考策略

(我个人经常会用初心一词 来做比喻)太远

- 对于PPO的介绍,详见本文开头前言中提到的此文《强化学习极简入门:通俗理解MDP、DP MC TD和Q学习、策略梯度、PPO》的4.4节

- 对于通过旧策略与环境交互 而采集经验数据的完整流程,则可以参见下面这两篇文章

ChatGPT技术原理解析

从零实现带RLHF的类ChatGPT:逐行解析微软DeepSpeed Chat的源码

这个可以通过如下目标函数形式化:

其中表示某种散度度量

- 当

为KL 散度时,有著名的结果:

是

的解,其拉格朗日乘子为

[67-70]

- 该优势条件下的策略提取方法基于一个密切相关但不那么知名的结果:如果定义策略

————

其中表示某动作

在某单调递增函数

下相较于

有提升的概率

那么保证会优于

,即

[4, 71]

将在下文(对应于原文的第四节B 部分)中利用该性质推导该策略提取方法。利用上述定义,随后可以通过求解如下最小化问题,从 的闭式定义中获得参数化策略:

上述目标函数,类似instructGPT原始论文中的目标函数『详见此文《ChatGPT技术原理解析》的「3.1.3 InstructGPT训练阶段3:如何通过PPO算法进一步优化模型的策略』

上面的

便等同于

,可以再展开如下

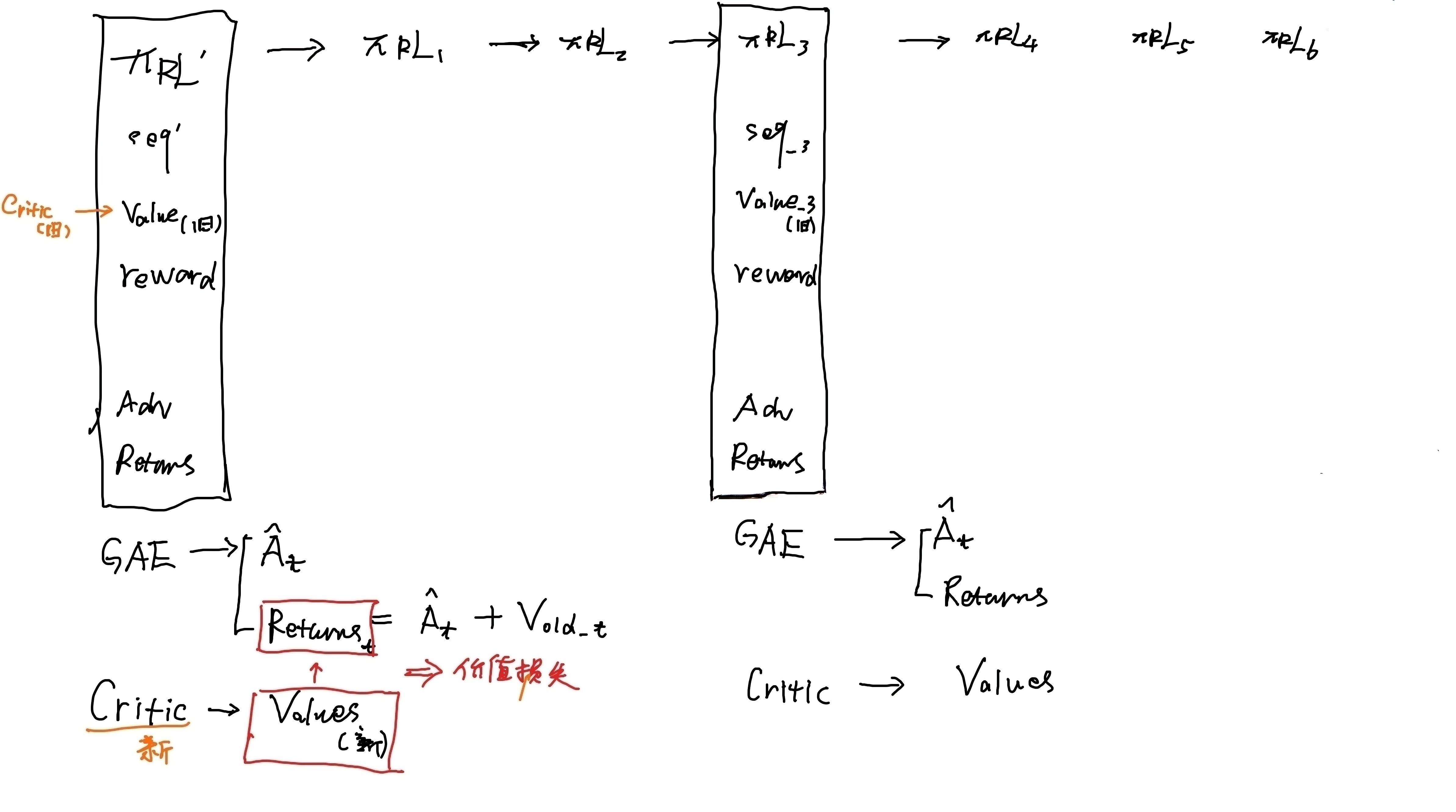

1.2 RECAP的训练三阶段:数据收集、价值函数训练、优势条件训练

RECAP本质是基于优势条件策略的RL with experience及修正的VLA方法,其训练(不论是预训练,还是后训练)包括以下步骤,这些步骤可以重复一次或多次,以改进基础的 VLA 模型:

- 数据收集:演示数据做预训练,自主和人工纠错数据做后训练

在该任务上运行VLA,为每个episode 标注任务结果标签(这些标签决定奖励),并根据需要提供人工干预,用于为早期迭代中的错误提供修正示例

注意,相当于对于预训练来说,数据仅仅是演示数据

但对于后训练来说,数据收集分为两种,一种是自主运行,一种是人工干预

怎么个人工干预法呢,其实类似HIL-SERL,研究人员让机器人先上岗工作,当它在自主执行任务时犯了错(比如抓歪了、卡住了),人类专家会立即接管机器人,通过远程操作来纠正这个错误,并展示如何从这个错误中恢复过来

一举避免误差累积!

- 价值函数训练:给每个状态打分

使用到目前为止收集的所有数据来训练一个大型的、多任务的价值函数,称之为,该函数可以检测失败,并判断任务完成的预期时间

——

更深入讲,价值函数不是评断该动作做的错还是对,毕竟有时一个任务最终能否成功,光看前几步 不一定看得出来,可能到了第6步才失败,但导致失败的不一定是第6步,而是前几步没有做好 但偏偏前几步还没到最后成功与否的临界点

再比如,机械臂弄咖啡时,如果机器人以错误的方式拿起意式浓缩咖啡机的滤篮,它可能会难以将其插入。可失败的根源并非在于最后的插入环节,而是在最初的抓取动作 不对

故,正确的信用分配方法(credit assignment method)应当将抓取动作认定为失误,即便失败是在那之后 才显现出来的

所以,那到底怎么判定某一步动作到底好不好呢,那就放长远,即当前距离成功还有多远 - 优势条件训练:各个前后动作分数的差值,这个差值就是优势分数,在RL中,当然追求优势值为正了

为了利用该价值函数改进VLA 策略,作者引入了一个基于从该价值函数中导出的优势值的最优性指示器

we include an optimality indicator based on advantage values derived from this value function in the VLA prefix.

总之,该“优势条件”方法提供了一种简单且有效的方式,用于利用次优数据从价值函数中提取更优的策略

this “advantage conditioned” recipe provides a simple and effective wayto extract a more optimal policy from our value functionwith suboptimal data

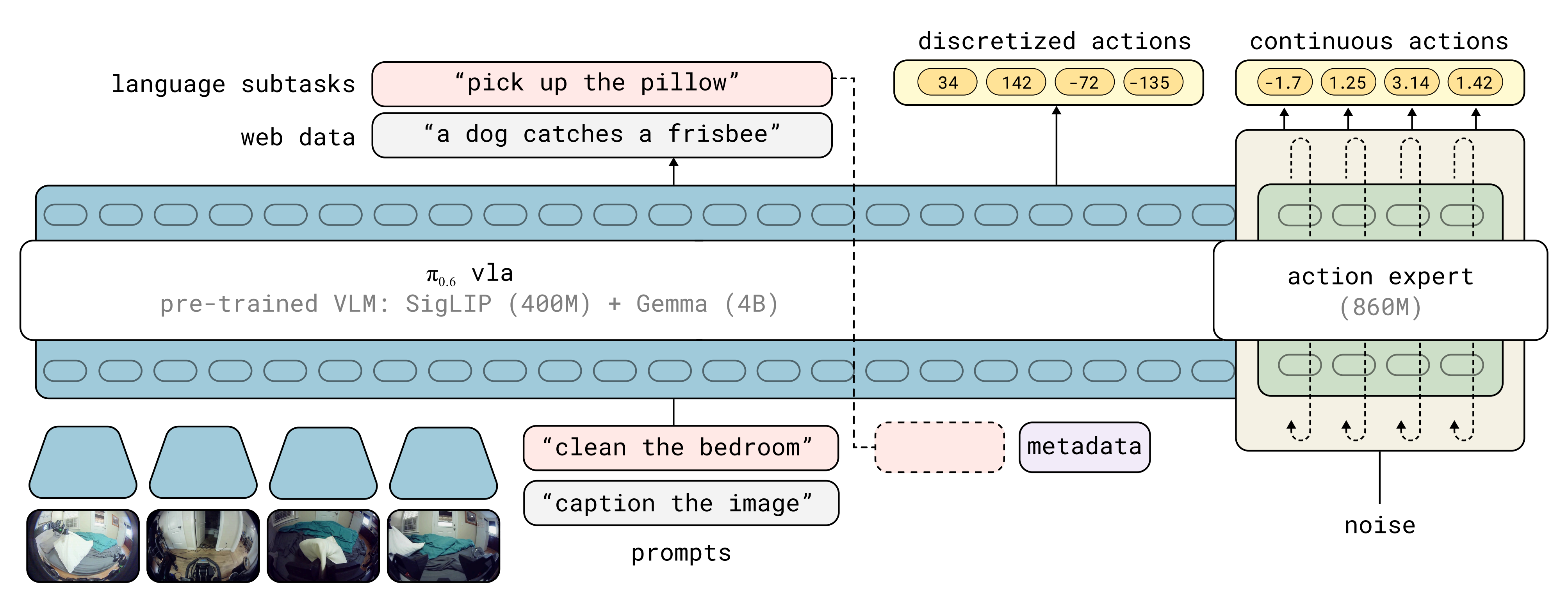

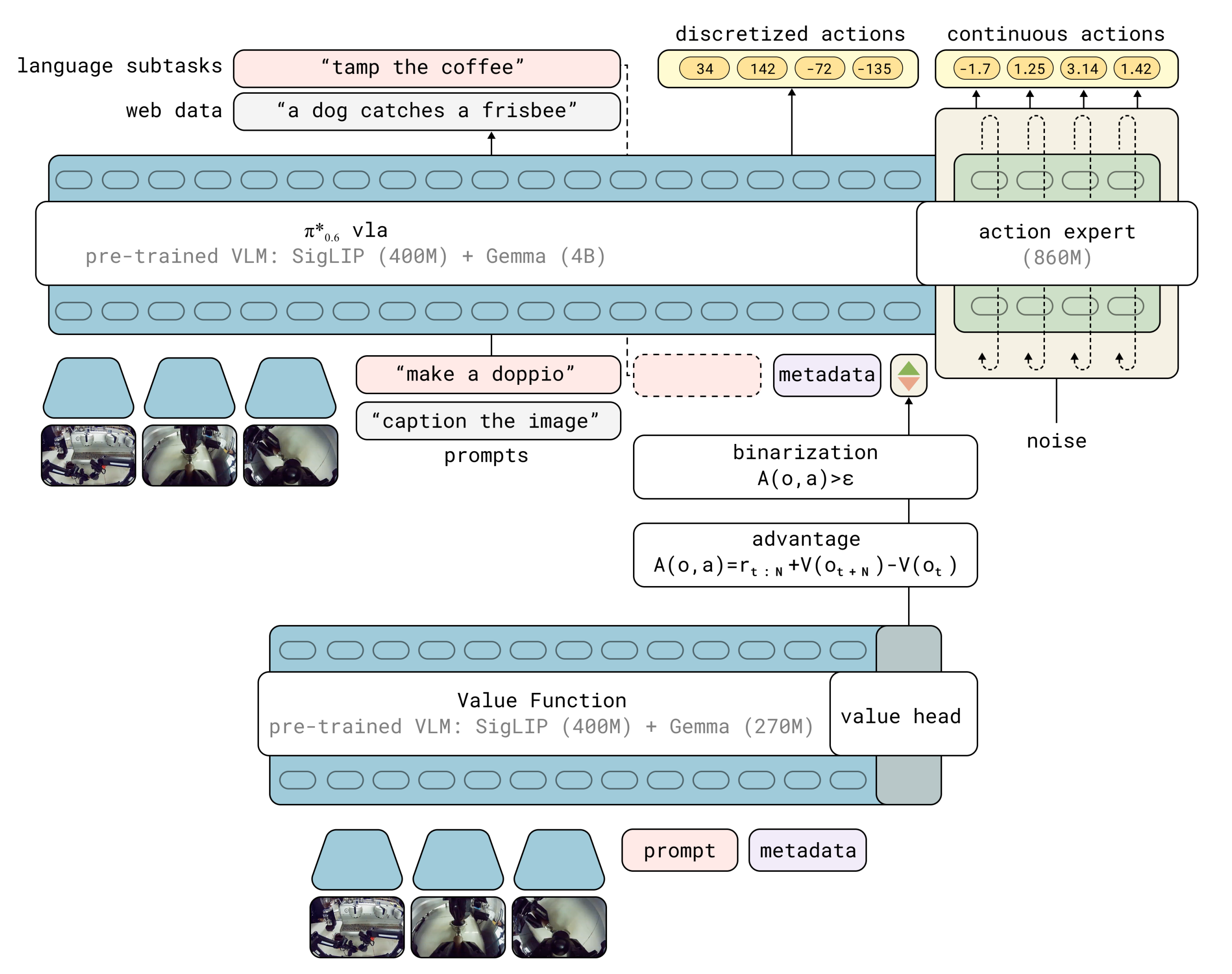

图1 展示了训练过程的整体结构,而图3 则更详细地说明了价值函数和策略结构的具体细节

- 在 RECAP 训练期间,π∗0.6 VLA 与价值函数之间的交互

- π∗0.6 VLA 使用预训练的视觉语言模型(VLM)骨干网络,该VLA的训练遵循 KI 配方『73-Knowledge insulating vision-language-action models:

Train fast, run fast, generalize better,详见此文《π0.5的KI改进版(已部分开源)——知识隔离:让VLM在不受动作专家负反馈的同时,输出离散动作token,并根据反馈做微调,而非冻结VLM》』在预训练阶段对多个数据源进行下一个token,并使用具有停止梯度的流匹配动作专家

且VLA 以从单独的价值函数获得的二值化优势指标为条件,该价值函数由预训练但规模较小的 VLM 模型初始化

The VLA is conditioned on a binarized advantage indicator, obtained from a separate value function initialized from a pre-trained but smaller VLM model

总之

- 预训练阶段包括在整个预训练数据集上执行上述第(2-价值函数训练) 和第(3-优势条件训练) 步,该数据集包含来自众多任务和多种不同机器人的数万小时演示

Our pre-training phase consists of performing steps (2) and (3) above on our entirepre-training dataset, which consists of tens of thousands ofhours of demonstrations from numerous tasks and a variety ofdifferent robots - 随后,执行第(1)、(2) 和(3) 步一次或多次,以利用自主收集的数据进一步改进VLA

Then, we perform steps (1), (2), and (3) oneor more times to further improve the VLA with autonomously collected data.

————

最后,再强调一点,RECAP这套流程(训练三阶段),是可以反复执行的

接下来,将在下文描述价值函数训练和策略训练步骤,然后再(对应于原论文第五节)介绍训练π∗0.6 的具体实现方法

1.2.1 分布式价值函数训练:给 “任务进度” 精准打分

为解决信用分配难题,作者设计了分布式价值函数,核心作用是实时评估当前状态的 “任务完成潜力”

而为了训练一个能够在预训练或后训练阶段作为任何任务的可靠评论者的价值函数「To train a value function that can act as a reliable criticfor any task in our pre-training or post-training stages」

- 首先,对于输入

作者用多任务分布式价值函数来表示

,将观测

和语言指令

映射为B 个离散价值区间上的分布

在作者的实现中,该价值函数使用与VLA 策略相同的架构,但使用了更小的VLM 主干网络

- 其次,对于输出

用表示从时间步

到末尾轨迹

的经验回报

作者通过先将经验回报值离散化为

个区间——用

表示离散化后的回报

- 最后,对于训练方式

则是对当前数据集中的轨迹最小化交叉熵

,来训练

,即(定义为公式1)

这是一个用于数据集(即行为策略

)所代表策略的价值函数的蒙特卡洛估计器

最终可以通过所学习的价值分布,利用提取一个连续的价值函数(从而获得优势),其中

表示与区间

对应的价值

- 在预训练阶段,数据集

对应于人类演示,价值函数捕捉了作者所设定任务和元数据的期望回报

During the pre-training phase,the dataset D corresponds to the human demonstrations, and the value function captures the expected return for the taskand metadata we condition on - 而在后续迭代中,它则倾向于演示(离线)回报和所学习策略(在线)回报的加权组合

while on subsequent iterations,it skews toward a weighted combination of the return of the demonstrations and the learned policy.

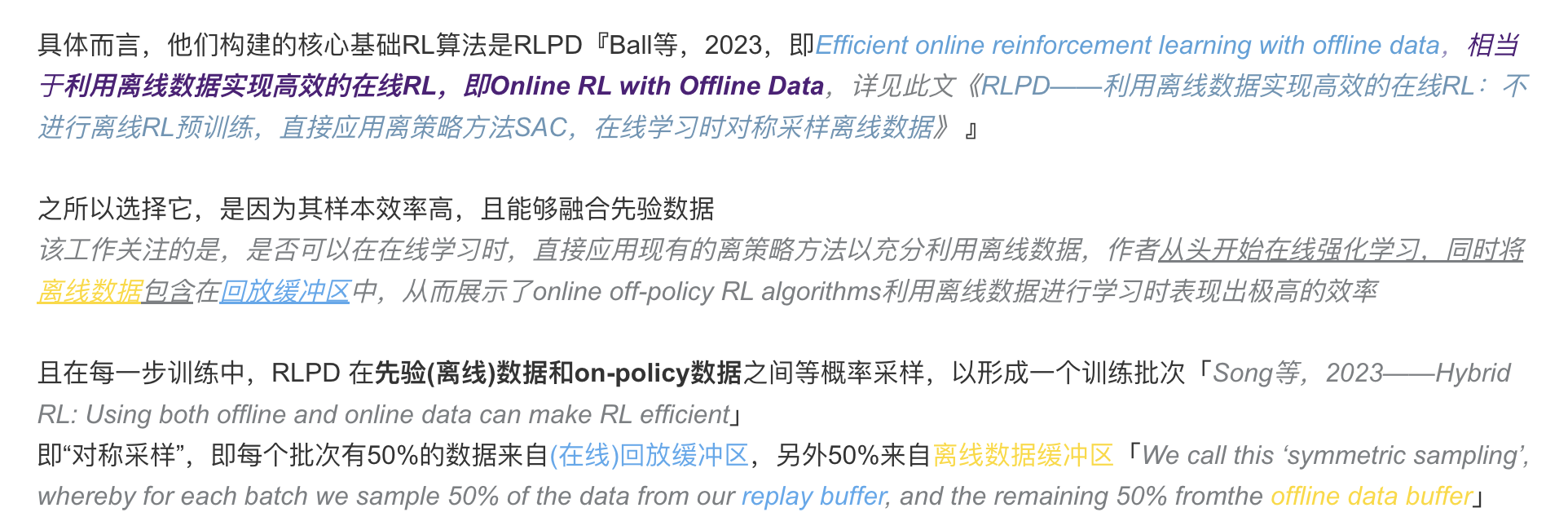

类似RLPD中,一半采样于离线数据,一半采样于在线数据,如下图所示

虽然这种基于当前策略的估算方法不如更传统的离策略Q函数估算器最优,但作者发现其结构简单且高度可靠,同时仍能够在模仿学习的基础上实现显著提升

故该方法在未来工作中可以扩展以支持离策略估算器(off-policy estimators)

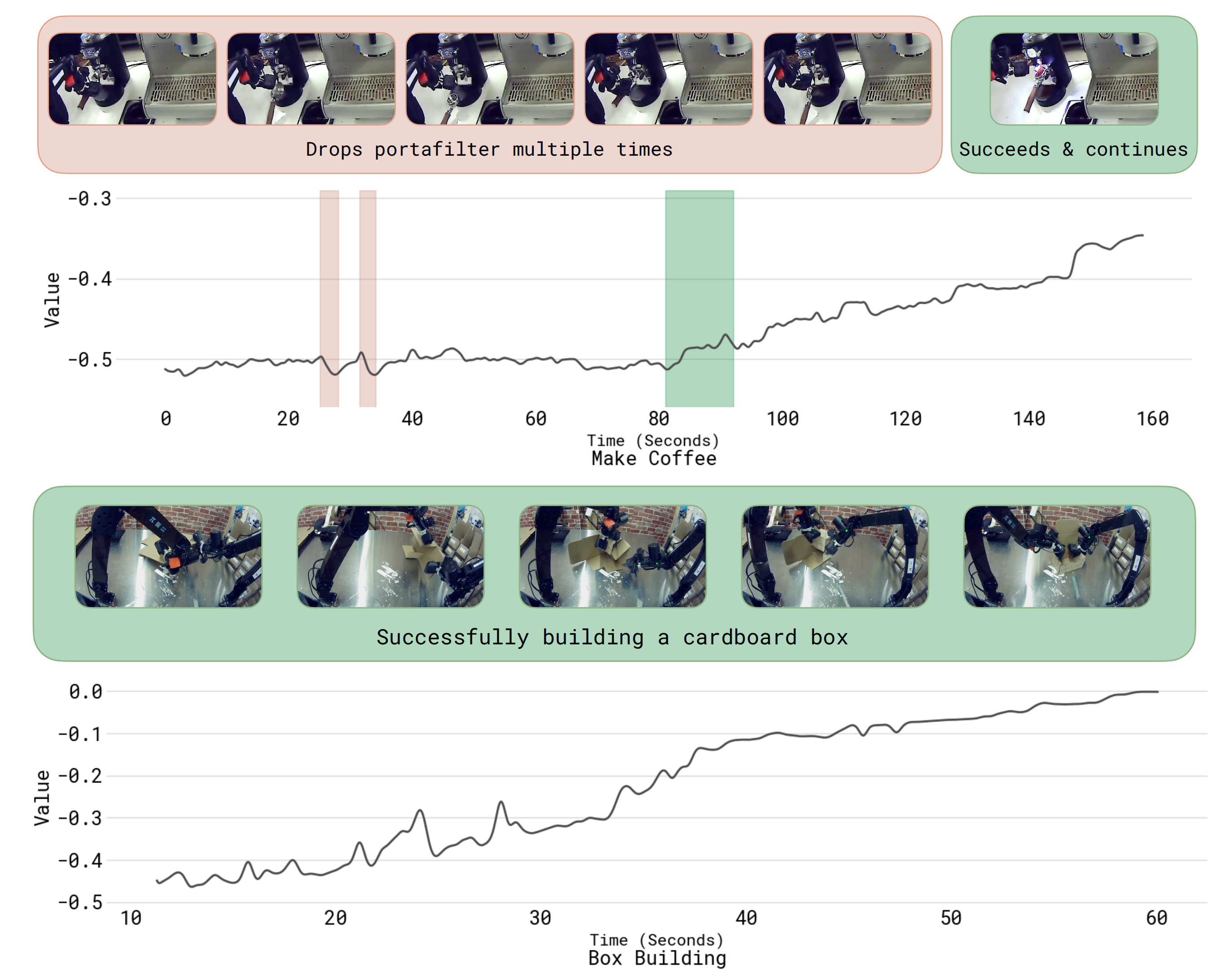

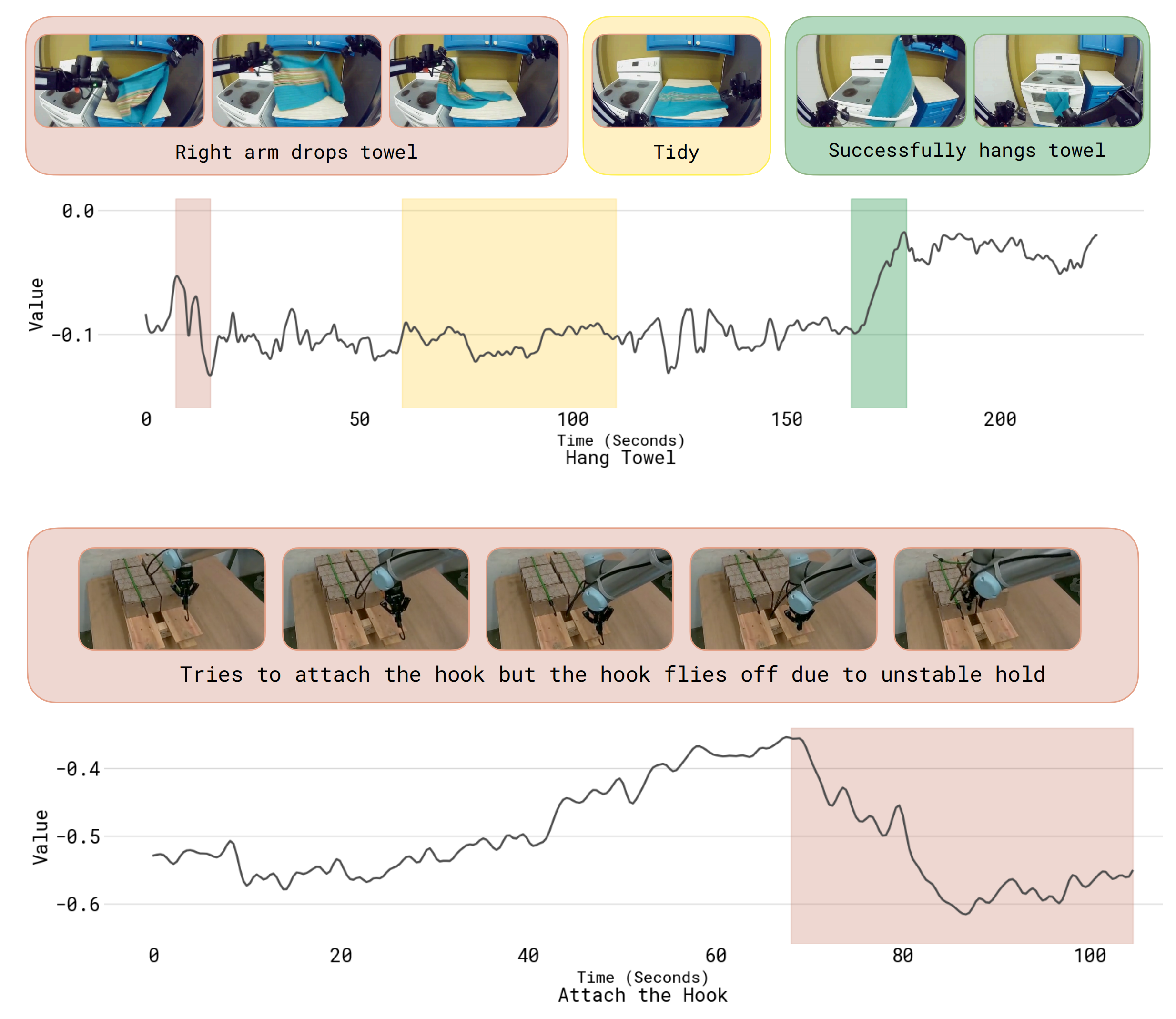

图13展示了作者训练得到的价值函数在五个不同任务上的额外可视化结果,包括他们

- 用来评估策略的任务(制作浓缩咖啡、装配盒子)

- 以及更广泛的任务(挂毛巾、安装挂钩)

其中价值函数变化最显著的部分已被高亮显示:

- 红色表示价值函数下降的位置

- 绿色表示价值函数上升的位置

- 黄色表示数值波动的位置

1.2.2 基于优势条件的策略提取:给每个状态打分,判定某个动作是接近目标还是偏离目标

一旦得到了价值函数,便需要一种方法利用该价值函数来训练一个改进的策略。这被称为策略提取。在作者的设定中,一个有效的策略提取方法需要满足若干标准

- 首先,它需要有效地利用多样的离策略数据,包括初始演示、专家干预,以及来自最新策略和旧策略的自主训练片段。这与离线强化学习方法所面临的挑战密切相关 [2,3]

- 其次,该方法还需要具备可扩展性,并且易于应用于大型的VLA模型,包括那些采用流匹配或扩散机制生成动作的模型

- 最后,它还必须能够有效利用优质(近最优)和劣质(次优)数据,这一点对于通过自主经验提升策略至关重要

即把所有数据(不管是好动作、差动作,还是专家纠正的动作)都拿来训练 VLA 模型,同时把 “这步是高优势(好)的动作”、“这步是低优势(差)的动作” 的标注,也给到模型做训练

训练完后,模型已经清楚 “哪些动作能帮它更快成功”,从而在实际执行时,优先选择 “高优势” 的动作 即可

在现有的策略提取方法中

- 策略梯度方法(包括正则化策略梯度和重参数梯度)或许是应用最广泛的[66-即PPO,74- Soft actor-critic: Off-policy maximum entropy deep reinforcement learning with a stochastic actor],但这些方法难以应用于 flow matching模型,因为这类模型无法直接给出可处理的对数似然,因此难以扩展到现代的 VLA 架构(详见原论文第VI节的对比)

————

我补充说明下,对于这点,可以参见此文《πRL——首个在线RL微调流式VLA π0/π0.5的框架:通过Flow-Noise和Flow-SDE实现精确对数似然估计,全面提升性能》 - 另一种替代方案是使用加权回归方法,如 AWR [68,75,76],这类方法隐式地对行为策略进行正则化,并采用简单的(重要性加权)监督学习目标

然而,这些方法会丢弃或显著降低大量数据的重要性,实际上实现了一种过滤式模仿技术

相较之下,作者采用了一种优势条件化advantage conditioning[48-Reward-conditioned policies] 变体,在该方法中,策略通过监督学习利用全部数据进行训练,但会额外输入一个指示动作基于优势有多最优的信号

这与文献中提出根据轨迹某个函数对策略进行条件化的多种方法密切相关 [47-Reinforcement learning upside down: Don’t predict rewards — just map them to actions,50-When does returnconditioned supervised learning work for offline reinforcement learning?]

事实上,该方法中的具体表达方式与CFGRL [4-Diffusion guidance is a controllable policy improvement operator] 最为相关

- 在1.1.3节所述的方法基础上,即引用如下

可以应用贝叶斯法则对策略的概率进行重写

即改进为- 将其应用到本文的设定中,并包括语言调节后,便可以获得上文1.1.3节(对应于原论文第三节)中描述的改进正则化策略

其中表示某动作

在某单调递增函数

下相较于

有提升的概率

的另一种封闭形式(定义为公式2)

至于,如果对于特殊情况,

为方便大家更好的理解,我再做下补充说明

首先,根据上文1.1.3节,有,且其中

——

但根据上面的第一点,可知该可以改进为

故把改进后的,代入至

,即可得到

如此,可以在不需要显式表示提升概率

的情况下 表示

——如果训练该策略使其能够同时表示

和

————

这一原理类似于无分类器引导(classifier-free guidance)中的方法,在该方法中,扩散模型被训练为能够在有无条件变量的情况下对数据建模[4]。且假设提升指示变量服从一个delta分布

带有任务相关的改进阈值

。该阈值使得能够控制最优性指标,并最大限度地减少在训练后寻找衰减因子

以收紧改进条件分布的需求

然后,策略目标对应于最小化以下负对数似然(定义为公式3,其中 为指示变量):

优势值来自上一节中的价值函数,

是一个权衡超参数

- 第一项

,是标准的行为克隆BC

- 第二项

是优势条件化项

当训练时,在训练时,如果某条数据的动作优势很高(大于阈值

),就把

设为 True

这意味着模型学会了:当时,便应该输出那些高优势的动作

实际上,数据集

包含了迄今为止收集到的所有数据,包括所有演示和自主任务尝试,因此参考策略

是人类行为与先前行为的混合

- 为了包含人工修正,作者发现对于在自主执行过程中由人类提供的修正动作,强制令

(即为正)是有用的

如果假设人类专家总是提供良好的纠正动作,这种选择是合理的- 正如将在下文(对应于原论文第V节)讨论的那样,在实际应用中,VLA 模型同时产生离散和连续的输出,连续分布通过流匹配进行表示

因此,实际的训练目标将离散值的似然性与连续值的流匹配目标结合起来在实际操作中,作者首先在整个预训练数据集上预训练一个模型,用于表示

,然后针对每个任务通过使用on-policy rollouts(以及可选的专家纠正干预),进行方法的一次或多次迭代

1.2.3 方法概述

在Algorithm1中提供了完整方法的概述

如本节开头所述,该方法可以通过应用三个子程序来完全定义:

- 通过自主回滚收集数据(可选地由专家进行校正干预)

- 根据公式1训练价值函数

- 有了价值函数

,便可以计算某个动作

的优势

如果,说明动作

比平均水平好;如果

,说明动作

较差

RECAP 的核心思想是:不需要复杂的梯度回传,只需要在训练时把“优势”作为一个输入条件喂给模型

继而根据公式3训练策略

不同步骤之间唯一变化的是每个子程序所使用的数据来源:预训练阶段使用所有以往的演示数据,而每项技能专员的训练过程则有所不同:使用了额外的自主数据

在实际操作中,专家模型是在预训练模型的基础上进行微调的,而最终的通用模型则是从零开始训练的。该方法的更多细节详见附录F

如原论文附录F所说,对于优势估计而言

- 后训练阶段,作者使用

来估计优势函数,其中是在同一路径上向前N 步采样得到的观测

作者使用N = 50 步前视来计算该优势- 在预训练阶段,作者将优势估计计算为

其为每个回合设置N = T,这是一种方差更高的优势估计

————

采用这种优势计算方法,因为它允许在预训练时仅通过一次对价值函数的推理调用,就能动态计算出优势值

作者的实证结果显示,当策略在预训练阶段以来自不同任务的大量数据进行训练时,这种优势估计方法效果良好优势条件丢弃法:在训练过程中,有30%的概率随机丢弃对优势指示器的条件依赖。作者采用这种丢弃机制,是为了能够在推理阶段直接从有条件或无条件策略中采样,并在测试时使用CFG进行策略改进『详见下文的「1.3.2 从π0.6到π∗0.6与优势条件化(包含使用CFG在测试时进行策略改进)」』;此外,这一方法实际上替代了损失乘子α的作用

此外,对于优势阈值:每个任务的优势阈值

设置如下

- 在预训练期间,作者为每个任务选择一个阈值,使大约30 % 的示范数据具有正优势(基于一组随机抽取的10k 数据点计算)

- 在微调期间,作者通常将阈值设置为每次迭代中大约40 % 的评估回滚具有正优势

对于T 恤和短裤叠衣任务(在该任务中,基于高质量示范数据训练会产生较慢但成功率较高的策略),作者会提高阈值,使只有大约10 %的数据具有正优势

1.3 基于RECAP的π∗0.6的实现、模型与系统细节

如原论文所述,π∗0.6基于π0.6 VLA,后者是π0.5 VLA [5] 的进化版本,并在伴随的模型卡[6] 中详细说明了一些改进。π∗0.6 还额外增加了在二值化优势指示器It 上的条件能力(π∗0.6 additionally adds the ability condition on the binarized advantage indicator It),使其适用于用RECAP 进行的RL 训练

模型结构如图3 所示,作者在训练VLA的同时训练一个价值函数——按照上文「1.2.1 分布式价值函数训练:给 “任务进度” 精准打分」一节所述的方法,该价值函数同样是由VLM 初始化的

之后用RECAP 训练该价值函数和VLA,得到最终模型,称之为π∗0.6

接下来,首先详细介绍模型的设计以及它如何扩展以利用价值函数中的优势值,然后描述奖励函数和值函数,最后详细说明实现中的训练和数据收集过程

1.3.1 π0.6模型

π0.6 模型[6] 是从π0.5 模型推导而来,其保留了π0.5 的分层设计,提供高层次的子任务预测和低层次的动作生成,即可通过流匹配灵活地表示分块动作分布,并生成用于高层策略推理的中间文本

- 该模型采用了知识隔离(KI)训练过程[73],对整个模型在连续动作和离散化token(包括通过FAST[77]离散化的动作)上进行端到端训练,同时使用停止梯度来防止流匹配动作专家影响模型的其他部分

- 预训练同时采用了机器人数据和来自网络的视觉-语言联合训练数据

但π0.6 在多个方面优于π0.5:

- 预训练数据集通过来自多个机器人平台的额外数据进行了扩充

π0.6 在很大程度上继承了π0.5 中使用的训练数据构成,包括内部收集的跨形态数据和外部数据源、多样化的在家庭环境中收集的移动和非移动数据、高级子任务预测、多模态网络数据集(包括边界框和关键点预测)

π0.6 由于多样化的训练数据和丰富的元数据条件,无需特定任务微调即可在各项任务上实现显著更强的性能 - 基础VLM 为Gemma 3 [78] 4B模型

- 行动专家的参数量增加到860M(一组专门为动作生成而通过流匹配训练的参数)

具体而言,类似于π0 [1] 和π0.5,π0.6 架构基于流匹配和离散分词输出生成动作块

- 视觉-语言主干网络初始化自Gemma3 4B 模型[6],并且 “动作专家” 具有与主干相同数量的层,参数量约为860M

在预训练期间,模型最多接收四张分辨率为448 × 448 的图像作为输入,分别对应一个基础相机、最多两个手腕相机,以及(针对移动操作机器人)一个可选的后向相机

经过视觉编码器后的图像token 与分词后的语言提示和分词后的本体感觉状态拼接在一起

且在所有图像token 之间保持双向注意力(如同π0.5 所做),但在文本token 之间使用因果注意力。输入动作专家的动作token 采用双向注意力 - 模型采用知识隔离方法[3]进行训练:视觉-语言主干预测FAST 动作token [5] 及协同训练样本,如多模态网络数据

动作专家预测连续动作,动作专家的梯度不会传递回主要的视觉-语言模型主干

除了语言指令外,π0.6 还可以选择性地在提示中添加调节元数据,进一步影响任务的执行方式

在5 步去噪和3 个相机输入的情况下,π0.6 在单个H100GPU 上生成一个动作块耗时63 ms

再进一步而言,该模型可以表示为,其中

包含摄像头图像

、机器人结构

,以及

,即包括整体任务提示

(例如,” 为我做一杯浓缩咖啡”),以及额外的语言输入

,用于提供进一步调节任务执行方式的元数据

- 模型生成的动作片段

,包含关节角度和以50 Hz 频率的夹爪指令,利用了独立的” 动作专家”,但能关注模型其余部分的激活信息

- 模型还生成离散化的符号输出

,其中包括下一个预测子任务的文本表示(如” 拿起咖啡杯”),用于高层决策。由于动作是在

之后生成的,动作生成实际上受到该预测子任务的条件约束,从而提供了高层指导

当然,在推理阶段子任务预测的频率低于动作生成

在训练过程中,模型还会使用FAST tokenizer [77],作为KI 方案[73] 的一部分,预测动作片段的分词表示

作者将这些离散化动作记为。动作专家并不接收这些离散动作作为输入,因此离散动作和连续动作是独立预测的。这导致最终的训练对数似然为

由于首先预测子任务,因此可以根据如下方式对该对数似然进行分解

1.3.2 从π0.6到π∗0.6与优势条件化(包含使用CFG在测试时进行策略改进)

为了将关于优势的信息纳入策略中,作者将模型输入扩展,增加一个改进指示器作为额外的文本输入,当时,输入”Advantage: positive”,否则输入”Advantage: negative”

- 优势指示器出现在训练序列中

之后、动作(离散和连续)之前,这样只有动作对数似然会受到影响。对数似然的连续部分无法被精确计算,因此采用flow matching loss [79] 进行训练

- 在某些假设下,可以将flow matching 与扩散过程进行紧密类比,而后者又可以被解释为对数似然的下界[80],因此可以大致将「离散动作的对数似然与连续动作上的flow matching loss 之和」作为整体动作似然的下界——定义为公式4

其中,表示带噪动作,其中

是flow matching 的时间索引,

表示扩散专家模型的连续输出

是一个损失加权项(该项可以选择依赖噪声)。损失的全部细节在附录C 中提供

在训练过程中,作者随机省略指示符,而不是调整损失乘数

,这样可以直接从

的策略中采样(这对应于在公式(2) 中设置β = 1),或者同时使用有条件和无条件模型来实现无分类器引导(CFG),这使得推理时可以取β > 1。详细信息见附录E

如原论文附录C所说,为了从公式4推导对数似然,作者首先可以注意到,完整的模型似然可以分解为自回归项和扩散项

其中

- 第一项通过流匹配进行建模

- 第二项是离散动作

的自回归似然

- 第三项对应于自回归文本似然

自回归似然可以用常规方法进行估算,即对真实标签的交叉熵损失进行评估。对于

的连续似然,并不存在封闭形式的似然函数[79]

- 然而,可以参考之前的工作[82-FPO],将一步扩散过程视为具有如下似然的高斯分布:

其中且

- 由此,作者可以按照

80- Understanding diffusion objectives as the elbo with simple data augmentation

82- Flow matching policy gradients

形成对似然性的证据下界(实质上对η 和ω 进行了边缘化),其结果为

其中是一个依赖于噪声的加权项,

是一个与

无关的常数

关于该推导,参见[80],其中还在附录D.3 中推导了在选取该加权项时流匹配与扩散之间的关系- 最后,将下界与文本输出

中离散化动作部分的自回归似然结合起来,并将加权项吸收到

中,得到

此外,如原论文附录『E. 使用CFG在测试时进行策略改进,其中β > 1』所示,在训练之后,可以通过在Eq.(2) 中设置β > 1

选择进一步加强用于评估的策略。正如先前工作[4-Diffusion guidance is a controllable policy

improvement operator] 所示,可以在无需额外训练的情况下恢复这个加强的策略,因为它被学习到的策略和

隐式地定义

- 具体来说,在训练之后可以形成如下近似

现在可以认识到,扩散模型有效地学习了似然函数的梯度,即它分别表示和

- 由此,按照Frans 等人[4] 的方法,可以看到,如果按照梯度运行流匹配推断

实际上是在从期望的衰减分布中采样。作者注意到,正如主文中所述,参数β 与作者在训练过程中引入的优势阈值

之间存在一定联系(即两者都使分布更加锋利,一个在推理时作用,一个在训练时作用)

且作者发现,在训练后对分布进行锐化并将β 设为较高值,会导致动作分布被推至其学习到的支持边界(这可能导致过于激进的动作),因此作者主要依赖

以便在训练后直接获得良好的条件策略,并在必要时与中等数值设定『例如β ∈[1.5, 2.5]』结合使用

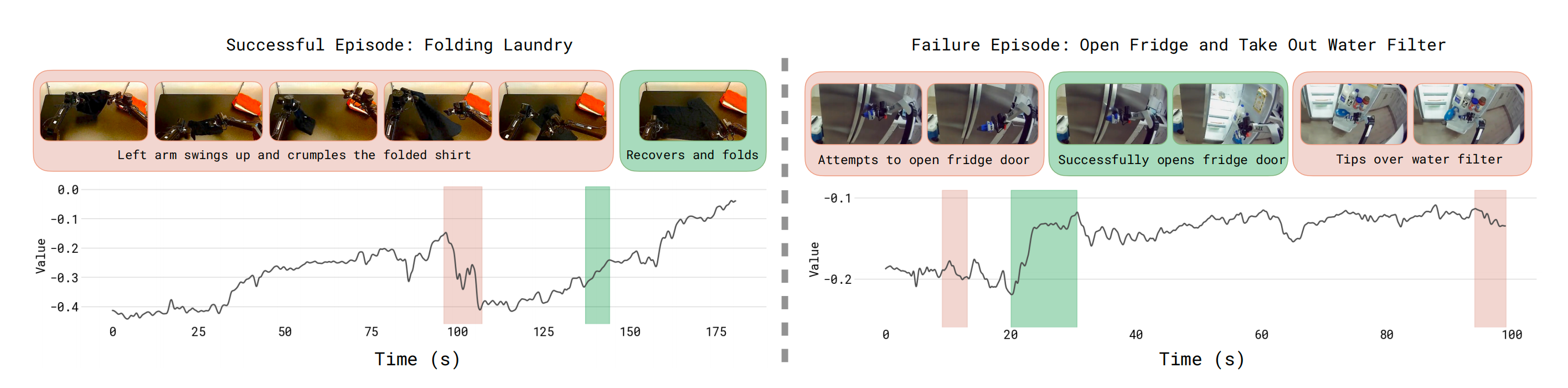

1.3.3 奖励定义与价值函数训练

由于作者的目标是开发一种通用且广泛适用的方法,用于通过经验训练视觉-语言智能体(VLA),因此作者采用了一种可以适用于几乎所有任务的通用稀疏奖励定义

- 在每个实验过程中,都会获得一个标签,指示该实验是否成功,且从其每个episode的成功标签中获取奖励,使得价值函数对应于成功完成episode之前的(负)步数『We derive the reward from his episode-level success label such that the value function corresponds to the (negative) number of steps until successful completion of the episode』

- 这等价于如下奖励函数,其中T 表示该回合中的最后一步,

是一个较大的常数,用于确保失败回合具有较低的值:

通过该奖励函数,作者训练价值函数预测在成功的采样中距离成功还剩余的步数(取其相反数),对于失败的采样则预测一个很大的负值

实际操作中,作者将预测的数值归一化到(−1,0)之间。由于在各种任务上进行训练,而这些任务的典型长度差异很大,因此会根据每个任务的最大回合长度对数值进行归一化

此外,价值函数接收与π∗0.6 VLA 相同的语言输入,并采用相同的架构设计,使用一个较小的670M 参数的VLM 主干网络,该主干网络同样从Gemma 3 初始化,详见图3

为了防止过拟合,作者还在一小部分多模态网页数据混合上对价值函数进行联合训练。图4 展示了价值函数在一些成功和失败案例上的可视化结果「更多的可视化内容见附录B中的图13」

- 作者训练了一个多任务价值函数,用于预测达到成功所需的步数,并将其归一化到最大任务长度的区间(-1,0),其中0代表任务成功完成

- 作者将价值函数的输出应用于一个成功完成的折叠任务(左),以及预训练数据集中一个操控任务未成功的示例(右)

红色部分表示价值下降,绿色部分表示价值上升;上方图片显示了该片段对应的帧。可视化结果表明,价值函数能够准确识别出任务过程中的错误,以及任务推进的速度

1.3.4 预训练、数据采集与经验学习

作者在模型预训练阶段使用的数据混合过程在很大程度上遵循了π0.5 [5] 的方法,包括来自网络的视觉-语言数据、子任务 的预测,以及在来自许多不同机器人的多种任务上的低级动作预测

- 作者注意到,在预训练之后,π∗0.6 能够执行的任务远不少

在预训练期间,作者首先在同一数据集上训练价值函数,预测每个任务成功完成所需步骤数的相反数

然后估计了用于确定基于优势的改进行为指示器的每个任务改进阈值

————

作者将设置为价值函数在任务

上预测值的30 % 分位数

然后,在VLA 训练期间实时运行价值函数,为每个样本估计,并据此基于

计算

如1.3.1节(对应于原论文第V-A节)所述,被作为输入包含到π∗0.6 中

由于为价值函数使用了相对较小的VLM 主干(670M),因此在VLA 训练期间实时推理价值函数只带来了极小的额外开销

- 在预训练之后,作者为目标任务开始一个策略改进循环

首先用目标任务的示范数据

对π∗0.6 进行微调。在这个阶段将指示变量

固定为True,作者发现这样会带来略好的结果,因此这一阶段对应于有监督微调(SFT)

这将产生初始策略,随后用于收集额外数据,这些数据被添加到

中。虽然其中一些回合是完全自动收集的,但有些回合则由专家远程操作员进行监控,他们可以介入以提供修正

这些修正可以向策略展示如何避免灾难性失败或者如何从错误中恢复

——

然而需要注意的是,仅仅依靠修正是不太可能解决所有问题的:在自主执行过程中进行干预是一种扰动行为,即便是经验丰富的人类操作员也无法保证干预的一致质量,也无法改进行为中的细微方面,比如整体速度

因此,修正更主要是用来修复大的错误以及克服探索中的挑战,本身并不能像理论中那样[7] 提供最优的监督。回忆1.1.2(对应于原论文IV-B)节,作者强制对所有修正令

————

但除此之外,整个回合(包括自主部分和修正部分),无论是否进行了修正,都会被可选地添加到数据集中

在数据收集之后,作者对截至目前为止为该任务收集的所有数据对价值函数进行微调,然后使用它来微调带有更新指标 的策略,所用方法与预训练阶段相同

且注意,价值函数和策略都是从预训练的检查点进行微调的,而不是从上一轮的策略和价值函数进行微调。作者发现这种做法有助于避免在多次迭代过程中出现偏移,尽管持续从上一个模型微调也有可能获得良好的效果

原则上,可以根据需要多次重复此过程,然而在实际应用中,作者发现即使只进行一次迭代,也通常能显著提升结果

1.4 实验评估

在作者的实验评估中,作者使用 RECAP 对 π0.6 模型进行训练,任务集涵盖了实际场景:制作浓缩咖啡饮品、折叠各种类型的衣物,以及组装纸箱

每个任务都包含多个步骤,耗时从 5 到 15 分钟不等,涉及复杂的操作行为(如受限的强力操作、液体倒灌、织物和纸板的操作等),并要求快速执行以实现高通量

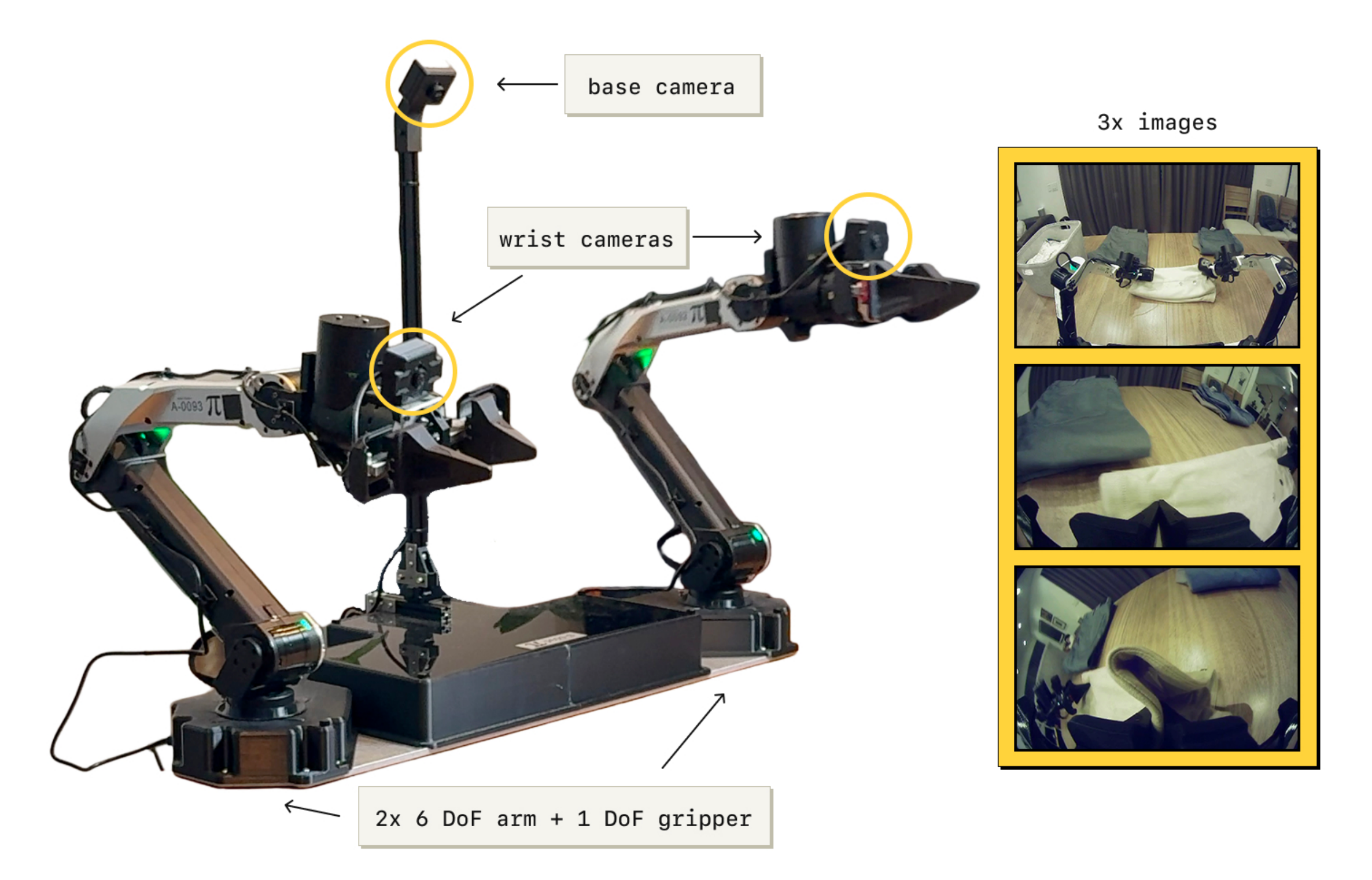

下图图5是实验中所用的机器人平台

1.4.1 评估任务

定量评估与对比涵盖三大类任务,每类均包含若干具体任务变体:叠洗衣、制作咖啡和箱体组装。按原论文所说的,相关示意图见图6

- 洗衣(T恤和短裤)

这是π0论文[81]中定义的标准衣物折叠任务。该任务包括从一个初始条件可变的篮子中取出T恤或短裤,将其铺平并折叠

任务成功的标准是在200秒内将一件衣物折叠好并叠放到桌子的右上角 - 洗衣任务(多样化物品)

该多样化洗衣任务要求对种类繁多的物品进行折叠,总共涉及11种物品类型,包括毛巾、衬衫(带纽扣)、毛衣、牛仔裤、T恤、短裤、POLO衫、裙子、长袖衬衫、袜子和内衣

————

为了在实验中获得低方差的评估指标,作者选择了最具挑战性的物品之一——带纽扣的衬衫来衡量性能。然而,策略是在所有物品类型上进行训练的,附带的视频展示了对多种衣物的处理结果

成功的标准是:在500秒内将目标物品正确折叠并堆放在桌上的叠放物上 - 洗衣(针对性故障移除)

洗衣折叠任务的最终版本采用了更为结构化的设定,用于消融实验,其中任务要求从一个固定、摊平的初始状态开始,折叠一件橙色T恤

他们极为重视任务成功,设置了严格的成功标准:要求在200秒内,T恤必须被正确折叠且衣领始终朝上

作者发现,这项任务对于评估RECAP是否能够通过强化学习移除特定的不良行为非常有用(本例中为防止衣领朝下而不是朝上) - 咖啡馆(双份浓缩咖啡)

作者在制作咖啡这一具有挑战性的长周期任务上评估他们的策略

虽然咖啡馆策略能够制作多种饮品(拿铁、冰美式、浓缩咖啡等),甚至可以用毛巾清洁咖啡机,但在作者的定量实验中,他们专注于制作双份浓咖啡这一任务

——

该任务包括:拿起滤杯、将其放在研磨机上并研磨咖啡豆、压实研磨好的咖啡粉、将滤杯锁入咖啡机、取过杯子、萃取完整的浓缩咖啡液,然后上饮

任务成功的定义是在200秒内完成所有步骤且无关键性错误(如掉落滤杯或溢出咖啡) - 纸箱组装

作者在实际工厂部署场景中对他们的策略在包装盒组装问题上进行了评估

纸箱组装包括从一张扁平的纸板开始,将其折叠成盒子,贴上标签,并将纸箱放置到箱内的指定位置

——

为了进行定量实验,作者重点关注任务的全部环节,并以从扁平纸板到组装完成并堆放到箱中的纸箱,用时不超过600秒作为整体成功标准

对于数据集构成:作者对所有任务均采用Algorithm1中描述的数据集聚合策略。然而,每个任务的性质各不相同:每个任务的情节长度不同,Iteration 0模型在各任务上的表现也有差异,并且有一个任务(装箱组装)是在部署场景下异地执行的。因此,作者初始拥有的示范数据量不同,并为迭代改进收集了不同量的经验数据

- 对于洗衣任务(T恤和短裤),作者仅使用自主评估数据——没有专家修正。随着推动模型性能,使其在速度方面与专家数据采集者更加接近,提供修正变得更加困难

对于该任务,作者在4 个机器人工作站收集了300 个实验用于评估性能- 对于多样化的叠衣任务,作者收集了450个评估实验和287 个修正实验。对于失效模式移除消融实验,作者同时收集自主数据和策略修正数据

总共收集了∼1000 个自主实验和280 + 378 个修正实验,分布在3 台机器人上- 对于组装盒子任务,作者直接在部署场景中收集数据,每轮使用3 台机器人,收集600 个演示实验和360 个修正实验

- 对于咖啡任务,作者进行了一轮实验,收集了429 个修正实验以及414 个自主实验

1.4.2 对比与消融实验

作者将RECAP与多个基线方法进行了对比:

- 预训练的π0.5 [5]

该基线不使用RL,也不利用RECAP - 预训练的π0.6 [6]

它不包含优势指示器,并且通过有监督学习进行预训练

- 使用RL 预训练的π∗0.6,但无RL后训练

它与其价值函数一起通过RL 进行预训练,并且包含了如1.3.4节(对应于原论文第V-D 节)所述的优势指示器 - π∗0.6 离线RL + SFT,相当于也无RL后训练,但有SFT

该模型通过使用目标任务的示范数据对基础的π∗0.6 预训练checkpoint 进行微调来训练

这种微调称为”SFT”,因为所有示范样本的优势值都被设为True

——

作者发现,这种将离线RL 预训练的π∗0.6 模型与高质量SFT 相结合的方法优于标准SFT(未进行离线RL预训练),并且为基于机器人实时数据的RL提供了一个良好的起点 - π∗0.6(最终的方法)

这是最终使用RECAP 在目标任务上训练的模型,包括自主回滚和专家纠正。默认情况下,作者在β = 1 时进行评估。在一些实验中,作者还考虑使用CFG 进行推理,对应于β > 1

且作者还考虑了文献中两种替代的策略提取方法,以对比作者的优势条件方法。这两种方法同样使用与RECAP相同的机器人实地数据,但其策略学习方法不同:

- AWR。从相同的预训练模型π0.6(未进行优势条件化)出发,作者基于从他们的价值函数中提取的优势,采用优势加权回归[68]进行微调

- PPO。作者实现了DPPO/FPO[23,82]的一个变体,在该变体中,作者基于单步扩散目标计算似然值,并按照SPO[83]中提出的替代PPO约束定义进行约束处理(详见附录D)

如原论文附录D所示,作者实现了一种与 DPPO 和 FPO [23,82] 相关的PPO [66] 变体,并将其用作额外的基线。为了以高效的计算方式同时训练模型的自回归部分以及基于扩散的动作专家,作者基于单步扩散目标计算似然

- 具体而言,作者使用类似于上文「1.3.2 从π0.6到π∗0.6与优势条件化」最后公式9的似然下界,但不包含改进指示器

将其分解为自回归项和流匹配项,表达为公式10

这类似于 FPO [82] 中使用的扩散似然下界。作者将其与 PPO 风格的损失结合,分别分为扩散项和自回归项- 在初步实验中,作者发现,在他们的设置下,使用标准的 PPO 剪切目标函数时,很难对动作专家(其通过无界扩散头对动作进行建模)施加信任域约束

这很可能部分源于算法属于“离线”范式,无法每隔几个梯度步骤就从真实机器人收集新数据

——

然为使训练过程更加稳定,作者发现采用遵循 SPO [83] 的另一种 PPO约束定义是有效的

最终得到的损失函数如下

其中是一个权衡参数,

和

分别是用于自回归和流匹配模型部分的信赖域参数。作者采用这种变体,从π0.6检查点开始在评估数据上进行训练

1.4.3 定量结果:对「策略提升率、多轮迭代的必要性、优势条件策略提取方法」等4个方面的全面评估

评估中使用了两个指标:吞吐量和成功率

- 吞吐量衡量每小时成功完成任务的次数,因此能够将速度和成功率综合为一个具有实际应用意义的量

- 成功率表示任务成功的比例,并根据人工标注的数据得出。评审人员被要求以多个质量指标对该过程进行评估,并将这些质量指标汇总为一个成功标签

第一方面,1) RECAP 对策略提升了多少?

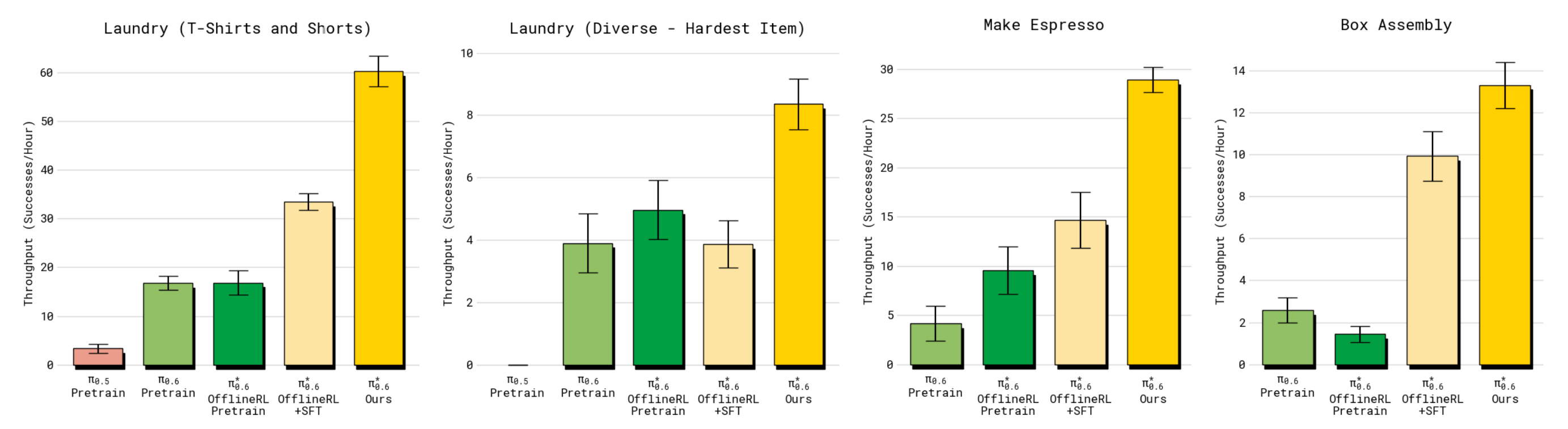

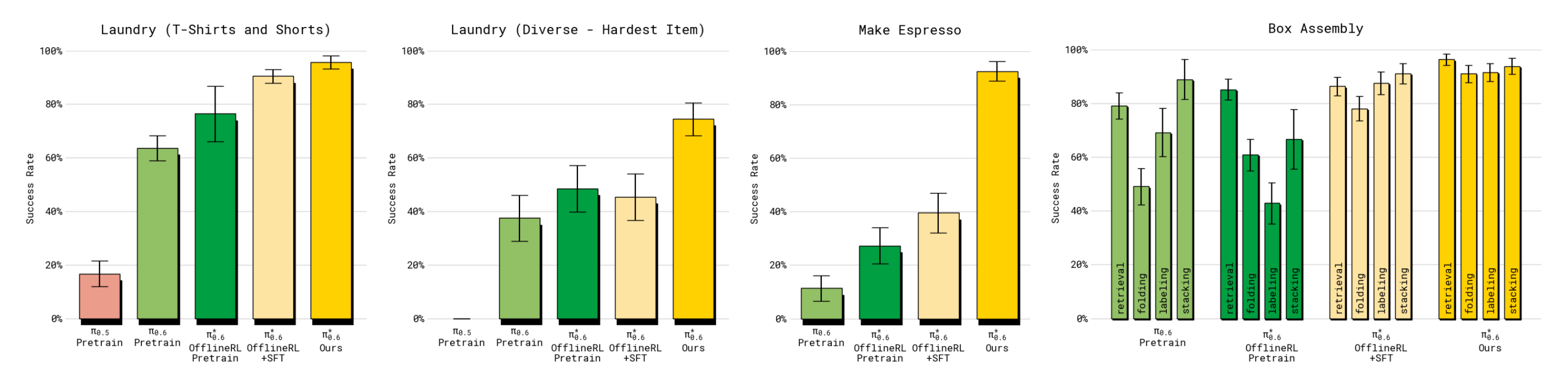

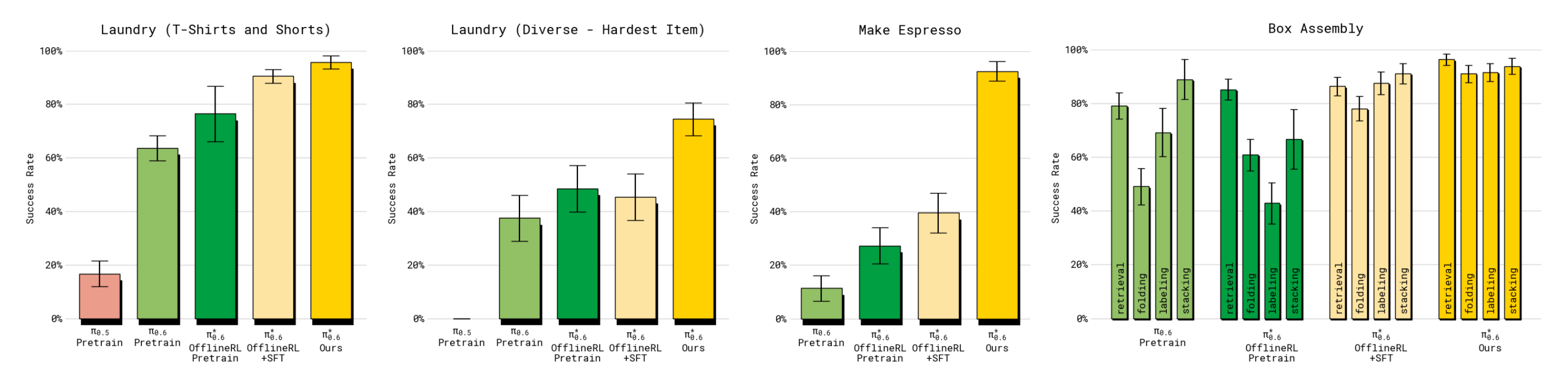

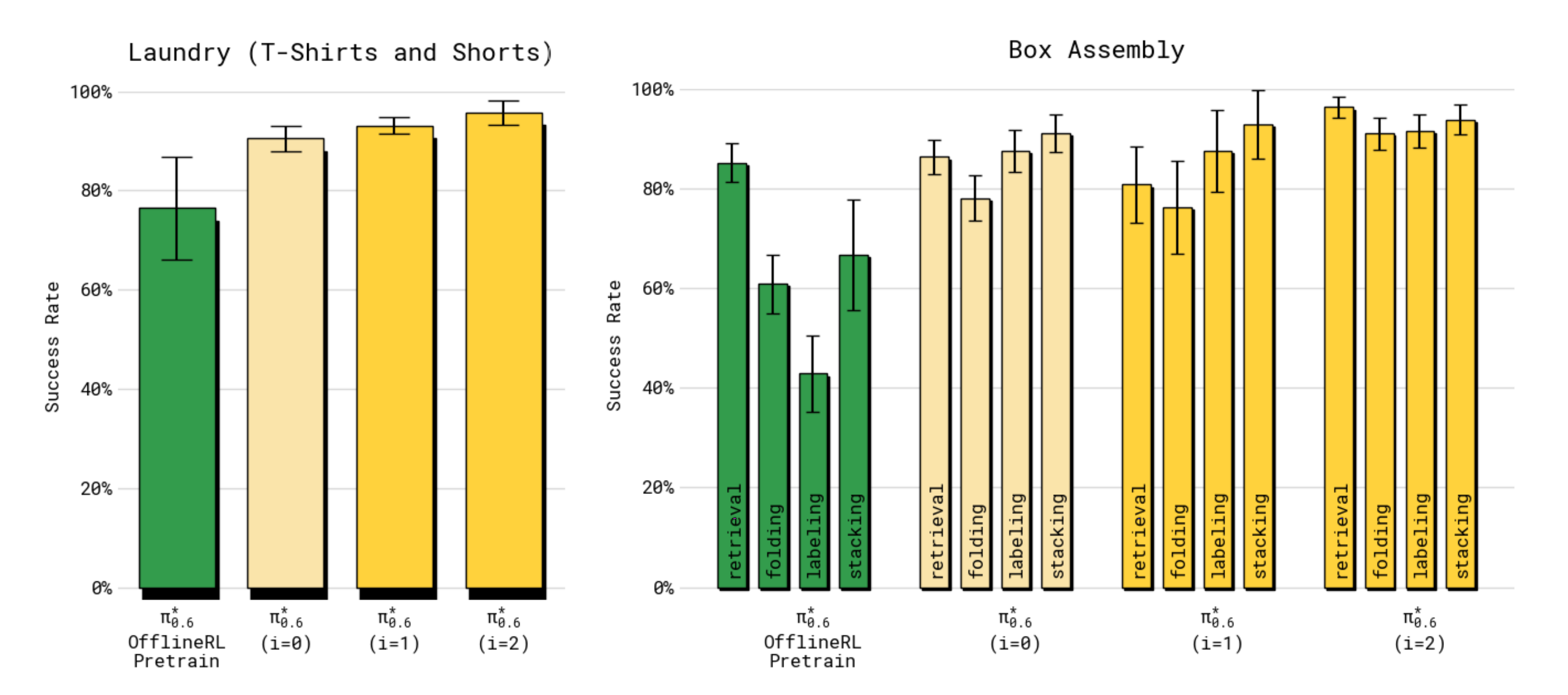

为回答这个问题,作者在图7 和图8 中展示了主要的量化结果

- 在所有任务中,最终的π∗0.6 模型都显著优于基础(有监督)π0.6 模型、RL预训练π∗0.6 模型、以及离线RL + SFT 的π∗0.6 模型

————

在包含机器人数据后(即从离线RL+SFT 到最终π∗0.6 模型,说白了,就是包含机器人与环境的自主交互,且必要时人工干预),多样的叠衣服和制作浓缩咖啡任务的吞吐量提升超过一倍,失败率大约减少了一半

- 在相对简单的叠衣服任务(T 恤和短裤)中,SFT 阶段后成功率已经接近最大,但最终模型的吞吐量仍然有显著提升

除了多样化洗衣任务外,最终π∗0.6 模型在所有任务上的成功率都在90 %+ 范围内。这使得它在实际环境中具有可行性,例如在办公室制作浓缩咖啡饮品或在工厂组装纸箱,正如附带的视频所展示的那样

- 对于箱子组装任务,图8(右)展示了该任务四个阶段的成功率细分:拾取箱片、组装纸箱、贴标签以及将其放置在箱内的可用位置

- 与其他模型相比,π∗0.6 在所有阶段都达到了更高的成功率。这些阶段中大多数失败的原因是策略耗尽了时间。附带的视频展示了每个任务运行数小时的延时拍摄

第二方面,在多次迭代中,RECAP 对 π∗ 的提升有多大0.6

接下来阐述,通过多轮数据收集和训练,RECAP训练流程如何提升策略表现

作者主要研究T恤与短裤折叠任务,以及盒子组装任务

- 对于T恤折叠任务,仅使用自主评估收集的数据(即无人工纠正),在两轮迭代中进行策略改进,以评估仅依靠强化学习在改进策略方面的效果

每一轮迭代中,作者在四台机器人上各收集300条轨迹 - 盒子组装任务则同时采用自主试验与专家遥操作介入,每轮包含600次自主试验和360次带有介入的试验

在图9 中绘制了不同迭代次数下的吞吐量,对比了RECAP 的两次迭代,分别用i = 1, i = 2 表示。最后一次迭代,标记为(Ours),对应于前一节中展示的这些任务的总体最佳结果

- 作者还对比了初始数据收集策略,该策略使用了离线RL 预训练的π∗0.6 模型并进行了SFT 微调

对于这两个任务,π∗0.6 在两次迭代中都取得了提升在洗衣任务中,我们可以看到吞吐量稳步提升,总体提升了50 %

对于长时间跨度的箱子组装任务,需要更多的数据才能带来显著的提升,但在第二次迭代后,作者观察到吞吐量提升了2×

- 此外,作者还在图10 中展示了各迭代过程中的成功率『多次迭代下成功率的提升。洗衣任务很快达到最大成功率(但其吞吐量仍如图9所示持续提升),而箱子组装任务的成功率则持续提升』

对于洗衣任务,第一次迭代就已经将成功率提升到90 % 以上,而第二次迭代主要提升了吞吐量

对于盒子组装任务,在两轮迭代中都看到了成功率的明显提升。虽然仍存在一些失败(尤其是在最后将盒子放置到堆叠上时),但最终策略在600秒的限定时间内,实现了约90%的成功率,无论是在折叠盒子还是贴标签环节

第三方面,3) RECAP 中的优势条件策略提取方法与其他方法相比如何?

将第四节B 部分「1.2.2 基于优势条件的策略提取:给每个状态打分,判定某个动作是接近目标还是偏离目标」介绍的优势条件策略提取方法与文献中的其他方法进行了比较:AWR 和PPO

作者使用T 恤与短裤任务进行对比。为了确保对比的可控性,作者使用了与训练最终模型相同的数据进行比较。这为基线方法提供了略微的优势,因为它们能够访问在运行RECAP 时收集到的更高质量数据

结果如图11 所示「不同策略提取方法的对比。RECAP应用于π∗在洗衣任务中,0.6相比AWR和PPO实现了迄今为止最高的吞吐量」。虽然AWR 和PPO 都能够取得合理的结果,但它们都远远逊色于我们的方法,并且难以在离线RL + SFT π∗0.6 模型的基础上取得提升

- 对于PPO,不得不使用较小的信任域约束(η = 0.01) 以在该离策略环境下稳定训练,虽然这样可以保证训练稳定,但该方法并未实现良好的性能

- AWR 可以达到合理的成功率,但导致策略执行速度更慢,吞吐量较低

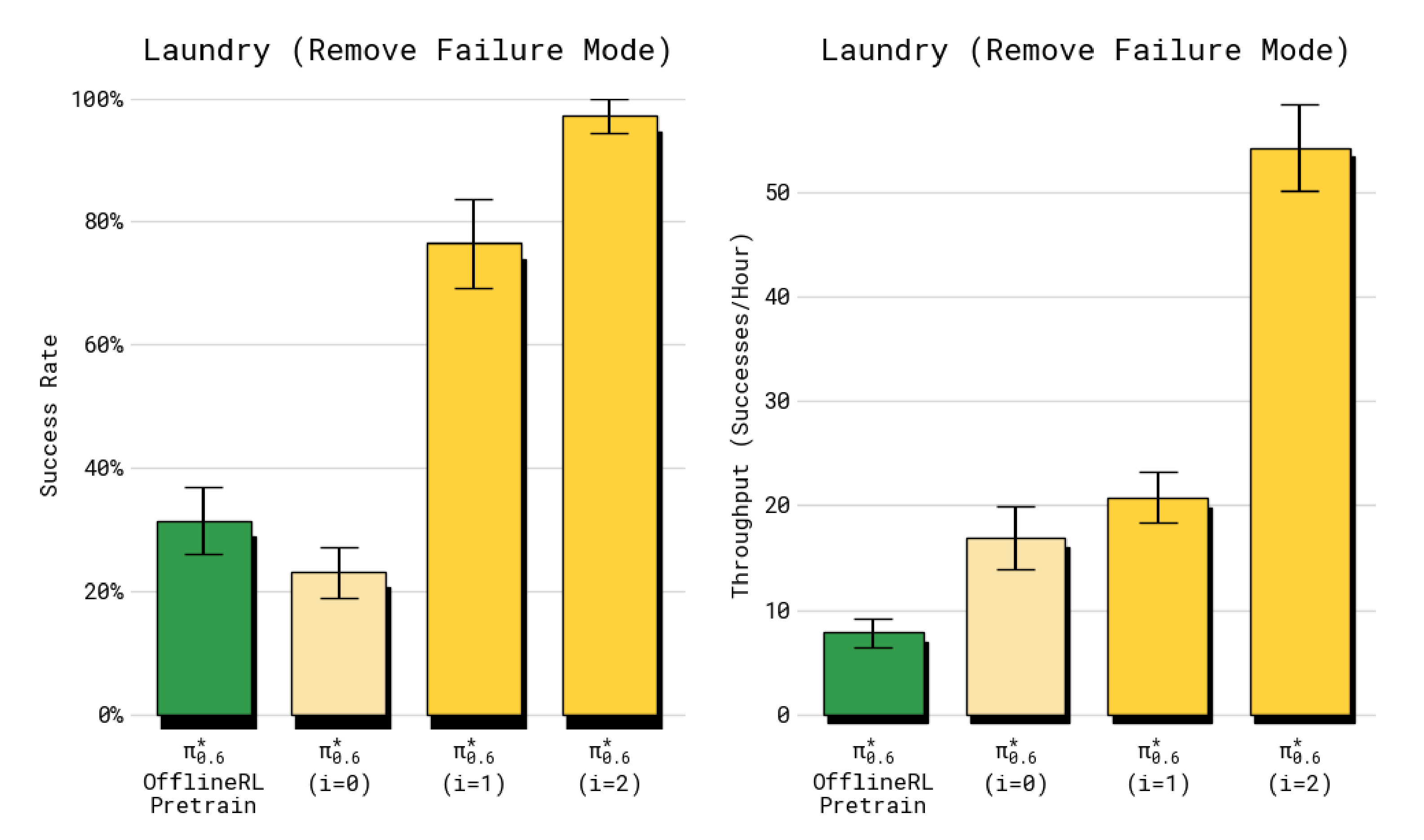

第四方面,4)RECAP 能否在相对较少的数据下显著改变策略行为并消除一个失败模式?

虽然前面的实验主要关注于策略性能的整体端到端评估,但也可以聚焦于某个特定的失败模式,来考察使用RECAP 进行RL 训练是否能够从策略中消除某个具体错误

- 为回答这一问题,作者使用了带有严格成功标准的洗衣任务版本,该标准要求策略将T恤折叠并且衣领居中且朝上。每个回合都以特定的对抗性条件初始化,即T 恤被平铺在桌面上,使得基线离线RL + SFT 策略经常无法正确折叠

- 正如图12 所示,在该设置下应用RECAP 进行两轮迭代(每轮收集600 条轨迹),最终得到的策略有97 % 的成功率,并且速度很快

——

因此,作者得出结论:RECAP 能够有效消除特定的失败模式,即使完全通过RL 学习而没有任何干预数据或额外演示

1.4.4 目前的局限与改进方向

如原论文最后所说,针对RECAP系统,有多个改进方向

- 首先,系统尚未实现完全自动化:它依赖于人工标注和人为干预来提供奖励反馈、操作干预以及回合重置。已有多项相关研究探索了自动化这些环节的方法[84,85],而VLA(视觉语言代理)为实现更自动化的数据采集提供了新途径,例如通过利用高层策略[86]来推理如何重置场景

- 其次,系统在探索方面相对简单,主要采用贪婪策略,依赖策略的随机性和人工干预来发现新的解决方案

当初始模仿学习策略已经能够做出合理动作时,这种方式是可以接受的,但通过更先进的探索方法仍有很大提升空间 - 最后,RECAP采用“离线”迭代更新(即收集一批数据,重新训练模型,并重复该过程),此点其实相当于类似ChatGPT三阶段训练方式中的RLHF了,即采集一批批经验数据重复迭代,如下图所示『图源:来自此文《ChatGPT技术原理解析》此节「3.2.1 如何更好的理解Actor-Critic架构中的Critic网络」』

而不是运行完全在线的RL循环——当然 其中,策略和值函数会随着数据的收集实时更新

————

作者声称,他们之所以做出这个选择,是出于便利性的考虑,但将该方法扩展为完全并发的在线RL框架,是未来值得探索的方向

更广泛地说,利用强化学习训练VLA或许是实现其在现实应用中达到足够性能水平的最直接途径

当然了,作者也说,针对VLA的强化学习面临诸多挑战,包括高容量模型的大规模强化学习训练难度、样本复杂性、自主性以及延迟反馈等问题。尽管为小规模系统或“虚拟”领域(如大型语言模型)设计的现有强化学习框架可以作为良好的起点,但要使强化学习成为VLA训练的可行工具,还需要更多研究

// 待更

后记

π*0.6里面的细节还是多啊

- 前几天周三(11.19)时,以为当天 可以解读完,但到刚才 解读进度 总算到了90%

- 当然了,一旦涉及到RL,细节便少不了,比如少不了数学推导/公式,不过,十多年如一日,我尽可能让推导/公式 更好懂

且在写本文的过程中,我准备再专门写一篇文章,解读下π*0.6的第82篇参考文献『82-Flow matching policy gradients』,即FPO了

更多推荐

已为社区贡献19条内容

已为社区贡献19条内容

所有评论(0)