【花雕学编程】Arduino BLDC 之多传感器融合的动态避障跟随(服务机器人场景)

本文介绍了一种高度集成的智能移动机器人解决方案,融合了BLDC电机驱动、多传感器数据融合、动态目标跟踪和环境感知等技术。该机器人具备实时路径规划与避障能力,适用于酒店服务、医院辅助、零售导购等多种场景。文章分析了关键挑战,包括Arduino计算能力瓶颈、传感器融合算法复杂性、实时安全性等问题,并提出了分层架构、优化算法等对策。最后展示了一个基于红外和超声波的简易跟随机器人实例,包含硬件配置和核心代

这是一个高度集成的智能移动机器人解决方案,它结合了嵌入式系统、高效电机驱动、多传感器数据融合、环境感知、动态目标跟踪、路径规划与实时避障等先进技术,旨在服务机器人领域实现安全、流畅、智能的动态环境跟随功能。

一、 主要特点 (Key Features)

高效动力系统 (High-Efficiency Drive System):

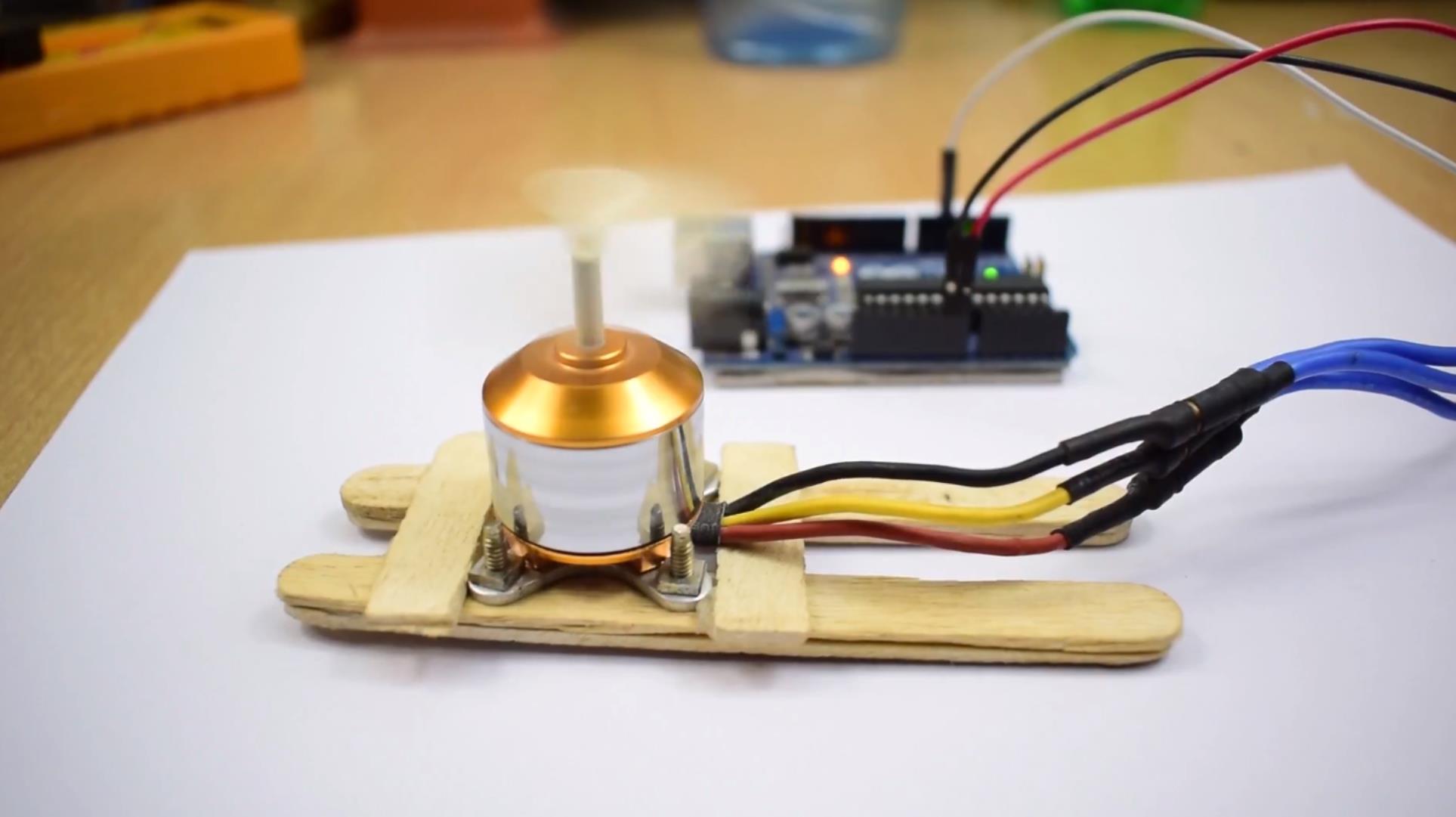

核心: 采用BLDC电机及其驱动器(ESC或专用驱动IC)为机器人提供动力。

功能: 相比有刷电机,BLDC具有高效率、高扭矩密度、长寿命和精确控制能力,对于需要频繁加速、减速、转向的跟随机器人至关重要,能有效延长续航时间并提供稳定的驱动力。

多传感器融合感知 (Multi-Sensor Fusion Perception):

核心: 依赖多种传感器协同工作,以克服单一传感器的局限性,提供更全面、更可靠、更精确的环境和目标信息。

常用传感器组合:

视觉传感器 (Camera): 用于目标识别与跟踪(如人脸识别、颜色标记、深度学习模型)、环境特征提取、部分障碍物识别(需结合深度信息)。

激光雷达 (LiDAR): 提供精确的二维或三维距离信息,用于构建环境地图、精确检测静态和动态障碍物、进行路径规划。

超声波传感器 (Ultrasonic Sensors): 作为近距离障碍物检测的补充,成本低,对透明或黑色物体检测有效。

红外传感器 (IR Sensors): 用于近距离障碍物检测或特定场景下的目标识别。

IMU (Inertial Measurement Unit): 提供机器人自身的姿态(俯仰、横滚、偏航角)和运动状态(加速度、角速度),辅助定位、姿态估计和运动预测。

功能: 通过融合来自不同传感器的数据(如位置、距离、速度、类别),获得比单一传感器更准确、更完整的环境模型和目标状态估计。

动态目标识别与跟踪 (Dynamic Target Recognition & Tracking):

核心: 结合视觉传感器和/或其它传感器(如佩戴特定信标的对象),使用计算机视觉算法(如特征匹配、模板匹配、深度学习)来识别和持续锁定跟随目标。

功能: 实时确定目标的位置、速度和运动趋势,是实现跟随行为的基础。需要处理目标被短暂遮挡、外观变化、光照变化等情况。

实时环境建图与定位 (Real-Time Mapping & Localization):

核心: 利用LiDAR、IMU、里程计(基于BLDC电机编码器)等数据,运行SLAM(Simultaneous Localization and Mapping)算法或基于已知地图的定位算法。

功能: 构建机器人周围的局部环境地图(或与预存地图匹配),确定机器人在环境中的精确位置和姿态,为路径规划提供基础。

动态路径规划与避障 (Dynamic Path Planning & Obstacle Avoidance):

核心: Arduino(或更强大的主控)结合环境地图、目标位置、自身状态和传感器实时数据,运行路径规划算法。

常用算法:

全局路径规划: A*、Dijkstra等,用于计算从当前位置到目标位置的大致路径(考虑静态障碍物)。

局部路径规划/动态避障: DWA(Dynamic Window Approach)、TEB(Timed Elastic Band)、VFH(Vector Field Histogram)等,用于在全局路径的基础上,实时避开动态障碍物(行人、车辆、移动物品),生成安全、平滑的局部轨迹。

功能: 在跟随目标的同时,确保机器人不会与环境中(静态或动态)的障碍物发生碰撞。

自适应跟随行为 (Adaptive Following Behavior):

核心: 控制系统根据目标的运动状态(静止、匀速、加速、变向)和环境的动态变化(出现新障碍物、通道变窄)调整跟随策略。

功能: 例如,保持恒定距离跟随;目标突然变向时平滑跟随;目标停下时机器人也停下并保持警戒;路径被堵时寻找绕行或暂停等待。

二、 应用场景 (Application Scenarios)

酒店/餐饮服务 (Hotel/Food Service):

用途: 跟随客人前往房间或餐桌,运送食物、饮料、毛巾等物品。

价值: 提升服务效率和客户体验,减少服务员负担。

医院辅助 (Hospital Assistance):

用途: 跟随医护人员或患者,运送病历、药品、医疗器械或协助患者移动。

价值: 提高医院内部物流效率,减轻医护人员工作强度。

零售/商场导购 (Retail/Mall Concierge):

用途: 跟随顾客,引导他们到指定店铺或商品区域,或作为移动广告展示平台。

价值: 提供个性化服务,吸引顾客注意力。

机场/车站引导 (Airport/Station Guidance):

用途: 跟随旅客前往登机口、检票口或特定服务区域。

价值: 改善旅客体验,分流引导。

办公环境助手 (Office Environment Assistant):

用途: 跟随员工,协助搬运文件、会议用品等。

价值: 提高办公效率。

三、 需要注意的事项 (Considerations & Critical Challenges)

Arduino计算能力瓶颈 (Arduino Computational Bottleneck):

问题: 经典Arduino(如Uno/Nano)的处理能力和内存严重不足以运行复杂的传感器融合算法、实时SLAM、深度学习目标识别或高级动态路径规划(如DWA)。即使是ESP32等性能稍强的MCU,在处理高帧率视觉数据和复杂地图时也可能吃力。

对策:

选用更强主控: 如树莓派(Raspberry Pi)、NVIDIA Jetson Nano/Orin Nano、或专门的机器人控制器(如UP ROSbot控制器)。这些平台具备更强的CPU/GPU性能,更适合运行ROS(Robot Operating System)等机器人框架。

分层架构: Arduino负责底层传感器数据采集、电机控制、简单逻辑;将复杂的感知、规划、融合任务交给上位机(如树莓派/PC)处理。

传感器融合算法复杂性 (Complexity of Sensor Fusion Algorithms):

问题: 如何有效融合不同类型、不同频率、不同精度的传感器数据是一个复杂的工程问题,涉及坐标系转换、时间同步、权重分配、滤波(如卡尔曼滤波、粒子滤波)等技术。

对策: 学习和应用成熟的传感器融合框架(如ROS中的robot_localization包),或使用简化的融合策略。

实时性与安全性 (Real-Time Performance & Safety):

问题: 机器人必须在极短时间内感知环境变化、做出决策并执行动作,以避免撞上突然出现的障碍物或追丢目标。任何计算延迟或决策错误都可能导致事故。

对策: 优化代码效率,确保关键传感器(如紧急避障传感器)有最高的处理优先级,设计冗余的安全机制(如物理急停按钮、碰撞检测),严格测试各种边界情况。

环境复杂性与动态性 (Environmental Complexity & Dynamics):

问题: 服务场景通常人流密集、光线变化大、障碍物种类多样且动态性高,对感知和规划算法的鲁棒性提出极高要求。

对策: 进行大量不同场景下的实地测试和算法调优,考虑使用深度学习模型提升环境理解和目标识别能力(但这需要强大算力)。

目标丢失与恢复策略 (Target Loss & Recovery Strategy):

问题: 目标被人群遮挡、走出传感器视野或伪装失效时,机器人应如何反应?是原地等待、搜索找回还是通知用户?

对策: 设计智能的目标丢失检测和恢复逻辑,如预测目标轨迹、执行搜索模式、发出提示音或灯光信号。

人机交互与社会接受度 (Human-Robot Interaction & Social Acceptance):

问题: 机器人在人群中移动需要遵循社交礼仪,避免惊吓或阻碍他人。其行为应显得自然、可预测。

对策: 设计友好的UI/UX(如显示屏、语音提示、指示灯),遵循机器人伦理规范,进行用户研究以优化交互体验。

电源管理与续航 (Power Management & Battery Life):

问题: 多传感器、高性能主控、BLDC电机共同工作,功耗较大。需要平衡性能与续航时间。

对策: 选择高容量电池,优化软件算法降低功耗,设计智能休眠机制。

成本控制 (Cost Control):

问题: 高性能传感器(如LiDAR)、计算平台和BLDC驱动系统成本较高,可能影响商业化部署。

对策: 在满足功能需求的前提下,寻求性价比高的传感器和组件方案。

1、基于红外+超声波的简易跟随机器人(入门级)

功能:通过红外传感器(HC-SR501)检测人体/障碍物,超声波传感器(HC-SR04)测量距离,结合BLDC电机的差速驱动,实现“跟随人走”和“遇障避让”。

硬件:Arduino UNO、2个BLDC电机(带编码器)、L298N驱动器、HC-SR04(测距)、HC-SR501(人体感应)、OLED显示屏。

代码逻辑:

状态机设计:定义三种模式——FOLLOW_MODE(跟随人)、AVOID_MODE(避障)、STOP_MODE(停机);

传感器采集:读取超声波距离和红外感应信号;

决策逻辑:若红外检测到人且距离>0.5m→跟随模式(保持0.5-1m距离);若距离<0.3m或前方有障碍物→避障模式(转向绕开);否则停机;

运动控制:根据模式输出左右轮PWM,实现差速转向。

#include <NewPing.h>

#include <Adafruit_SSD1306.h>

// 硬件引脚定义

#define SONAR_TRIG D2

#define SONAR_ECHO D3

#define IR_SENSOR D4

#define LEFT_MOTOR_IN1 D5

#define LEFT_MOTOR_IN2 D6

#define RIGHT_MOTOR_IN1 D7

#define RIGHT_MOTOR_IN2 D8

#define MOTOR_EN_LEFT A1

#define MOTOR_EN_RIGHT A2

// 传感器对象

NewPing sonar(SONAR_TRIG, SONAR_ECHO, 200); // 超声波最大测距200cm

Adafruit_SSD1306 display(128, 64, &Wire, -1); // OLED显示屏

// 全局变量

int mode = STOP_MODE; // 当前模式

float distance = 0; // 超声波测距(cm)

bool personDetected = false; // 是否检测到人

void setup() {

Serial.begin(9600);

pinMode(IR_SENSOR, INPUT);

pinMode(LEFT_MOTOR_IN1, OUTPUT);

pinMode(LEFT_MOTOR_IN2, OUTPUT);

pinMode(RIGHT_MOTOR_IN1, OUTPUT);

pinMode(RIGHT_MOTOR_IN2, OUTPUT);

pinMode(MOTOR_EN_LEFT, OUTPUT);

pinMode(MOTOR_EN_RIGHT, OUTPUT);

// 初始化OLED

if (!display.begin(SSD1306_SWITCHCAPVCC, 0x3C)) {

for (;;) delay(10);

}

display.clearDisplay();

display.setTextSize(1);

}

void loop() {

// 1. 传感器数据采集

distance = sonar.ping_cm(); // 超声波测距(0表示无回波)

personDetected = digitalRead(IR_SENSOR) == HIGH; // 红外检测人

// 2. 模式决策

if (personDetected && distance > 50) { // 检测到人且距离合适→跟随

mode = FOLLOW_MODE;

} else if (distance < 30 || !personDetected) { // 距离过近或未检测到人→避障/停机

mode = AVOID_MODE;

} else {

mode = STOP_MODE;

}

// 3. 执行对应模式

switch (mode) {

case FOLLOW_MODE:

followPerson();

break;

case AVOID_MODE:

avoidObstacle();

break;

case STOP_MODE:

stopMotors();

break;

}

// 4. 显示状态

display.clearDisplay();

display.setCursor(0, 0);

display.println("Mode: " + getModeName(mode));

display.println("Distance: " + String(distance) + " cm");

display.println("Person: " + (personDetected ? "Yes" : "No"));

display.display();

delay(100); // 降低循环频率,减少传感器干扰

}

// 跟随模式:保持与人的固定距离

void followPerson() {

int pwmLeft = 150, pwmRight = 150; // 基础速度

if (distance > 80) { // 距离太远→加速前进

pwmLeft = pwmRight = 200;

} else if (distance < 60) { // 距离太近→减速或后退

pwmLeft = pwmRight = 100;

}

// 调整转向(轻微偏航修正)

setMotorSpeed(pwmLeft, pwmRight);

}

// 避障模式:转向绕开障碍物

void avoidObstacle() {

// 先停止,然后转向(假设左侧无障碍物)

setMotorSpeed(100, 200); // 左转(左慢右快)

delay(500); // 转向时间

setMotorSpeed(150, 150); // 恢复前进

}

// 设置电机速度(差速驱动)

void setMotorSpeed(int left, int right) {

// 左电机方向(正转前进)

digitalWrite(LEFT_MOTOR_IN1, (left > 0) ? HIGH : LOW);

digitalWrite(LEFT_MOTOR_IN2, (left > 0) ? LOW : HIGH);

// 右电机方向

digitalWrite(RIGHT_MOTOR_IN1, (right > 0) ? HIGH : LOW);

digitalWrite(RIGHT_MOTOR_IN2, (right > 0) ? LOW : HIGH);

// PWM调速(0-255)

analogWrite(MOTOR_EN_LEFT, abs(left));

analogWrite(MOTOR_EN_RIGHT, abs(right));

}

// 停止电机

void stopMotors() {

setMotorSpeed(0, 0);

}

// 获取模式名称(用于显示)

String getModeName(int mode) {

switch (mode) {

case FOLLOW_MODE: return "Follow";

case AVOID_MODE: return "Avoid";

case STOP_MODE: return "Stop";

default: return "Unknown";

}

}

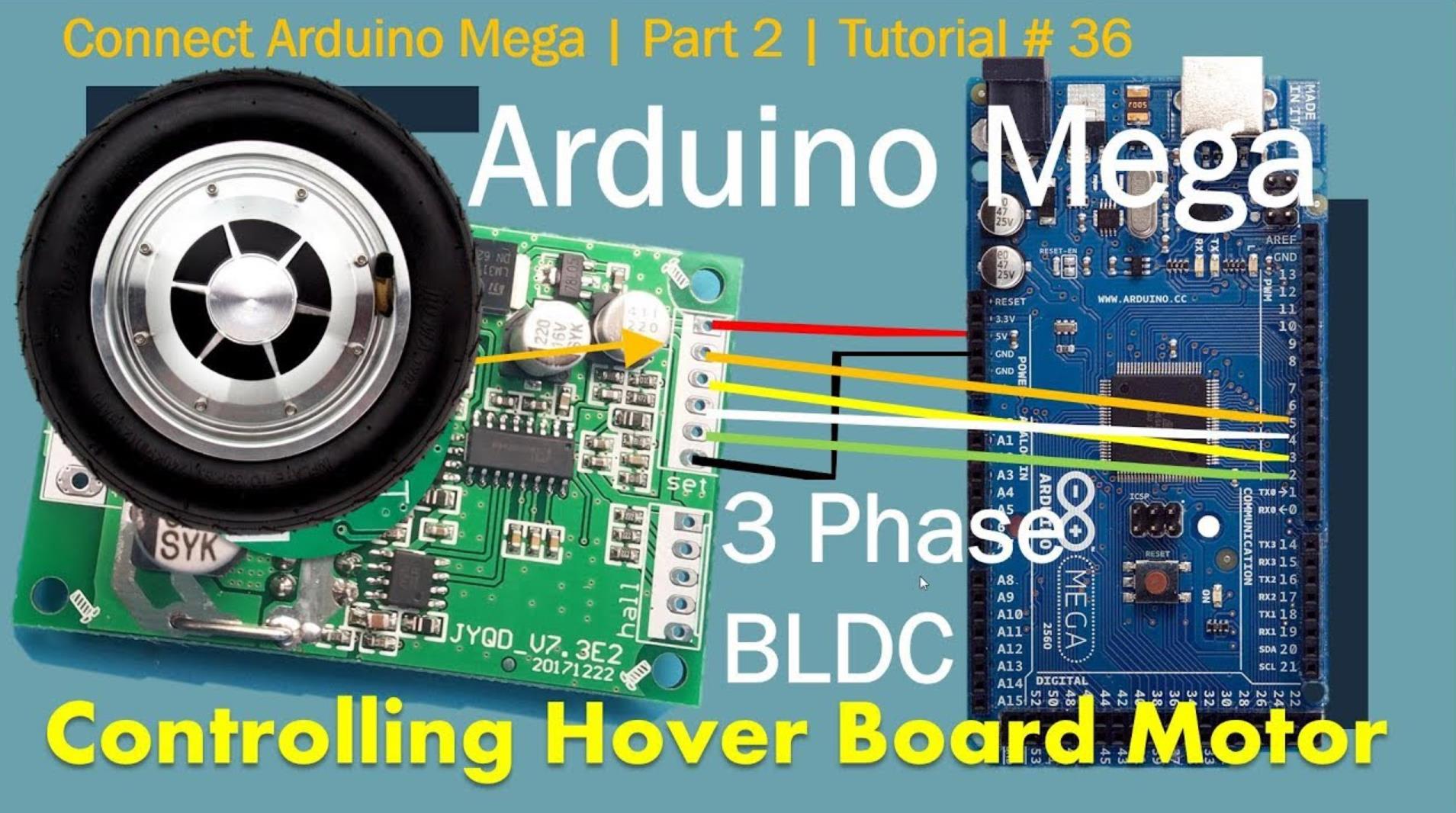

2、基于激光雷达+卡尔曼滤波的SLAM导航机器人(进阶级)

功能:用RPLiDAR A1(激光雷达)构建环境地图,结合里程计(编码器)和卡尔曼滤波融合定位,实现自主建图(SLAM)和路径规划(A*),最终完成“目标点导航”(如从客厅到卧室)。

硬件:Arduino Mega、RPLiDAR A1、2个BLDC电机(带编码器)、TB6560驱动器、SD卡模块(存储地图)。

代码逻辑:

数据融合:用卡尔曼滤波融合激光雷达的绝对定位和里程计的相对定位,得到更精准的机器人位姿(x,y,θ);

SLAM建图:将激光雷达的点云数据转换为栅格地图(Occupancy Grid Map),记录障碍物位置;

路径规划:用A*算法计算从当前位置到目标点的最短路径;

轨迹跟踪:将路径分解为左右轮速度序列,通过双PID(位置环+速度环)控制电机跟随轨迹。

#include <RPLidar.h>

#include <SD.h>

#include <KalmanFilter.h>

#include <AStar.h>

// 硬件定义

#define LIDAR_SERIAL Serial1 // Lidar通信串口

#define ENCODER_LEFT_A D2

#define ENCODER_LEFT_B D3

#define ENCODER_RIGHT_A D4

#define ENCODER_RIGHT_B D5

#define MOTOR_LEFT_EN A1

#define MOTOR_RIGHT_EN A2

RPLidar lidar; // Lidar对象

AStar planner; // A*路径规划对象

KalmanFilter kf; // 卡尔曼滤波对象(状态:x,y,theta)

// 全局变量

float odomX = 0, odomY = 0, odomTheta = 0; // 里程计位姿

float filteredX = 0, filteredY = 0, filteredTheta = 0; // 卡尔曼滤波后的位姿

Path navigationPath; // 导航路径

unsigned long lastTime = 0;

int leftEncoderCount = 0, rightEncoderCount = 0;

const float WHEEL_RADIUS = 0.1; // 车轮半径(m)

const float ROBOT_WIDTH = 0.3; // 机器人宽度(m)

void setup() {

Serial.begin(115200);

lidar.begin(LIDAR_SERIAL, 115200); // 初始化Lidar

SD.begin(10); // 初始化SD卡(存储地图)

// 初始化编码器中断

attachInterrupt(digitalPinToInterrupt(ENCODER_LEFT_A), leftEncoderISR, CHANGE);

attachInterrupt(digitalPinToInterrupt(ENCODER_RIGHT_A), rightEncoderISR, CHANGE);

// 初始化卡尔曼滤波(状态维度3,观测维度360)

kf.init(3, 360);

kf.processNoiseCov << 0.01, 0, 0, 0, 0.01, 0, 0, 0, 0.01; // 过程噪声

kf.measurementNoiseCov << 0.1, 0, ...; // 观测噪声(需校准)

// 加载地图(从SD卡)

loadMapFromSD();

}

void loop() {

// 1. 更新里程计(编码器计数→位移)

updateOdometry();

// 2. 获取Lidar数据并融合定位

if (lidar.isValidScan()) {

float scan[360];

lidar.getScan(scan); // 获取360°扫描数据

kf.predict(); // 预测下一状态(基于里程计)

kf.update(scan); // 更新观测值(基于Lidar)

filteredX = kf.statePost[0];

filteredY = kf.statePost[1];

filteredTheta = kf.statePost[2];

}

// 3. 路径规划(若路径为空则重新计算)

if (navigationPath.empty()) {

calculateAStarPath(); // A*算法计算路径

}

// 4. 轨迹跟踪(双PID控制)

followPath(navigationPath);

// 5. 保存地图(定期更新)

if (millis() - lastTime > 5000) {

saveMapToSD();

lastTime = millis();

}

delay(50);

}

// 更新里程计(编码器计数→位姿)

void updateOdometry() {

static float lastLeftPos = 0, lastRightPos = 0;

float deltaTime = 0.1; // 假设100ms采样周期

// 计算左右轮位移

float leftPos = leftEncoderCount * WHEEL_RADIUS * 2 * PI / ENCODER_PPR;

float rightPos = rightEncoderCount * WHEEL_RADIUS * 2 * PI / ENCODER_PPR;

// 计算机器人位移和角度变化

float deltaS = (leftPos + rightPos) / 2;

float deltaTheta = (rightPos - leftPos) / ROBOT_WIDTH;

// 更新位姿

odomTheta += deltaTheta;

odomX += deltaS * cos(odomTheta);

odomY += deltaS * sin(odomTheta);

// 重置编码器计数

leftEncoderCount = 0;

rightEncoderCount = 0;

}

// A*路径规划(简化版)

void calculateAStarPath() {

Point start(filteredX, filteredY);

Point goal(5, 5); // 目标点(客厅到卧室)

navigationPath = planner.findPath(start, goal); // 返回路径点列表

}

// 轨迹跟踪(双PID控制)

void followPath(Path& path) {

if (path.empty()) return;

// 找到最近的路径点

Point target = path.getClosestPoint(filteredX, filteredY);

// 计算目标线速度和角速度

float dx = target.x - filteredX;

float dy = target.y - filteredY;

float targetTheta = atan2(dy, dx);

float errorTheta = normalizeAngle(targetTheta - filteredTheta);

float v = 0.5; // 目标线速度(m/s)

float w = errorTheta * 1.0; // 目标角速度(rad/s)

// 转换为左右轮速度

float leftSpeed = (v - w * ROBOT_WIDTH / 2) / WHEEL_RADIUS;

float rightSpeed = (v + w * ROBOT_WIDTH / 2) / WHEEL_RADIUS;

// 速度环PID控制(左右轮独立)

leftPID.Compute();

rightPID.Compute();

// 输出PWM给电机

setMotorSpeed(leftPID.GetOutput(), rightPID.GetOutput());

}

3、基于视觉+毫米波雷达的人员跟随机器人(高级级)

功能:用OpenMV Cam(视觉传感器)识别人体特征(如颜色、形状),毫米波雷达(MR60B)测量人体的精确距离和速度,结合YOLO Tiny轻量化模型实现高精度人员跟随(抗光照变化、遮挡)。

硬件:Arduino Mega、OpenMV Cam、MR60B雷达、2个BLDC电机(带编码器)、ESC、GPS模块(室外定位)。

代码逻辑:

视觉处理:OpenMV Cam通过颜色阈值识别人体(如红色衣服),输出人体的像素坐标和** bounding box**;

雷达融合:MR60B雷达测量人体的距离(d)、速度(v)和角度(θ),与视觉数据融合得到人体的世界坐标;

目标跟踪:用卡尔曼滤波跟踪人体的运动轨迹,预测下一时刻的位置;

自适应跟随:根据人体的距离和速度调整机器人的速度(如人走得快→机器人加速,人停下→机器人停下)。

#include <SoftwareSerial.h>

#include <KalmanFilter.h>

// 硬件定义

SoftwareSerial openmvSerial(12, 13); // OpenMV通信串口

SoftwareSerial radarSerial(9, 10); // 雷达通信串口

#define MOTOR_LEFT_EN A1

#define MOTOR_RIGHT_EN A2

KalmanFilter kf; // 目标跟踪滤波器(状态:x,y,vx,vy)

// 全局变量

struct Target {

float x; // 目标x坐标(m)

float y; // 目标y坐标(m)

float vx; // 目标x方向速度(m/s)

float vy; // 目标y方向速度(m/s)

} target;

bool targetDetected = false; // 是否检测到目标

void setup() {

Serial.begin(115200);

openmvSerial.begin(9600); // OpenMV波特率9600

radarSerial.begin(9600); // 雷达波特率9600

// 初始化卡尔曼滤波(状态维度4:x,y,vx,vy)

kf.init(4, 2); // 观测维度2(x,y)

kf.processNoiseCov << 0.01, 0, 0, 0, 0.01, 0, 0, 0, 0.01, 0, 0, 0, 0.01;

kf.measurementNoiseCov << 0.1, 0, 0, 0.1;

// 初始化电机PID

leftPID.SetSampleTime(10);

rightPID.SetSampleTime(10);

}

void loop() {

// 1. 接收OpenMV视觉数据(人体bounding box)

if (openmvSerial.available()) {

VisionData vision = parseVisionData(openmvSerial.readString());

if (vision.valid) {

// 转换像素坐标到世界坐标(需相机标定)

target.x = vision.centerX * 0.01; // 假设1像素=0.01m

target.y = vision.centerY * 0.01;

targetDetected = true;

}

}

// 2. 接收雷达数据(距离、速度、角度)

if (radarSerial.available()) {

RadarData radar = parseRadarData(radarSerial.readString());

if (targetDetected) {

// 融合视觉和雷达数据(加权平均)

target.x = 0.7 * target.x + 0.3 * radar.x;

target.y = 0.7 * target.y + 0.3 * radar.y;

target.vx = radar.vx;

target.vy = radar.vy;

}

}

// 3. 目标跟踪(卡尔曼滤波预测)

if (targetDetected) {

kf.predict();

kf.update({target.x, target.y});

Target predicted = {kf.statePost[0], kf.statePost[1], kf.statePost[2], kf.statePost[3]};

// 4. 自适应跟随控制

adaptiveFollow(predicted);

} else {

stopMotors();

}

delay(100);

}

// 自适应跟随:根据目标速度调整机器人速度

void adaptiveFollow(Target& t) {

// 计算与目标的距离

float distance = sqrt(pow(t.x, 2) + pow(t.y, 2));

// 根据距离调整线速度(保持1m距离)

float desiredSpeed = map(distance, 0.5, 2, 0.2, 1.0);

// 根据目标速度调整(人走得快→机器人加速)

desiredSpeed += sqrt(pow(t.vx, 2) + pow(t.vy, 2)) * 0.5;

// 计算目标角度(机器人朝向目标)

float desiredTheta = atan2(t.y, t.x);

float errorTheta = normalizeAngle(desiredTheta - currentRobotTheta);

// 转换为左右轮速度

float leftSpeed = (desiredSpeed - errorTheta * ROBOT_WIDTH / 2) / WHEEL_RADIUS;

float rightSpeed = (desiredSpeed + errorTheta * ROBOT_WIDTH / 2) / WHEEL_RADIUS;

// PID控制电机

leftPID.SetSetpoint(leftSpeed);

rightPID.SetSetpoint(rightSpeed);

setMotorSpeed(leftPID.GetOutput(), rightPID.GetOutput());

}

// 解析OpenMV视觉数据(JSON格式示例:"{x:100,y:200,w:50,h:100}")

VisionData parseVisionData(String data) {

VisionData result;

result.valid = false;

int x = data.indexOf('x');

int y = data.indexOf('y');

if (x != -1 && y != -1) {

result.centerX = data.substring(x+2, data.indexOf(',', x)).toInt();

result.centerY = data.substring(y+2, data.indexOf(',', y)).toInt();

result.valid = true;

}

return result;

}

// 解析雷达数据(JSON格式示例:"{d:1.5,v:0.2,a:30}")

RadarData parseRadarData(String data) {

RadarData result;

int d = data.indexOf('d');

int v = data.indexOf('v');

if (d != -1 && v != -1) {

result.x = data.substring(d+2, data.indexOf(',', d)).toFloat() * cos(radians(30));

result.y = data.substring(d+2, data.indexOf(',', d)).toFloat() * sin(radians(30));

result.vx = data.substring(v+2, data.indexOf(',', v)).toFloat() * cos(radians(30));

result.vy = data.substring(v+2, data.indexOf(',', v)).toFloat() * sin(radians(30));

}

return result;

}

要点解读

- 多传感器的角色分工:互补而非替代

不同传感器在动态避障中承担不同角色,需融合优势:

视觉传感器(OpenMV):擅长目标分类(区分人和物体),但受光照影响大、测距精度低;

毫米波雷达(MR60B):擅长精确测距/测速(不受光照影响),但无法区分目标类型;

激光雷达(RPLiDAR):擅长环境建模(生成360°点云地图),但成本高、体积大;

超声波/红外:成本低、适合近距离检测,但范围小、易受干扰。

案例对应:案例3用视觉识别“人”,雷达测“距离/速度”,实现“精准跟人”;案例2用激光雷达建图,解决“全局定位”。

- 传感器数据融合:提升定位精度

单一传感器的定位误差会累积(如里程计漂移),需通过数据融合算法(如卡尔曼滤波、扩展卡尔曼滤波EKF)结合多源数据,得到更准确的状态估计:

卡尔曼滤波(KF):适用于线性系统、高斯噪声(如案例2中的里程计+激光雷达融合);

扩展卡尔曼滤波(EKF):适用于非线性系统(如机器人的非直线运动);

粒子滤波(PF):适用于非高斯噪声、动态环境(如复杂场景的目标跟踪)。

注意:融合前需对传感器进行时间同步(确保数据在同一时间戳)和空间校准(如雷达与相机的安装偏移)。

- 动态避障的实时性:算法选择与优化

服务机器人需应对移动障碍物(如行人、宠物),要求避障算法低延迟、高可靠性:

传统算法:人工势场法(APF)——简单快速,但易陷入局部最优;适用于入门级场景(案例1);

机器学习算法:YOLO Tiny(轻量化目标检测)、Deep Q-Network(DQN,强化学习)——能处理复杂场景,但计算量大,需用Arduino Mega/Due等高性能单片机或边缘计算设备;

规则引擎:状态机+阈值判断——适合简单场景(如案例1的“跟随/避障/停机”模式切换)。

优化技巧:降低传感器采样频率(如案例1的100ms一次)、简化算法模型(如案例3的YOLO Tiny)、并行处理(如用Arduino Mega的多个硬件串口同时处理传感器数据)。

- 运动控制的平稳性:差速驱动与PID调节

服务机器人需平稳移动(避免碰撞或惊吓用户),差速驱动的控制策略需配合双PID环(位置环+速度环):

位置环:外层环,负责跟踪目标位置(如案例3中的人体坐标),输出速度给定值;

速度环:内层环,负责跟踪电机的实际转速(如编码器反馈),输出PWM占空比;

差速转向:通过左右轮速度差实现转向(如左转时右轮速度快于左轮),比舵机转向更灵活。

调参技巧:先调速度环(确保转速稳定),再调位置环(确保轨迹跟踪准确);加入加速度限制(如速度变化率≤0.5m/s²),避免急启急停。

- 安全与鲁棒性:防止误操作与故障

服务机器人需在家庭/公共场所运行,必须具备多层安全机制:

硬件保护:电机过流保护(INA219检测电流)、电源过压保护(TVS二极管)、紧急停止按钮;

软件容错:传感器失效时的 fallback 策略(如视觉失效→切换到雷达跟踪)、PID参数自适应(如负载增加时自动增大Kp);

行为约束:限制机器人的最大速度(如≤1m/s)、避障时的最小距离(如≥0.3m)、夜间运行时的灯光提示。

案例对应:案例1加入了“距离阈值”(<0.3m停机),案例3加入了“目标丢失处理”(无人时停止跟随)。

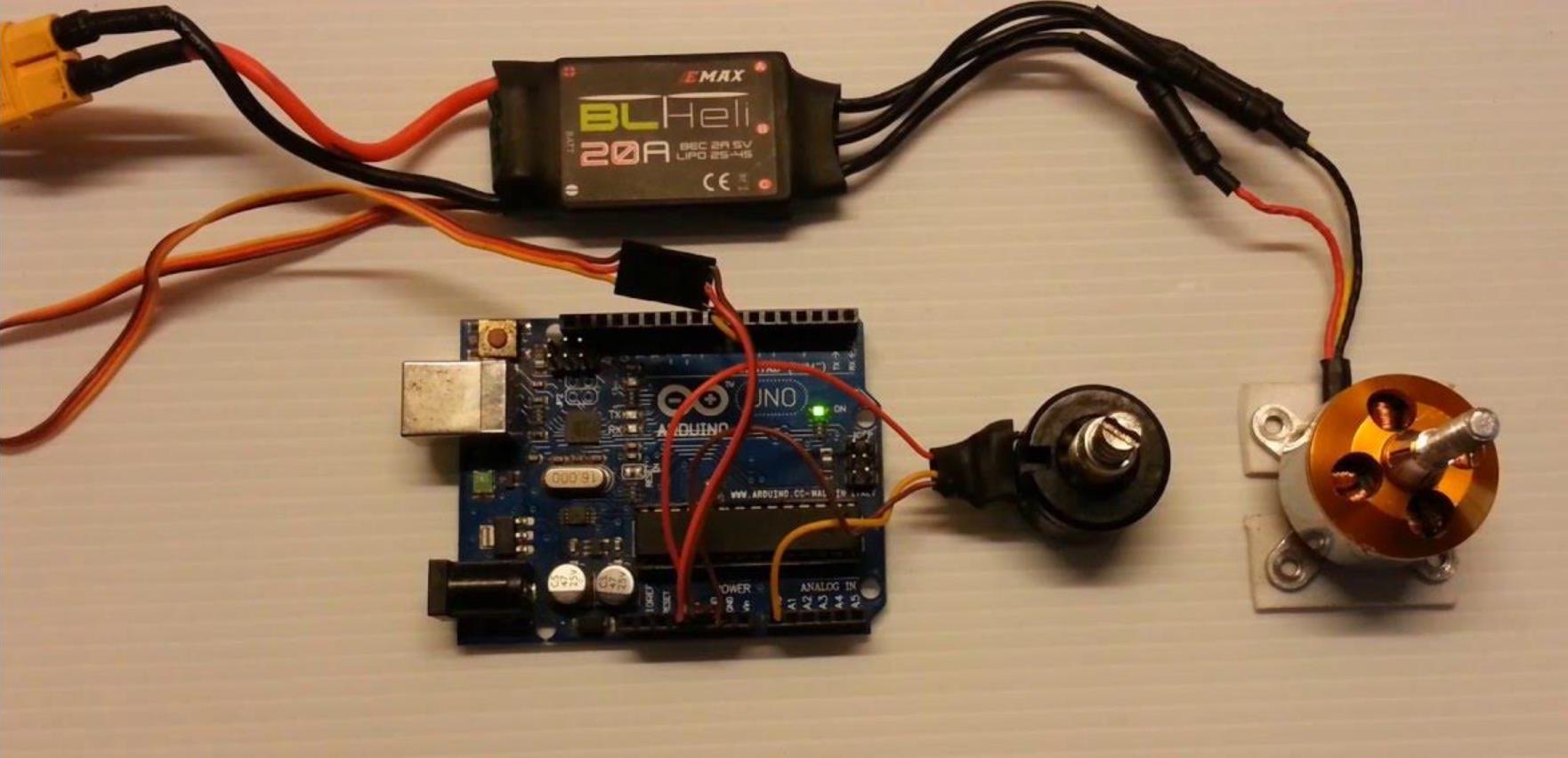

4、超声波+红外融合避障(低成本方案)

#include <NewPing.h>

#include <Servo.h>

// 传感器定义

#define TRIG_PIN 12

#define ECHO_PIN 11

#define IR_PIN A0

#define MAX_DISTANCE 200 // 超声波最大距离(cm)

// 电机控制

#define ESC_PIN 9

Servo esc;

int motorSpeed = 1500; // 中立值

// 传感器融合参数

float obstacleWeight = 0.7; // 超声波权重

float cliffWeight = 0.3; // 红外权重

NewPing sonar(TRIG_PIN, ECHO_PIN, MAX_DISTANCE);

void setup() {

Serial.begin(115200);

esc.attach(ESC_PIN);

esc.writeMicroseconds(1000); // 初始化

delay(3000);

}

void loop() {

// 超声波测距(前方障碍)

unsigned int uS = sonar.ping();

float sonarDist = uS / US_ROUNDTRIP_CM;

// 红外测距(悬崖/低矮障碍)

int irValue = analogRead(IR_PIN);

float irDist = map(irValue, 0, 1023, 10, 80); // 需校准

// 多传感器融合决策

float compositeRisk = obstacleWeight * (1 - constrain(sonarDist/50, 0, 1)) +

cliffWeight * (irDist > 30 ? 0 : 1);

// 动态速度调整(危险时减速)

motorSpeed = 1500 - compositeRisk * 400;

motorSpeed = constrain(motorSpeed, 1100, 1900);

esc.writeMicroseconds(motorSpeed);

Serial.print("Sonar:"); Serial.print(sonarDist);

Serial.print(" IR:"); Serial.print(irDist);

Serial.print(" Speed:"); Serial.println(motorSpeed);

delay(50);

}

5、激光雷达+IMU融合跟随(高精度方案)

#include <Servo.h>

#include <Wire.h>

#include <MPU6050_light.h> // IMU库

// 传感器定义

#define LIDAR_PIN A1 // 模拟激光雷达(简化模拟)

#define ESC_PIN 9

#define SERVO_PIN 10 // 转向舵机

// 控制参数

float targetDistance = 1.0; // 目标跟随距离(m)

float maxSpeed = 1800; // 最大PWM

float minSpeed = 1200; // 最小PWM

Servo esc;

Servo steeringServo;

MPU6050 mpu(Wire);

void setup() {

Serial.begin(115200);

Wire.begin();

mpu.begin();

mpu.calcOffsets(); // IMU校准

esc.attach(ESC_PIN);

steeringServo.attach(SERVO_PIN);

esc.writeMicroseconds(1000);

delay(3000);

}

void loop() {

// 模拟激光雷达数据(实际需用I2C/UART雷达)

float lidarDist = analogRead(LIDAR_PIN) * 3.0 / 1024; // 0-3m模拟

// IMU数据融合(补偿机器人倾斜)

mpu.update();

float tiltAngle = mpu.getAngleY();

float compensatedDist = lidarDist * cos(tiltAngle * PI / 180);

// 跟随控制(PID简化版)

float error = targetDistance - compensatedDist;

float speed = constrain(1500 + error * 300, minSpeed, maxSpeed);

// 转向控制(模拟目标在右侧)

float steerAngle = constrain(error * 5, -30, 30);

esc.writeMicroseconds(speed);

steeringServo.write(90 + steerAngle); // 90°为中立

Serial.print("Dist:"); Serial.print(compensatedDist);

Serial.print(" Speed:"); Serial.print(speed);

Serial.print(" Steer:"); Serial.println(steerAngle);

delay(100);

}

5、视觉+TOF多模态避障(智能跟随)

#include <Servo.h>

#include <VL53L0X.h> // TOF激光测距库

// 传感器定义

#define TOF_PIN A2 // 模拟输入(实际需I2C)

#define ESC_PIN 9

#define CAMERA_PIN 2 // 模拟视觉信号(简化)

// 控制参数

float safeDistance = 0.8; // 安全距离(m)

float avoidGain = 0.6; // 避障权重

float followGain = 0.4; // 跟随权重

Servo esc;

VL53L0X tofSensor;

void setup() {

Serial.begin(115200);

Wire.begin();

// TOF传感器初始化(实际需I2C地址配置)

tofSensor.init();

tofSensor.setTimeout(500);

tofSensor.startContinuous();

esc.attach(ESC_PIN);

esc.writeMicroseconds(1000);

delay(3000);

}

void loop() {

// 模拟视觉信号(0=无目标,1=左侧,2=右侧)

int visionSignal = digitalRead(CAMERA_PIN);

// TOF测距(前方)

float tofDist = tofSensor.readRangeContinuousMillimeters() / 1000.0;

// 多模态决策

float riskFactor = 0;

if (tofDist < safeDistance * 1.5) {

riskFactor = avoidGain * (1 - tofDist / (safeDistance * 1.5));

}

// 跟随优先级(检测到目标时)

float followFactor = (visionSignal > 0) ? followGain : 0;

// 动态速度计算

float baseSpeed = 1500;

if (riskFactor > 0.3) {

baseSpeed = 1200; // 紧急制动

} else if (followFactor > 0) {

baseSpeed = 1600 + (visionSignal == 1 ? 100 : -100); // 差速转向

}

esc.writeMicroseconds(constrain(baseSpeed, 1100, 1900));

Serial.print("TOF:"); Serial.print(tofDist);

Serial.print(" Risk:"); Serial.print(riskFactor);

Serial.print(" Speed:"); Serial.println(baseSpeed);

delay(50);

}

要点解读

传感器时空对齐

不同传感器采样频率不同(如IMU 100Hz vs 激光雷达 10Hz),需通过时间戳同步或滑动窗口对齐

空间坐标系转换:激光雷达/摄像头数据需转换到机器人本体坐标系(使用齐次变换矩阵)

数据融合策略

加权融合:根据传感器可靠性动态调整权重(如雨天降低摄像头权重)

卡尔曼滤波:用于融合速度+位置信息(案例5中的IMU补偿)

冲突解决:当多个传感器发出矛盾指令时(如TOF检测到障碍但视觉认为安全),需设计仲裁机制

动态响应优化

分层控制:紧急避障(硬实时)优先级高于跟随控制(软实时)

速度规划:采用S型曲线代替阶跃变化,避免机械冲击

预测控制:利用历史数据预测障碍物运动轨迹(案例6可扩展)

安全机制设计

硬件看门狗:监控主循环执行时间,超时自动停机

传感器冗余:关键场景需双传感器验证(如主激光雷达+超声波)

失效保护:当通信中断时进入跛行模式(低速直行)

性能调优技巧

传感器布局:避免相互干扰(如超声波与电机保持30cm距离)

滤波参数:根据场景调整(室内低通滤波截止频率5Hz,室外1Hz)

计算负载:在Arduino Mega上建议控制循环≤10ms,复杂算法移植至STM32

注意,以上案例只是为了拓展思路,仅供参考。它们可能有错误、不适用或者无法编译。您的硬件平台、使用场景和Arduino版本可能影响使用方法的选择。实际编程时,您要根据自己的硬件配置、使用场景和具体需求进行调整,并多次实际测试。您还要正确连接硬件,了解所用传感器和设备的规范和特性。涉及硬件操作的代码,您要在使用前确认引脚和电平等参数的正确性和安全性。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)