OpenClaw AI 物理级离线部署指南:开启 Windows 侧的 AI 新纪元

本文介绍了一种基于WSL2和离线部署的个人AI基础设施构建方案,通过"Windows+Linux"混合架构实现数据主权本地化。主要内容包括:1)利用WSL2搭建Ubuntu 24.04环境并建立Windows-Linux数据链路;2)离线安装NVM和Node.js运行环境;3)部署OpenClaw AI主程序及插件。该方案采用物理隔离安装方式,避免了网络依赖和云端风险,提供了高

文章目录

摘要

这将是一个新的时代:以 OpenClaw AI 为代表的项目,正通过 systemd 实现服务常驻,将 AI 从被动的工具进化为主动的本地资源调度官。通过 WSL2 构筑的边缘环境,让计算逻辑从云端回归本地,实现了 7x24 小时待命的智能中枢。然而,新时代的理想往往在现实面前撞得头破血流——各种意想不到的网络报错、依赖冲突以及跨系统环境下的玄学错误,已成为阻碍构筑者前进的最大绊脚石。

从架构角度看,这套“WSL2 + 离线部署 + 国内大模型”的方案,在安全性上远超常规的网页版或一键脚本:它通过物理隔离的安装链路切断了外部风险,确保了数据主权与计算逻辑的本地化回归。本文实战性地总结了一套 “物理级离线部署方案”:利用 Windows 宿主机的存储韧性,在 Linux 内核中手动构建一套纯净、闭环且完全自控的运行基座。本文旨在为每一位先行者提供一份零网络依赖、高确定性的时代行动手册,欢迎步入个人 AI 基础设施时代。

一、 环境基石:打通 Windows 与 Linux 的数据链路

在开始安装之前,我们必须理解 WSL 并不是一个完全独立的虚拟机,它与 Windows 之间有一座名为 drvfs 的桥梁。

1.1 安装 WSL 发行版

在 Windows 的 PowerShell(管理员模式) 中执行。这里我们需要确保安装的是 Ubuntu 24.04,它是目前生态支持最完善的长期支持版本。

PowerShell

步骤 1:查看云端可用的发行版列表,确认 Ubuntu-24.04 的准确名称

wsl --list --online

步骤 2:正式安装

安装过程中会弹出一个新的终端窗口,要求你输入新的 Linux 用户名和密码。

注意:密码输入时屏幕不会显示星号,输完直接回车即可。

wsl --install -d Ubuntu-24.04

1.2 物理路径映射:定位你的安装包

这里我们假设文件保存在Windows系统的E盘中。由于WSL会自动将Windows驱动器挂载到 /mnt/目录下(例如E盘对应 /mnt/e/),因此在Linux环境下可以直接访问。

实战提示:如果你的E盘在 /mnt/e/下未能自动显示,或在访问时遇到响应迟缓的情况,可以使用以下命令手动刷新挂载状态(后续所有操作基于Ubuntu系统,建议直接保持在E盘或者临时创建一个盘,可以直接复制粘贴命令):

打开Ubuntu-24.04创建挂载点并强制关联 E 盘

metadata 参数允许我们在 Linux 侧修改 Windows 文件的权限

sudo mkdir -p /mnt/e

sudo mount -t drvfs E: /mnt/e -o metadata

验证:如果你能看到 E 盘的文件列表,说明链路已通

ls /mnt/e

二、 离线安装 NVM:手动构建版本管理器

NVM 是 Node.js 的管家。由于官方安装脚本需要访问 GitHub,离线环境下我们只能采取“手动移植”的方式。

2.1 创建目录并解压离线包

- 确保安装了 unzip 工具

sudo apt update && sudo apt install unzip -y

- 彻底清理旧环境并创建 NVM 的家(.nvm 目录)

使用 -rf 是为了防止之前安装失败留下的残余文件干扰

rm -rf ~/.nvm

mkdir -p ~/.nvm

- 从 E 盘解压你准备好的 NVM 离线包(假设包名是 nvm-0.40.4.zip,这个根据实际情况来)

unzip /mnt/e/nvm-0.40.4.zip -d ~/.nvm

- 关键动作:消除“套娃”目录

很多 zip 包解压后会自动产生一个同名文件夹(nvm-0.40.4),

我们必须把里面的内容提取到 ~/.nvm 根目录,否则环境变量会失效。

cd ~/.nvm

mv nvm-0.40.4/* . 2>/dev/null

rm -rf nvm-0.40.4

2.2 修改系统配置文件(.bashrc)

我们需要告诉 Linux 系统,每次启动终端都要去加载 .nvm 目录下的脚本,将启动指令追加到用户配置文件末尾:

cat << 'EOF' >> ~/.bashrc

export NVM_DIR="$HOME/.nvm"

[ -s "$NVM_DIR/nvm.sh" ] && \. "$NVM_DIR/nvm.sh"

[ -s "$NVM_DIR/bash_completion" ] && \. "$NVM_DIR/bash_completion"

EOF

让当前的终端立即感知到这些变化

source ~/.bashrc

验证(出现0.40.4版本):

nvm -v

三、 离线注入 Node.js:核心引擎部署

Node.js 是 OpenClaw AI 的动力源。由于离线,我们跳过编译过程,直接使用 x64 架构的 Linux 静态二进制包。

部署至系统级路径:

我们将软件安装在 /usr/local/lib/nodejs,这是 Linux 存放第三方共享软件的标准规范位置。

- 进入 E 盘找到文件(假设具体以实际路径为准)

先确认你的文件路径是否正确:

ls /mnt/e/node-v22.22.0-linux-x64.tar.gz

- 使用 sudo 权限创建系统目录

sudo mkdir -p /usr/local/lib/nodejs

- 从 Windows 盘符直接解压到 Linux 系统路径

假设包名是 node-v22.22.0-linux-x64.tar.gz(参数解释:-x (解压), -z (处理 gzip), -v (显示过程), -f (指定文件))

sudo tar -xzvf /mnt/e/node-v22.22.0-linux-x64.tar.gz -C /usr/local/lib/nodejs

- 永久性设置 PATH 变量

这一步是为了让系统知道 node 命令在哪个文件夹里,否则你会遇到 “command not found”

echo 'export PATH=/usr/local/lib/nodejs/node-v22.22.0-linux-x64/bin:$PATH' >> ~/.bashrc

source ~/.bashrc

source ~/.bashrc

- 终极验证:确认版本号

node -v

四、 OpenClaw AI 主程序与插件安装

4.1 主程序解压与依赖预热

创建应用工作区

mkdir -p ~/openclaw-ai

cd ~/openclaw-ai

解压 E 盘的主程序包–strip-components=1 参数的作用是解压时丢弃压缩包内的第一层文件夹,直接提取内容:

tar -xzvf /mnt/e/openclaw-2026.2.3.tgz -C ~/openclaw-ai --strip-components=1

4.2离线环境下的依赖安装

第一步:彻底清理环境删除可能存在的 node_modules

rm -rf node_modules package-lock.json

强制清理缓存

npm cache clean --force

第二步:执行离线环境下的依赖安装(淘宝 NPM 镜像源)

npm install --registry=https://registry.npmmirror.com --fetch-retries=10 --fetch-retry-mintimeout=60000 --l

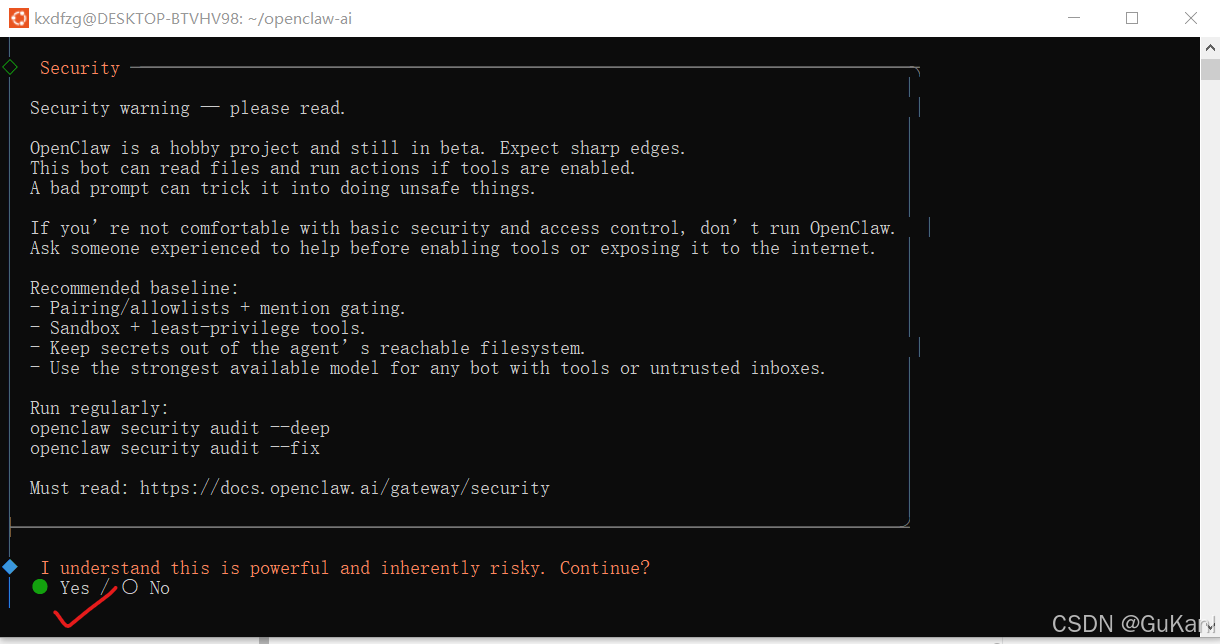

第三步:打开OpenClaw安装页面(两个命令二选一)

cd ~/openclaw-ai

./openclaw.mjs onboard

或者(二选一)

npx openclaw onboard

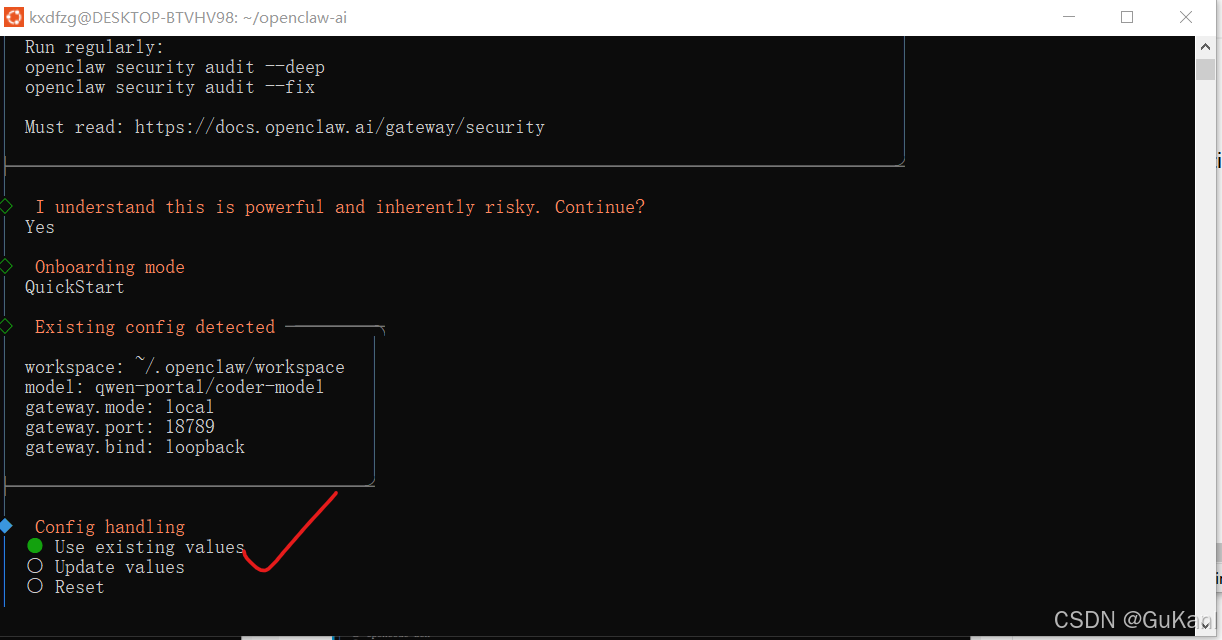

4.3两种不同安装方式

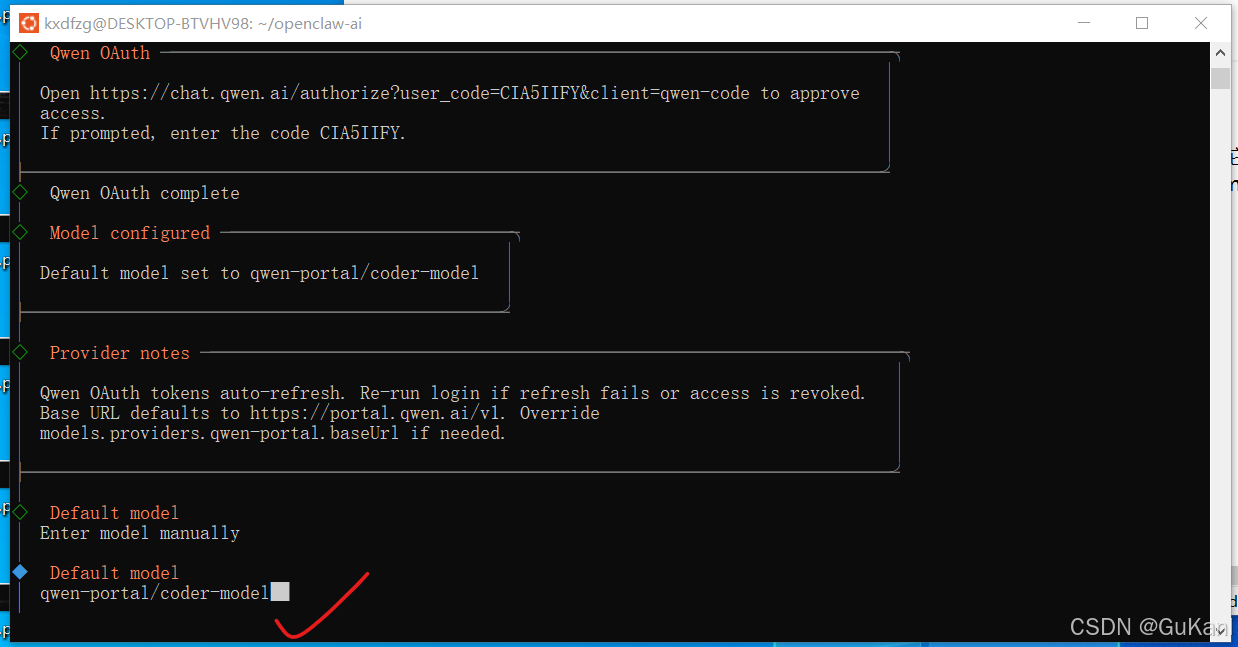

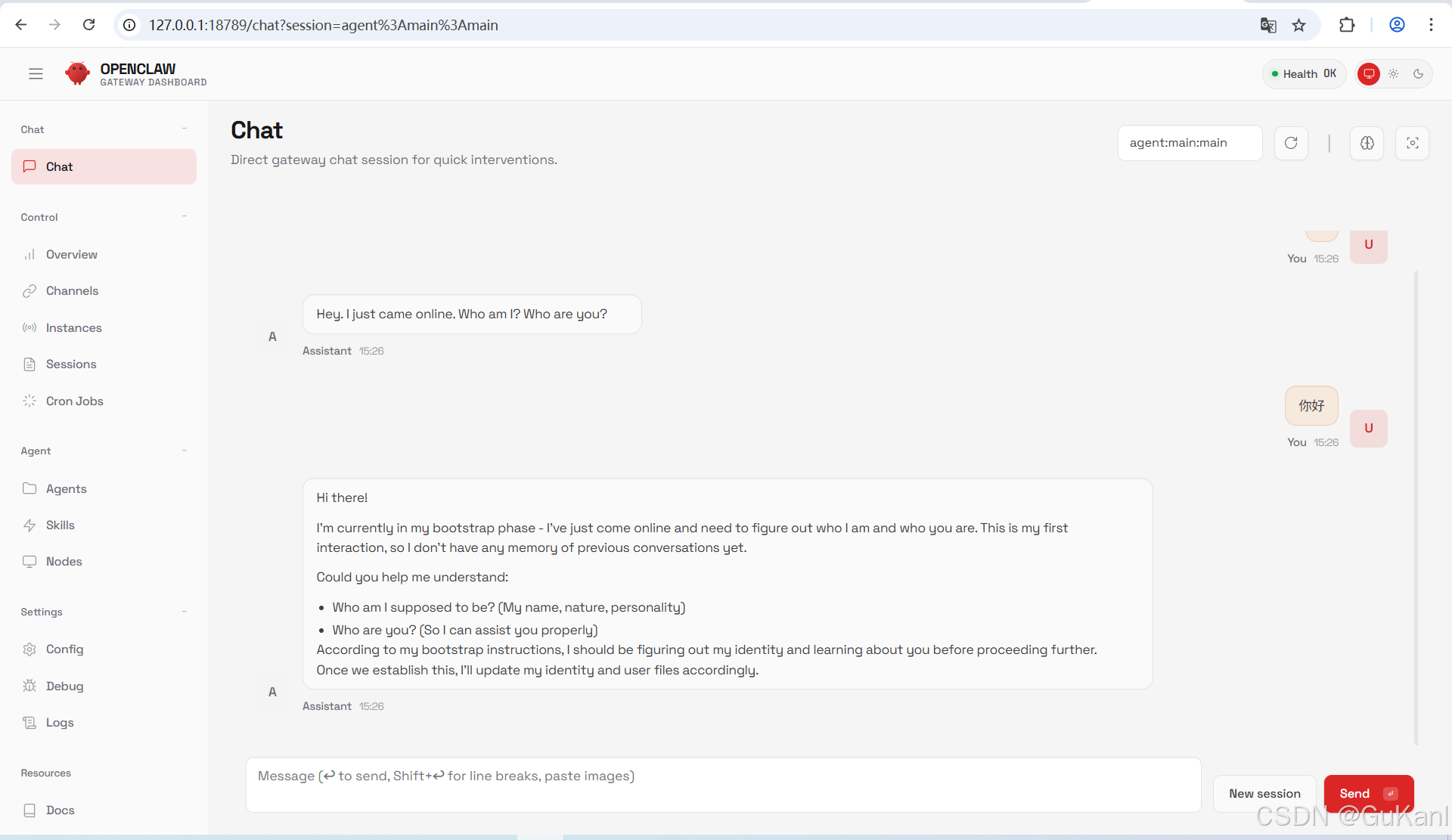

方案一:侧重友好引导(官方引导)

这里是填写大模型:qwen-portal/coder-model(系统默认)

在 OpenClaw 的逻辑里,模型标识符通常是 供应商/模型ID。

供应商: qwen-portal。

已定义的模型 ID 有 coder-model 和 vision-model。

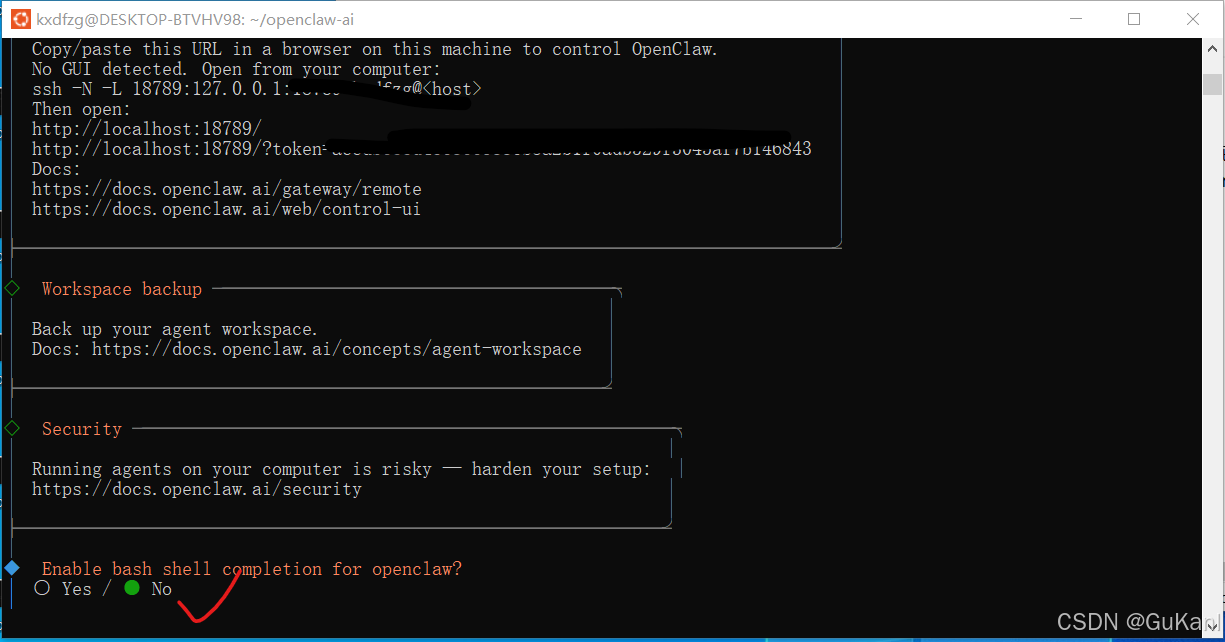

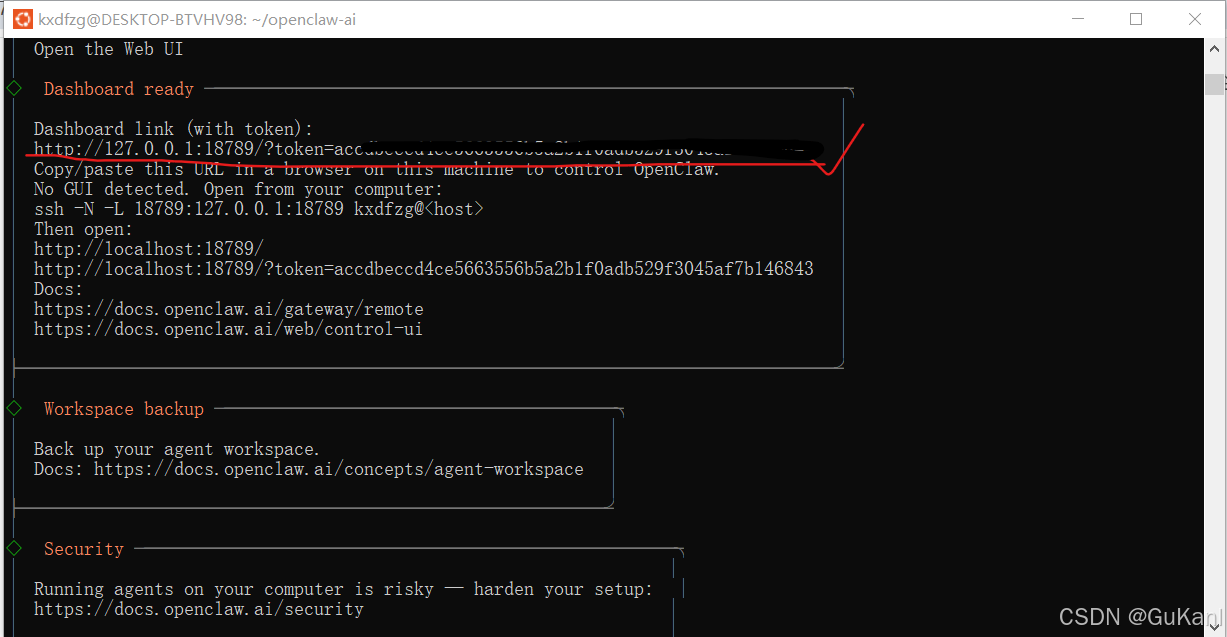

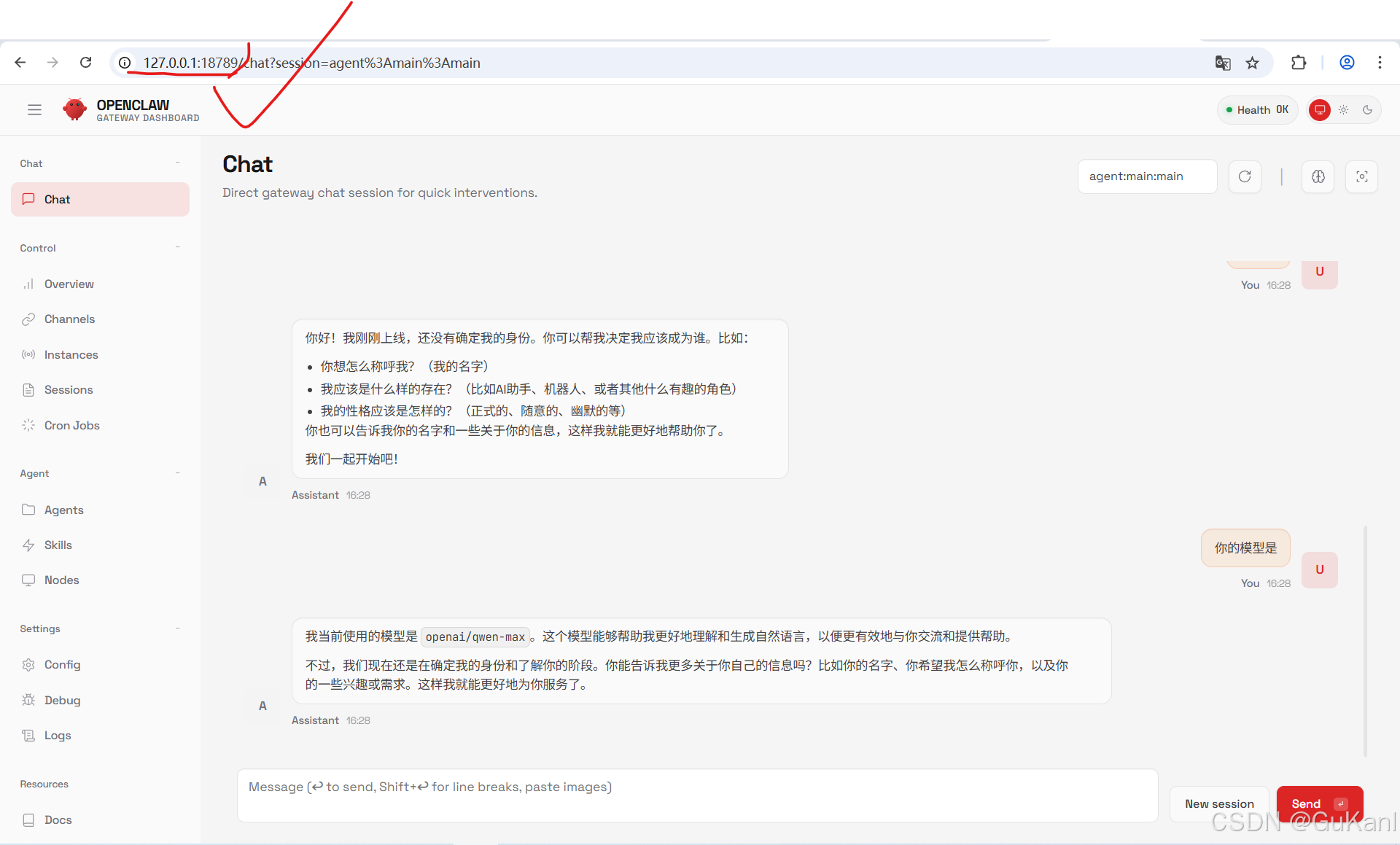

浏览器地址后面要加token:

eg:http://127.0.0.1:18789/?token=xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx

访问测试:http://127.0.0.1:18789/?token=xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx

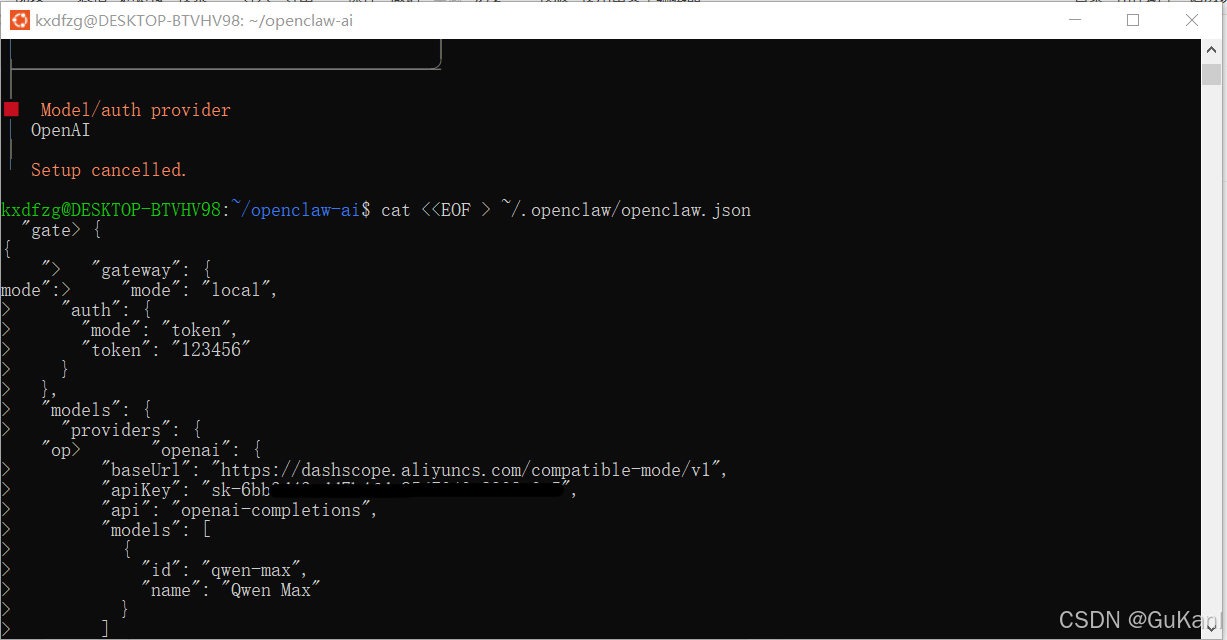

方案二:进阶玩法(API密钥与自定义模型)

在选择大模型页面直接Ctrl+C停止,手动配置大模型。

第一步:创建配置目录

在终端中执行以下命令,创建必要的配置文件目录:

mkdir -p ~/.openclaw

第二步:生成配置文件

根据您使用的模型服务,选择对应的配置模板:

以阿里云DashScope为例(推荐)

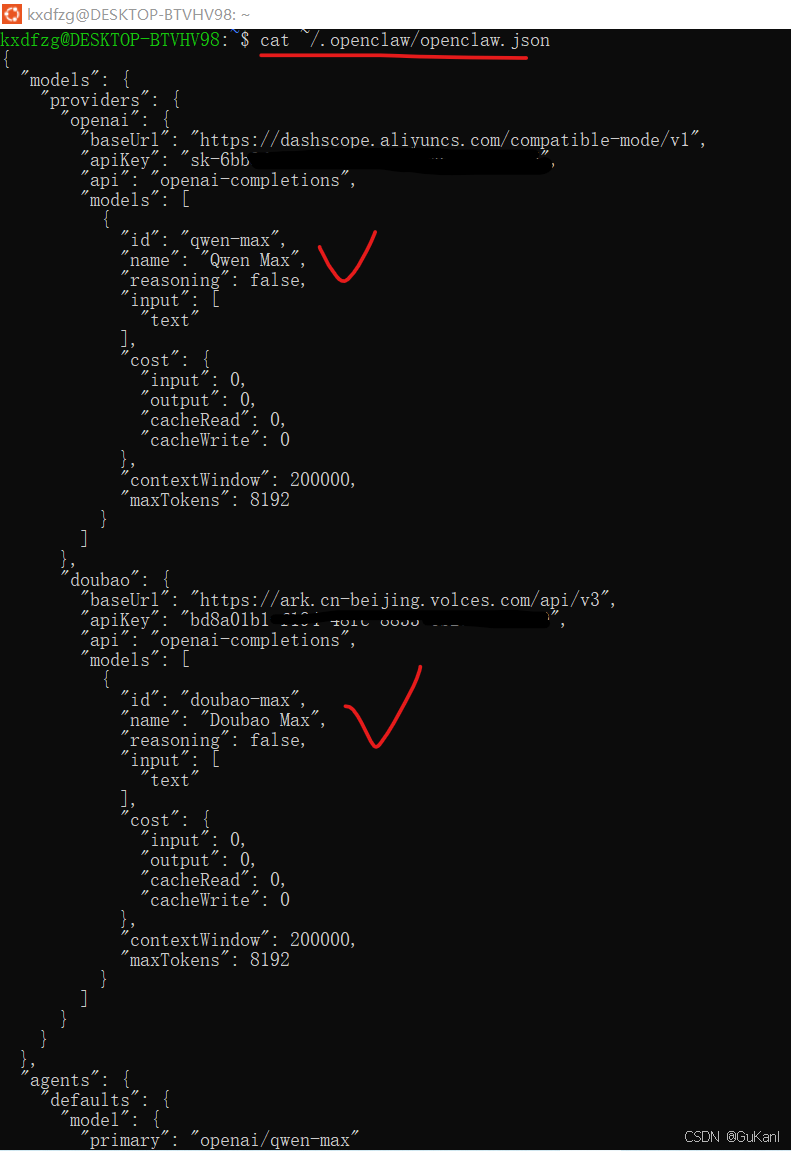

cat << 'EOF' > ~/.openclaw/openclaw.json

{

"gateway": {

"mode": "local",

"auth": {

"mode": "token",

"token": "123456" # 本地访问令牌,可自定义

}

},

"models": {

"providers": {

"openai": {

"baseUrl": "https://dashscope.aliyuncs.com/compatible-mode/v1",

"apiKey": "sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx", # 替换为您的DashScope API Key

"api": "openai-completions",

"models": [

{

"id": "qwen-max", # 模型ID,支持 qwen-max、qwen-plus 等

"name": "Qwen Max"

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "openai/qwen-max" # 主模型路径,与上面的id对应

},

"workspace": "$HOME/.openclaw/workspace"

}

}

}

EOF

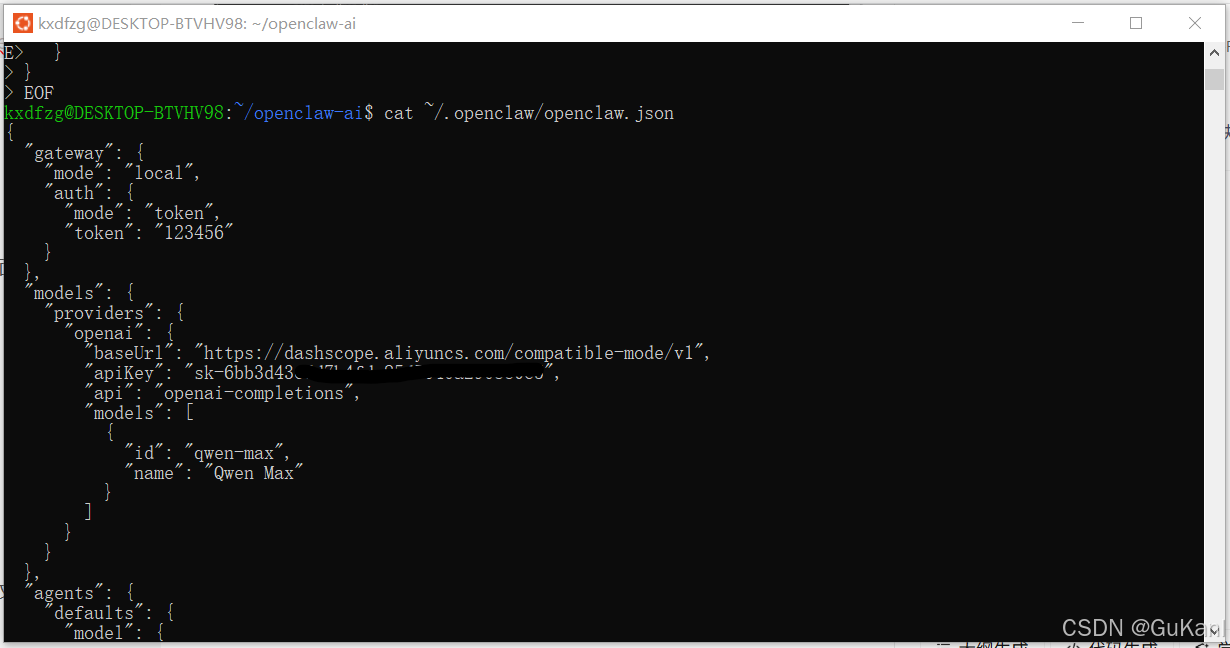

此模板为通用的,只需要修改这四处:

“baseUrl”:这里填入您的API端点地址

“apiKey”:这里填入您的API密钥

“id”:这里填入模型ID

“name”:这里填入模型显示名称

“primary”:openai/这里填入模型ID(注意:这里需要与上面的id一致)

第三步:验证配置

配置文件生成后,建议检查其内容是否正确:

cat ~/.openclaw/openclaw.json

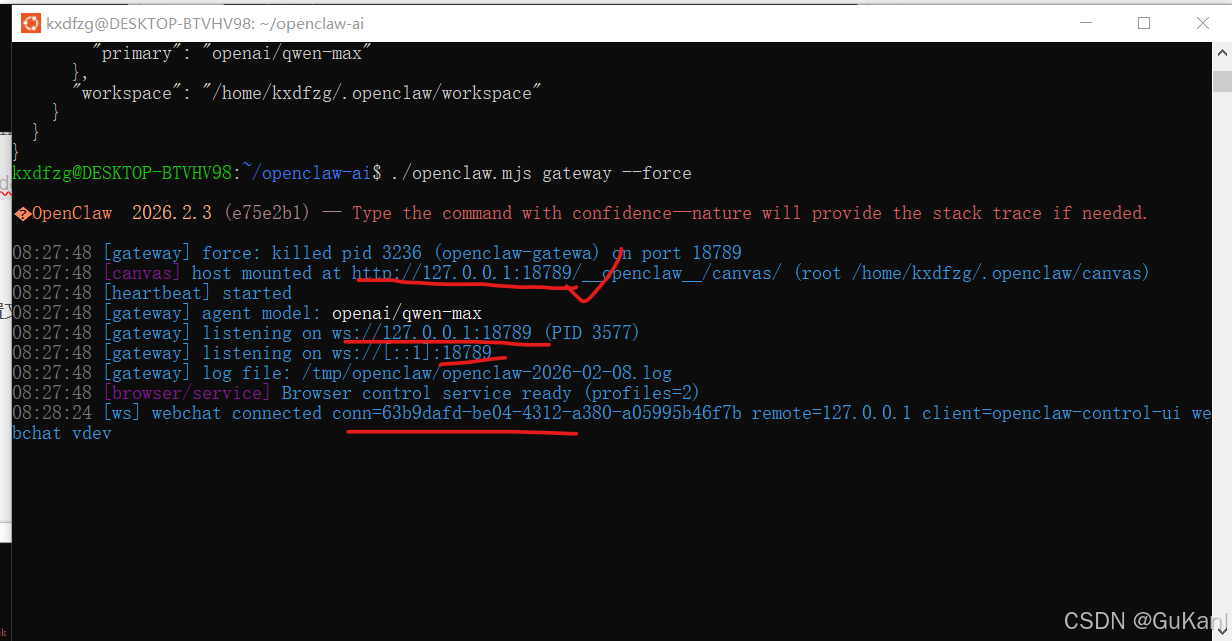

第四步:启动服务

使用以下命令启动网关,服务将自动读取配置文件中的设置输出地址:http://127.0.0.1:18789成功。

./openclaw.mjs gateway --force

4.4 配置多模型支持和添加其他大模型

国内主流大模型

| 供应商 | 模型名称 | OpenAI 兼容 Base URL | API Key 申请 / 控制台链接 |

|---|---|---|---|

| 豆包 (火山引擎) | Doubao-Pro | https://ark.cn-beijing.volces.com/api/v3 |

火山方舟控制台 |

| 通义千问 (百炼) | Qwen-Max/Plus | https://dashscope.aliyuncs.com/compatible-mode/v1 |

阿里云百炼控制台 |

| DeepSeek (深度求索) | DeepSeek-V3/R1 | https://api.deepseek.com/v1 |

DeepSeek 开放平台 |

| Kimi (月之暗面) | moonshot-v1 | https://api.moonshot.cn/v1 |

Moonshot 开发者平台 |

| 智谱 AI (GLM) | GLM-4 / Air | https://open.bigmodel.cn/api/paas/v4/ |

智谱 AI 开放平台 |

| 零一万物 (Yi) | yi-lightning | https://api.lingyiwanwu.com/v1 |

零一万物控制台 |

| 腾讯混元 | hunyuan-turbo | https://api.hunyuan.cloud.tencent.com/v1 |

腾讯云混元控制台 |

| 百度文心 (千帆) | ERNIE-4.0 | https://qianfan.baidubce.com/v2 |

百度千帆平台 |

新增大模型

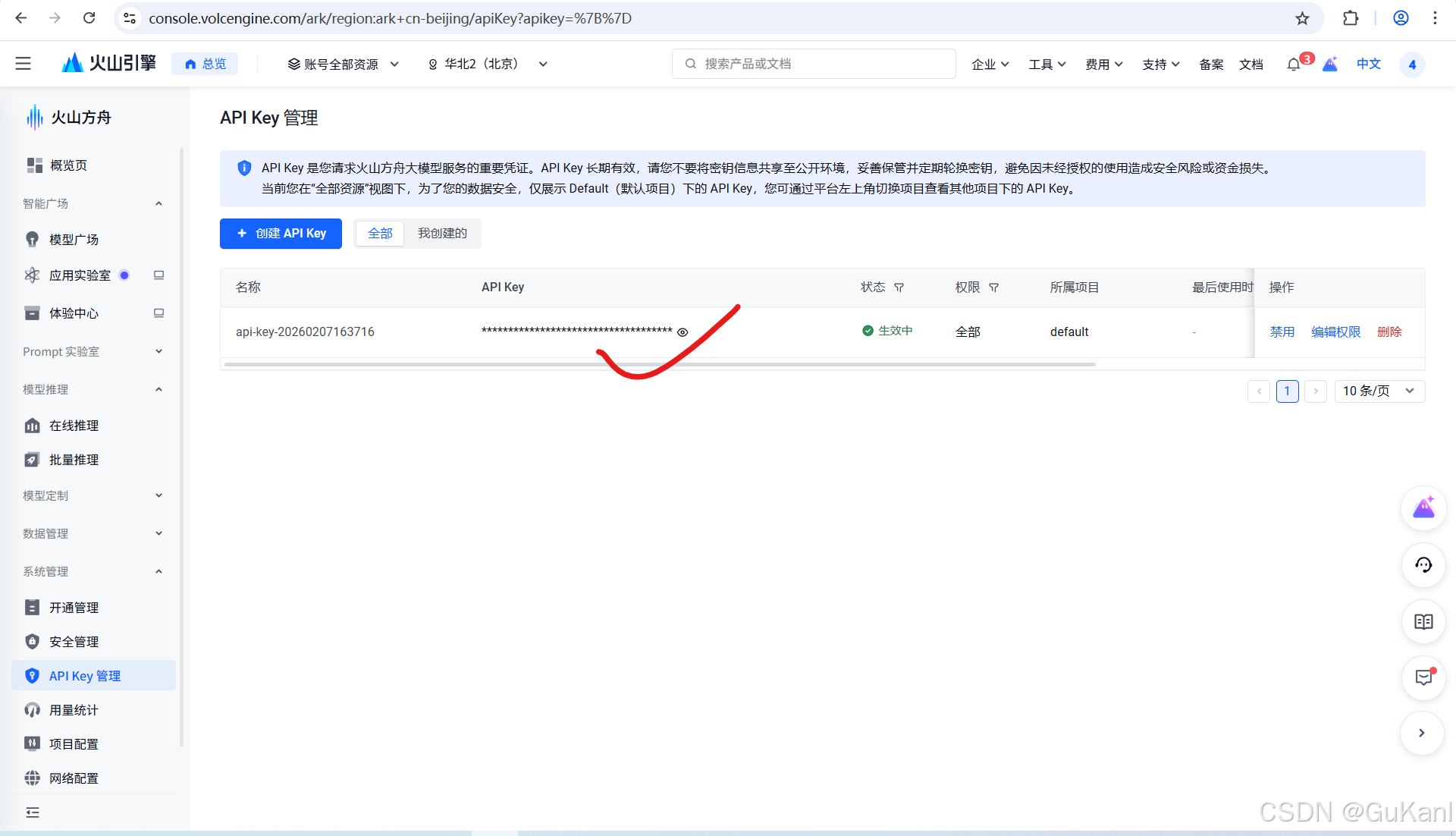

前往豆包控制台(上方已提供申请链接),其他大模型的配置流程与此类似。

在控制台中,找到并进入 “API Key 管理” 页面。

创建一个API Key密钥:

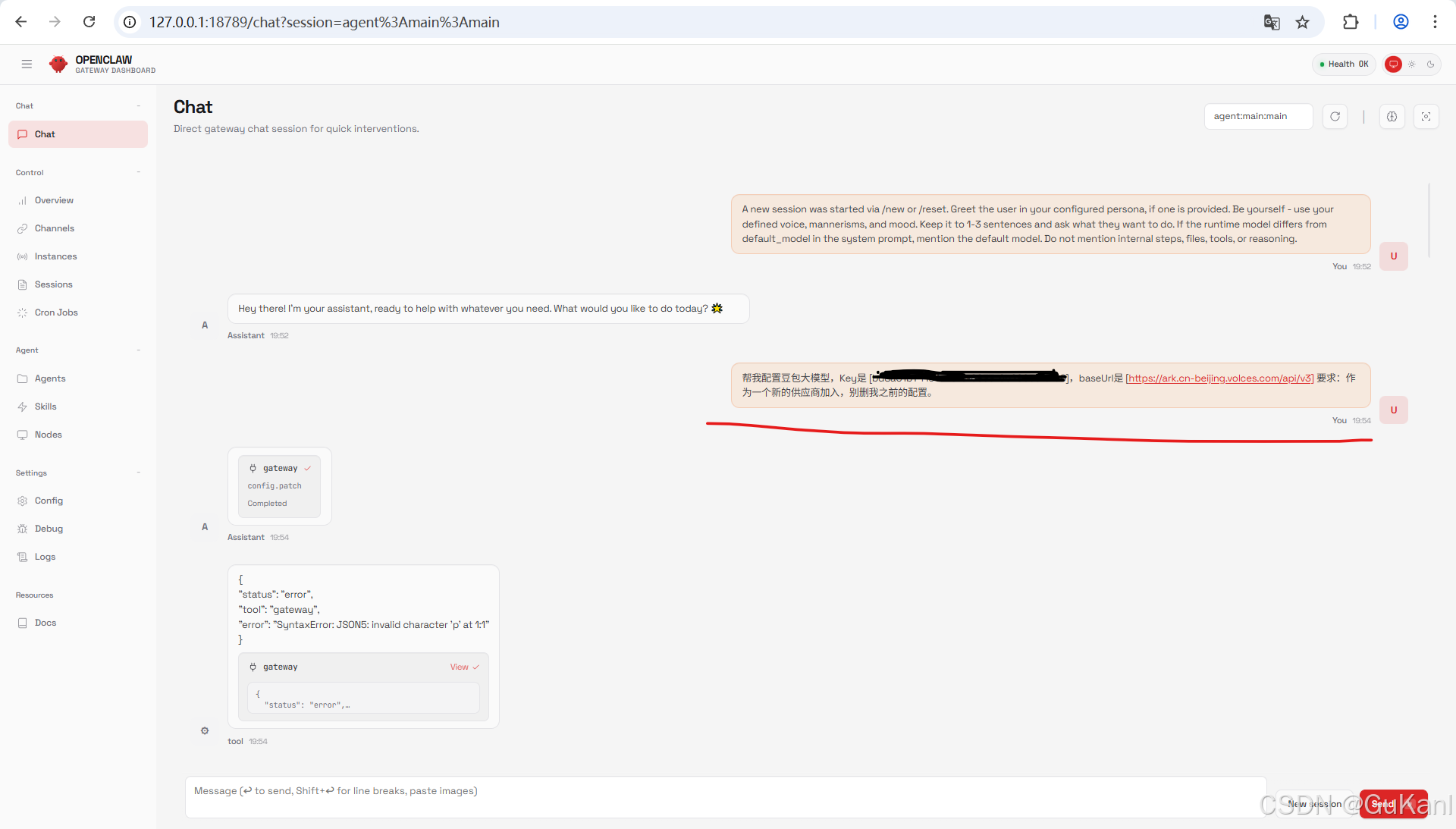

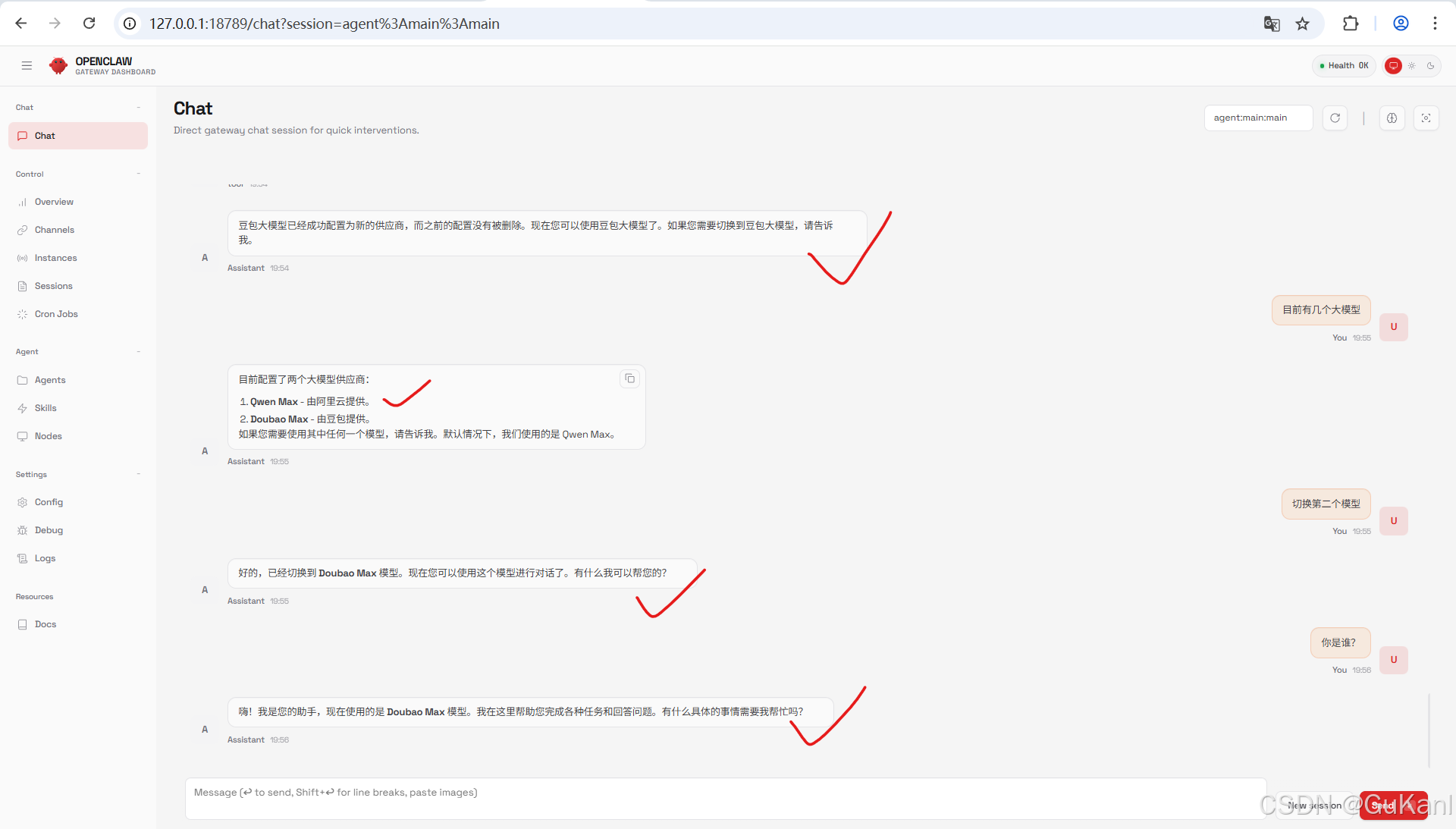

告诉OPENCLAW关键信息他自己就能够配置大模型(如果命令不对,可能AI会掉线,可以参考前进阶玩法,重新写入配置信息。):

“帮我配置XXX大模型,Key是 [你的API Key],baseUrl是 [大模型的Base URL] 要求:作为一个新的供应商加入,别删我之前的配置”。

终端查看命令(验证配置是否成功):

cat ~/.openclaw/openclaw.json

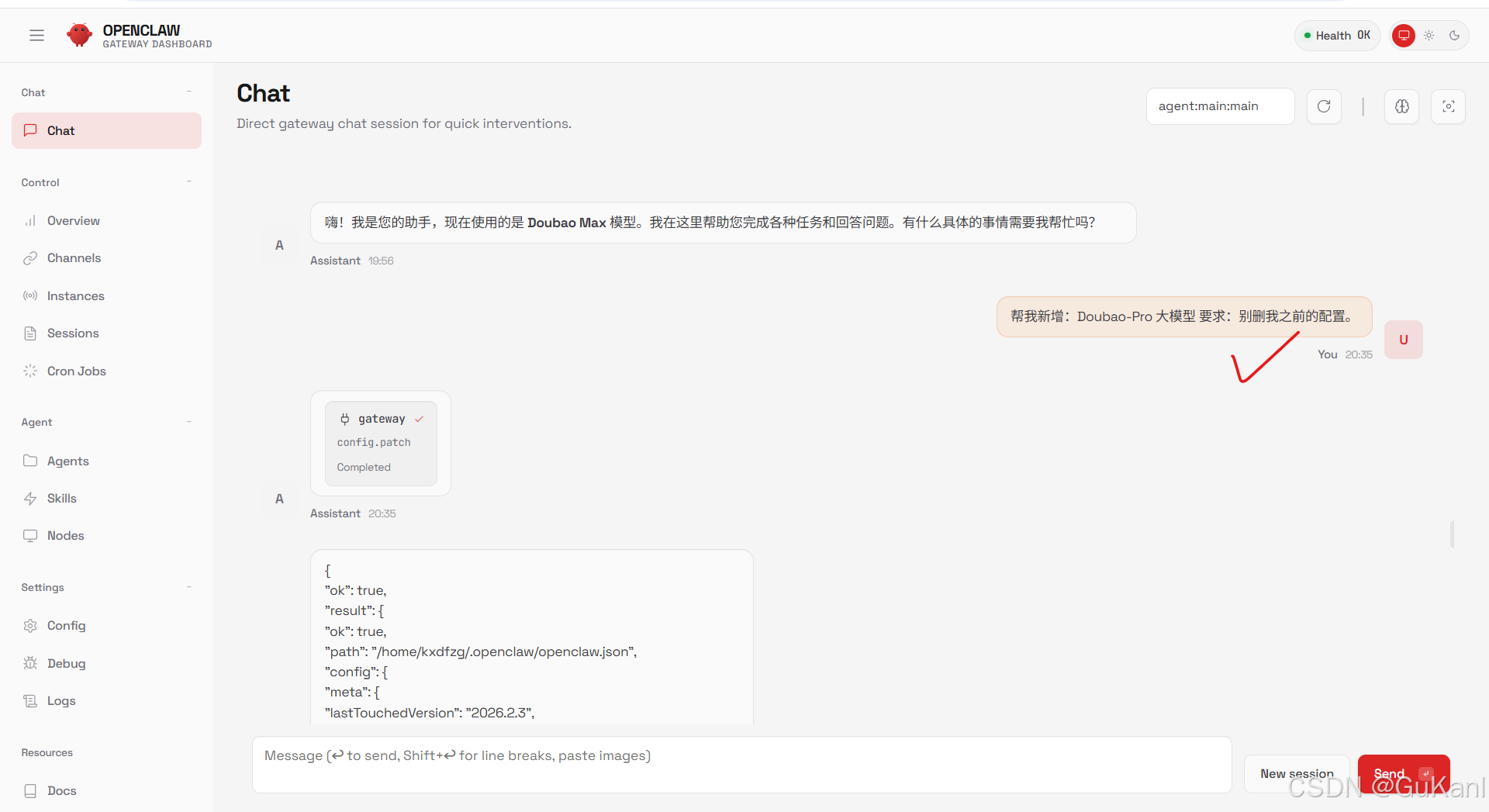

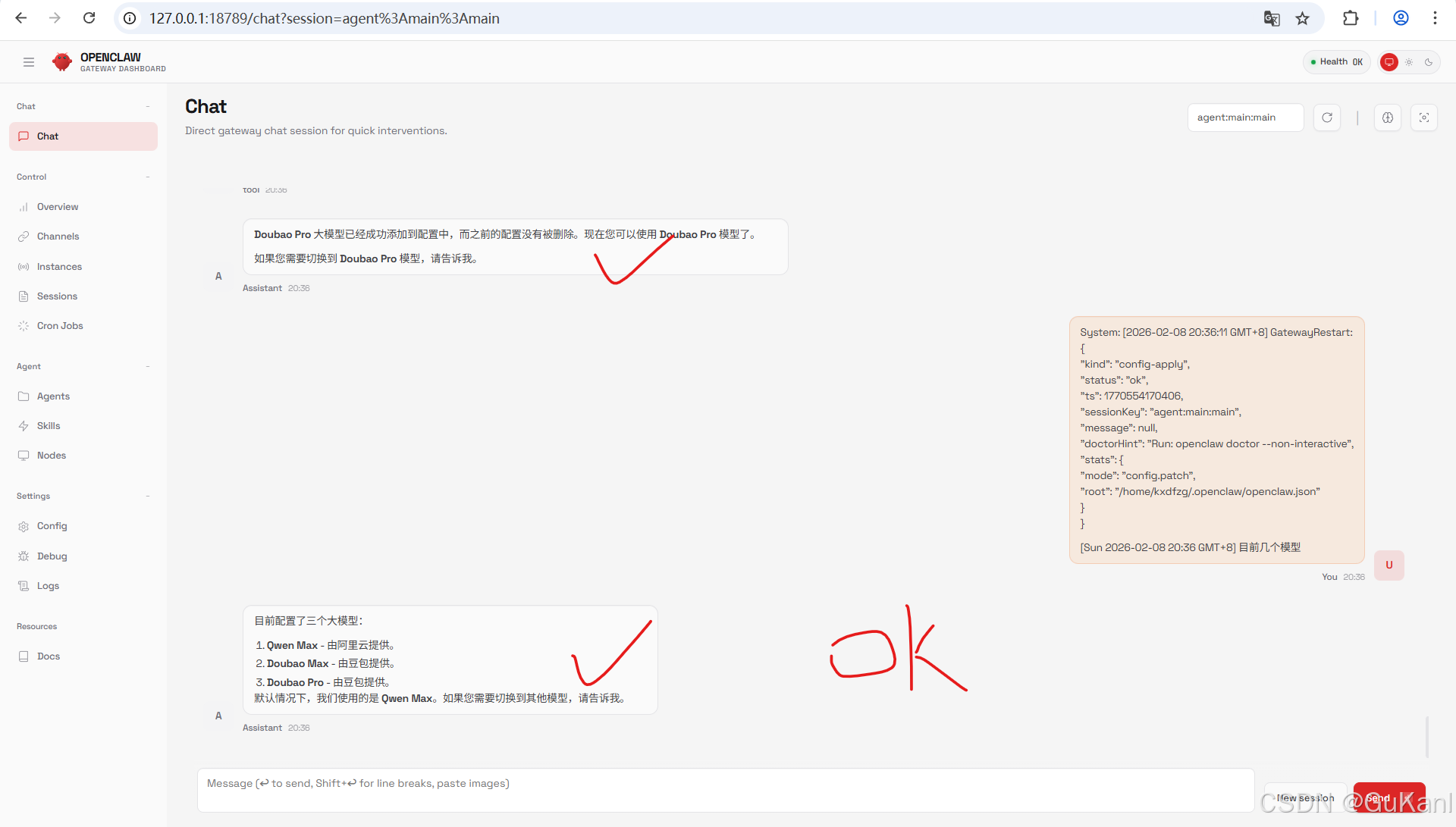

添加多模型

可以询问其他AI相关信息来配置:

核心思想:不允许删除其他配置信息。

“帮我新增:Doubao-Pro 大模型 要求:别删我之前的配置”。

4.5日常维护常用命令

Ubuntu系统命令

日常启动 :

cd ~/openclaw-ai

./openclaw.mjs gateway --force --allow-unconfigured

全部关闭:kill -f openclaw

进入系统安装界面:

cd ~/openclaw-ai

./openclaw.mjs onboard

查看核心API Key大模型配置:cat ~/.openclaw/openclaw.json

检查系统所有监听端口: ss -tulpn

检查 Node.js 版本(确保符合项目要求): node -v

查看当前的 Node 运行版本:node -v

查看显存是否爆了: nvidia-smi

查看 CPU 和内存压力: htop

一键修复权限(确保所有者是你的用户):

sudo chown -R $USER:$USER ~/openclaw-ai ~/.openclaw

安全补丁: sudo apt update && sudo apt upgrade -y

查看磁盘占用大户:du -sh ~/openclaw-ai/* | sort -rh

查看历史命令:history | grep openclaw

测试你的 Ubuntu 到底能不能上网:ping -c 4 baidu.com

查看网关分配的 IP: hostname -I

Windows PowerShell命令

启动:wsl

彻底关机(最推荐):wsl --shutdown

确定是否真正关机:wsl --list --verbose

从 Windows 访问 Ubuntu 文件: 在 Windows 资源管理器的地址栏输入:\wsl$\Ubuntu-24.04

在 Ubuntu 里访问 Windows 的 E 盘: cd /mnt/e/

五、QQ 机器人的接入与生产化部署

5.1编译 OpenClaw China 插件

这是让 AI 具备“社交能力”的关键步骤,需要我们将插件源码转换为可执行代码。

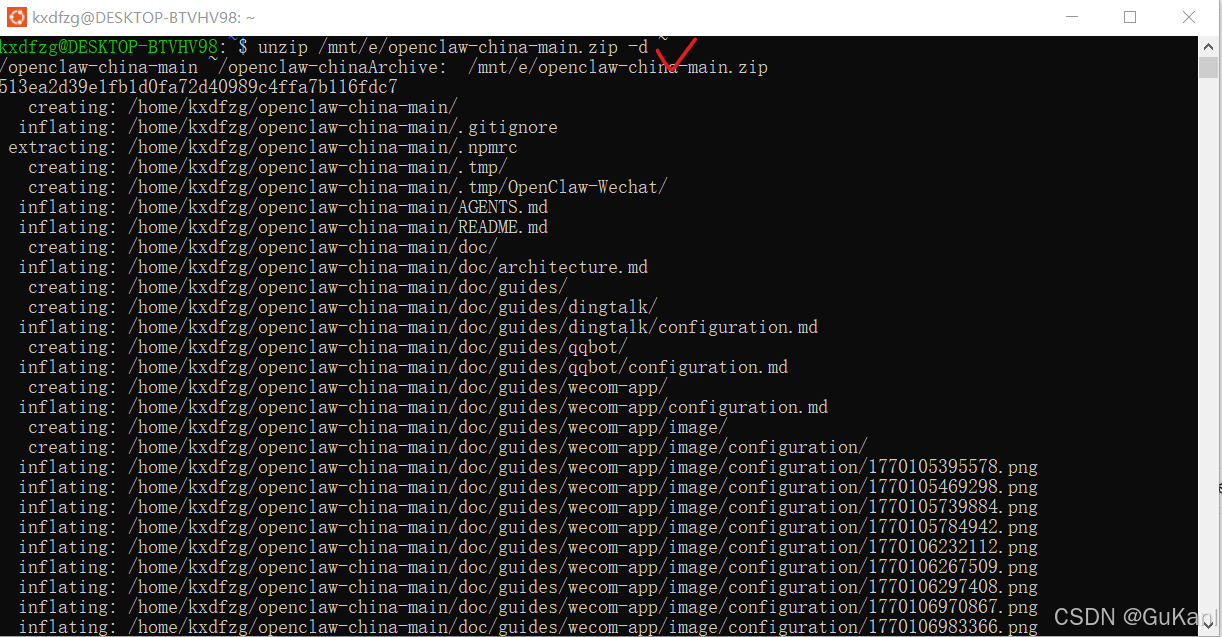

1.解压插件(假设 zip 在 Windows E 盘根目录根据实际路径)

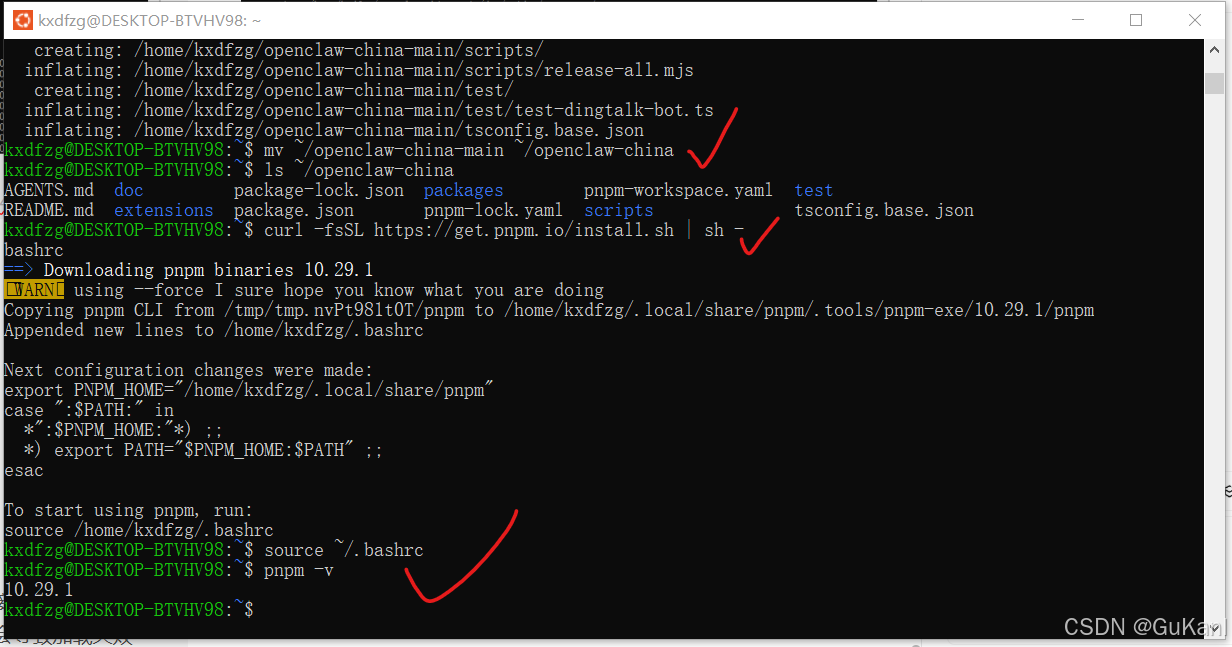

unzip /mnt/e/openclaw-china-main.zip -d ~

mv ~/openclaw-china-main ~/openclaw-china

2.验证目录

ls ~/openclaw-china

3.安装并激活现代包管理器(绕过受限的 /usr/local)

curl -fsSL https://get.pnpm.io/install.sh | sh -

source ~/.bashrc

4.验证 pnpm 工具是否可用

pnpm -v

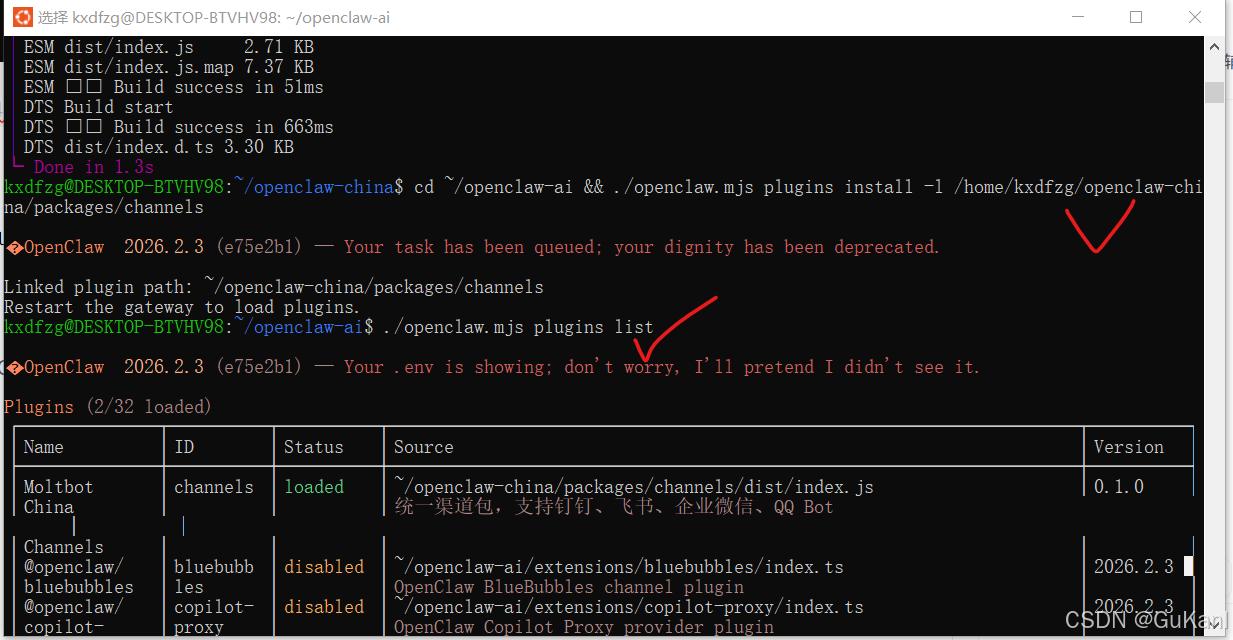

5.2插件编译与安装

将源码转换为可执行的插件包,并链接到 OpenClaw 主程序。

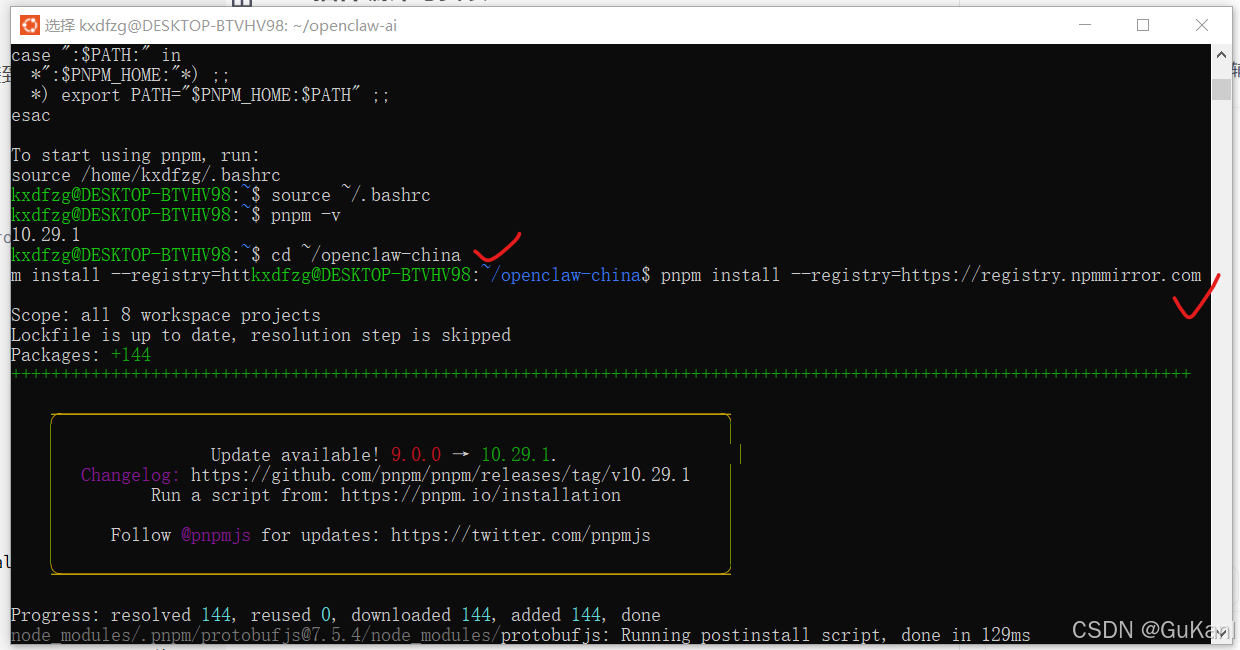

1.安装插件依赖(使用国内阿里云 NPM 镜像源)

cd ~/openclaw-china

pnpm install --registry=https://registry.npmmirror.com

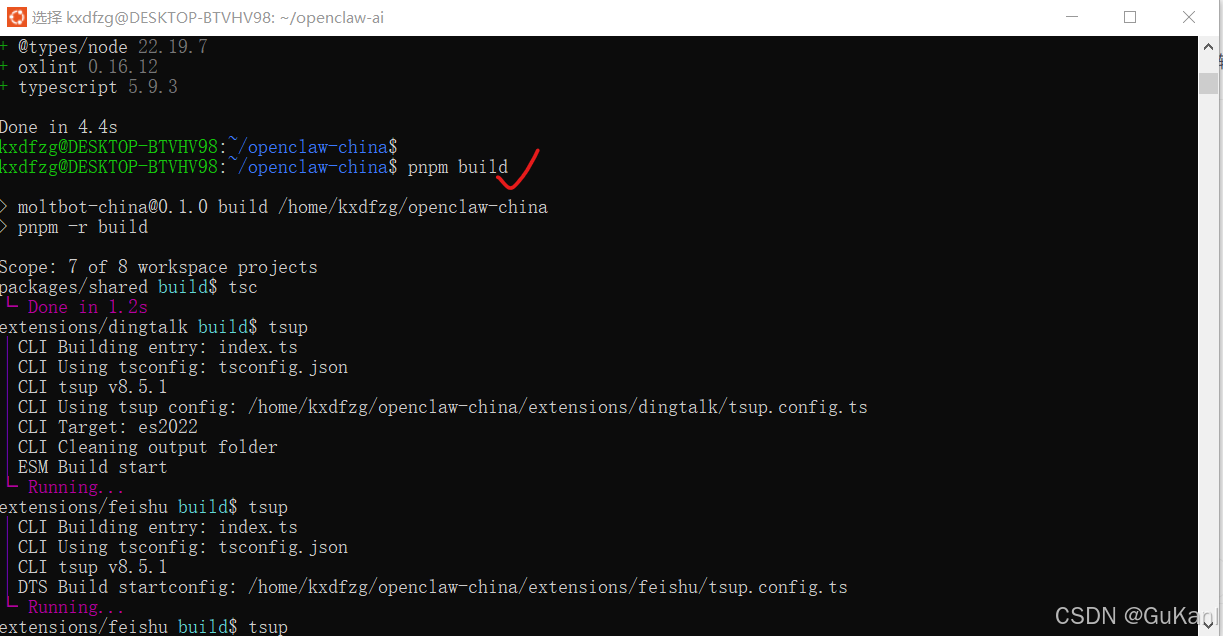

2.编译插件源码

pnpm build

3.将插件链接到主程序(注意使用完整路径)

cd ~/openclaw-ai && ./openclaw.mjs plugins install -l /home/kxdfzg/openclaw-china/packages/channels

4。验证插件是否加载 (列表中应出现 Moltbot China Channels 且状态为 loaded)

./openclaw.mjs plugins list

5.3 QQ 渠道参数配置

进入主程序目录,通过 CLI 刷入 QQ 机器人的核心配置。

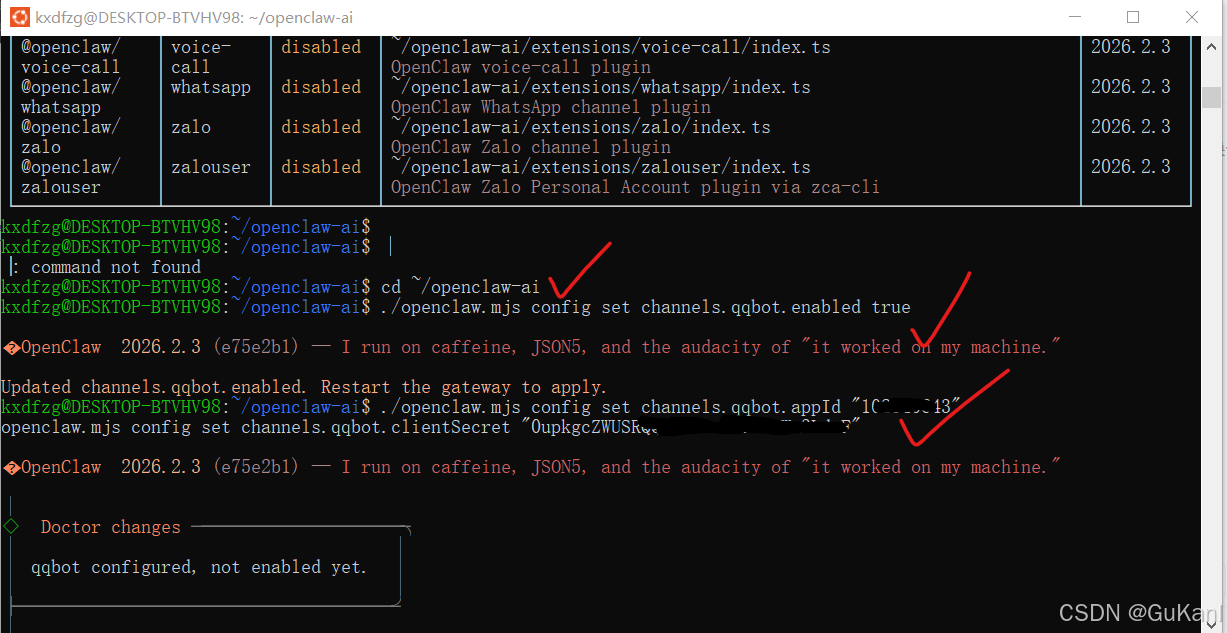

1.进入主目录

cd ~/openclaw-ai

3.开启 QQ 渠道开关

./openclaw.mjs config set channels.qqbot.enabled true

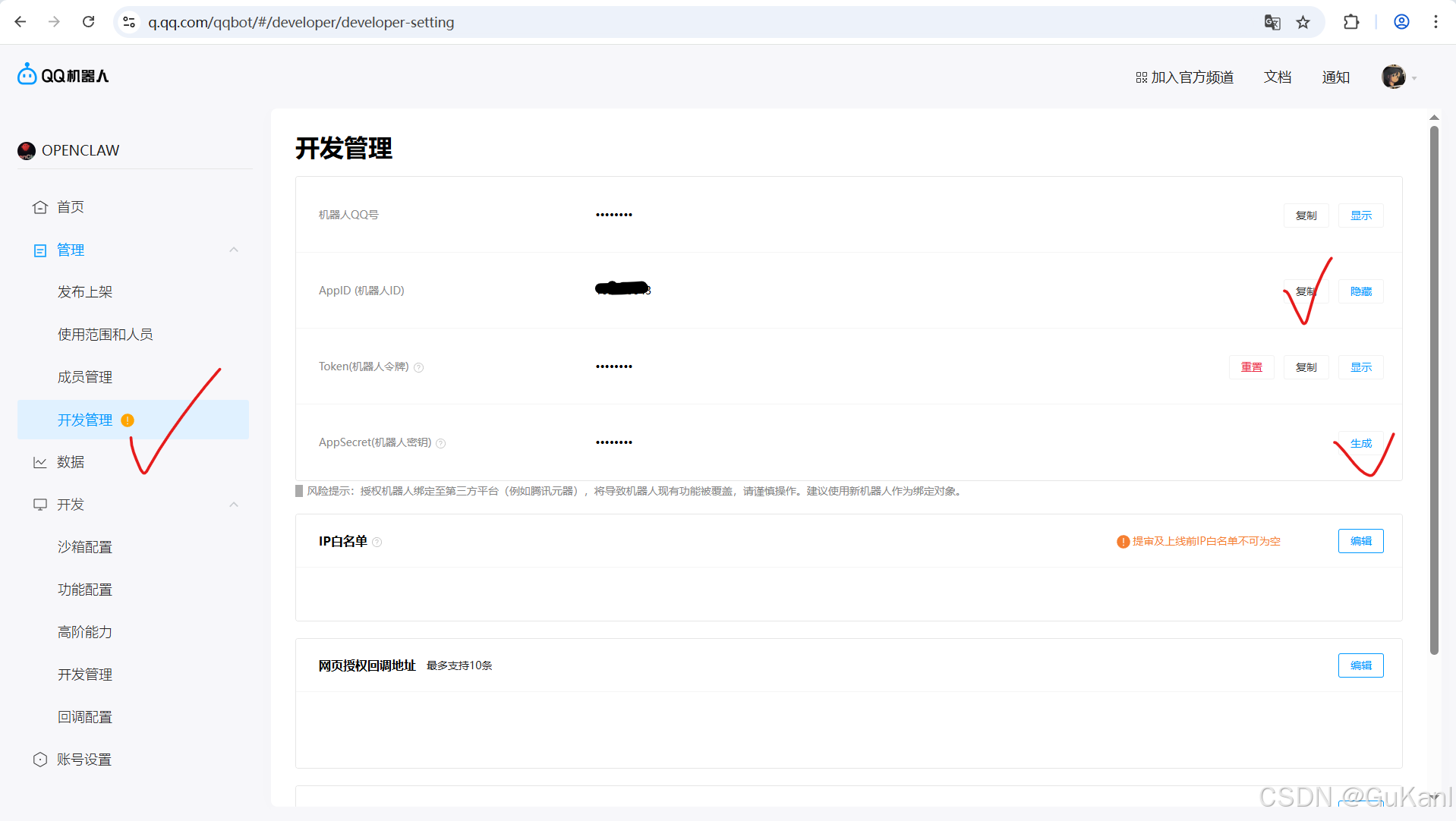

4.配置 AppID 和 Secret (替换为你自己的 ID文章最后)

./openclaw.mjs config set channels.qqbot.appId "你的AppID"

./openclaw.mjs config set channels.qqbot.clientSecret "你的AppSecret"

5.刷入其他业务配置

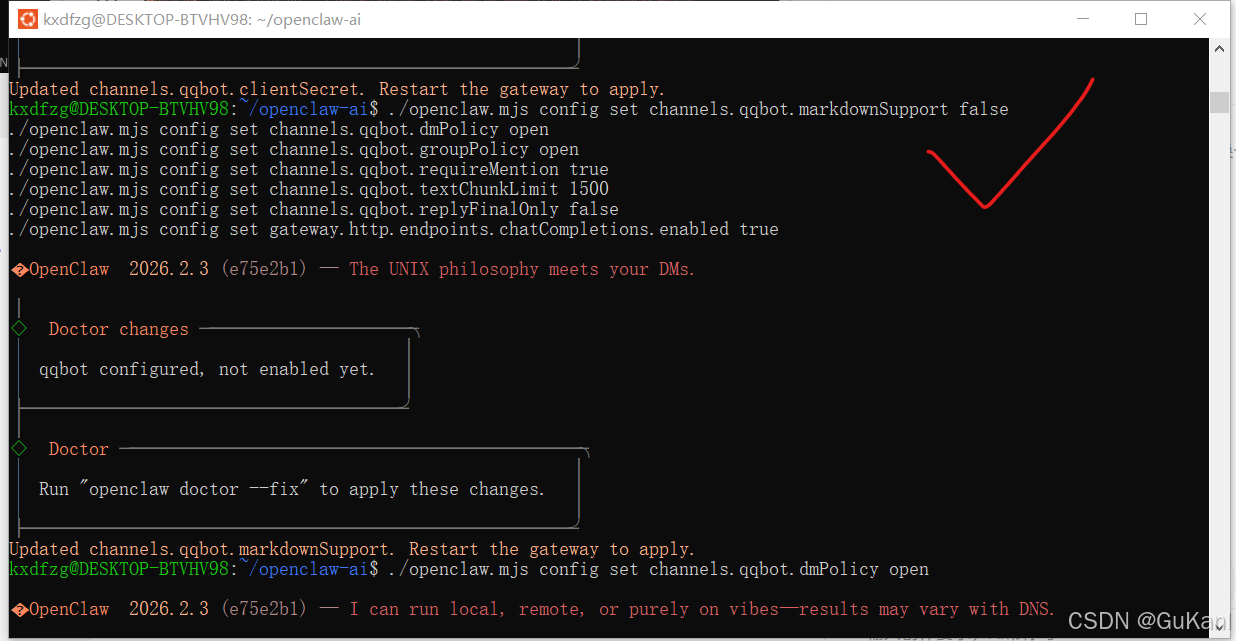

./openclaw.mjs config set channels.qqbot.markdownSupport false

./openclaw.mjs config set channels.qqbot.dmPolicy open

./openclaw.mjs config set channels.qqbot.groupPolicy open

./openclaw.mjs config set channels.qqbot.requireMention true

./openclaw.mjs config set channels.qqbot.textChunkLimit 1500

./openclaw.mjs config set channels.qqbot.replyFinalOnly false

./openclaw.mjs config set gateway.http.endpoints.chatCompletions.enabled true

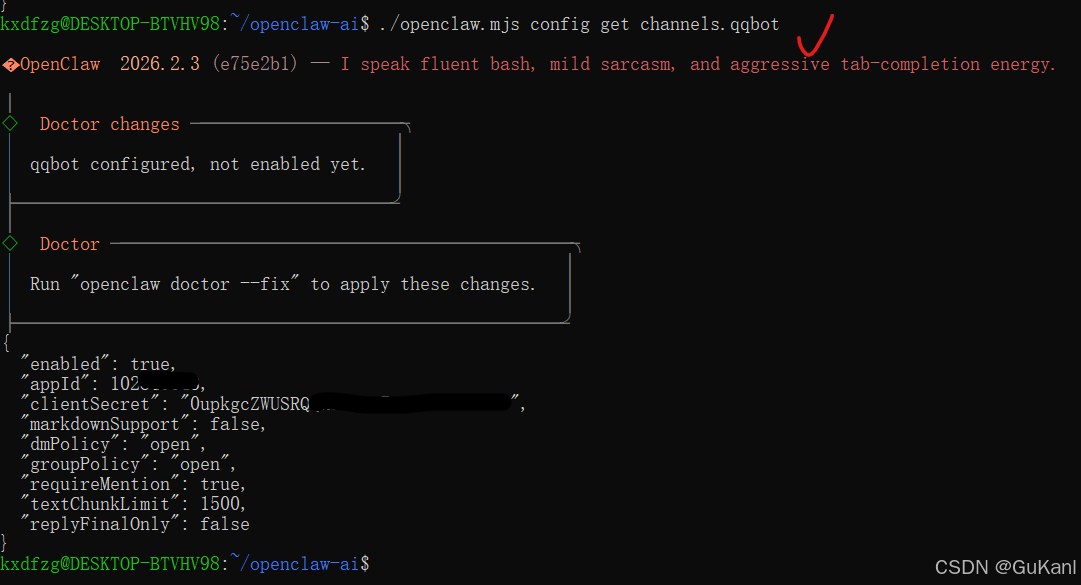

6.确认配置是否写入成功

./openclaw.mjs config get channels.qqbot

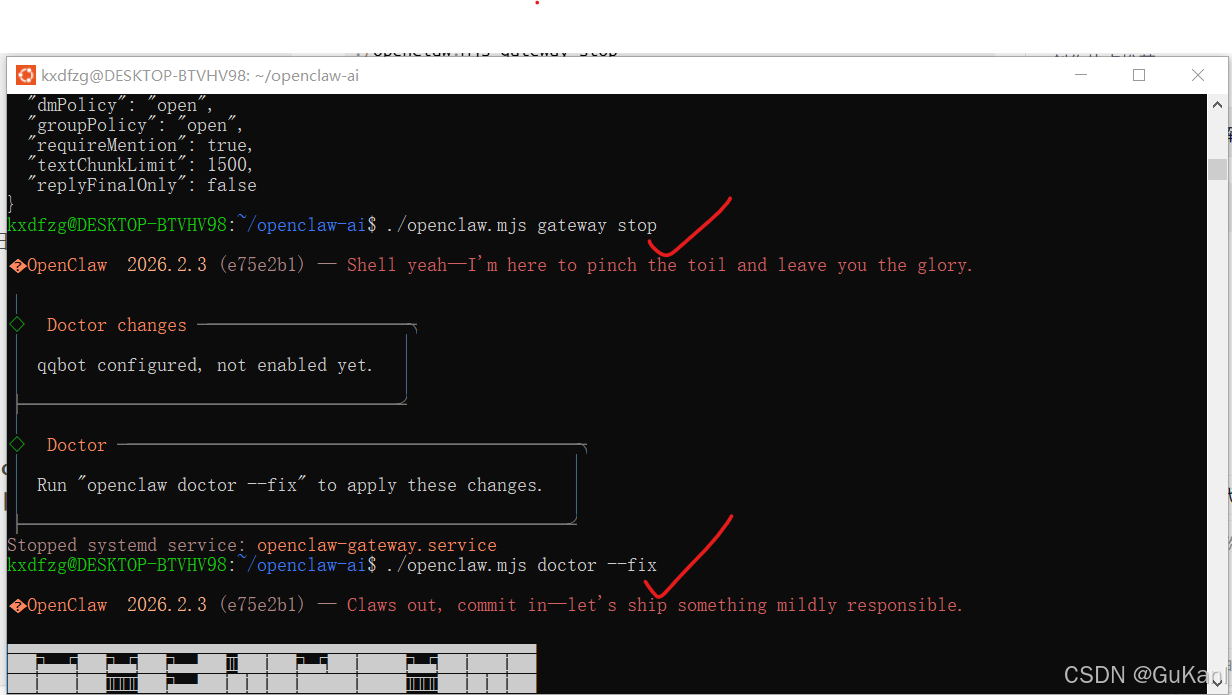

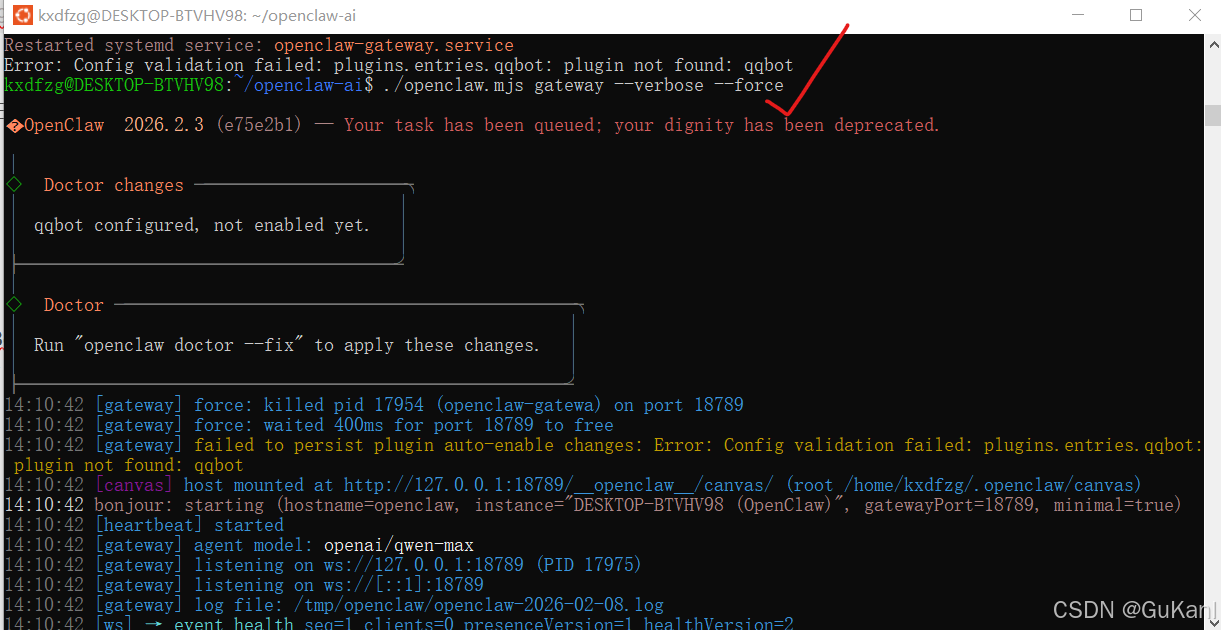

5.4启动与状态检查

清理环境并以调试模式运行:

- 停止任何正在运行的网关进程

./openclaw.mjs gateway stop

- 自动修复配置一致性 (重要一步)

./openclaw.mjs doctor --fix

- 正式启动(开启 --verbose 模式观察连接日志)

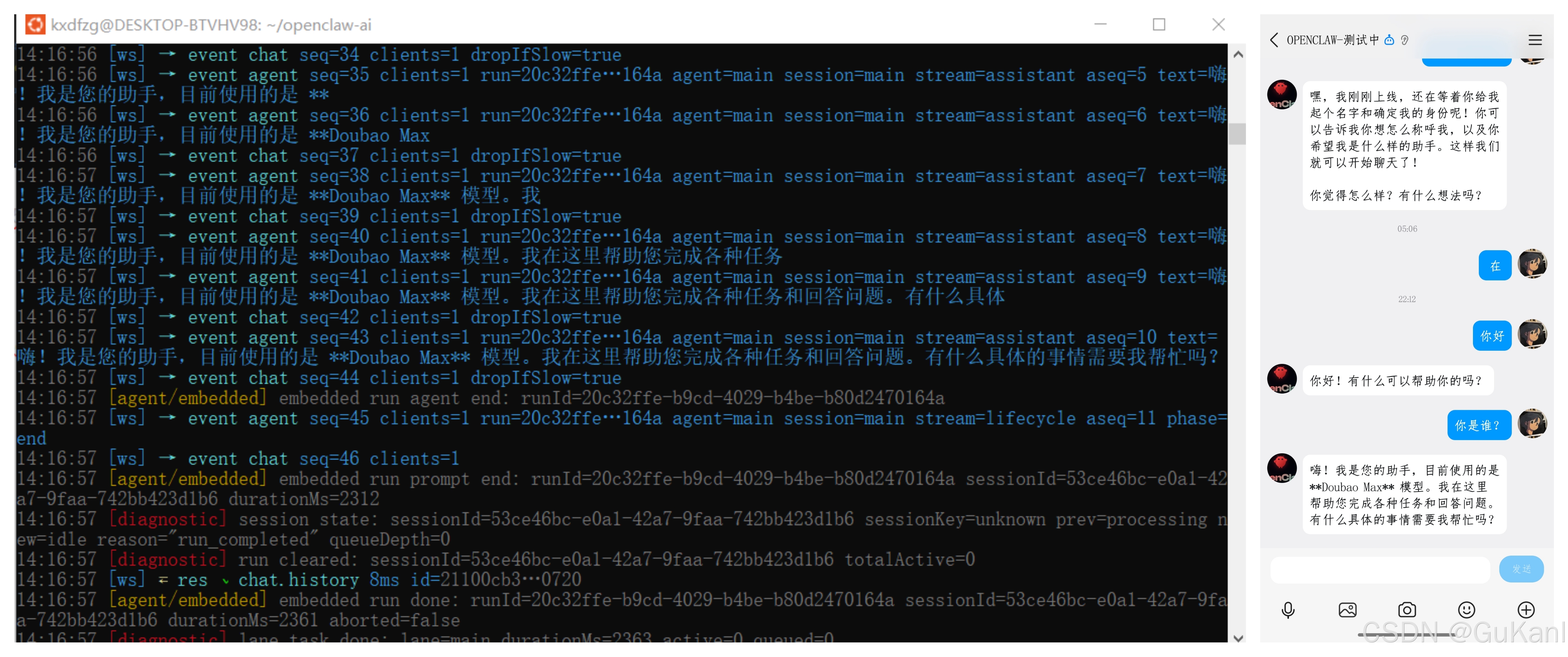

./openclaw.mjs gateway --verbose --force

部署成功标志:

当你看到控制台输出: [QQBot] WebSocket connected 说明你的 QQ 机器人已经正式和 OpenClaw 网关合体成功了!

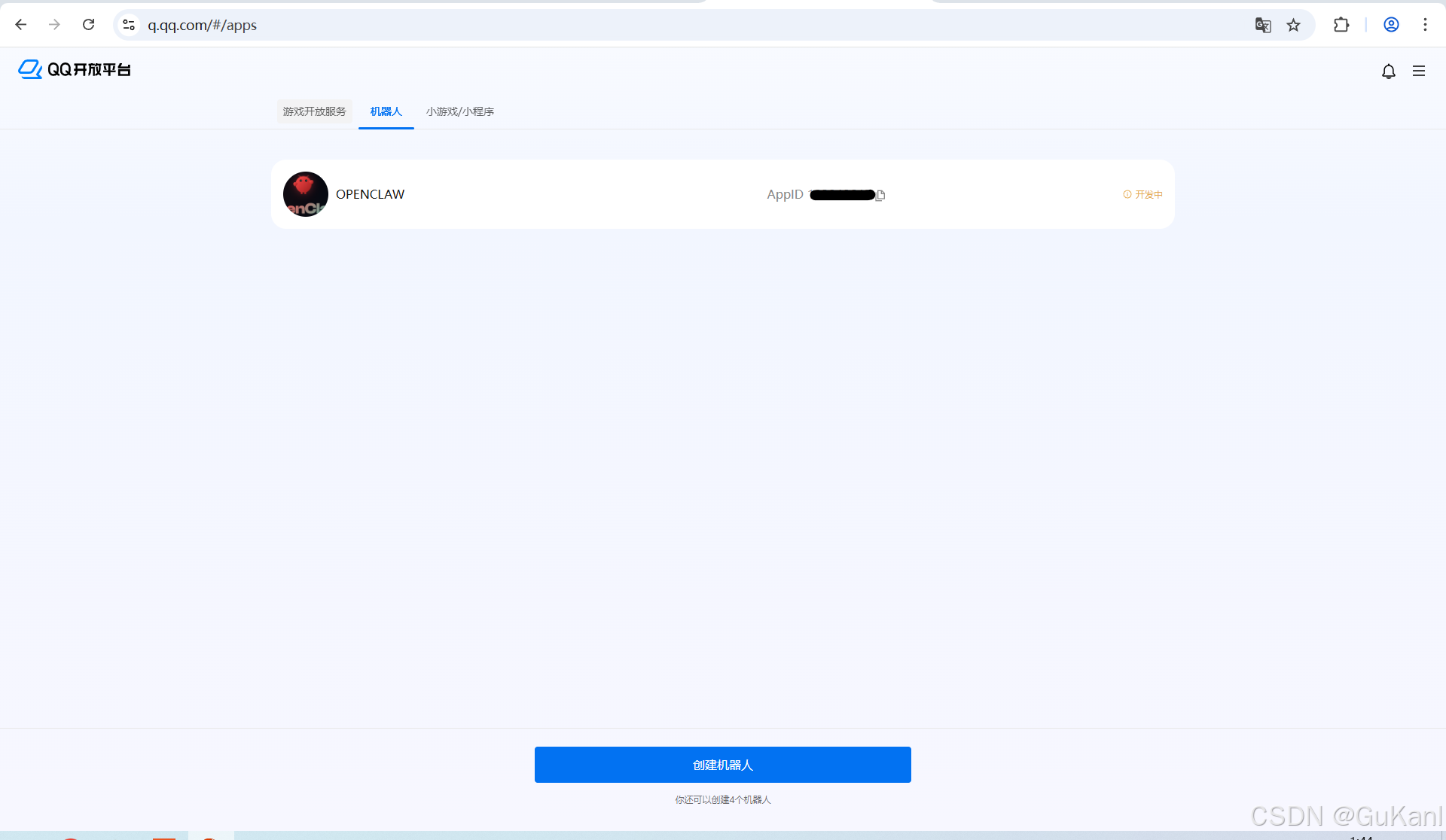

5.5 QQ机器人创建(获取AppID和AppSecret)

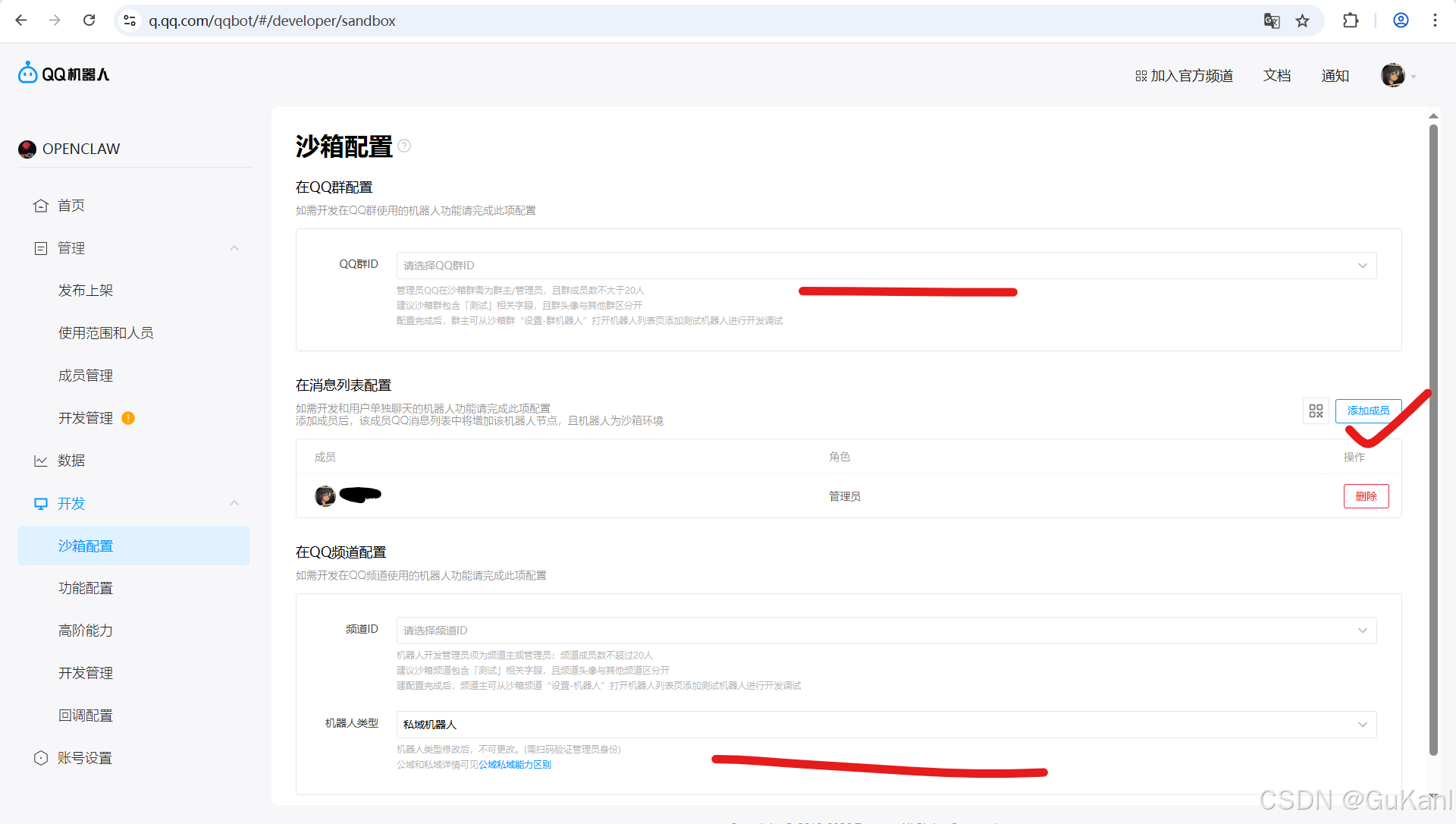

首先登入QQ开放平台(https://q.qq.com)如果没有账号自行创建。

根据实际情况来选择,部署在本地建议选择本人访问即可。

5.6相关下载资源

123网盘:https://www.123865.com/s/i72cTd-B5SAH

GitHub(源地址):

openclaw AI:https://github.com/openclaw/openclaw/releases (AI助手)

nvm-0.40.4:https://github.com/nvm-sh/nvm/releases/tag/v0.40.4 (依赖环境)

node-v22.22.0-linux-x64:https://nodejs.org/download/release/v22.22.0/(依赖环境)

openclaw-china-main:https://github.com/BytePioneer-AI/openclaw-china(支持飞书,钉钉,QQ,企业微信,微信OpenClaw插件)

注意:所有环境依赖全部采用阿里云NPM镜像源。

六、 总结:构筑数字堡垒

通过这套“物理级离线部署方案”,不仅实现了 OpenClaw AI 在 WSL2 环境下的稳定运行,更在 Windows 宿主机之上,建立了一座逻辑闭环的数字堡垒。

在这个新的时代,开发范式正在经历深刻定义:

确定性终结环境玄学:利用离线预装与物理挂载机制,彻底阻断了网络波动与依赖冲突,使部署流程进入可预测、可复现的工程轨道。

边缘计算保障数据主权:基于 OpenClaw AI 与国内大模型的协同架构,计算逻辑得以从云端回归本地,构建起 7x24 小时待命且高度受控的智能中枢。

角色从调用向构筑跃迁:摆脱了单纯的 API 调用模式,转而通过路径精算、服务守护以及渠道编排,实现了对 AI 底层基础设施的深度管控。

此套方案的成功落地,标志着个人 AI 基础设施化的初步完成。随着插件生态的扩展与本地业务逻辑的深化,该系统将展现出更强大的进化潜力。

新纪元的航道已经铺就,硬核构筑永无止境!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)