朴素贝叶斯算法:机器学习中的‘快刀斩乱麻’

朴素贝叶斯算法因其简单、高效的特点,在文本分类、医疗诊断和金融风控等领域得到了广泛应用。尽管其独立性假设在现实中往往不成立,但通过特征工程、半朴素贝叶斯方法和贝叶斯网络等优化策略,可以显著提升其分类性能。未来,随着数据规模的不断增长和数据类型的多样化,朴素贝叶斯算法仍有很大的发展空间。例如,与深度学习算法的融合、处理多模态数据以及增强算法的可解释性,都是值得探索的研究方向。

引言

在机器学习领域,朴素贝叶斯算法因其简单、高效且易于实现的特性,成为了分类任务中的经典算法之一。尽管其“朴素”的假设——特征之间相互独立——在现实中往往不成立,但它在许多实际应用中依然表现出色。本文将深入探讨朴素贝叶斯算法的原理、优缺点、变体以及如何在实际项目中应用和优化该算法。

一、朴素贝叶斯算法基础

1.1 贝叶斯定理

朴素贝叶斯算法的核心是贝叶斯定理。贝叶斯定理描述了在已知某些条件下,事件发生的概率如何更新。其数学表达式为:

P ( A ∣ B ) = P ( B ∣ A ) ⋅ P ( A ) P ( B ) P(A|B) = \frac{P(B|A) \cdot P(A)}{P(B)} P(A∣B)=P(B)P(B∣A)⋅P(A)

其中:

- P ( A ∣ B ) P(A|B) P(A∣B) 是在事件 B B B 发生的条件下,事件 A A A 发生的概率,称为后验概率。

- P ( B ∣ A ) P(B|A) P(B∣A) 是在事件 A A A 发生的条件下,事件 B B B 发生的概率,称为似然。

- P ( A ) P(A) P(A) 是事件 A A A 的先验概率,即在没有任何额外信息的情况下,事件 A A A 发生的概率。

- P ( B ) P(B) P(B) 是事件 B B B 的边际概率。

贝叶斯定理的核心思想是通过已知的先验概率和新的观测数据,更新我们对事件发生概率的认知。

贝叶斯定理的扩展形式

当存在多个事件时,贝叶斯定理可以扩展为:

P ( A i ∣ B ) = P ( B ∣ A i ) ⋅ P ( A i ) ∑ k = 1 n P ( B ∣ A k ) ⋅ P ( A k ) P(A_i|B) = \frac{P(B|A_i) \cdot P(A_i)}{\sum_{k=1}^{n} P(B|A_k) \cdot P(A_k)} P(Ai∣B)=∑k=1nP(B∣Ak)⋅P(Ak)P(B∣Ai)⋅P(Ai)

贝叶斯定理的应用示例

在实际应用中,贝叶斯定理可以用于计算条件概率。例如,在医学诊断中,可以通过已知的症状和疾病的先验概率,计算出患病的后验概率。

1.2 朴素贝叶斯的“朴素”假设

朴素贝叶斯算法的“朴素”之处在于它假设所有特征之间是相互独立的。也就是说,给定类别标签,每个特征对结果的影响是独立的。这一假设极大地简化了计算,但也带来了局限性,因为现实中的数据特征往往存在相关性。

数学上,朴素贝叶斯假设可以表示为:

P ( X 1 , X 2 , … , X n ∣ Y ) = ∏ i = 1 n P ( X i ∣ Y ) P(X_1, X_2, \dots, X_n | Y) = \prod_{i=1}^{n} P(X_i | Y) P(X1,X2,…,Xn∣Y)=i=1∏nP(Xi∣Y)

其中, X 1 , X 2 , … , X n X_1, X_2, \dots, X_n X1,X2,…,Xn 是特征, Y Y Y 是类别标签。

1.3 朴素贝叶斯算法的步骤

朴素贝叶斯算法的实现可以分为以下几个步骤:

- 计算先验概率:根据训练数据,计算每个类别的先验概率 P ( Y ) P(Y) P(Y)。

- 计算条件概率:对于每个特征,计算在给定类别下的条件概率 P ( X i ∣ Y ) P(X_i | Y) P(Xi∣Y)。

- 预测新样本:对于新样本,计算其属于每个类别的后验概率,并选择概率最大的类别作为预测结果。

二、朴素贝叶斯算法的优缺点

2.1 优点

- 简单易实现:朴素贝叶斯算法的数学模型简单,计算效率高,适合处理大规模数据。

- 对缺失数据不敏感:由于算法基于概率模型,缺失值不会对结果产生太大影响。

- 适合高维数据:在处理文本分类等高维数据时,朴素贝叶斯表现尤为出色。

2.2 缺点

- 特征独立性假设:现实中的数据特征往往存在相关性,朴素贝叶斯的独立性假设可能导致分类性能下降。

- 对强相关特征处理不佳:当特征之间存在强相关性时,朴素贝叶斯的表现可能会受到影响。

三、朴素贝叶斯算法的变体

3.1 高斯朴素贝叶斯

高斯朴素贝叶斯适用于连续型数据,假设特征服从高斯分布。其条件概率计算公式为:

P ( X i ∣ Y ) = 1 2 π σ y 2 exp ( − ( X i − μ y ) 2 2 σ y 2 ) P(X_i | Y) = \frac{1}{\sqrt{2\pi\sigma_y^2}} \exp\left(-\frac{(X_i - \mu_y)^2}{2\sigma_y^2}\right) P(Xi∣Y)=2πσy21exp(−2σy2(Xi−μy)2)

其中, μ y \mu_y μy 和 σ y \sigma_y σy 分别是类别 Y Y Y 下特征 X i X_i Xi 的均值和标准差。

代码示例:高斯朴素贝叶斯

# 导入必要的库

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.naive_bayes import GaussianNB

from sklearn.metrics import accuracy_score

# 加载鸢尾花数据集

data = load_iris()

X = data.data # 特征

y = data.target # 标签

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建高斯朴素贝叶斯模型

gnb = GaussianNB()

# 训练模型

gnb.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = gnb.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print(f"高斯朴素贝叶斯的准确率: {accuracy:.2f}")

3.2 多项式朴素贝叶斯

多项式朴素贝叶斯适用于离散型数据,特别是文本分类任务。它假设特征服从多项式分布,通常用于处理词频等计数数据。

代码示例:多项式朴素贝叶斯

# 导入必要的库

from sklearn.datasets import fetch_20newsgroups

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.model_selection import train_test_split

from sklearn.naive_bayes import MultinomialNB

from sklearn.metrics import accuracy_score

# 加载20个新闻组数据集

categories = ['alt.atheism', 'soc.religion.christian', 'comp.graphics', 'sci.med']

newsgroups = fetch_20newsgroups(subset='all', categories=categories)

# 将文本数据转换为TF-IDF特征向量

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(newsgroups.data)

y = newsgroups.target

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建多项式朴素贝叶斯模型

mnb = MultinomialNB()

# 训练模型

mnb.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = mnb.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print(f"多项式朴素贝叶斯的准确率: {accuracy:.2f}")

3.3 伯努利朴素贝叶斯

伯努利朴素贝叶斯适用于二元特征数据,假设特征服从伯努利分布。它常用于文本分类中的二值化特征(如某个词是否出现)。

代码示例:伯努利朴素贝叶斯

# 导入必要的库

from sklearn.datasets import fetch_20newsgroups

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.model_selection import train_test_split

from sklearn.naive_bayes import BernoulliNB

from sklearn.metrics import accuracy_score

# 加载20个新闻组数据集

categories = ['alt.atheism', 'soc.religion.christian', 'comp.graphics', 'sci.med']

newsgroups = fetch_20newsgroups(subset='all', categories=categories)

# 将文本数据转换为二元特征向量

vectorizer = CountVectorizer(binary=True)

X = vectorizer.fit_transform(newsgroups.data)

y = newsgroups.target

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建伯努利朴素贝叶斯模型

bnb = BernoulliNB()

# 训练模型

bnb.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = bnb.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print(f"伯努利朴素贝叶斯的准确率: {accuracy:.2f}")

四、朴素贝叶斯算法的应用

4.1 文本分类

朴素贝叶斯算法在文本分类任务中表现尤为出色。例如,垃圾邮件过滤和情感分析都是其经典应用场景。通过计算每个词在不同类别下的条件概率,朴素贝叶斯可以快速判断新文本的类别。

4.2 医疗诊断

在医疗领域,朴素贝叶斯算法可以用于疾病预测和医疗影像识别。通过分析患者的症状、病史和检查结果,算法可以辅助医生进行诊断。

4.3 金融风控

在金融领域,朴素贝叶斯算法可以用于信用评估和欺诈检测。通过分析借款人的信用历史、收入等信息,算法可以预测其违约风险。

五、朴素贝叶斯算法的优化策略

5.1 特征工程优化

特征工程是提升朴素贝叶斯算法性能的关键。通过特征选择和特征组合,可以减少冗余特征,提升模型的分类能力。

5.1.1 特征选择

常用的特征选择方法包括互信息和卡方检验。互信息衡量特征与类别之间的相关性,而卡方检验则用于评估特征与类别之间的独立性。

5.1.2 特征组合

通过组合多个特征,可以捕捉到特征之间的交互信息,提升模型的分类性能。例如,在电商用户行为分析中,可以将用户的浏览历史和购买记录组合成新的特征。

5.2 处理特征相关性

为了克服朴素贝叶斯算法的独立性假设,可以采用半朴素贝叶斯方法或贝叶斯网络来处理特征之间的相关性。

5.2.1 半朴素贝叶斯方法

半朴素贝叶斯方法通过引入部分特征依赖关系,缓解了独立性假设带来的局限性。常见的半朴素贝叶斯方法包括独依赖估计(ODE)和树增强朴素贝叶斯(TAN)。

5.2.2 贝叶斯网络

贝叶斯网络通过构建有向无环图来表示特征之间的依赖关系,能够更准确地建模复杂的数据分布。

5.3 模型评估与调优

为了确保朴素贝叶斯算法在实际应用中的性能,需要进行模型评估和参数调优。

5.3.1 评估指标体系

常用的评估指标包括准确率、召回率、F1值和AUC-ROC曲线。这些指标可以从不同角度评估模型的分类性能。

5.3.2 交叉验证与参数调优

通过交叉验证和参数调优,可以找到模型的最佳参数组合,提升其泛化能力。

六、总结与展望

朴素贝叶斯算法因其简单、高效的特点,在文本分类、医疗诊断和金融风控等领域得到了广泛应用。尽管其独立性假设在现实中往往不成立,但通过特征工程、半朴素贝叶斯方法和贝叶斯网络等优化策略,可以显著提升其分类性能。

未来,随着数据规模的不断增长和数据类型的多样化,朴素贝叶斯算法仍有很大的发展空间。例如,与深度学习算法的融合、处理多模态数据以及增强算法的可解释性,都是值得探索的研究方向。

参考文献

- 贝叶斯定理 - 维基百科

贝叶斯定理 - Scikit-learn 官方文档 - 朴素贝叶斯

Scikit-learn 朴素贝叶斯 - 贝叶斯定理的应用实例 - Towards Data Science

贝叶斯定理的实际应用

学习是通往智慧高峰的阶梯,努力是成功的基石。

我在求知路上不懈探索,将点滴感悟与收获都记在博客里。

要是我的博客能触动您,盼您 点个赞、留个言,再关注一下。

您的支持是我前进的动力,愿您的点赞为您带来好运,愿您生活常暖、快乐常伴!

希望您常来看看,我是 秋声,与您一同成长。

秋声敬上,期待再会!

更多推荐

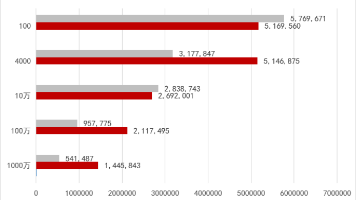

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)