大模型请求/响应参数完全拆解:每个字段都是什么意思?

重生了,这一世,我一定要学会大模型请求/响应参数!只因上一世……

·

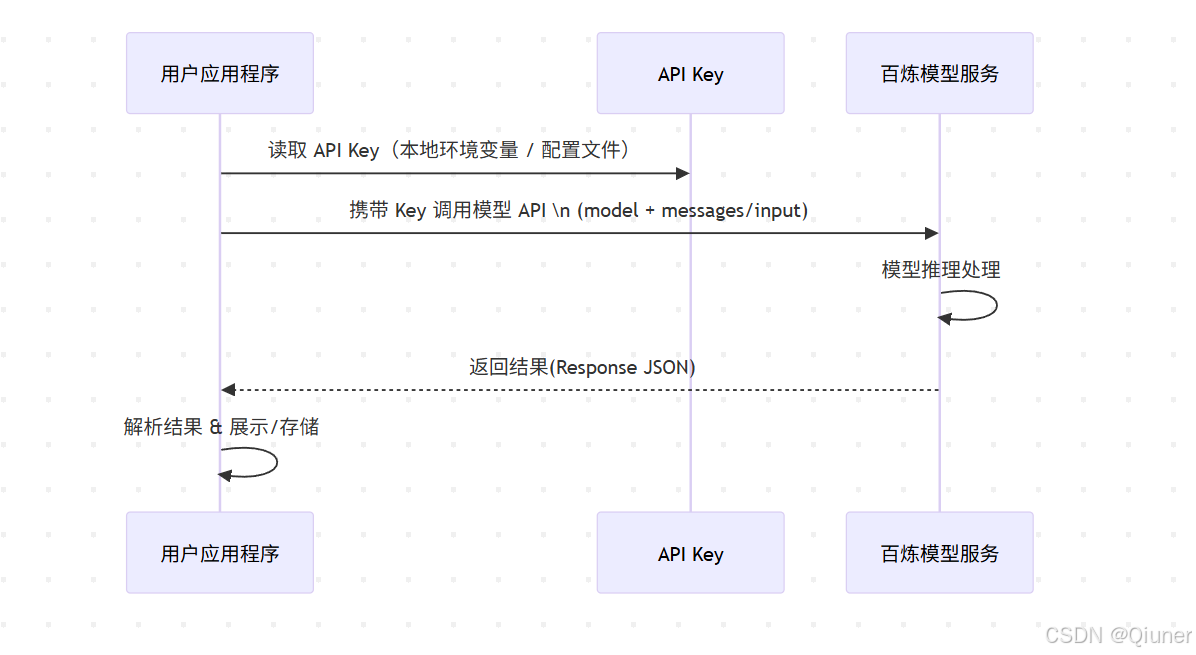

- AI时代下,如果你仅仅限于下载AI产品、通过网站对话访问Ai那就太落伍了。本文将用Apifox对阿里云上的模型进行请求,进行参数解读,让你从另一个视角认识大模型。

所需前置知识

| HTTP协议 | 请求方法(GET/POST) 请求头/请求体 状态码(200/400/500) |

| JSON格式 | 知道json就好 |

| API认证 | API Key管理 请求头Authorization |

| Apifox工具 | 创建请求集合 环境变量配置 测试和调试 |

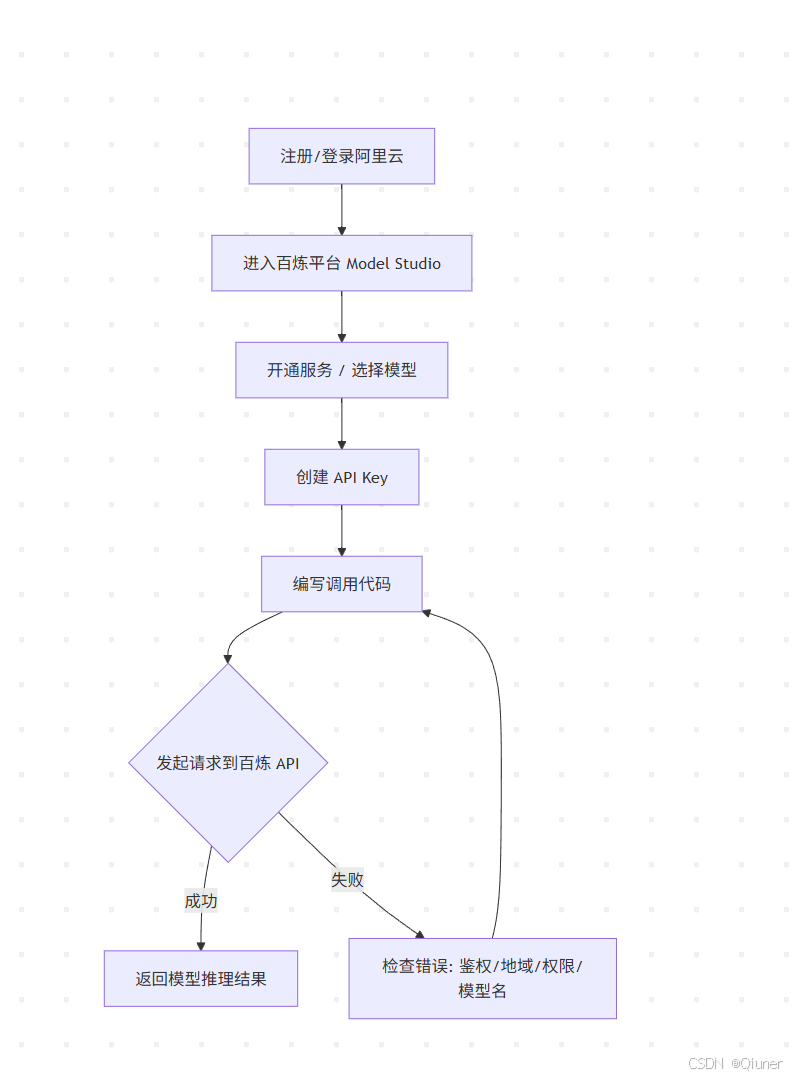

如何用Apifox对阿里云上的模型进行请求?

第一步:平台方面

- 访问:下列网址,注册账号并注册密匙

https://bailian.console.aliyun.com/?tab=model#/api-key

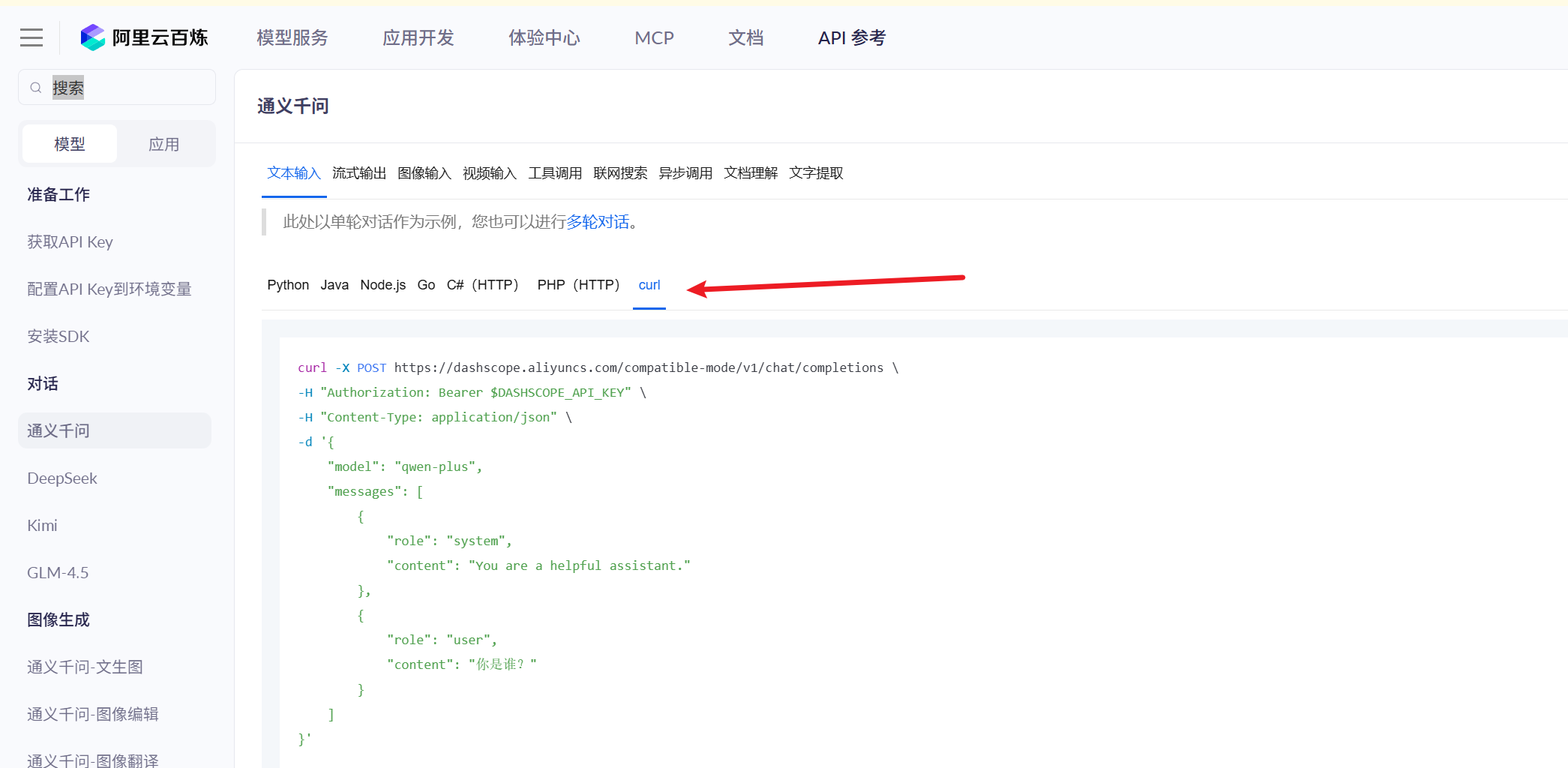

- 访问:下列网址,找到curl

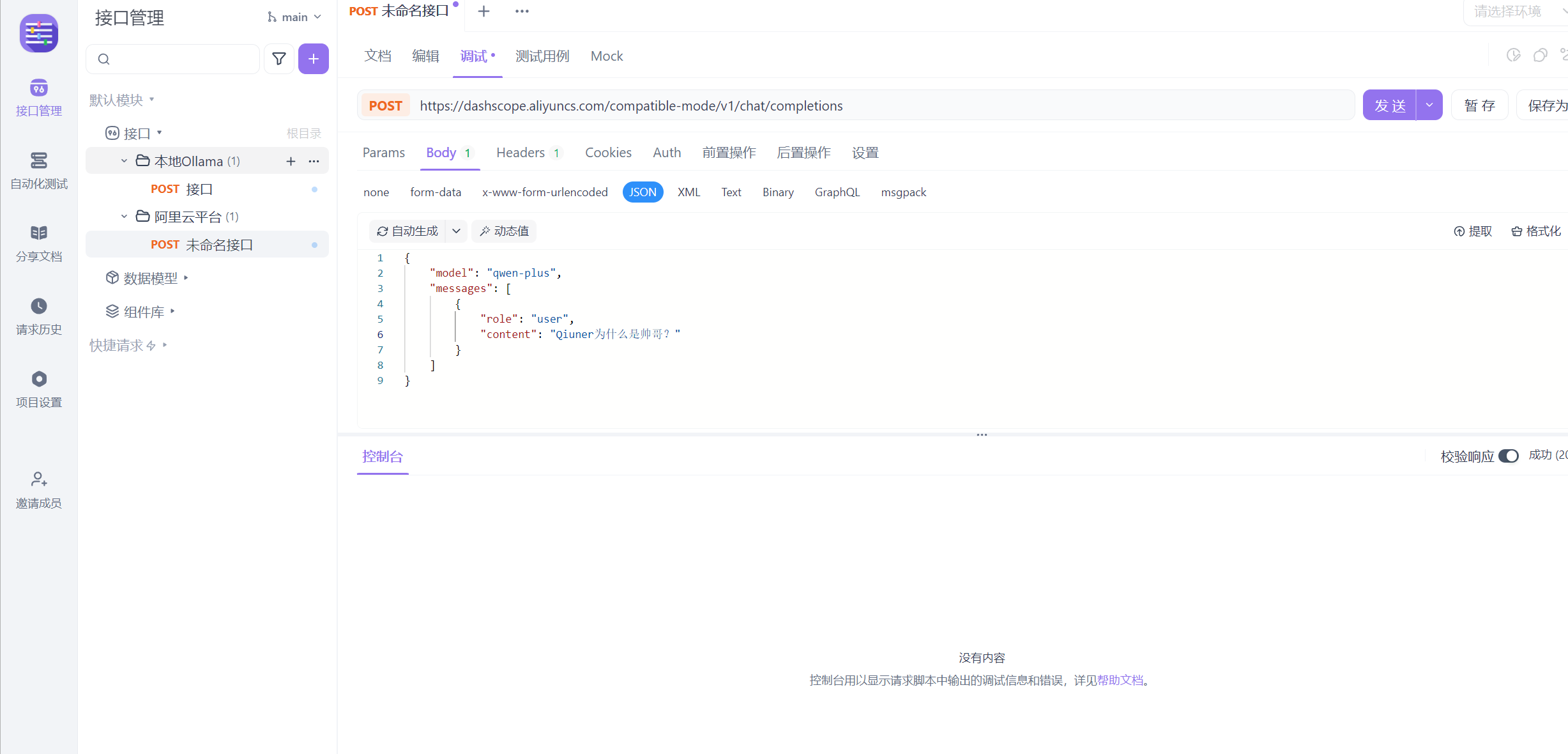

第二步:软件方面

- 下载安装好Apifox,来到新建界面窗口

- 分别填入

https://dashscope.aliyuncs.com/compatible-mode/v1/chat/completions

自己的密匙,见第一步

{

"model": "qwen-plus",

"messages": [

{

"role": "user",

"content": "Qiuner为什么是帅哥?"

}

]

}

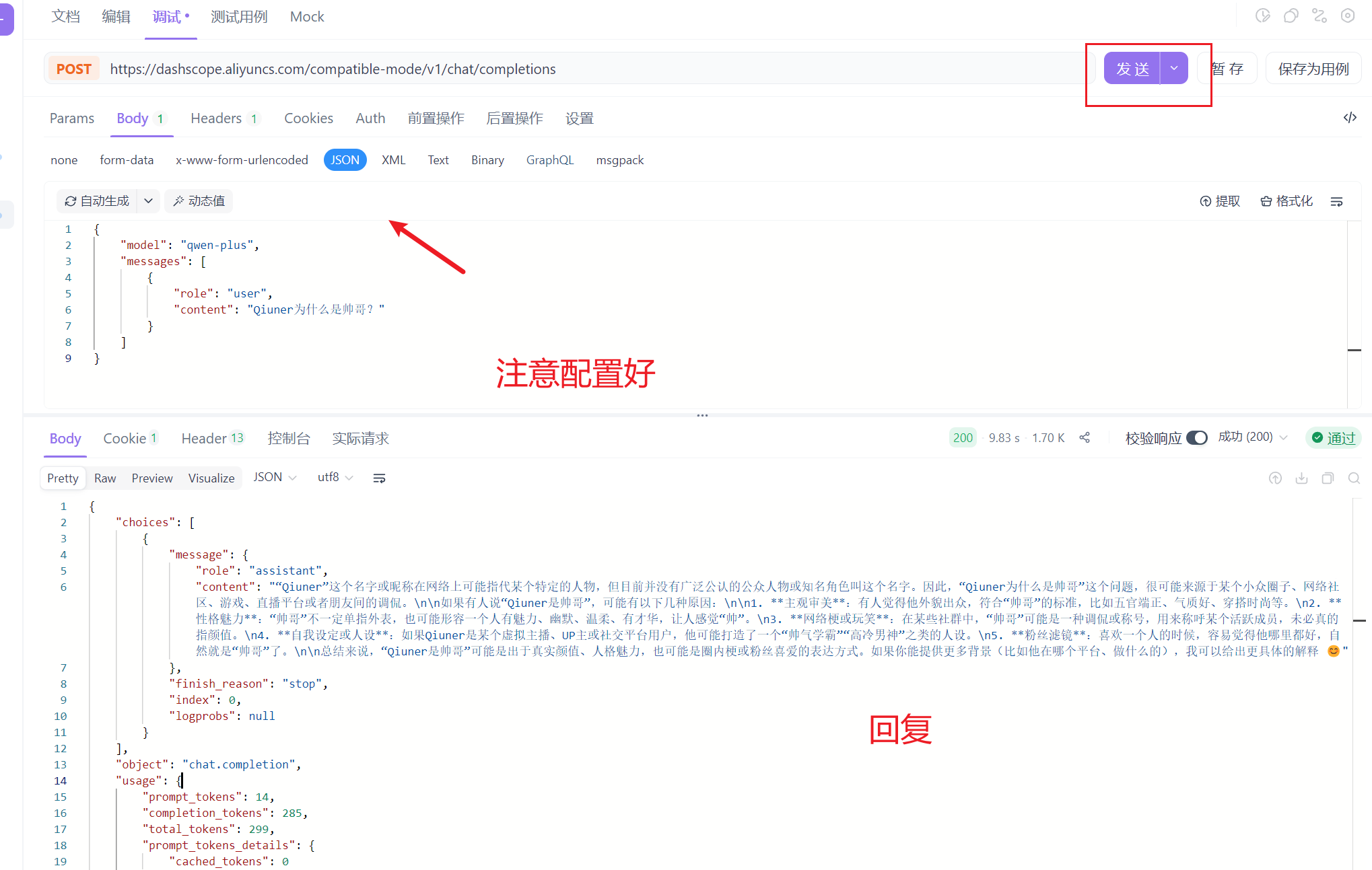

- 点击发送,大模型就会回复了

调用大模型时,出现的参数是什么意思?

- 以下是调用大模型参数需要的json格式数据

{

"model": "qwen-plus",

"messages": [

{

"role": "system",

"content": "你是Qiuner的ai助手"

},

{

"role": "user",

"content": "你是谁?"

},

{

"role": "assistant",

"content": "您好,有什么可以帮助您?"

}

],

"stream": true,

"enable_search": true

}

model

指定要使用的AI模型版本,不同模型具有不同的能力和特点。

contenet/role

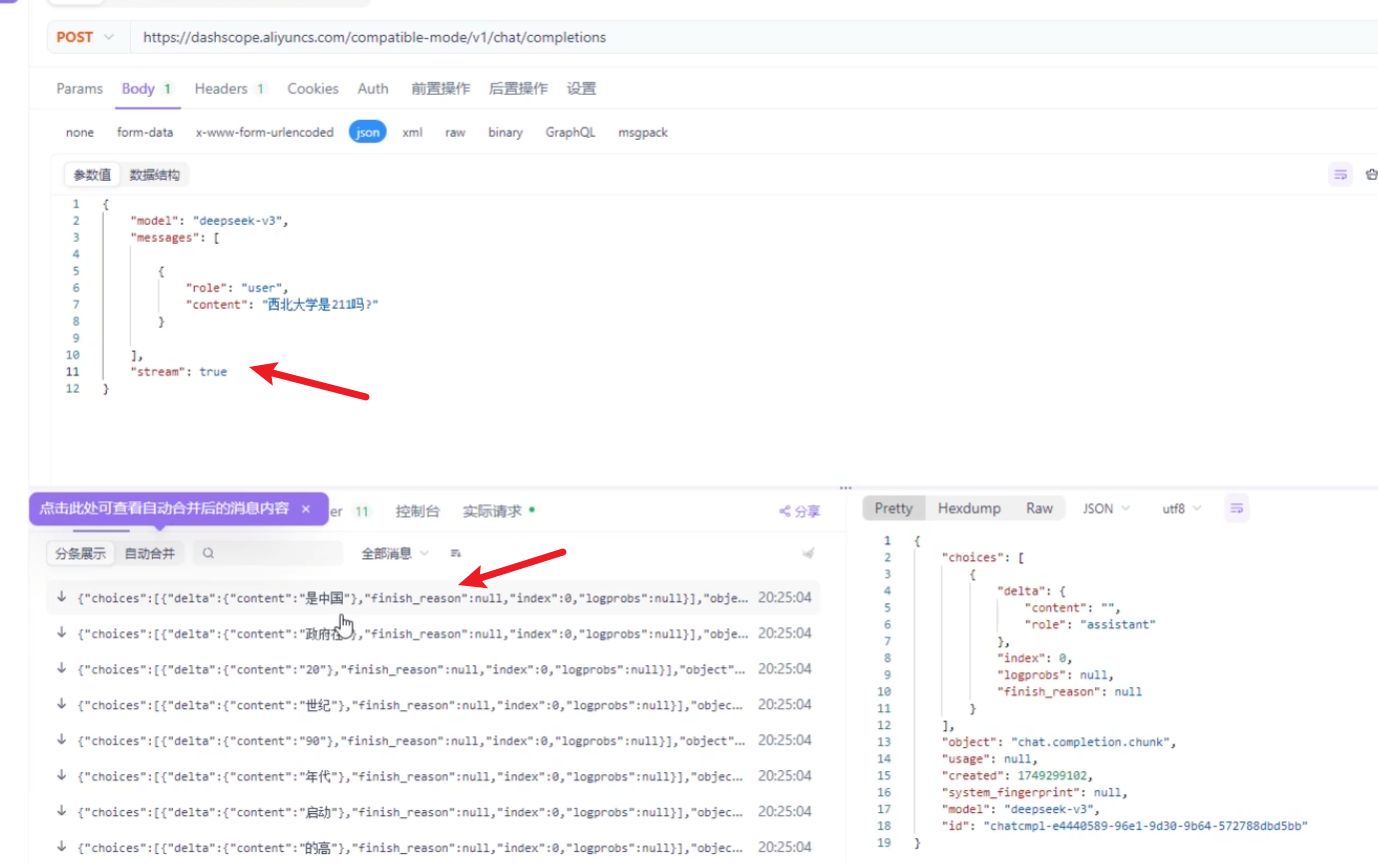

stream

- true: 流式返回,响应内容会逐步返回,用户可以实时看到生成过程

- false: 等待完整生成后一次性返回所有内容

enable_search

-

true: 模型可以联网搜索最新信息作为回答依据

-

false: 仅使用模型自身的知识库回答

总结

| 参数名称 | 类型 | 说明 | 可选值/示例 |

|---|---|---|---|

| model | string | 告诉平台,当前调用哪个模型 | qwen-plus 等模型名称 |

| messages | array | 发送给模型的数据,模型会根据这些数据给出合适的响应 | 消息对象数组 |

| stream | boolean | 调用方式 | true: 非阻塞调用(流式调用)false: 阻塞调用(一次性响应),默认值 |

| enable_search | boolean | 联网搜索,启用后,模型会将搜索结果作为参考信息 | true: 开启false: 关闭(默认) |

| 字段名称 | 说明 | 可选值 |

|---|---|---|

| role | 消息角色(类型) | user: 用户消息system: 系统消息assistant: 模型响应消息 |

| content | 消息内容 | 具体的文本内容 |

|

大模型响应的意思是什么?

响应数据示例

{

"choices": [

{

"message": {

"role": "assistant",

"content": "我是通义千问,阿里巴巴..."

},

"finish_reason": "stop",

"index": 0

}

],

"object": "chat.completion",

"usage": {

"prompt_tokens": 22,

"completion_tokens": 80,

"total_tokens": 102

},

"created": 1748068508,

"system_fingerprint": null,

"model": "qwen-plus",

"id": "chatcmpl-99f8d040-0f49-955b-943a-21c83"

}

- 上面这个响应可以这样解读

- 模型(qwen-plus)生成了一条回复:"我是通义千问,阿里巴巴..."

- 用户输入使用了22个token

- 模型回复使用了80个token

- 总共消耗102个token

- 响应正常结束(finish_reason为stop)

- 调用ID为 chatcmpl-99f8d040-0f49-955b-943a-21c83

响应字段说明表格

| 字段名称 | 类型 | 说明 |

|---|---|---|

| choices | array | 模型生成的内容数组,可以包含一条或多条内容 |

| object | string | 始终为chat.completion,无需关注 |

| usage | object | 本次对话过程中使用的token信息 |

| created | integer | 本次会话被创建时的时间戳 |

| system_fingerprint | string/null | 固定为null,无需关注 |

| model | string | 本次会话使用的模型名称 |

| id | string | 本次调用的唯一标识符 |

finish_reason表示模型停止生成的原因:

- stop: 模型自然完成了回答

- length: 生成的内容达到了最大长度限制而被截断

created

- Unix时间戳格式,表示该响应生成的时间。示例中的

1748068508转换为日期时间约为2025年5月。

id

- 每次API调用的唯一标识符,可用于日志追踪、问题排查或审计。

choices 数组结构(重点关注)

| 字段名称 | 类型 | 说明 |

|---|---|---|

| message | object | 本次调用模型输出的消息 |

| finish_reason | string | 自然结束(stop),生成内容过长(length) |

| index | integer | 当前内容在choices数组中的索引 |

- 这是一个数组,包含模型生成的所有响应。通常情况下只有一个元素(index为0),但某些API配置下可能返回多个候选响应。

message 对象结构

| 字段名称 | 类型 | 说明 |

|---|---|---|

| role | string | 固定为assistant,表示这是模型的响应 |

| content | string | 模型生成的具体文本内容 |

usage 对象结构(重点关注)

| 字段名称 | 类型 | 说明 |

|---|---|---|

| prompt_tokens | integer | 用户的输入转换成token的个数 |

| completion_tokens | integer | 模型生成的回复转换成token的个数 |

| total_tokens | integer | 用户输入和模型生成的总token个数 |

Token是AI模型处理文本的基本单位,用户输入内容需要转换成token才能方便大模型处理同时用于计费和性能监控:

(一个token等于四个英文字符,一个汉字等于1~2个token)

- prompt_tokens: 你发送给模型的所有内容(包括历史对话)消耗的token数

- completion_tokens: 模型生成的回复消耗的token数

- total_tokens: 本次调用的总消耗,等于前两者之和

学习程度测试:下面响应该如何解读?

- 我将答案放在了最后面,小伙伴们可以可以先打到评论区,用以检验自己学习程度。

题目:

{

"choices": [

{

"message": {

"role": "assistant",

"content": "“Qiuner”这个名字或昵称在网络上可能指代某个特定的人物,但目前并没有广泛公认的公众人物或知名角色叫这个名字。因此,“Qiuner为什么是帅哥”这个问题,很可能来源于某个小众圈子、网络社区、游戏、直播平台或者朋友间的调侃。\n\n如果有人说“Qiuner是帅哥”,可能有以下几种原因:\n\n1. **主观审美**:有人觉得他外貌出众,符合“帅哥”的标准,比如五官端正、气质好、穿搭时尚等。\n2. **性格魅力**:“帅哥”不一定单指外表,也可能形容一个人有魅力、幽默、温柔、有才华,让人感觉“帅”。\n3. **网络梗或玩笑**:在某些社群中,“帅哥”可能是一种调侃或称号,用来称呼某个活跃成员,未必真的指颜值。\n4. **自我设定或人设**:如果Qiuner是某个虚拟主播、UP主或社交平台用户,他可能打造了一个“帅气学霸”“高冷男神”之类的人设。\n5. **粉丝滤镜**:喜欢一个人的时候,容易觉得他哪里都好,自然就是“帅哥”了。\n\n总结来说,“Qiuner是帅哥”可能是出于真实颜值、人格魅力,也可能是圈内梗或粉丝喜爱的表达方式。如果你能提供更多背景(比如他在哪个平台、做什么的),我可以给出更具体的解释 😊"

},

"finish_reason": "stop",

"index": 0,

"logprobs": null

}

],

"object": "chat.completion",

"usage": {

"prompt_tokens": 14,

"completion_tokens": 285,

"total_tokens": 299,

"prompt_tokens_details": {

"cached_tokens": 0

}

},

"created": 1760090562,

"system_fingerprint": null,

"model": "qwen-plus",

"id": "chatcmpl-90a8022a-73fc-40c5-9d06-67db4e4a4110"

}

结束语

你好,我是Qiuner. 为帮助别人少走弯路而写博客 这是我的 github https://github.com/Qiuner⭐ gitee https://gitee.com/Qiuner 🌹

如果本篇文章帮到了你 不妨点个赞吧~ 我会很高兴的 😄 (^ ~ ^) 。想看更多 那就点个关注吧 我会尽力带来有趣的内容 😎。

代码都在github或gitee上,如有需要可以去上面自行下载。记得给我点星星哦😍

如果你遇到了问题,自己没法解决,可以去我掘金评论区问。CSDN评论区和私信看不完 掘金账号 https://juejin.cn/user/1942157160101860 掘金账号

更多专栏:感谢订阅专栏 三连文章

| 上一篇推荐 | 链接 |

|---|---|

| Java程序员快又扎实的学习路线 | 点击该处自动跳转查看哦 |

| 一文读懂 AI | 点击该处自动跳转查看哦 |

| 一文读懂 服务器 | 点击该处自动跳转查看哦 |

| 2024年创作回顾 | 点击该处自动跳转查看哦 |

| 一文读懂 ESLint配置 | 点击该处自动跳转查看哦 |

| 老鸟如何追求快捷操作电脑 | 点击该处自动跳转查看哦 |

| 未来会写什么文章? | 预告链接 |

|---|---|

| 一文读懂 XX? | 点击该处自动跳转查看哦 |

| 2025年终总结 | 点击该处自动跳转查看哦 |

| 一图读懂 XX? | 点击该处自动跳转查看哦 |

答案

基本信息

模型名称:qwen-plus

调用ID:chatcmpl-90a8022a-73fc-40c5-9d06-67db4e4a4110

创建时间:1760090562(Unix时间戳)

响应类型:chat.completion

生成内容

模型(qwen-plus)生成了一条回复:""Qiuner"这个名字或昵称在网络上可能指代某个特定的人物,但目前并没有广泛公认的公众人物或知名角色叫这个名字。因此,"Qiuner为什么是帅哥"这个问题,很可能来源于某个小众圈子、网络社区、游戏、直播平台或者朋友间的调侃..."(完整回复约285个token长度)

Token消耗统计

用户输入使用了14个token(prompt_tokens)

模型回复使用了285个token(completion_tokens)

总共消耗299个token(total_tokens)

缓存token数:0(本次请求未使用缓存)

执行状态

响应正常结束(finish_reason为stop)

返回结果索引:0(表示第一条结果)

概率信息:null(未开启logprobs参数)

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)